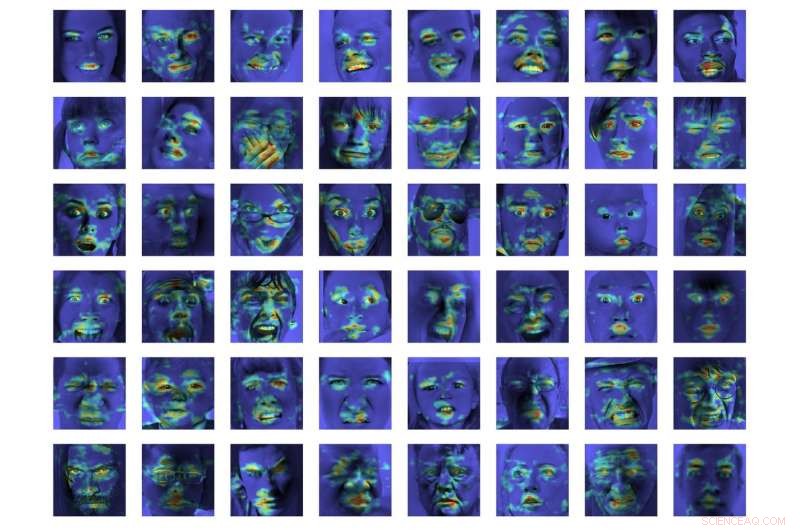

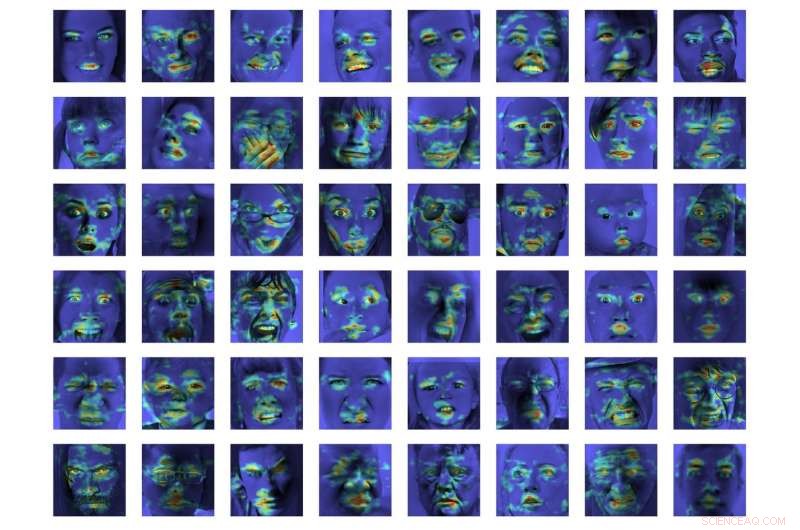

Et følelsesmæssigt deep alignment netværk (DAN) til at klassificere og visualisere følelser

Kredit:Tautkutè &Trzcinski

Forskere ved det polsk-japanske akademi for informationsteknologi og Warszawas teknologiske universitet har udviklet en DAN-model (deep alignment network) til at klassificere og visualisere følelser. Deres metode viste sig at udkonkurrere state-of-the-art metoder til følelsesklassificering på to benchmark-datasæt.

At udvikle modeller, der kan genkende og klassificere menneskelige følelser, er en nøgleudfordring inden for maskinlæring og computersyn. De fleste eksisterende følelsesgenkendelsesværktøjer bruger flerlagede foldningsnetværk, som ikke eksplicit udleder ansigtstræk i klassifikationsfasen.

Ivona Tautkute og Tomasz Trzcinski, forskerne, der udførte den nylige undersøgelse, arbejdede oprindeligt på et system til en californisk opstart, der kunne integreres i autonome biler. Dette system var i stand til at tælle passagerer baseret på data hentet fra et enkelt videokamera monteret inde i bilen.

På et senere tidspunkt, de to forskere begyndte at udforske modeller, der kunne mere end dette, skabe bredere statistik om passagerer ved at estimere deres alder og køn. En åbenlys udvidelse af dette system var, at det kunne registrere ansigtsudtryk og følelser, såvel.

"Da systemet skulle bruges med ældre passagerer, det var vigtigt at fange negative og positive følelser forbundet med chaufførens uenighed, " forklarede Tautkute. "Eksisterende tilgange til følelsesgenkendelse er langt fra perfekte, så vi begyndte at undersøge interessante nye måder at forbedre os på. En idé kom til os efter en diskussion med en kollega computersynsforsker, Marek Kowalski, der arbejdede på ansigtsjustering med deep alignment network (DAN). Placeringen af ansigtets vartegn er ligefrem relateret til udtrykte følelser, så vi var nysgerrige på, om vi kunne bygge et system, der ville kombinere de to opgaver."

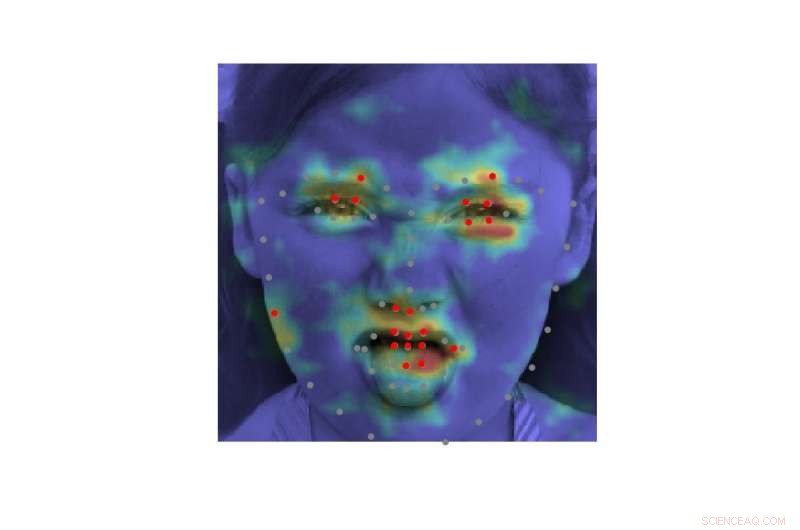

EmotionalDAN, modellen udtænkt af Tautkute og Trzcinski, er en tilpasning af Kowalskis DAN -model, som omfatter et udtryk relateret til ansigtstræk. Takket være denne ændring, deres model lærer samtidig placeringen af både ansigtets vartegn og udtrykte følelser.

-

Kredit:Tautkutè &Trzcinski

-

Kredit:Tautkutè &Trzcinski

-

Kredit:Tautkutè &Trzcinski

-

Kredit:Tautkutè &Trzcinski

"Vi opnåede dette ved at udvide tabsfunktionen af den oprindelige DAN med en term, der er ansvarlig for følelsesklassificering, " sagde Tautkute. "Det neurale netværk trænes i på hinanden følgende stadier, der giver mulighed for forfining af ansigtets vartegn og indlærte følelser. Der er også overførsel af information mellem stadier, som holder styr på det normaliserede ansigtsinput, feature map og vartegnens varmekort."

I en indledende evaluering, EmotionalDAN overgik topmoderne klassificeringsmetoder med 5 procent på to benchmark-datasæt, nemlig CK+ og ISED. Forskerne var også i stand til at visualisere billedregioner analyseret af deres model, når de traf en beslutning. Deres observationer afslørede, at EmotionalDAN korrekt kunne identificere ansigtets vartegn forbundet med udtryk for følelser hos mennesker.

"Det, der virkelig er interessant ved vores undersøgelse, er, at selvom vi ikke føder følelsesrelaterede rumlige oplysninger til netværket, modellen er i stand til af sig selv at lære, hvilke ansigtsområder der skal ses på, når man forsøger at forstå ansigtsudtryk, " sagde Tautkute. "Vi mennesker ser intuitivt på en persons øjne og mund for at bemærke smil eller tristhed, men det neurale netværk ser kun en matrix af pixels. At verificere, hvilke billedområder der er aktiveret for en given klassificeringsbeslutning, bringer os et skridt tættere på at forstå modellen, og hvordan den træffer beslutninger."

Kredit:Tautkutè &Trzcinski.

På trods af de meget lovende resultater opnået med EmotionalDAN og andre følelsesgenkendelsesværktøjer, at forstå menneskelige følelser er fortsat en meget kompleks opgave. Mens eksisterende systemer har opnået bemærkelsesværdige resultater, det har de primært kunnet, når følelser kommer til udtryk i væsentlig grad.

I virkelige situationer, imidlertid, de følelsesmæssige signaler udtrykt af mennesker er ofte langt mere subtile. For eksempel, en persons lykke bliver måske ikke altid formidlet ved at vise alle tænder i et bredt smil, men kan blot medføre en lille bevægelse af læbehjørnerne.

"Det ville være virkelig interessant at forstå mere subjektive aspekter af følelser, og hvordan deres udtryk adskiller sig mellem individer, " sagde Tautkute. "For at gå videre, man kunne prøve at skelne falske følelser fra ægte. For eksempel, neurologer oplyser, at forskellige ansigtsmuskler er involveret i ægte og falske smil. I særdeleshed, øjenmuskler trækker sig ikke sammen i det tvungne udtryk. Det ville være interessant at opdage lignende forhold ved hjælp af information lært fra data."

© 2018 Science X Network

Varme artikler

Varme artikler

-

Googles Duplex skal have en advarsel, siger ekspert i kunstig intelligensKredit:Shutterstock Googles demonstration af kunstig intelligens var morsom, men rejste et vigtigt spørgsmål:har du ret til at vide, at du taler til en maskine? Google overraskede os alle i denne

Googles Duplex skal have en advarsel, siger ekspert i kunstig intelligensKredit:Shutterstock Googles demonstration af kunstig intelligens var morsom, men rejste et vigtigt spørgsmål:har du ret til at vide, at du taler til en maskine? Google overraskede os alle i denne -

Forskere øger bevidstheden om sammenkobling, privatlivsrisici ved onlinetjenesterKredit:CC0 Public Domain Hvis du er en hyppig bruger af teknologi, noget som dette sker sandsynligvis for dig hver dag:Du søger på nettet efter artikler om din nye hvalps ernæringsbehov, og næsten

Forskere øger bevidstheden om sammenkobling, privatlivsrisici ved onlinetjenesterKredit:CC0 Public Domain Hvis du er en hyppig bruger af teknologi, noget som dette sker sandsynligvis for dig hver dag:Du søger på nettet efter artikler om din nye hvalps ernæringsbehov, og næsten -

Objekter kan nu ændre farver som en kamæleonFotoChromeleon, en reversibel proces til at ændre farven på objekter udviklet på MIT, involverer en blanding af fotokrome farvestoffer, der kan sprøjtes eller males på overfladen af enhver genstand.

Objekter kan nu ændre farver som en kamæleonFotoChromeleon, en reversibel proces til at ændre farven på objekter udviklet på MIT, involverer en blanding af fotokrome farvestoffer, der kan sprøjtes eller males på overfladen af enhver genstand. -

Smarthøjttalere gør passive lyttereKredit:Cornell Brand Communications Folk udforsker mindre, når de får anbefalinger fra stemmebaserede platforme som Amazons Alexa eller Apples Siri, hvilket gør det mere sandsynligt, at de vil hør

Smarthøjttalere gør passive lyttereKredit:Cornell Brand Communications Folk udforsker mindre, når de får anbefalinger fra stemmebaserede platforme som Amazons Alexa eller Apples Siri, hvilket gør det mere sandsynligt, at de vil hør

- NASA finder Tropical Storm 07W nær Kadena Air Base, Okinawa

- Skovrydning i Amazonasbassinet kan forstyrre fjern regnskov ved fjern klimaforbindelse

- En bioinspireret flow-sensing cupula til nedsænket robotik

- Sådan beregnes procenten af en time

- Gummy Bear Science Experiments

- Månens største krater rummer spor om den tidlige månekappe