AI-system gør billedgeneratormodeller som DALL-E 2 mere kreative

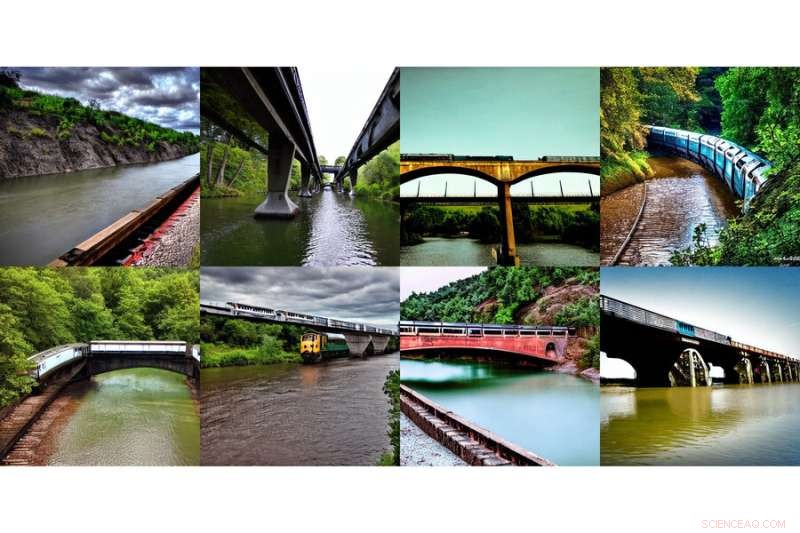

Denne række af genererede billeder, der viser "et tog på en bro" og "en flod under broen," blev genereret ved hjælp af en ny metode udviklet af MIT-forskere. Kredit:Massachusetts Institute of Technology

Internettet havde et kollektivt feel-good-øjeblik med introduktionen af DALL-E, en kunstig intelligens-baseret billedgenerator inspireret af kunstneren Salvador Dali og den elskelige robot WALL-E, der bruger naturligt sprog til at producere det mystiske og smukke billede, dit hjerte begærer . At se udskrevne input som "smilende gopher, der holder en iskugle" øjeblikkeligt springer til live, gav tydeligt genklang i verden.

At få nævnte smilende gopher og attributter til at dukke op på din skærm er ikke en lille opgave. DALL-E 2 bruger noget, der kaldes en diffusionsmodel, hvor den forsøger at indkode hele teksten i én beskrivelse for at generere et billede. Men når først teksten har mange flere detaljer, er det svært for en enkelt beskrivelse at fange det hele. Desuden, mens de er meget fleksible, kæmper de nogle gange med at forstå sammensætningen af visse begreber, som at forvirre egenskaberne eller relationerne mellem forskellige objekter.

For at generere mere komplekse billeder med bedre forståelse, strukturerede forskere fra MIT's Computer Science and Artificial Intelligence Laboratory (CSAIL) den typiske model fra en anden vinkel:de tilføjede en række modeller sammen, hvor de alle samarbejder om at generere ønskede billeder, der fanger flere forskellige aspekter som anmodet om af inputteksten eller etiketterne. For at skabe et billede med to komponenter, f.eks. beskrevet af to beskrivelsessætninger, vil hver model tackle en bestemt komponent af billedet.

Denne række af genererede billeder, der viser "en flod, der fører ind i bjerge" og "røde træer på siden," blev genereret ved hjælp af en ny metode udviklet af MIT-forskere. Kredit:Massachusetts Institute of Technology

De tilsyneladende magiske modeller bag billedgenerering fungerer ved at foreslå en række iterative forfiningstrin for at komme til det ønskede billede. Det starter med et "dårligt" billede og forfiner det derefter gradvist, indtil det bliver det valgte billede. Ved at komponere flere modeller sammen forfiner de i fællesskab udseendet ved hvert trin, så resultatet er et billede, der udviser alle egenskaberne for hver model. Ved at få flere modeller til at samarbejde, kan du få meget mere kreative kombinationer i de genererede billeder.

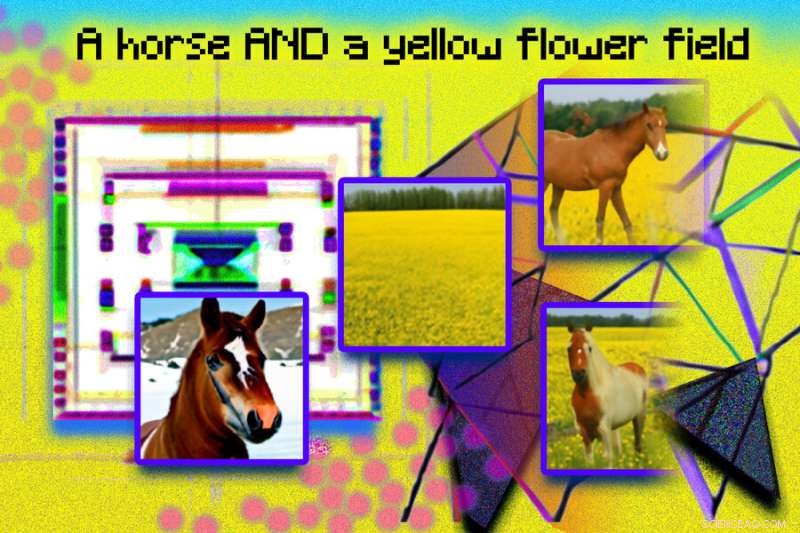

Tag for eksempel en rød lastbil og et grønt hus. Modellen vil forveksle begreberne rød lastbil og grønt hus, når disse sætninger bliver meget komplicerede. En typisk generator som DALL-E 2 kan lave en grøn lastbil og et rødt hus, så den vil bytte rundt på disse farver. Teamets tilgang kan håndtere denne type binding af attributter med objekter, og især når der er flere sæt ting, kan det håndtere hvert objekt mere præcist.

"Modellen kan effektivt modellere objektpositioner og relationelle beskrivelser, hvilket er udfordrende for eksisterende billedgenereringsmodeller. Sæt for eksempel et objekt og en terning i en bestemt position og en kugle i en anden. DALL-E 2 er god til at generere naturlige billeder, men har nogle gange svært ved at forstå objektrelationer," siger MIT CSAIL Ph.D. studerende og medforfatter Shuang Li, "Ud over kunst og kreativitet kunne vi måske bruge vores model til undervisning. Hvis du vil fortælle et barn, at det skal lægge en terning oven på en kugle, og hvis vi siger dette på sproget, er det kan være svært for dem at forstå. Men vores model kan generere billedet og vise dem."

Forskere var i stand til at skabe nogle overraskende, surrealistiske billeder med teksten "en hund" og "himlen." Til venstre vises en hund og skyer hver for sig, mærket "hund" og "himmel" nedenunder, og til højre ses to billeder af skylignende hunde med etiketten "hund OG himmel" nedenunder. Kredit:Massachusetts Institute of Technology

Gør Dali stolt

Composable Diffusion – teamets model – bruger diffusionsmodeller sammen med kompositoriske operatører til at kombinere tekstbeskrivelser uden yderligere træning. Holdets tilgang fanger tekstdetaljer mere præcist end den originale diffusionsmodel, som direkte koder ordene som en enkelt lang sætning. For eksempel, givet "en lyserød himmel" OG "et blåt bjerg i horisonten" OG "kirsebærblomster foran bjerget", var teamets model i stand til at producere det billede nøjagtigt, hvorimod den originale diffusionsmodel gjorde himlen blå og alt foran bjergene pink.

"Det faktum, at vores model er komponerbar betyder, at du kan lære forskellige dele af modellen, en ad gangen. Du kan først lære en genstand oven på en anden, så lære en genstand til højre for en anden og så lære noget til venstre. af en anden," siger co-lead forfatter og MIT CSAIL Ph.D. studerende Yilun Du. "Da vi kan komponere disse sammen, kan du forestille dig, at vores system gør os i stand til gradvist at lære sprog, relationer eller viden, hvilket vi synes er en ret interessant retning for fremtidigt arbejde."

Denne fotoillustration blev skabt ved hjælp af genererede billeder fra et MIT-system kaldet Composable Diffusion, og arrangeret i Photoshop. Sætninger som "diffusionsmodel" og "netværk" blev brugt til at generere de lyserøde prikker og geometriske, kantede billeder. Sætningen "en hest OG en gul blomstermark" er inkluderet øverst i billedet. Genererede billeder af en hest og et gult felt vises til venstre, og det kombinerede billede af en hest i et gult blomsterfelt vises til højre. Kredit:Massachusetts Institute of Technology

Selvom den viste dygtighed til at generere komplekse, fotorealistiske billeder, stod den stadig over for udfordringer, da modellen blev trænet på et meget mindre datasæt end dem som DALL-E 2, så der var nogle objekter, den simpelthen ikke kunne fange.

Nu hvor Composable Diffusion kan arbejde oven på generative modeller, såsom DALL-E 2, ønsker forskerne at udforske kontinuerlig læring som et potentielt næste skridt. Da der normalt tilføjes mere til objektrelationer, ønsker de at se, om diffusionsmodeller kan begynde at "lære" uden at glemme tidligere lært viden – til et sted, hvor modellen kan producere billeder med både den tidligere og nye viden.

"Denne forskning foreslår en ny metode til at komponere begreber i tekst-til-billede generering, ikke ved at sammenkæde dem for at danne en prompt, men snarere ved at beregne score med hensyn til hvert koncept og komponere dem ved hjælp af konjunktion og negationsoperatorer," siger Mark Chen, medskaber af DALL-E 2 og forsker ved OpenAI. "Dette er en fin idé, der udnytter den energibaserede fortolkning af diffusionsmodeller, så gamle ideer omkring kompositionalitet ved hjælp af energibaserede modeller kan anvendes. Tilgangen er også i stand til at gøre brug af klassificeringsfri vejledning, og det er overraskende at se, at den udkonkurrerer GLIDE-baselinjen på forskellige kompositoriske benchmarks og kan kvalitativt producere meget forskellige typer billedgenereringer."

"Mennesker kan komponere scener med forskellige elementer på et utal af måder, men denne opgave er udfordrende for computere," siger Bryan Russel, forsker hos Adobe Systems. "Dette arbejde foreslår en elegant formulering, der eksplicit sammensætter et sæt diffusionsmodeller for at generere et billede givet en kompleks naturlig sprogprompt." + Udforsk yderligere

Revolutionerende billedgenerering gennem AI:Gør tekst til billeder

Denne historie er genudgivet med tilladelse fra MIT News (web.mit.edu/newsoffice/), et populært websted, der dækker nyheder om MIT-forskning, innovation og undervisning.

Varme artikler

Varme artikler

-

Rygter og lækager på iPhone 12:4 ting, vi forventer af Apple i 2020Selvom Apple lancerede sin trio af iPhone 11-modeller for blot fire måneder siden i september, rygtemøllen kigger allerede over horisonten og spekulerer i 2020 og den kommende iPhone 12 (nogle rygter

Rygter og lækager på iPhone 12:4 ting, vi forventer af Apple i 2020Selvom Apple lancerede sin trio af iPhone 11-modeller for blot fire måneder siden i september, rygtemøllen kigger allerede over horisonten og spekulerer i 2020 og den kommende iPhone 12 (nogle rygter -

Lav nanodiamanter af flaskeplastI forsøget blev et tyndt ark simpelt PET-plast beskudt med laser. De stærke laserglimt, der ramte den folielignende materialeprøve, varmede den kortvarigt op til 6000 grader Celsius og genererede derm

Lav nanodiamanter af flaskeplastI forsøget blev et tyndt ark simpelt PET-plast beskudt med laser. De stærke laserglimt, der ramte den folielignende materialeprøve, varmede den kortvarigt op til 6000 grader Celsius og genererede derm -

Nu ser du det:Undgåelse af registrering af et infrarødt kamera, blæksprutte stilUCI ingeniørprofessor Alon Gorodetsky og doktorand Chengyi Xu har opnået et gennembrud, opfinde et elastisk nyt materiale modelleret efter både blækspruttehud og Hollywood -dinosaurer med bemærkelsesv

Nu ser du det:Undgåelse af registrering af et infrarødt kamera, blæksprutte stilUCI ingeniørprofessor Alon Gorodetsky og doktorand Chengyi Xu har opnået et gennembrud, opfinde et elastisk nyt materiale modelleret efter både blækspruttehud og Hollywood -dinosaurer med bemærkelsesv -

Zablit valgt som Renault-Nissan-Mitsubishi generalsekretærHadi Zablit er valgt som generalsekretær for Renault-Nissan-Mitsubishi bilalliancen En fransk-libanesisk ingeniør er blevet valgt som generalsekretær for bilalliancen Renault-Nissan-Mitsubishi, de

Zablit valgt som Renault-Nissan-Mitsubishi generalsekretærHadi Zablit er valgt som generalsekretær for Renault-Nissan-Mitsubishi bilalliancen En fransk-libanesisk ingeniør er blevet valgt som generalsekretær for bilalliancen Renault-Nissan-Mitsubishi, de

- Forsker undersøger små RNA'ers rolle i kommunikationen mellem celler

- Billig, effektiv og stabil fotoelektrode kunne forbedre vandopdeling med solenergi

- Sådan laver du en model af Mars til 5. klasse

- Århundredes data viser stigning i havniveau ved skiftende tidevand i Delaware, Chesapeake bugter

- Hvorfor kan du stole på en kvantecomputer med hemmeligheder - selv over internettet

- Video:Hvor meget vejer en sky?