Neuralt netværk lærer talemønstre, der forudsiger depression i kliniske interviews

MIT-forskere har udviklet en neural-netværksmodel, der kan analysere rå tekst- og lyddata fra interviews for at opdage talemønstre, der indikerer depression. Denne metode kan bruges til at udvikle diagnostiske hjælpemidler til klinikere, der kan opdage tegn på depression i naturlig samtale. Kredit:Massachusetts Institute of Technology

For at diagnosticere depression, klinikere interviewer patienter, stille specifikke spørgsmål – om, sige, tidligere psykiske lidelser, livsstil, og humør - og identificer tilstanden baseret på patientens reaktioner.

I de seneste år, maskinlæring er blevet forkæmpet som en nyttig hjælp til diagnostik. Maskinlæringsmodeller, for eksempel, er blevet udviklet, der kan detektere ord og intonationer af tale, der kan indikere depression. Men disse modeller har en tendens til at forudsige, om en person er deprimeret eller ej, baseret på personens specifikke svar på specifikke spørgsmål. Disse metoder er nøjagtige, men deres afhængighed af den type spørgsmål, der bliver stillet, begrænser, hvordan og hvor de kan bruges.

I et papir, der præsenteres på Interspeech-konferencen, MIT-forskere beskriver en neural-netværksmodel, der kan udløses på rå tekst- og lyddata fra interviews for at opdage talemønstre, der indikerer depression. Med et nyt emne, det kan præcist forudsige, om personen er deprimeret, uden at have brug for andre oplysninger om spørgsmålene og svarene.

Forskerne håber, at denne metode kan bruges til at udvikle værktøjer til at opdage tegn på depression i naturlig samtale. I fremtiden, modellen kunne for eksempel, driver mobilapps, der overvåger en brugers tekst og stemme for mental nød og sender advarsler. Dette kan især være nyttigt for dem, der ikke kan komme til en kliniker for at få en indledende diagnose, på grund af afstand, koste, eller manglende bevidsthed om, at noget kan være galt.

"De første hints vi har om, at en person er glad, begejstret, trist, eller har en alvorlig kognitiv tilstand, såsom depression, er gennem deres tale, " siger førsteforfatter Tuka Alhanai, en forsker i Computer Science and Artificial Intelligence Laboratory (CSAIL). "Hvis du vil implementere [depression-detektion]-modeller på en skalerbar måde ... du vil minimere mængden af begrænsninger, du har på de data, du bruger. Du vil implementere det i enhver almindelig samtale og få modellen til at samle op, fra det naturlige samspil, individets tilstand."

Teknologien kunne stadig, selvfølgelig, bruges til at identificere psykisk lidelse i tilfældige samtaler på kliniske kontorer, tilføjer medforfatter James Glass, seniorforsker i CSAIL. "Hver patient vil tale forskelligt, og hvis modellen ser ændringer, vil det måske være et flag til lægerne, " siger han. "Dette er et skridt fremad i at se, om vi kan gøre noget assisterende for at hjælpe klinikere."

Den anden medforfatter på papiret er Mohammad Ghassemi, medlem af Institut for Medicinsk Teknik og Videnskab (IMES).

Kontekstfri modellering

Modellens nøgleinnovation ligger i dens evne til at opdage mønstre, der indikerer depression, og derefter kortlægge disse mønstre til nye individer, uden yderligere oplysninger. "Vi kalder det 'kontekstfrit' fordi du ikke sætter nogen begrænsninger i den type spørgsmål, du leder efter, og typen af svar på disse spørgsmål, " siger Alhanai.

Andre modeller er forsynet med et specifikt sæt spørgsmål, og derefter givet eksempler på, hvordan en person uden depression reagerer og eksempler på, hvordan en person med depression reagerer - f.eks. den ligefremme undersøgelse, "Har du en historie med depression?" Den bruger de nøjagtige svar til derefter at afgøre, om et nyt individ er deprimeret, når det stilles det nøjagtig samme spørgsmål. "Men det er ikke sådan, naturlige samtaler fungerer, " siger Alhanai.

Forskerne, på den anden side, brugte en teknik kaldet sekvensmodellering, bruges ofte til talebehandling. Med denne teknik, de fodrede modelsekvenserne af tekst og lyddata fra spørgsmål og svar, fra både deprimerede og ikke-deprimerede personer, en efter en. Efterhånden som sekvenserne akkumulerede, modellen udtog talemønstre, der dukkede op for mennesker med eller uden depression. Ord som f.eks. sige, "trist, " "lav, " eller "ned, " kan parres med lydsignaler, der er fladere og mere monotone. Personer med depression kan også tale langsommere og bruge længere pauser mellem ordene. Disse tekst- og lydidentifikatorer for psykiske lidelser er blevet undersøgt i tidligere forskning. Det var i sidste ende op til modellen at afgøre, om nogen mønstre var forudsigende for depression eller ej.

"Modellen ser sekvenser af ord eller talestil, og fastslår, at disse mønstre er mere tilbøjelige til at blive set hos mennesker, der er deprimerede eller ikke deprimerede, " siger Alhanai. "Så, hvis den ser de samme sekvenser i nye emner, det kan forudsige, om de også er deprimerede."

Denne sekventeringsteknik hjælper også modellen med at se på samtalen som en helhed og notere forskelle mellem, hvordan mennesker med og uden depression taler over tid.

Opdagelse af depression

Forskerne uddannede og testede deres model på et datasæt med 142 interaktioner fra Distress Analysis Interview Corpus, der indeholder lyd, tekst, og videointerviews af patienter med psykiske problemer og virtuelle agenter kontrolleret af mennesker. Hvert emne vurderes i forhold til depression på en skala mellem 0 og 27, ved hjælp af spørgeskemaet om personlig sundhed. Score over en grænse mellem moderat (10 til 14) og moderat svær (15 til 19) betragtes som deprimeret, mens alle andre under denne tærskel betragtes som ikke deprimerede. Ud af alle emnerne i datasættet, 28 (20 procent) er stemplet som deprimerede.

I eksperimenter, modellen blev evalueret ved hjælp af metrics for præcision og tilbagekaldelse. Præcisionsmåler, hvilke af de deprimerede personer identificeret af modellen, der blev diagnosticeret som deprimerede. Recall measures the accuracy of the model in detecting all subjects who were diagnosed as depressed in the entire dataset. In precision, the model scored 71 percent and, on recall, scored 83 percent. The averaged combined score for those metrics, considering any errors, was 77 percent. In the majority of tests, the researchers' model outperformed nearly all other models.

One key insight from the research, Alhanai notes, is that, during experiments, the model needed much more data to predict depression from audio than text. With text, the model can accurately detect depression using an average of seven question-answer sequences. With audio, the model needed around 30 sequences. "That implies that the patterns in words people use that are predictive of depression happen in shorter time span in text than in audio, " Alhanai says. Such insights could help the MIT researchers, and others, further refine their models.

This work represents a "very encouraging" pilot, Glass says. But now the researchers seek to discover what specific patterns the model identifies across scores of raw data. "Right now it's a bit of a black box, " Glass says. "These systems, imidlertid, are more believable when you have an explanation of what they're picking up. … The next challenge is finding out what data it's seized upon."

The researchers also aim to test these methods on additional data from many more subjects with other cognitive conditions, such as dementia. "It's not so much detecting depression, but it's a similar concept of evaluating, from an everyday signal in speech, if someone has cognitive impairment or not, " Alhanai says.

Denne historie er genudgivet med tilladelse fra MIT News (web.mit.edu/newsoffice/), et populært websted, der dækker nyheder om MIT-forskning, innovation og undervisning.

Varme artikler

Varme artikler

-

Fans glæder sig:Streaming uden abonnement til NFL-spilI denne torsdag, 30. august, 2018, fotoapps til NFL og Yahoo Sports vises på en telefon på sidelinjen før en preseason NFL-fodboldkamp mellem Philadelphia Eagles og New York Jets i Philadelphia. Da de

Fans glæder sig:Streaming uden abonnement til NFL-spilI denne torsdag, 30. august, 2018, fotoapps til NFL og Yahoo Sports vises på en telefon på sidelinjen før en preseason NFL-fodboldkamp mellem Philadelphia Eagles og New York Jets i Philadelphia. Da de -

Tesla stiger under store forventninger til solenergiKredit:CC0 Public Domain Det ser ud til at solen fortsætter med at skinne på Tesla. På onsdag, Teslas aktier registrerede deres højeste lige kurs, efter at en analytiker på Wall Street sagde, at

Tesla stiger under store forventninger til solenergiKredit:CC0 Public Domain Det ser ud til at solen fortsætter med at skinne på Tesla. På onsdag, Teslas aktier registrerede deres højeste lige kurs, efter at en analytiker på Wall Street sagde, at -

Lufthansa ser Thomas Cooks Condor med udkøbstilbudLufthansa har tjekket ind hos Thomas Cook for at købe Condor Den europæiske flyselskabsgigant Lufthansa sagde tirsdag, at de havde tilbudt at købe luftfartsselskabet Condor fra det britiske moders

Lufthansa ser Thomas Cooks Condor med udkøbstilbudLufthansa har tjekket ind hos Thomas Cook for at købe Condor Den europæiske flyselskabsgigant Lufthansa sagde tirsdag, at de havde tilbudt at købe luftfartsselskabet Condor fra det britiske moders -

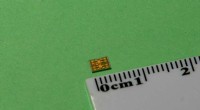

Klargøring til 5G:En miniature, lavpris transceiver til hurtig, pålidelig kommunikationDen foreslåede chip, fremstillet i en standard 65-nanometer CMOS-proces, fylder et samlet areal på kun 12 mm 2 . Kredit:Atsushi Shirane Forskere ved Tokyo Institute of Technology (Tokyo Tech) ha

Klargøring til 5G:En miniature, lavpris transceiver til hurtig, pålidelig kommunikationDen foreslåede chip, fremstillet i en standard 65-nanometer CMOS-proces, fylder et samlet areal på kun 12 mm 2 . Kredit:Atsushi Shirane Forskere ved Tokyo Institute of Technology (Tokyo Tech) ha

- Forskere registrerer vulkansk torden for første gang

- Brasilien mister en million skovbaner til en værdi af fodbold

- Halvlederfremstillingsteknikker anvendt til ny gammastråledetektor

- Nanotråde kan gøre lithium-ion-batterier mere sikre

- Sådan laver du Infrasound

- Team viser, at atomer kan modtage almindelige kommunikationssignaler