Berkeley Lab, Intel, Cray udnytte kraften til dyb læring for at studere universet

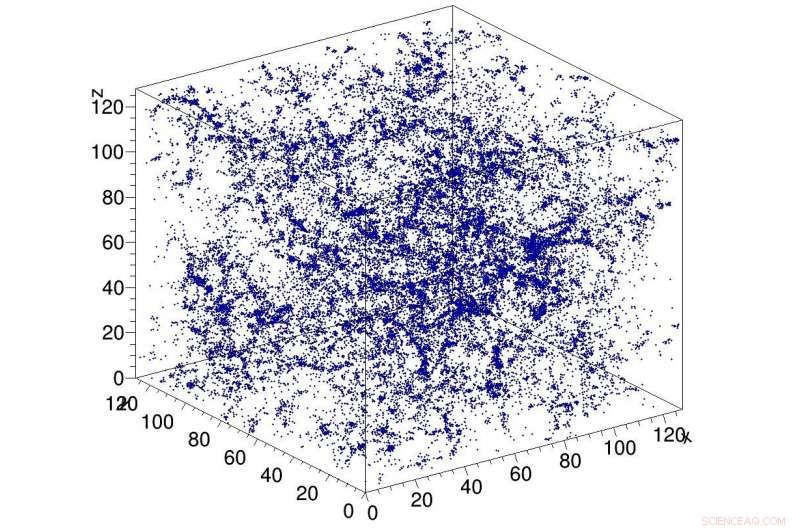

Eksempel simulering af mørkt stof i universet, bruges som input til CosmoFlow-netværket. CosmoFlow er den første store videnskabelige applikation, der bruger TensorFlow-rammeværket på en CPU-baseret højtydende computerplatform med synkron træning. Kredit:Lawrence Berkeley National Laboratory

Et Big Data Center-samarbejde mellem dataforskere ved Lawrence Berkeley National Laboratory's (Berkeley Lab) National Energy Research Scientific Computing Center (NERSC) og ingeniører hos Intel og Cray har givet endnu en førsteplads i søgen efter at anvende dyb læring til dataintensiv videnskab:CosmoFlow , den første store videnskabelige applikation til at bruge TensorFlow-rammeværket på en CPU-baseret højtydende computerplatform med synkron træning. Det er også den første til at behandle tredimensionelle (3-D) rumlige datamængder på denne skala, giver videnskabsfolk en helt ny platform til at få en dybere forståelse af universet.

Kosmologiske ''big data''-problemer går ud over den simple mængde data, der er gemt på disken. Observationer af universet er nødvendigvis begrænsede, og den udfordring, forskere står over for, er, hvordan man kan udtrække mest information fra de tilgængelige observationer og simuleringer. Problemet sammensættes ved, at kosmologer typisk karakteriserer fordelingen af stof i universet ved hjælp af statistiske mål for stofets struktur i form af to- eller trepunktsfunktioner eller anden reduceret statistik. Metoder såsom dyb læring, der kan indfange alle funktioner i fordeling af stof, ville give større indsigt i mørk energis natur. De første til at indse, at dyb læring kunne anvendes på dette problem, var Siamak Ravanbakhsh og hans kolleger, som refereret i forhandlingerne fra The 33rd International Conference on Machine Learning. Imidlertid, beregningsmæssige flaskehalse ved opskalering af netværket og datasættet begrænsede omfanget af det problem, der kunne løses.

Motiveret til at løse disse udfordringer, CosmoFlow er designet til at være yderst skalerbar; at behandle store, 3-D kosmologidatasæt; og for at forbedre deep learning-træningsydelsen på moderne HPC-supercomputere, såsom den Intel-processorbaserede Cray XC40 Cori-supercomputer hos NERSC. CosmoFlow er bygget oven på den populære TensorFlow machine learning framework og bruger Python som frontend. Applikationen udnytter Cray PE Machine Learning Plugin til at opnå hidtil uset skalering af TensorFlow Deep Learning-rammen til mere end 8, 000 noder. Det drager også fordel af Crays DataWarp I/O -acceleratorteknologi, som giver den I/O-gennemstrømning, der kræves for at nå dette niveau af skalerbarhed.

I et teknisk papir, der skal præsenteres på SC18 i november, CosmoFlow-teamet beskriver applikationen og de indledende eksperimenter ved hjælp af mørkt stof N-legeme-simuleringer produceret ved hjælp af MUSIC- og pycola-pakkerne på Cori-supercomputeren på NERSC. I en række skaleringseksperimenter med enkeltknude og flere knudepunkter, holdet var i stand til at demonstrere fuldt synkron dataparallel træning den 8. 192 af Cori med 77 % parallel effektivitet og 3,5 Pflop/s vedvarende ydeevne.

"Vores mål var at demonstrere, at TensorFlow kan køre i skala på flere noder effektivt, " sagde Deborah Bard, en big data-arkitekt hos NERSC og medforfatter til det tekniske papir. "Så vidt vi ved, dette er den største udrulning nogensinde af TensorFlow på CPU'er, og vi synes, det er det største forsøg på at køre TensorFlow på det største antal CPU -noder. "

Tidligt, CosmoFlow-teamet opstillede tre primære mål for dette projekt:videnskab, single-node optimering og skalering. Det videnskabelige mål var at demonstrere, at dyb læring kan bruges på 3D-bind til at lære universets fysik. Holdet ønskede også at sikre, at TensorFlow kørte effektivt og effektivt på en enkelt Intel Xeon Phi-processorknude med 3-D-volumener, som er almindelige i videnskaben, men ikke så meget i industrien, hvor de fleste deep learning-applikationer omhandler 2-D billeddatasæt. Og endelig, sikre høj effektivitet og ydeevne, når den skaleres på tværs af 1000-vis af noder på Cori-supercomputersystemet.

Som Joe Curley, Sr.Direktør for Code Modernization Organization i Intels Data Center Group, bemærkede, "Big Data Center-samarbejdet har givet fantastiske resultater inden for datalogi gennem kombinationen af Intel-teknologi og dedikeret softwareoptimeringsindsats. Under CosmoFlow-projektet, vi identificerede rammer, kerne- og kommunikationsoptimering, der førte til mere end 750x ydelsesforøgelse for en enkelt node. Lige så imponerende, holdet løste problemer, der begrænsede skalering af deep learning-teknikker til 128 til 256 noder - for nu at tillade CosmoFlow-applikationen at skalere effektivt til 8, 192 noder af Cori-supercomputeren på NERSC."

"Vi er begejstrede for resultaterne og gennembruddene inden for kunstig intelligens-applikationer fra dette samarbejdsprojekt med NERSC og Intel, sagde Per Nyberg, vicepræsident for markedsudvikling, kunstig intelligens og sky på Cray. "Det er spændende at se CosmoFlow-teamet drage fordel af den unikke Cray-teknologi og udnytte kraften i en Cray-supercomputer til effektivt at skalere deep learning-modeller. Det er et godt eksempel på, hvad mange af vores kunder stræber efter i konvergerende traditionel modellering og simulering med nye dyb læring og analysealgoritmer, alt på en enkelt, skalerbar platform."

Prabhat, Gruppeleder for data- og analysetjenester hos NERSC, tilføjet, "Fra mit perspektiv, CosmoFlow er et eksemplarisk projekt for Big Data Center-samarbejdet. Vi har virkelig udnyttet kompetencer fra forskellige institutioner til at løse et hårdt videnskabeligt problem og forbedre vores produktionsstak, som kan gavne det bredere NERSC-brugerfællesskab."

Ud over Bard og Prabhat, medforfattere på SC18-papiret inkluderer Amrita Mathuriya, Lawrence Meadows, Lei Shao, Tuomas Karna, John Pennycook, Jason Sewall, Nalini Kumar og Victor Lee fra Intel; Peter Mendygral, Diana Moise, Kristyn Maschhoff og Michael Ringenburg fra Cray; Siyu He og Shirley Ho fra Flatiron Institute; og James Arnemann fra UC Berkeley.

Varme artikler

Varme artikler

-

Hulu hæver prisen for live-tv-tjeneste, sænker grundpakkeprisenDenne 24. juni, 2015, filbillede viser Hulu Apple TV-appikonet i South Orange, N.J. Hulus live-tv-streamingtjeneste vil koste $5 mere om måneden, mens dens traditionelle video-on-demand-tjeneste vil v

Hulu hæver prisen for live-tv-tjeneste, sænker grundpakkeprisenDenne 24. juni, 2015, filbillede viser Hulu Apple TV-appikonet i South Orange, N.J. Hulus live-tv-streamingtjeneste vil koste $5 mere om måneden, mens dens traditionelle video-on-demand-tjeneste vil v -

Den amerikanske senator Schumer opfordrer til undersøgelse af FaceAppSchumer er ikke den eneste demokrat, der er bekymret Populær Rusland-baseret applikation FaceApp, som giver brugerne mulighed for at ændre deres udseende til at se ældre eller yngre ud, blev besku

Den amerikanske senator Schumer opfordrer til undersøgelse af FaceAppSchumer er ikke den eneste demokrat, der er bekymret Populær Rusland-baseret applikation FaceApp, som giver brugerne mulighed for at ændre deres udseende til at se ældre eller yngre ud, blev besku -

Placering og brand påvirker folks tillid til cloud-tjenesterForskerne lavede produktmeddelelser, der annoncerede 50 gigabyte ledig plads i skyen som et særligt tilbud, der blev givet i anledning af åbningen af nye cloudservice-datacentre. Deltagerne havde st

Placering og brand påvirker folks tillid til cloud-tjenesterForskerne lavede produktmeddelelser, der annoncerede 50 gigabyte ledig plads i skyen som et særligt tilbud, der blev givet i anledning af åbningen af nye cloudservice-datacentre. Deltagerne havde st -

FCC ønsker at rette kort, der nu overdriver bredbåndsdækningI denne 12. april, 2019 filbillede, Formand for Federal Communications Commission, Ajit Pai, taler under en begivenhed i Washington. Pai meddelte under en Senatshøring onsdag, 12 juni, at han ønsker,

FCC ønsker at rette kort, der nu overdriver bredbåndsdækningI denne 12. april, 2019 filbillede, Formand for Federal Communications Commission, Ajit Pai, taler under en begivenhed i Washington. Pai meddelte under en Senatshøring onsdag, 12 juni, at han ønsker,

- Tøris kunne forhindre jernbaneforsinkelser forårsaget af blade på strækningen

- Forskere opfordrer USA til at tillade forskning i pottemedicin til kæledyr

- Gør et varmt sted til et koldt sted:Fano-formede lokale feltresponser undersøgt af en kvantepunkt

- Meteoritternes oprindelse peger på mulig uopdaget asteroide

- Sådan beregnes hjulomkreds

- Hvordan undertrykker CRABS CLAW TORNADO 2 i planteudvikling