Sætte neurale netværk under lup

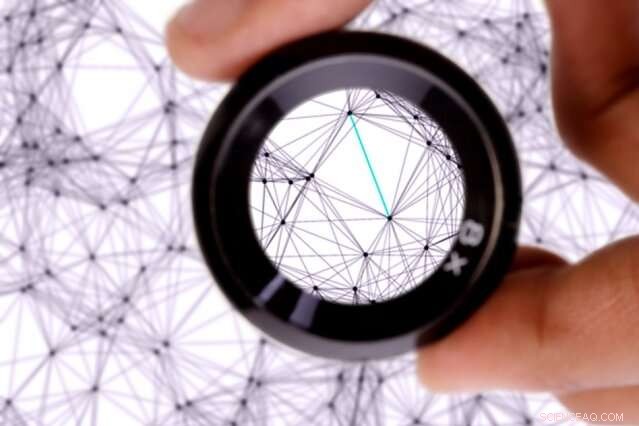

Forskere fra MIT og Qatar Computing Research Institute (QCRI) sætter maskinlæringssystemer kendt som neurale netværk under mikroskopet. Kredit:MIT News

Forskere fra MIT og Qatar Computing Research Institute (QCRI) sætter maskinlæringssystemer kendt som neurale netværk under mikroskopet.

I en undersøgelse, der belyser, hvordan disse systemer formår at oversætte tekst fra et sprog til et andet, forskerne udviklede en metode, der lokaliserer individuelle noder, eller "neuroner, " i de netværk, der fanger specifikke sproglige træk.

Neurale netværk lærer at udføre beregningsopgaver ved at behandle enorme sæt træningsdata. I maskinoversættelse, et netværk knuser sprogdata kommenteret af mennesker, og formentlig "lærer" sproglige træk, såsom ordmorfologi, sætningsstruktur, og ordets betydning. Givet ny tekst, disse netværk matcher disse indlærte funktioner fra et sprog til et andet, og lave en oversættelse.

Men, i træning, disse netværk justerer grundlæggende interne indstillinger og værdier på måder, skaberne ikke kan fortolke. Til maskinoversættelse, det betyder, at skaberne ikke nødvendigvis ved, hvilke sproglige træk netværket fanger.

I et papir, der præsenteres på denne uges Association for the Advancement of Artificial Intelligence-konference, forskerne beskriver en metode, der identificerer, hvilke neuroner der er mest aktive ved klassificering af specifikke sproglige træk. De har også designet et værktøjssæt til brugere til at analysere og manipulere, hvordan deres netværk oversætter tekst til forskellige formål, såsom at kompensere for eventuelle klassifikationsforstyrrelser i træningsdataene.

I deres papir, forskerne udpeger neuroner, der bruges til at klassificere, for eksempel, kønnede ord, fortid og nutid, tal i begyndelsen eller midten af sætninger, og flertals- og entalsord. De viser også, hvordan nogle af disse opgaver kræver mange neuroner, mens andre kun kræver en eller to.

"Vores forskning har til formål at se inde i neurale netværk for sprog og se, hvilken information de lærer, " siger medforfatter Yonatan Belinkov, en postdoc i Computer Science and Artificial Intelligence Laboratory (CSAIL). "Dette arbejde handler om at få en mere finmasket forståelse af neurale netværk og have bedre kontrol over, hvordan disse modeller opfører sig."

Medforfattere på papiret er:seniorforsker James Glass og bachelorstuderende Anthony Bau, af CSAIL; og Hassan Sajjad, Nadir Durrani, og Fahim Dalvi, af QCRI.

At sætte et mikroskop på neuroner

Neurale netværk er struktureret i lag, hvor hvert lag består af mange behandlingsknuder, hver forbundet til noder i lag over og under. Data behandles først i det nederste lag, som sender et output til ovenstående lag, og så videre. Hvert output har en forskellig "vægt" for at bestemme, hvor meget det tæller i det næste lags beregning. Under træning, disse vægte justeres konstant.

Neurale netværk, der bruges til maskinoversættelse, træner på annoterede sprogdata. I træning, hvert lag lærer forskellige "ordindlejringer" for ét ord. Ordindlejringer er i det væsentlige tabeller med flere hundrede tal kombineret på en måde, der svarer til et ord og det ords funktion i en sætning. Hvert tal i indlejringen beregnes af en enkelt neuron.

I deres tidligere arbejde, forskerne trænede en model til at analysere de vægtede output fra hvert lag for at bestemme, hvordan lagene klassificerede en given indlejring. De fandt ud af, at lavere lag klassificerede relativt simplere sproglige træk - såsom strukturen af et bestemt ord - og højere niveauer hjalp med at klassificere mere komplekse træk, såsom hvordan ordene kombineres for at danne mening.

I deres nye arbejde, forskerne bruger denne tilgang til at bestemme, hvordan indlejringer af lærte ord laver en sproglig klassifikation. Men de implementerede også en ny teknik, kaldet "sproglig korrelationsanalyse, ", der træner en model til at komme ind på de individuelle neuroner i hver ordindlejring, der var vigtigst i klassificeringen.

Den nye teknik kombinerer alle indlejringer, der er fanget fra forskellige lag - som hver indeholder information om ordets endelige klassificering - i en enkelt indlejring. Når netværket klassificerer et givet ord, modellen lærer vægte for hver neuron, der blev aktiveret under hver klassificeringsproces. Dette giver en vægt til hver neuron i hvert ordindlejring, der affyrede for en bestemt del af klassifikationen.

"Ideen er, hvis denne neuron er vigtig, der skal være en høj vægt, der er lært, " siger Belinkov. "Neuronerne med høj vægt er dem, der er vigtigere for at forudsige den bestemte sproglige egenskab. Du kan tænke på neuronerne som en masse knapper, du skal dreje for at få den korrekte kombination af tal i indlejringen. Nogle knapper er vigtigere end andre, så teknikken er en måde at tildele disse knapper betydning."

Neuron ablation, model manipulation

Fordi hver neuron vægtes, det kan rangeres i rækkefølge efter vigtighed. Til det formål, forskerne designet et værktøjssæt, kaldet NeuroX, der automatisk rangerer alle neuroner i et neuralt netværk efter deres betydning og visualiserer dem i en webgrænseflade.

Brugere uploader et netværk, de allerede har trænet, samt ny tekst. Appen viser teksten og ved siden af, en liste over specifikke neuroner, hver med et identifikationsnummer. Når en bruger klikker på en neuron, teksten vil blive fremhævet afhængigt af hvilke ord og sætninger neuronen aktiverer for. Derfra, brugere kan slå neuronerne fuldstændig ud - eller "ablate" - eller ændre omfanget af deres aktivering, at kontrollere, hvordan netværket oversættes.

Opgaven med ablation blev brugt til at afgøre, om forskernes metode præcist udpegede de korrekte højtplacerede neuroner. I deres papir, forskerne brugte værktøjet til at vise, at ved at fjerne højtrangerede neuroner i et netværk, dets præstationer med hensyn til at klassificere korrelerede sproglige træk faldt betydeligt. Alternativt da de ablerede lavere rangerende neuroner, ydeevne lidt, men ikke så dramatisk.

"Når du har fået alle disse placeringer, du vil se, hvad der sker, når du dræber disse neuroner og se, hvor slemt det påvirker ydeevnen, " siger Belinkov. "Det er et vigtigt resultat, der beviser, at de neuroner, vi finder, er, faktisk, vigtigt for klassificeringsprocessen."

En interessant applikation til værktøjskassen hjælper med at begrænse skævheder i sprogdata. Maskinoversættelsesmodeller, såsom Google Oversæt, kan træne på data med kønsbias, hvilket kan være problematisk for sprog med kønsbestemte ord. Visse erhverv, for eksempel, kan oftere omtales som mand, og andre som kvindelige. Når et netværk oversætter ny tekst, det kan kun producere det lærte køn for disse ord. I mange online engelsk-til-spansk oversættelser, for eksempel, "læge" oversættes ofte til sin maskuline version, mens "sygeplejerske" oversættes til sin feminine version.

"Men vi finder ud af, at vi kan spore individuelle neuroner med ansvar for sproglige egenskaber som køn, " siger Belinkov. "Hvis du er i stand til at spore dem, måske kan du gribe ind på en eller anden måde og påvirke oversættelsen til at oversætte disse ord mere til det modsatte køn … for at fjerne eller afbøde skævheden."

I foreløbige forsøg, forskerne modificerede neuroner i et netværk for at ændre oversat tekst fra datid til nutid med 67 procents nøjagtighed. De afbrød for at skifte ordenes køn med 21 procents nøjagtighed. "Det er stadig et igangværende arbejde, " siger Belinkov. Et næste skridt, tilføjer han, finjusterer webapplikationen for at opnå mere nøjagtig ablation og manipulation.

Denne historie er genudgivet med tilladelse fra MIT News (web.mit.edu/newsoffice/), et populært websted, der dækker nyheder om MIT-forskning, innovation og undervisning.

Varme artikler

Varme artikler

-

Telefonica-salg ramt af afslutningen af roamingtaksterOphøret af roamingtakster har ramt Telefonicas konti hårdt Den spanske telekomgigant Telefonica oplevede et fald i salget i første kvartal på grund af ophøret af roamingtakster i Europa. men havde

Telefonica-salg ramt af afslutningen af roamingtaksterOphøret af roamingtakster har ramt Telefonicas konti hårdt Den spanske telekomgigant Telefonica oplevede et fald i salget i første kvartal på grund af ophøret af roamingtakster i Europa. men havde -

Det britiske bilsalg ramte det seksårige lavt niveau i 2019:branchens organMange biler, færre købere Det nye britiske bilsalg sank i 2019 til et laveste niveau på seks år på grund af en svag efterspørgsel efter dieselmotorer med høj forurening og blandt Brexit-usikkerhed

Det britiske bilsalg ramte det seksårige lavt niveau i 2019:branchens organMange biler, færre købere Det nye britiske bilsalg sank i 2019 til et laveste niveau på seks år på grund af en svag efterspørgsel efter dieselmotorer med høj forurening og blandt Brexit-usikkerhed -

Forskere rapporterer om en ny måde at producere kurvet elektronik påEt team af forskere ledet af University of Houston ingeniør Cunjiang Yu har rapporteret en ny måde at fremstille kurvede, tredimensionel elektronik. Kredit:University of Houston Kontaktlinser, der

Forskere rapporterer om en ny måde at producere kurvet elektronik påEt team af forskere ledet af University of Houston ingeniør Cunjiang Yu har rapporteret en ny måde at fremstille kurvede, tredimensionel elektronik. Kredit:University of Houston Kontaktlinser, der -

Forskere udvikler en sukkerdrevet sensor til at opdage, forebygge sygdomSu Ha og Subhanshu Gupta, holder en glukosedrevet biobrændselscelle. Kredit:Washington State University Forskere ved Washington State University har udviklet en implanterbar, biobrændstofdrevet se

Forskere udvikler en sukkerdrevet sensor til at opdage, forebygge sygdomSu Ha og Subhanshu Gupta, holder en glukosedrevet biobrændselscelle. Kredit:Washington State University Forskere ved Washington State University har udviklet en implanterbar, biobrændstofdrevet se

- Sådan opløses EDTA i Water

- Detektering af et hidtil uset udvalg af potentielt skadelige luftbårne forbindelser

- Sådan konverteres amerikanske gaspriser til liter

- Brændstofmangel, flaskehalse hæmmer Floridas masseudvandring

- Det mest indflydelsesrige klimavidenskabelige papir nogensinde

- Ordnet arrangeret perlekæde ternære nanokompositter til superkondensatorer