ExAG:Et billedgættespil til at evaluere hjælpsomheden af maskinforklaringer

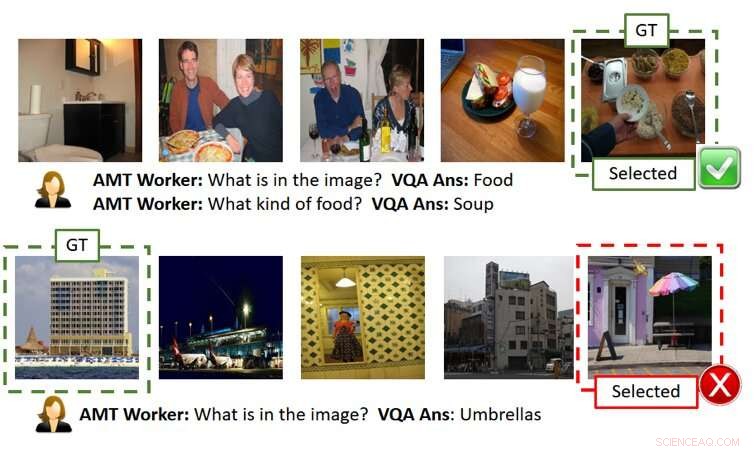

Figuren ovenfor viser to spil uden forklaringer (hver række er et spileksempel). Som vist i øverste række, brugeren (dvs. AMT Worker, siden vi har brugt Amazon Mechanical Turk til storstilet crowd-source-baseret evaluering) er i stand til at finde ud af det hemmelige billede korrekt givet nøjagtige AI-svar. Imidlertid, som vist i nederste række, brugeren kan fejle, selv når AI-svarene er rimelige, men en smule off-point (dvs. der er en paraply-lignende struktur ved siden af bygningen, selv om det ikke er fokus på grund-sandheden billedet). GT betyder Ground Truth (dvs. det hemmelige billede), Valgt er det billede, som brugeren har valgt efter at have stillet spørgsmålene og fået svarene og/eller forklaringerne. Kredit:Ray et al.

I de seneste år, forskere har forsøgt at gøre kunstig intelligens (AI) mere gennemsigtig ved at udvikle algoritmer, der kan forklare deres handlinger og adfærd, da dette kunne fremme større tillid til maskiner og forbedre menneske-AI-interaktioner. Trods deres indsats, Indtil videre har meget få undersøgelser konkret evalueret virkningen af AI-forklaringer på præstationen opnået i opgaver, der involverer menneske-AI-samarbejde.

For at løse dette hul i den eksisterende litteratur, et team af forskere ved SRI International har skabt et menneske-AI-billedgættespil inspireret af det populære spil 20 Questions (20Q), som kan bruges til at vurdere hjælpsomheden af maskinforklaringer. Deres papir, for nylig offentliggjort på arXiv, er blandt de første til at udforske virkningerne af at udvikle mere 'forklarlig' AI.

"Ideen opstod, mens vi arbejdede på et DARPA -projekt, "Arijit Ray, en datalog ved SRI International, der udførte undersøgelsen, fortalte TechXolore. "I dette projekt vi udvikler forklarlige AI-systemer, som ikke kun genererer det ønskede output (f.eks. objektdetektering, svar på spørgsmål, osv.), men også forklaringer på, hvordan de nåede frem til det output. Vi havde brug for en mekanisme til at evaluere, om de yderligere forklaringer fra AI'er var nyttige for brugeren for at få en bedre forståelse af AI-systemerne. Til denne ende, vi skabte en interaktiv menneske-AI-samarbejdsopgave, Forklaringsassisteret GuessWhich (ExAG), som er en tilpasning af det berømte 20Q spil, at demonstrere effektiviteten af de forskellige maskinforklaringsteknikker, som vi udvikler. "

Billedgættespillet udviklet af Ray og hans kolleger ligner meget det populære spil 20 Questions, som normalt involverer to spillere. I 20Q, en spiller tænker på noget, og den anden spiller forsøger at gætte, hvad det er ved at stille 20 lukkede spørgsmål (dvs. spørgsmål, der kun kan besvares med 'ja' eller 'nej').

I ExAG, tilpasningen af spillet udtænkt af Ray og hans kolleger, en bruger får vist fem billeder, hvoraf den ene er blevet valgt af AI-systemet som det 'hemmelige billede'. I det væsentlige, brugeren skal finde ud af, hvilket af billederne han/hun så er det "hemmelige billede", ved at stille spørgsmål om det naturlige sprog.

I modsætning til det traditionelle 20Q-spil, i ExAG kan menneskelige brugere stille både lukkede og åbne spørgsmål. For eksempel, de kunne spørge 'hvad er på billedet?, ' 'hvor er billedet taget?' og så videre. AI-systemet besvarer en brugers spørgsmål ét ad gangen og kan eventuelt forklare sine svar.

Baseret på disse svar, brugeren vil derefter forsøge at gætte det billede, som AI'en oprindeligt havde valgt. Det overordnede mål med spillet er at identificere det 'hemmelige billede' korrekt ved at stille så få spørgsmål som muligt.

"AI-systemet giver to forklaringsmåder, visuel og tekstlig, " Ray forklarede. "For visuelle forklaringer, AI-systemet genererer varmekort, der fremhæver de regioner, der understøtter dets svar. For eksempel, hvis en bruger spørger, hvad der er på billedet, og det ligner en hund, AI vil fremhæve hunderegionen og sige, at det er det, der fører til svaret "det er en hund." For tekstmæssige forklaringer, på den anden side, AI-systemet giver svar på relaterede spørgsmål til hvert af billederne. Så, hvis du spørger, hvad en person laver, og svaret er at surfe, for eksempel, det vil også besvare relaterede spørgsmål som 'hvad ser jeg på billedet? En surfer.' 'Hvor er billedet taget? En strand.'

På grund af arten af billedgættelegen, kvaliteten af svarene og forklaringerne fra AI kan betydeligt påvirke en menneskelig brugers succes og ydeevne. Det er værd at bemærke, at den nuværende state-of-the-art ydeevne inden for visuel besvarelse af spørgsmål er omkring 65 procent, hvilket betyder, at AI-systemet genererer korrekte svar 65 procent af tiden.

Ray og hans kolleger observerede, at brugere typisk havde succes med ExAG ved at drage fordel af AIs forklaringer, især når svarene i sig selv var forkerte. For eksempel, hvis det 'hemmelige billede' portrætterer en hund, men AI'en svarer 'det er en surfer, ' en visuel forklaring kunne hjælpe en menneskelig bruger med at indse AI'ens fejl. Ifølge forskerne, dette beviser, at deres spil er et velegnet værktøj til at evaluere hjælpsomheden af AI-forklaringer.

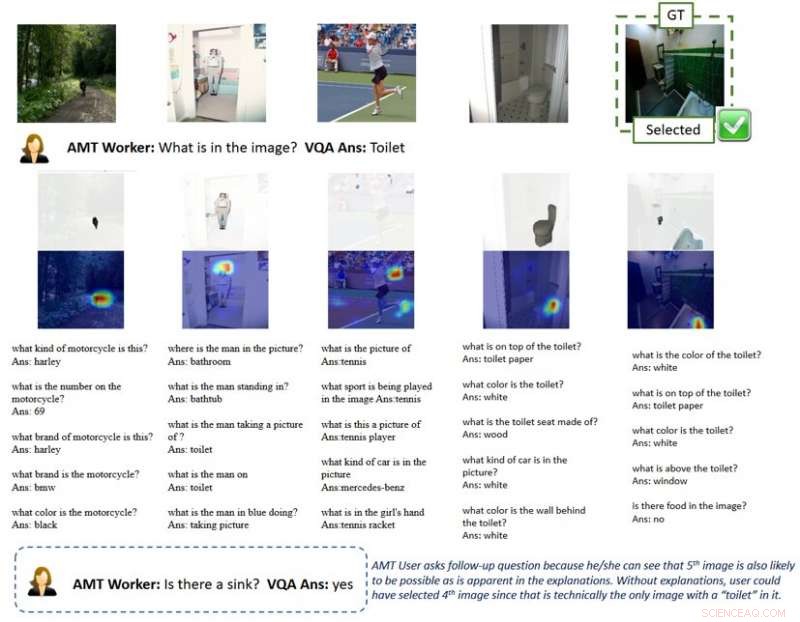

Figuren ovenfor viser et gameplay med forklaringer. Varmekortets visuelle forklaring fremhæver de områder på billederne, der fører til AI-svar. Med en sådan forklaring, brugere får forståelse for, at AI-systemer kan opfange objekter, der ikke er hovedfokus i billedet i menneskets perspektiv, når de besvarer et generelt spørgsmål som "hvad er på billedet". Dette antyder brugeren til at stille opfølgende spørgsmål og til sidst vælge det hemmelige billede korrekt. GT betyder Ground Truth (dvs. det hemmelige billede), Valgt er det billede, som brugeren har valgt efter at have stillet spørgsmålene og fået svarene og/eller forklaringerne. Kredit:Ray et al.

"Efter min mening, det mest interessante resultat af vores undersøgelse er, at brugere kan bruge nogle få gode forklaringer til at vinde spil, når AI-svarene for det meste er forkerte, " sagde Ray. "I modsætning hertil, til spil med lignende svarnøjagtighed, men uden forklaringer, brugere stoler blindt på AI-genererede svar og taber spillet. Dette understøtter vigtigheden af selv nogle få gode forklaringer på et menneske-AI-samarbejdssystem, især når AI-systemet er uperfekt, hvilket det er i de fleste tilfælde i disse dage."

For at forklare denne idé bedre, Ray giver eksemplet med selvkørende køretøjer. I løbet af de sidste par år, der har været megen debat om deres sikkerhed, også på grund af ulykker, der skete, mens køretøjerne blev testet. Ifølge Ray, effektive AI-forklaringer kunne fremme større tillid til sikkerheden i selvkørende køretøjer, da de ville give menneskelige chauffører mulighed for at identificere problemer på forhånd og forhindre ulykker.

"For eksempel, lad os antage, at AI-systemet oplever problemer med at registrere banerne pålideligt, " sagde Ray. "Da vejen i øjeblikket er lige, uden yderligere oplysninger, brugeren ville ikke være i stand til at fortælle, om AI'en fejler. Selvom han/hun var i tvivl, han/hun ville nok ikke gøre noget før i sidste øjeblik, når bilen skal en tur, gør ikke, og styrter, hvilket ville være for sent. I modsætning, hvis en skærm i bilen viste forklaringer på, hvordan AI opfatter miljøet, såsom varmekort, brugeren ville være i stand til at fortælle AI's latente fejl og tage kontrol over hjulet på forhånd."

Forskerne fandt ud af, at nyttige forklaringer positivt påvirkede menneskelige brugeres præstationer i billedgættespillet. Deres resultater tyder på, at det var væsentligt nyttigt at have mindst én 'korrekt' forklaring, især i tilfælde, hvor AI's svar på brugerspørgsmål var 'støjende' eller dårligt definerede. Interessant nok, spillere udviklede en præference for forklaringer frem for svar og vurderede ofte AI-forklaringerne som 'nyttige'.

"Jeg tror, at mens flere arbejdslinjer forsøgte at give forklaringer på et AI-systems resultater eller handlinger, vores er den første undersøgelse, der introducerer en menneskelig og maskinel samarbejdsopgave for at evaluere effektiviteten af AI-forklaringer; dermed, det bragte en masse indsigt i, hvordan AI-forklaringer kunne forbedre menneske-robot-interaktioner, "Yi Yao, en senior teknisk leder hos SRI International, der var involveret i undersøgelsen, fortalte TechXplore.

Undersøgelsen udført af Ray og hans kolleger er en af de første til at give håndgribelige beviser på nytten af AI -forklaringer. Forskerne håber, at deres forskning i sidste ende vil informere udviklingen af AI-systemer, der kan handle rationelt i samfundet, dermed forbinder og relaterer bedre til mennesker.

Ifølge Ray, AI-systemer, der klart kan forklare ræsonnementet og processerne bag deres handlinger, ville være et væsentligt skridt fremad i udviklingen af intelligente maskiner. Ved effektivt at besvare spørgsmål og rationalisere deres beslutninger, disse systemer kunne fremme en større følelse af tillid til kunstig intelligens, samt et dybere forhold til det.

"Mange andre virksomheder, grupper og forskningsgrupper har behandlet forklarlig AI, og der har været mange forslag til, hvordan man kan udvide eksisterende AI-modeller og -systemer for at give forklaringer til brugerne, " sagde Giedrius Burachas, en senior datalog ved SRI International og hovedefterforsker bag DARPA-undersøgelsen, der førte til udviklingen af Guess Which-spillet. "Selvom der blev genereret mange ideer, bevis på, at disse idéer manglede, så en af de stærke sider af vores forskning er, at den giver et uomtvisteligt bevis på, at visse typer forklaringer virkelig er meget effektive til at forbedre samarbejdet med AI-systemerne, men også med at opbygge tillid til dem."

Indtil nu, Rays og hans kollegers arbejde fokuserede primært på visuelle spørgsmålssvar (VQA) opgaver, hvor brugere stiller spørgsmål om billeder og en AI svarer. De planlægger nu at fortsætte deres forskning i AI-forklaringsteknikker, at anvende disse teknikker til et bredere spektrum af AI-opgaver.

"Vi vil også fortsætte med at udvikle protokoller til at evaluere effektiviteten af de AI-genererede forklaringer med finere granularitet (f.eks. hvilken forklaring er mere effektiv under hvilke scenarier?) og fra forskellige perspektiver (f.eks. hjælper forklaringer brugere med at opbygge den mentale model?), " sagde Ray. "For at lukke løkken, vi vil bruge erfaringer fra disse evalueringer til at udvikle mere effektive forklaringsmetoder. Vi mener, at den hellige gral af forklarlig AI er at udtænke forklaringer, der ikke kun informerer brugerne, men også forbedrer maskinens ydeevne ved at forbedre dens ræsonnementevne."

Ud over at udforske virkningerne af AI-forklaringer på menneskelige brugeres ydeevne og opfattelser, derfor, forskerne vil gerne undersøge deres indvirkning på AI-systemerne selv. De føler, at AI-forklaringer også kan gøre AI-systemer i sagens natur bedre, da de gradvist ville opnå ræsonnement og rationaliseringsevner.

© 2019 Science X Network

Varme artikler

Varme artikler

-

Ny teknologi bryder igennem tegnsprogsbarriererMSU-ingeniører udviklede og patenterede en tegnsprogsoversætterteknologi, der – i modsætning til tidligere mekanismer – er ikke-invasiv og lige så bærbar som et rør Chapstick. Kredit:Michigan State Un

Ny teknologi bryder igennem tegnsprogsbarriererMSU-ingeniører udviklede og patenterede en tegnsprogsoversætterteknologi, der – i modsætning til tidligere mekanismer – er ikke-invasiv og lige så bærbar som et rør Chapstick. Kredit:Michigan State Un -

Forskere udvikler en hurtigere måde at erstatte dårlige data med nøjagtig informationKredit:North Carolina State University Forskere fra North Carolina State University og Army Research Office har demonstreret en ny model for, hvordan konkurrerende stykker information spredes i on

Forskere udvikler en hurtigere måde at erstatte dårlige data med nøjagtig informationKredit:North Carolina State University Forskere fra North Carolina State University og Army Research Office har demonstreret en ny model for, hvordan konkurrerende stykker information spredes i on -

Ingeniører udvikler et HAL 9000-type AI-system til overvågning af planetbasestationerFig. 1 En intelligent agent, ligesom HAL 9000. (A) Arkitektonisk design på topniveau CASE. Planlæggeren genererer en aktivitetsplan, hvis handlinger er procedurer, der køres af eksekveringssystemet, h

Ingeniører udvikler et HAL 9000-type AI-system til overvågning af planetbasestationerFig. 1 En intelligent agent, ligesom HAL 9000. (A) Arkitektonisk design på topniveau CASE. Planlæggeren genererer en aktivitetsplan, hvis handlinger er procedurer, der køres af eksekveringssystemet, h -

Google introducerer brailletastatur til AndroidKredit:Google Google udgav i sidste uge et indbygget virtuelt braille-tastatur til blinde og svagtseende brugere. Det nye TalkBack-tastatur blev aktiveret torsdag på enheder, der kører Android 5.0

Google introducerer brailletastatur til AndroidKredit:Google Google udgav i sidste uge et indbygget virtuelt braille-tastatur til blinde og svagtseende brugere. Det nye TalkBack-tastatur blev aktiveret torsdag på enheder, der kører Android 5.0

- OS, Kina rådførte sig om sikkerhed, da deres håndværk var på vej til Mars

- Ny målrettet modifikationsstrategi forbedrer selektiviteten af polyamid -nanofiltreringsmembraner

- Konvertering af affald, en restressource, til biobrændstoffer reducerer emissionerne

- Kvanteffekter fører til mere kraftfuld batteriopladning

- Idéer til musefældeprojekter

- Store jordsatellit til at spore katastrofer, virkningerne af klimaændringer