Intel-forskere udvikler et system til korrektion af øjenkontakt til videochat

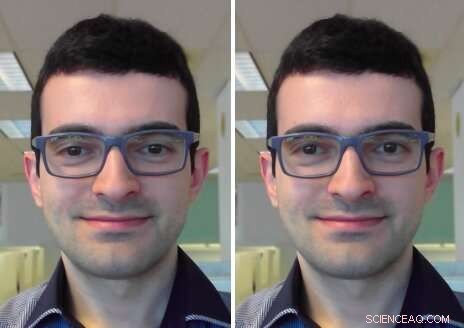

Øjenkontaktkorrektion:I inputrammen (venstre) kigger brugeren på skærmen. I outputrammen (til højre) er hans blik korrigeret for at se ind i kameraet. Kredit:Isikdogan, Gerasimow og Michael.

Når du deltager i et videoopkald eller konference, det er ofte svært at opretholde direkte øjenkontakt med andre deltagere, da dette kræver at man ser ind i kameraet i stedet for på skærmen. Selvom de fleste bruger videoopkaldstjenester regelmæssigt, indtil nu, der har ikke været nogen udbredt løsning på dette problem.

Et team af forskere hos Intel har for nylig udviklet en øjenkontakt-korrektionsmodel, der kan hjælpe med at overvinde denne gener ved at genoprette øjenkontakt i live videochat, uanset hvor en enheds kamera og skærm er placeret. I modsætning til tidligere foreslåede tilgange, denne model centrerer automatisk en persons blik uden behov for input, der specificerer omdirigeringsvinklen eller kamera/skærm/brugergeometri.

"Hovedformålet med vores projekt er at forbedre kvaliteten af videokonferenceoplevelser ved at gøre det nemmere at bevare øjenkontakt, "Leo Isikdogan, en af de forskere, der har udført undersøgelsen, fortalte TechXplore. "Det er svært at bevare øjenkontakt under et videoopkald, fordi det ikke er naturligt at se ind i kameraet under et opkald. Folk ser på den anden persons billede på deres display, eller nogle gange ser de endda på deres eget eksempelbillede, men ikke ind i kameraet. Med denne nye funktion til korrektion af øjenkontakt, brugere vil være i stand til at have en naturlig samtale ansigt til ansigt."

Hovedmålet med undersøgelsen udført af Isikdogan og hans kolleger var at skabe en naturlig videochatoplevelse. For at opnå dette, de ønskede kun, at deres øjenkontaktkorrektion skulle fungere, når en bruger er involveret i samtalen, snarere end når de naturligt fjerner øjnene fra skærmen (f.eks. når de ser på papirer eller manipulerer med genstande i deres omgivelser).

"Øjenkontaktkorrektion og blikomdirigering generelt, er ikke nye forskningsideer, " sagde Isikdogan. "Mange forskere har foreslået modeller til at manipulere, hvor folk ser på billeder. Imidlertid, nogle af disse kræver specielle hardwareopsætninger, andre har brug for yderligere oplysninger fra brugeren, som i hvilken retning og hvor meget omdirigeringen skal være, og andre bruger beregningsmæssigt dyre processer, der kun er mulige til behandling af forudindspillede videoer."

Det nye system, der er udviklet af Isikdogan og hans kolleger, bruger et dybt konvolutionelt neuralt netværk (CNN) til at omdirigere en persons blik ved at fordreje og justere øjnene i dets inputrammer. I det væsentlige, CNN behandler et monokulært billede og producerer et vektorfelt og et lysstyrkekort for at korrigere en brugers blik.

I modsætning til tidligere foreslåede tilgange, deres system kan køre i realtid, ud af æsken og uden at kræve noget input fra brugere eller dedikeret hardware. I øvrigt, korrektoren fungerer på en række forskellige enheder med forskellige skærmstørrelser og kamerapositioner.

"Vores øjenkontaktkorrektor bruger et sæt kontrolmekanismer, der forhindrer pludselige ændringer og sikrer, at øjenkontaktkorrektoren undgår at udføre unaturlige korrektioner, der ellers ville være uhyggelige, " sagde Isikdogan. "F.eks. korrektionen deaktiveres jævnt, når brugeren blinker eller ser et sted langt væk."

Forskerne trænede deres model på en tovejs måde på et stort datasæt af syntetisk genererede, fotorealistiske og mærkede billeder. De evaluerede derefter dets effektivitet, og hvordan brugerne opfattede det i en række blindtests.

"Vores blindtest viste, at de fleste mennesker ikke ved, hvornår vi slår vores algoritme til eller fra, de ser ingen artefakter, men føler bare, at de har øjenkontakt med den person, de kommunikerer med, "Gilad Michael, en anden forsker involveret i undersøgelsen, fortalte TechXplore.

Interessant nok, forskerne observerede, at deres model også havde lært at forudsige inputblikket (dvs. hvor den troede, at en bruger kiggede, før hans/hendes blik blev rettet), selv om aldrig blev uddannet til det. De mener, at denne evne kan være et biprodukt af modellens kontinuerlige omdirigering af en brugers blik til centrum, uden at angive, hvor en bruger søgte i første omgang.

"Modellen udledte simpelthen inputblikket, så det kan flytte det til midten, " Forklarede Isikdogan. "Derfor, vi kan uden tvivl betragte øjenkontaktkorrektionsproblemet som et delvist supersæt af blikforudsigelse."

Resultaterne indsamlet af forskerne fremhæver også værdien af at bruge fotorealistiske syntetiske data til at træne algoritmer. Faktisk, deres model opnåede bemærkelsesværdige resultater, selvom den under træning næsten udelukkende var afhængig af computergenererede billeder. Forskerne er langt fra de første til at eksperimentere med syntetiske træningsdata, alligevel er deres undersøgelse en yderligere bekræftelse af dets potentiale til at skabe højtydende applikationer.

"Vi bekræftede også, at det er en god praksis at have kortlægningsreversibilitet i tankerne, når man bygger modeller, der manipulerer deres input, " tilføjede Isikdogan. "F.eks. hvis modellen flytter nogle pixels fra nederst til venstre til midten, vi burde være i stand til at bede modellen om at flytte dem tilbage til nederst til venstre og få et billede, der ser næsten identisk ud med det originale billede. Denne tilgang forhindrer modellen i at ændre billeder uden reparation."

I fremtiden, systemet foreslået af Isikdogan, Michael og deres kollega Timo Gerasimow kunne være med til at forbedre videokonferenceoplevelser, bringer dem endnu tættere på personlige interaktioner. Forskerne planlægger nu at færdiggøre deres system, så det kan anvendes på eksisterende videokonferencetjenester.

"Vi gør en stor indsats for at sikre, at vores løsning er praktisk og klar til at blive brugt i rigtige produkter, " sagde Michael. "Vi vil måske nu prøve at forbedre nogle af biproduktfundene af algoritmen, såsom blikregistrering og engagementsvurdering for at muliggøre tilstødende use-cases."

© 2019 Science X Network

Varme artikler

Varme artikler

-

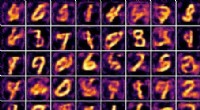

BinaryGAN:et generativt modstridende netværk med binære neuronerForaktiverede udgange (dvs. den reelle værdi, mellemværdier lige før binariseringsoperationen; se afsnit 2.2) for den foreslåede model implementeret af MLPer og trænet med WGAN-GP-målsætningen. Foresl

BinaryGAN:et generativt modstridende netværk med binære neuronerForaktiverede udgange (dvs. den reelle værdi, mellemværdier lige før binariseringsoperationen; se afsnit 2.2) for den foreslåede model implementeret af MLPer og trænet med WGAN-GP-målsætningen. Foresl -

Australien bør lære af globalt brintfokus, siger rapportenKredit:CC0 Public Domain Lande rundt om i verden gør nu hurtige fremskridt inden for brintenergiteknologier og -strategi - og Australien har meget at lære af deres erfaringer, ifølge forfatterne a

Australien bør lære af globalt brintfokus, siger rapportenKredit:CC0 Public Domain Lande rundt om i verden gør nu hurtige fremskridt inden for brintenergiteknologier og -strategi - og Australien har meget at lære af deres erfaringer, ifølge forfatterne a -

Samsung Electronics markerer en stigning på 5,2 % i Q2-resultatetSamsungs prognose indikerer en ende på firmaets rekordopstilling i stigende driftsoverskud Den sydkoreanske telekomgigant Samsung Electronics har fredag markeret en stigning på 5,2 procent i sit

Samsung Electronics markerer en stigning på 5,2 % i Q2-resultatetSamsungs prognose indikerer en ende på firmaets rekordopstilling i stigende driftsoverskud Den sydkoreanske telekomgigant Samsung Electronics har fredag markeret en stigning på 5,2 procent i sit -

Undersøgelse viser, at arbejdere hellere ville blive erstattet af en robot end en anden personKredit:CC0 Public Domain En trio af forskere med det tekniske universitet i München og Erasmus University Rotterdam har fundet beviser, der tyder på, at arbejdere hellere ville blive erstattet af

Undersøgelse viser, at arbejdere hellere ville blive erstattet af en robot end en anden personKredit:CC0 Public Domain En trio af forskere med det tekniske universitet i München og Erasmus University Rotterdam har fundet beviser, der tyder på, at arbejdere hellere ville blive erstattet af

- Kunne en computer en dag genskabe sig selv? Nyt nanomateriale 'styrer' strøm i flere dimensioner

- Visualisering af ændringer i nanoskala i grafens elektroniske egenskaber

- Biomaterialer skærper op med CRISPR

- Astrofysikere kortlægger lysenergien indeholdt i Mælkevejen

- Astronomer identificerer en mega metalfattig dværgstjerne

- Hvad er første kvartil?