Identificering af oplevede følelser fra folks gangstil

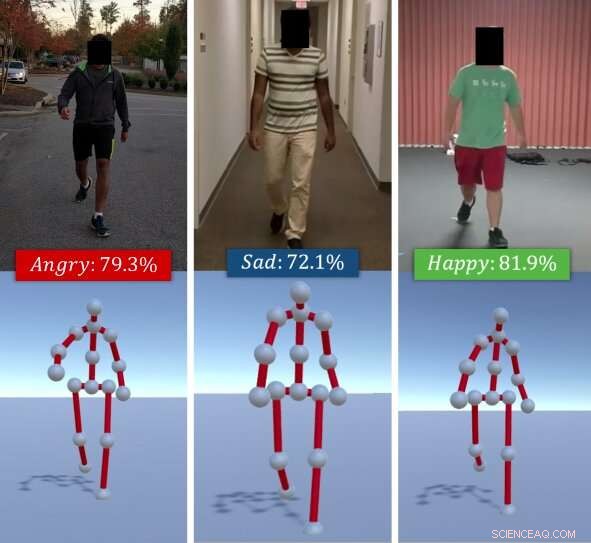

Algoritmen identificerer individers oplevede følelser baseret på deres gangstile. I betragtning af en RGB -video af en individuel gående (øverst), forskernes metode udtrækker hans/hendes gangart som en række 3D -stillinger (nederst). Den bruger derefter en kombination af dybe funktioner, der er lært via en LSTM, og affektive funktioner, der beregnes ved hjælp af krops- og bevægelsestegn, og klassificerer disse i grundlæggende følelser (f.eks. lykkelig, trist, etc.), ved hjælp af en Random Forest Classifier. Kredit:Randhavane et al.

Et team af forskere ved University of North Carolina i Chapel Hill og University of Maryland at College Park har for nylig udviklet en ny model for dyb læring, der kan identificere folks følelser baseret på deres vandrestier. Deres tilgang, skitseret i et papir, der på forhånd blev offentliggjort på arXiv, arbejder ved at udtrække en persons gang fra en RGB -video af ham/hende, der går, derefter analysere det og klassificere det som en af fire følelser:glad, trist, vred eller neutral.

"Følelser spiller en vigtig rolle i vores liv, definerer vores oplevelser, og forme hvordan vi ser på verden og interagerer med andre mennesker, "Tanmay Randhavane, en af de primære forskere og en kandidatstuderende ved UNC, fortalte TechXplore. "At opfatte andre menneskers følelser hjælper os med at forstå deres adfærd og beslutte vores handlinger over for dem. F.eks. mennesker kommunikerer meget anderledes med nogen, de opfatter som vred og fjendtlig, end de gør med nogen, de opfatter som værende rolige og tilfredse. "

De fleste eksisterende følelsesgenkendelses- og identifikationsværktøjer fungerer ved at analysere ansigtsudtryk eller stemmeoptagelser. Imidlertid, tidligere undersøgelser tyder på, at kropssprog (f.eks. positur, bevægelser, osv.) kan også sige meget om, hvordan nogen har det. Inspireret af disse observationer, forskerne satte sig for at udvikle et værktøj, der automatisk kan identificere individets oplevede følelser baseret på deres gangstil.

"Den største fordel ved vores opfattede tilgang til følelsesgenkendelse er, at den kombinerer to forskellige teknikker, "Randhavane sagde." Ud over at bruge dyb læring, vores tilgang udnytter også resultaterne af psykologiske undersøgelser. En kombination af begge disse teknikker giver os en fordel i forhold til de andre metoder. "

Fremgangsmåden udtrækker først en persons gangart fra en RGB -video af dem, der går, repræsenterer det som en serie af 3D-stillinger. Efterfølgende, forskerne brugte en langvarig korttidshukommelse (LSTM) tilbagevendende neuralt netværk og en tilfældig skov (RF) klassifikator til at analysere disse positurer og identificere den mest fremtrædende følelse, som personen følte i videoen, vælge mellem lykke, sorg, vrede eller neutral.

LSTM er oprindeligt uddannet i en række dybe funktioner, men disse kombineres senere med affektive træk beregnet ud fra gangarterne ved hjælp af kropsholdnings- og bevægelsestegn. Alle disse funktioner klassificeres i sidste ende ved hjælp af RF -klassifikatoren.

Randhavane og hans kolleger gennemførte en række indledende tests på et datasæt indeholdende videoer af mennesker, der gik, og fandt ud af, at deres model kunne identificere individets oplevede følelser med 80 procent nøjagtighed. Ud over, deres tilgang førte til en forbedring på cirka 14 procent i forhold til andre opfattede følelsesgenkendelsesmetoder, der fokuserer på folks gangstil.

"Selvom vi ikke gør nogen påstande om de faktiske følelser, en person oplever, vores tilgang kan give et skøn over den oplevede følelse af denne gangstil, "Aniket Bera, en forskningsprofessor i datalogi, føre tilsyn med forskningen, fortalte TechXplore. "Der er mange applikationer til denne forskning, lige fra bedre menneskelig opfattelse af robotter og autonome køretøjer til forbedret overvågning til at skabe mere engagerende oplevelser inden for augmented og virtual reality. "

Sammen med Tanmay Randhavane og Aniket Bera, forskergruppen bag denne undersøgelse omfatter Dinesh Manocha og Uttaran Bhattacharya ved University of Maryland ved College Park, samt Kurt Gray og Kyra Kapsaskis fra psykologiafdelingen ved University of North Carolina i Chapel Hill.

For at træne deres dybe læringsmodel, forskerne har også samlet et nyt datasæt kaldet Emotion Walk (EWalk), som indeholder videoer af personer, der går i både indendørs og udendørs omgivelser mærket med oplevede følelser. I fremtiden, dette datasæt kunne bruges af andre teams til at udvikle og træne nye følelsesgenkendelsesværktøjer designet til at analysere bevægelse, positur, og/eller gangart.

"Vores forskning er på et meget primitivt stadium, "Bera sagde." Vi vil udforske forskellige aspekter af kropssproget og se på flere tegn såsom ansigtsudtryk, tale, vokale mønstre, etc., og brug en multimodal tilgang til at kombinere alle disse signaler med gangarter. I øjeblikket, vi antager, at gangbevægelsen er naturlig og ikke indebærer noget tilbehør (f.eks. kuffert, mobiltelefoner, etc.). Som en del af det fremtidige arbejde, vi vil gerne indsamle flere data og træne vores deep-learning-model bedre. Vi vil også forsøge at udvide vores metode til at overveje flere aktiviteter såsom løb, gestikulerer, etc."

Ifølge Bera, opfattede følelsesgenkendelsesværktøjer kan snart hjælpe med at udvikle robotter med mere avanceret navigation, planlægning, og interaktionsevner. Ud over, modeller som deres kan bruges til at opdage uregelmæssig adfærd eller gangmønstre fra videoer eller CCTV -optagelser, f.eks. identifikation af personer, der er i fare for selvmord, og advarer myndigheder eller sundhedsudbydere. Deres model kunne også anvendes i VFX- og animationsindustrien, hvor det kunne hjælpe designere og animatorer med at skabe virtuelle karakterer, der effektivt udtrykker bestemte følelser.

© 2019 Science X Network

Sidste artikelAutomatiseret system genererer robotdele til nye opgaver

Næste artikelNye valgsystemer bruger sårbar software

Varme artikler

Varme artikler

-

Kunstig intelligens system bruger gennemsigtige, menneskelignende ræsonnement for at løse probleme…TbD-net løser det visuelle ræsonnement problem ved at opdele det i en kæde af delopgaver. Svaret på hver delopgave er vist i varmekort, der fremhæver objekterne af interesse, giver analytikere mulighe

Kunstig intelligens system bruger gennemsigtige, menneskelignende ræsonnement for at løse probleme…TbD-net løser det visuelle ræsonnement problem ved at opdele det i en kæde af delopgaver. Svaret på hver delopgave er vist i varmekort, der fremhæver objekterne af interesse, giver analytikere mulighe -

Sony køber det meste af EMI Music, at bruge $9B på billedsensorerSony Corp.-præsident Kenichiro Yoshida taler, mens karakterer fra Peanuts vises på en pressekonference i virksomhedens hovedkvarter tirsdag, 22. maj, 2018, i Tokyo. Elektronik- og underholdningsvirkso

Sony køber det meste af EMI Music, at bruge $9B på billedsensorerSony Corp.-præsident Kenichiro Yoshida taler, mens karakterer fra Peanuts vises på en pressekonference i virksomhedens hovedkvarter tirsdag, 22. maj, 2018, i Tokyo. Elektronik- og underholdningsvirkso -

Sensormærkater forvandler menneskekroppen til en multi-touch overfladeSaarbruecken computerforskere har udviklet nye hudfølere, der gør det muligt at styre mobile enheder fra ethvert punkt på kroppen. Kredit:Saarland University Sensorer gør det nu muligt at fange be

Sensormærkater forvandler menneskekroppen til en multi-touch overfladeSaarbruecken computerforskere har udviklet nye hudfølere, der gør det muligt at styre mobile enheder fra ethvert punkt på kroppen. Kredit:Saarland University Sensorer gør det nu muligt at fange be -

Analytisk model forudsiger præcis, hvor meget et stykke hardware vil fremskynde datacentreAccelerometer-estimeret hastighed for vigtige omkostninger identificeret af forskerne. Kredit:University of Michigan Store softwaretjenester kæmper effektivitetskampen på to fronter-effektiv softw

Analytisk model forudsiger præcis, hvor meget et stykke hardware vil fremskynde datacentreAccelerometer-estimeret hastighed for vigtige omkostninger identificeret af forskerne. Kredit:University of Michigan Store softwaretjenester kæmper effektivitetskampen på to fronter-effektiv softw

- Et helt optisk neuralt netværk på en enkelt chip

- Bredbåndsafbrydelse har store konsekvenser for landmænd i Midtvesten

- Forskere observerer kompleks afstembar magnetisme knyttet til elektrisk ledning i et topologisk mate…

- Tyrkiet afslører rute på 45 km Istanbul-kanalen

- Hvordan isnåle væver mønstre af sten i frosne landskaber

- Forskere udfordrer CRP-status quo for at afbøde fossile brændstoffer