AI:Agenter viser overraskende adfærd i gemmeleg

Kredit:openai

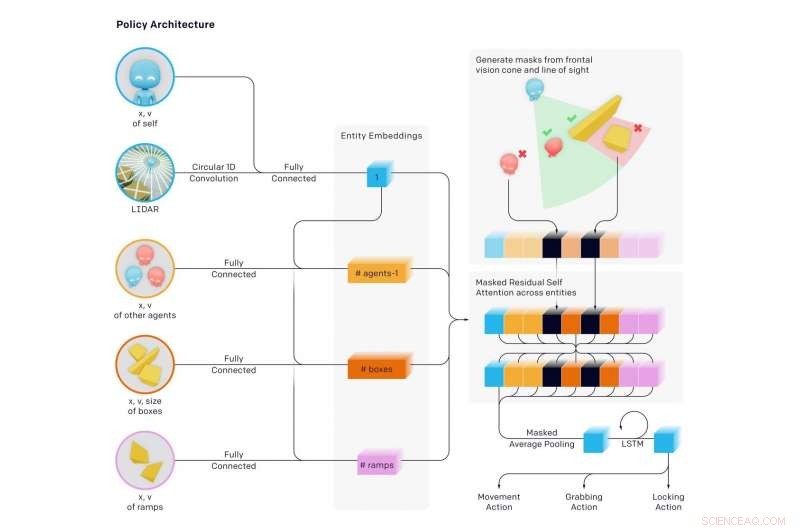

Forskere har lavet nyheder ved at lade deres AI -ambitioner udspille et formidabelt gemmeleg med formidable resultater. Agentenes miljø havde vægge og bevægelige kasser til en udfordring, hvor nogle var skjulerne og andre, søgende. Der skete meget undervejs, med overraskelser.

Med angivelse af det lærte, forfatterne blogger:"Vi har observeret agenter, der opdager gradvist mere kompleks værktøjsbrug, mens de spiller et simpelt spil gemmeleg, "hvor agenterne byggede" en række på seks forskellige strategier og modstrategier, nogle af dem vidste vi ikke, at vores miljø understøttede. "

I et nyt papir udgivet tidligere på ugen, holdet afslørede resultater. Deres papir, "Emergent Tool Use fra Multi-Agent Autocurricula, "havde syv forfattere, seks af dem havde OpenAI -repræsentation angivet, og en, Google Brain.

Forfatterne kommenterede, hvilken slags udfordring de tog imod. "Oprettelse af intelligente kunstige agenter, der kan løse en lang række komplekse menneskerelevante opgaver, har været en mangeårig udfordring i kunstig intelligens-samfundet."

Teamet sagde, at "vi finder ud af, at agenter opretter et selvovervåget autokurriculum, der fremkalder flere forskellige runder med fremvoksende strategi, mange af dem kræver sofistikeret værktøjsbrug og koordinering. "

Gennem gemmeleg, (1) Søgende lærte at jagte skjulere og skjulere lærte at løbe væk (2) Skjulte lærte grundlæggende værktøjsbrug - kasser og vægge til at bygge forter. (3) Søgende lærte at bruge ramper til at hoppe i skjulerums husly (4) Skjulere lærte at flytte ramper til langt fra, hvor de vil bygge deres fort, og lås dem på plads (5) Søgende lærte, at de kan hoppe fra låste ramper til kasser og surfe i kassen til skjulernes husly og (6) Skjulte lærte at låse de ubrugte kasser, inden de byggede deres fort.

Disse seks strategier opstod som agenter, der blev trænet mod hinanden i gemmeleg-hver ny strategi skabte et tidligere ikke-eksisterende pres for agenter til at gå videre til den næste fase, uden direkte incitamenter for agenter til at interagere med objekter eller til at udforske. Strategierne var et resultat af "autocurriculum" fremkaldt af multi-agent konkurrence og dynamik i gemmeleg.

Forfatterne i bloggen sagde, at de lærte "det er ret ofte, at agenter finder en måde at udnytte det miljø, du bygger eller fysikmotoren på en utilsigtet måde."

Det, der skete, var en "selvovervåget, fremvoksende kompleksitet." Og dette "tyder yderligere på, at multi-agent co-adaptation en dag kan producere ekstremt kompleks og intelligent adfærd." Forfatterne erklærede på samme måde i deres papir, at "inducering af autokurrikulaer i fysisk forankrede og åbne miljøer i sidste ende kunne gøre det muligt for agenter at erhverve et ubegrænset antal menneskerelevante færdigheder."

Douglas Heaven, Ny forsker , virkelig vakt læsernes interesse for den måde, han beskrev, hvad der skete:

"Først, skjulerne løb simpelthen væk. Men, de fandt hurtigt ud af, at den hurtigste måde at stumpe søgerne på var at finde genstande i miljøet for at skjule sig selv for synet, bruge dem som et slags værktøj. For eksempel, de lærte, at kasser kunne bruges til at blokere døråbninger og bygge enkle skjulesteder. Søgerne lærte, at de kunne flytte en rampe rundt og bruge den til at klatre over vægge. Robotterne opdagede derefter, at det at være en holdspiller-at overføre objekter til hinanden eller samarbejde om et gemmested-var den hurtigste måde at vinde på. "

Dette var et ambitiøst projekt. Undersøger deres arbejde, MIT Technology Review bemærkede, at AI lærte at bruge værktøjer efter næsten 500 millioner spil gemmeleg. Gennem at lege gemmeleg hundredvis af millioner af runder, to modsatrettede teams af AI -agenter udviklede komplekse skjul og søg strategier.

Karen Hao præsenterede en interessant markør for, hvad agenterne lærte efter hvor mange runder:"... omkring 25-million-spil-mærket, leg blev mere sofistikeret. Skjulerne lærte at bevæge sig og låse kasser og barrikader i miljøet for at bygge forter omkring sig selv, så søgerne aldrig ville se dem. "

Flere millioner runder:søgende opdagede en modstrategi, da de lærte at flytte en rampe ved siden af skjulernes fort og bruge den til at klatre over væggene. Flere runder senere, skjulerne lærte at låse ramperne på plads, inden de byggede deres fort.

Endnu dukkede flere strategier op ved 380 millioner spil. der opstod yderligere to strategier. Søgerne udviklede en strategi for at bryde ind i skjulernes fort ved at bruge en låst rampe til at klatre op på en ulåst kasse, derefter "surfe" deres vej oven på boksen til fortet og over dets mure. I den sidste fase, skjulerne lærte igen at låse alle ramper og kasser på plads, inden de byggede deres fort.

Hao citerede Bowen Baker, en af forfatterne til papiret. "Vi fortalte ikke skjulerne eller de, der søgte, at løbe i nærheden af en kasse eller interagere med den ... Men gennem multiagent -konkurrence, de skabte nye opgaver for hinanden, så det andet hold måtte tilpasse sig. "

Tænk over det. Baker sagde, at de ikke fortalte skjulerne, og de fortalte det ikke til de, der søgte, at løbe i nærheden af kasser eller interagere med dem.

Devin Coldewey i TechCrunch tænkte over det. "Undersøgelsen havde til formål, og med succes undersøgte muligheden for, at maskinlæringsagenter lærer sofistikeret, virkeligt relevante teknikker uden indblanding af forslag fra forskerne. "

Coldewey fastslog take-home for alt dette arbejde. "Som forfatterne til papiret forklarer, det er sådan vi kom til. "

Vi, som hos mennesker. Coldewey citerede en passage fra deres papir.

"Den enorme mængde kompleksitet og mangfoldighed på Jorden udviklede sig på grund af co-evolution og konkurrence mellem organismer, styret af naturligt udvalg. Når en ny vellykket strategi eller mutation dukker op, det ændrer den implicitte opgavefordeling, naboer skal løse og skaber et nyt pres for tilpasning. Disse evolutionære våbenløb skaber implicitte autokurrikler, hvor konkurrerende agenter løbende skaber nye opgaver for hinanden. "

© 2019 Science X Network

Varme artikler

Varme artikler

-

To NE træarter kan bruges i nyt bæredygtigt byggematerialePaneler af CLT blev placeret i en styrke-testmaskine på UMass Wood Mechanics Lab, hvor en kæmpe stålarm lagde tusinder af pund pres på det konstruerede træ, indtil det gik i stykker. Kredit:Peggi Clou

To NE træarter kan bruges i nyt bæredygtigt byggematerialePaneler af CLT blev placeret i en styrke-testmaskine på UMass Wood Mechanics Lab, hvor en kæmpe stålarm lagde tusinder af pund pres på det konstruerede træ, indtil det gik i stykker. Kredit:Peggi Clou -

Bilsalget i Storbritannien er steget efter årelange fald:industriTo britiske byggede biler, en Bentley Flying Spur og en Range Rover, afbilledet i London i 2015 Storbritanniens salg af nye biler steg en smule i april, industridata viste fredag, et år tidligere

Bilsalget i Storbritannien er steget efter årelange fald:industriTo britiske byggede biler, en Bentley Flying Spur og en Range Rover, afbilledet i London i 2015 Storbritanniens salg af nye biler steg en smule i april, industridata viste fredag, et år tidligere -

Engineers Smart Speaker Firewall isolerer Alexa-enheder på et øjeblikKredit:CC0 Public Domain Chuck Carey er en erfaren ingeniør og selvskreven teknofil, men han er også på vagt over for spredningen af data-hoovering, Internetforbundne enheder såsom mikrofon- og

Engineers Smart Speaker Firewall isolerer Alexa-enheder på et øjeblikKredit:CC0 Public Domain Chuck Carey er en erfaren ingeniør og selvskreven teknofil, men han er også på vagt over for spredningen af data-hoovering, Internetforbundne enheder såsom mikrofon- og -

Apple opgraderer Amazon med at vælge nye tech hub -placeringerDeirdre OBrien, Apples vicepræsident for mennesker, taler under en begivenhed om Apples nye campusmeddelelse i Austin, Texas, Torsdag, Dec, 13, 2018. Apple planlægger at bygge et campus på 1 milliard

Apple opgraderer Amazon med at vælge nye tech hub -placeringerDeirdre OBrien, Apples vicepræsident for mennesker, taler under en begivenhed om Apples nye campusmeddelelse i Austin, Texas, Torsdag, Dec, 13, 2018. Apple planlægger at bygge et campus på 1 milliard

- En gylden kugle til kræft:Nanopartikler giver en målrettet version af fototermisk behandling mod k…

- Plastmarkederne tilpasser sig i en alder af COVID-19

- 5 Fremtidens grønne byer

- Underoptælling af agroskovbrug skævvrider planlægning og rapportering om afbødning af klimaændr…

- Nanopartikler forbliver uforudsigelige

- At se skoven for træerne:Hvad en eg fortæller os om klimaændringer