Nyt værktøj fremhæver, hvad generative modeller udelader, når de rekonstruerer en scene

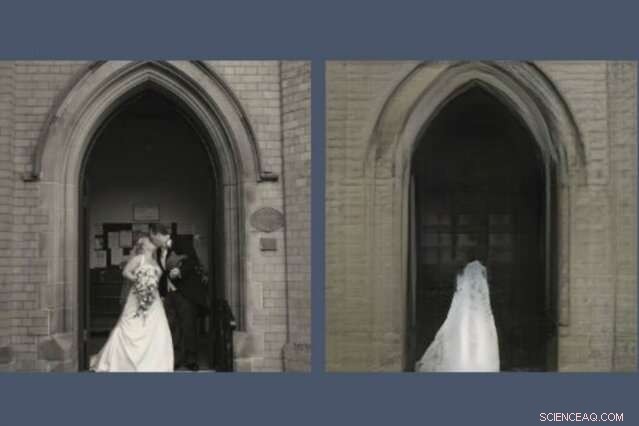

Et nyt værktøj afslører, hvad AI-modeller udelader ved at genskabe en scene. Her, en GAN, eller generativt modstridende netværk, har droppet parret af nygifte fra dets rekonstruktion (til højre) af det foto, det blev bedt om at tegne (til venstre). Kredit:Massachusetts Institute of Technology

Enhver, der har brugt tid på sociale medier, har sikkert bemærket, at GAN'er, eller generative kontradiktoriske netværk, er blevet bemærkelsesværdigt gode til at tegne ansigter. De kan forudsige, hvordan du vil se ud, når du er gammel, og hvordan du vil se ud som berømthed. Men bed en GAN om at tegne scener fra den større verden, og tingene bliver mærkelige.

En ny demo fra MIT-IBM Watson AI Lab afslører, hvad en model trænet på scener med kirker og monumenter beslutter sig for at udelade, når den tegner sin egen version af, sige, Pantheon i Paris, eller Piazza di Spagna i Rom. Det større studie, At se, hvad en GAN ikke kan generere, blev præsenteret på den internationale konference om computersyn i sidste uge.

"Forskere fokuserer typisk på at karakterisere og forbedre, hvad et maskinlæringssystem kan gøre - hvad det er opmærksom på, og hvordan bestemte input fører til bestemte output, " siger David Bau, en kandidatstuderende ved MIT's Department of Electrical Engineering and Computer Science and Computer Science and Artificial Science Laboratory (CSAIL). "Med dette arbejde, Vi håber, at forskere vil være så meget opmærksomme på at karakterisere de data, som disse systemer ignorerer."

I en GAN, et par neurale netværk arbejder sammen om at skabe hyperrealistiske billeder mønstret efter eksempler, de har fået. Bau blev interesseret i GAN'er som en måde at kigge ind i black-box neurale net for at forstå begrundelsen bag deres beslutninger. Et tidligere værktøj udviklet sammen med hans rådgiver, MIT professor Antonio Torralba, og IBM-forsker Hendrik Strobelt, gjort det muligt at identificere klynger af kunstige neuroner, der er ansvarlige for at organisere billedet i virkelige kategorier som døre, træer, og skyer. Et relateret værktøj, GANPaint, lader amatørkunstnere tilføje og fjerne disse funktioner fra deres egne fotos.

En dag, mens han hjælper en kunstner med at bruge GANPaint, Bau ramte på et problem. "Som sædvanligt, vi jagtede tallene, forsøger at optimere numerisk rekonstruktionstab for at rekonstruere billedet, " siger han. "Men min rådgiver har altid opfordret os til at se ud over tallene og granske de faktiske billeder. Da vi kiggede, Fænomenet sprang lige ud:Folk blev selektivt droppet ud."

Ligesom GAN'er og andre neurale net finder mønstre i dynger af data, de ignorerer mønstre, også. Bau og hans kolleger trænede forskellige typer GAN'er på indendørs og udendørs scener. Men uanset hvor billederne er taget, GAN'erne udelod konsekvent vigtige detaljer som mennesker, biler, tegn, springvand, og møbler, selv når disse objekter var fremtrædende i billedet. I én GAN-rekonstruktion, et par nygifte, der kysser på trappen til en kirke, spøges ud, efterlader en uhyggelig brudekjole-tekstur på katedraldøren.

"Når GAN'er støder på objekter, de ikke kan generere, de ser ud til at forestille sig, hvordan scenen ville se ud uden dem, " siger Strobelt. "Nogle gange bliver folk til buske eller forsvinder helt ind i bygningen bag dem."

Forskerne formoder, at maskinel dovenskab kan være skylden; selvom en GAN er trænet til at skabe overbevisende billeder, det kan lære, at det er lettere at fokusere på bygninger og landskaber og springe over sværere at repræsentere mennesker og biler. Forskere har længe vidst, at GAN'er har en tendens til at overse nogle statistisk meningsfulde detaljer. Men dette kan være den første undersøgelse, der viser, at state-of-the-art GAN'er systematisk kan udelade hele klasser af objekter i et billede.

En AI, der taber nogle objekter fra sine repræsentationer, kan nå sine numeriske mål, mens den savner de detaljer, der er vigtigst for os mennesker, siger Bau. Efterhånden som ingeniører henvender sig til GAN'er for at generere syntetiske billeder for at træne automatiserede systemer som selvkørende biler, der er fare for, at mennesker, tegn, og anden kritisk information kunne droppes, uden at mennesker opdagede det. Det viser, hvorfor modellens ydeevne ikke bør måles ved nøjagtighed alene, siger Bau. "Vi er nødt til at forstå, hvad netværkene er og ikke gør for at sikre, at de træffer de valg, vi ønsker, at de skal træffe."

Denne historie er genudgivet med tilladelse fra MIT News (web.mit.edu/newsoffice/), et populært websted, der dækker nyheder om MIT-forskning, innovation og undervisning.

Varme artikler

Varme artikler

-

Flyvende fiskerobot kan drive sig selv op af vandet og glide gennem luftenIllustration af robotten, der springer op af vandet. Kredit:Aerial Robotics Lab/Imperial College London En bio-inspireret bot bruger vand fra miljøet til at skabe en gas og lancere sig selv fra va

Flyvende fiskerobot kan drive sig selv op af vandet og glide gennem luftenIllustration af robotten, der springer op af vandet. Kredit:Aerial Robotics Lab/Imperial College London En bio-inspireret bot bruger vand fra miljøet til at skabe en gas og lancere sig selv fra va -

Macron siger, at teknologigiganter nyder permanent status som skattelyTrump og Macron har stødt sammen om Paris skatteplan for digitale giganter med den amerikanske præsident, der fordømmer sin franske modparts tåbelighed Frankrigs præsident Emmanuel Macron, hvem vi

Macron siger, at teknologigiganter nyder permanent status som skattelyTrump og Macron har stødt sammen om Paris skatteplan for digitale giganter med den amerikanske præsident, der fordømmer sin franske modparts tåbelighed Frankrigs præsident Emmanuel Macron, hvem vi -

Hvorfor er der ikke elektriske fly endnu?At bygge et elektrisk fly er meget anderledes end at bygge en elbil eller lastbil. Kredit:Venkat Viswanathan, CC BY-ND Efterhånden som elbiler og lastbiler dukker op på de amerikanske motorveje, d

Hvorfor er der ikke elektriske fly endnu?At bygge et elektrisk fly er meget anderledes end at bygge en elbil eller lastbil. Kredit:Venkat Viswanathan, CC BY-ND Efterhånden som elbiler og lastbiler dukker op på de amerikanske motorveje, d -

News Corp viser overskud for tredje kvartalNews Corp fik et nettooverskud på 23 millioner dollars i tredje kvartal sammenlignet med et usædvanligt tab på mere end 1 milliard dollar sidste år Rupert Murdochs massemedier og forlagsselskab Ne

News Corp viser overskud for tredje kvartalNews Corp fik et nettooverskud på 23 millioner dollars i tredje kvartal sammenlignet med et usædvanligt tab på mere end 1 milliard dollar sidste år Rupert Murdochs massemedier og forlagsselskab Ne

- Nye matematiske løsninger på et gammelt problem inden for astronomi

- Grafenkomposit kan holde vingerne isfri

- Ethereum reagerer på formørkelsesangreb beskrevet af forskningstrioen

- Amerikas dæmningskrise - var Oroville bare en dråbe i spanden?

- Forskere finder spor til, hvordan farlig rumstråling begynder

- Et vindue til fældefri ladningstransport i organiske halvledere