Online hadefulde ytringer kan være indeholdt som en computervirus, siger forskere

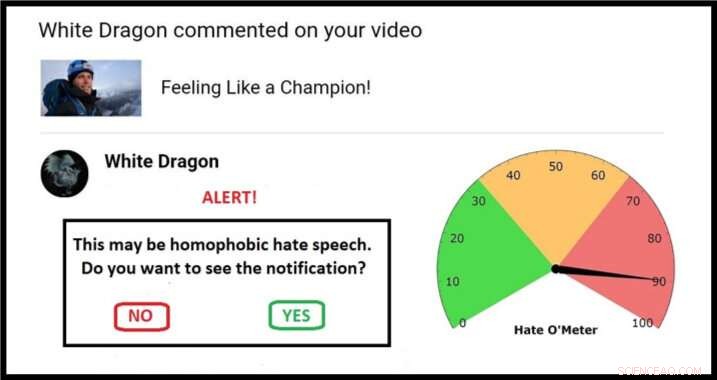

Eksempel på en mulig tilgang til en karantæneskærm, komplet med Hate O'Meter. Kredit:Stefanie Ullman

Spredningen af hadefulde ytringer via sociale medier kunne tackles ved hjælp af den samme "karantæne"-tilgang, der er indsat til at bekæmpe ondsindet software, ifølge forskere fra University of Cambridge.

Definitioner af hadefulde ytringer varierer afhængigt af nation, lov og platform, og bare blokering af søgeord er ineffektivt:grafiske beskrivelser af vold behøver ikke indeholde åbenlyse etniske bagtalelser for at udgøre racistiske dødstrusler, for eksempel.

Som sådan, hadefulde ytringer er svære at opdage automatisk. Det skal rapporteres af dem, der er udsat for det, efter at den tilsigtede "psykologiske skade" er påført, med hære af moderatorer, der kræves til at bedømme enhver sag.

Dette er den nye frontlinje i en gammel debat:ytringsfrihed versus giftigt sprog.

Nu, en ingeniør og en lingvist har offentliggjort et forslag i tidsskriftet Etik og informationsteknologi der udnytter cybersikkerhedsteknikker til at give kontrol til de målrettede, uden at ty til censur.

Cambridge sprog- og maskinlæringseksperter bruger databaser med trusler og voldelige fornærmelser til at bygge algoritmer, der kan give en score for sandsynligheden for en onlinemeddelelse, der indeholder former for hadefuld tale.

Efterhånden som disse algoritmer bliver forfinet, potentielle hadefulde ytringer kunne identificeres og "sættes i karantæne". Brugere ville modtage en advarsel med et "Hate O'Meter" - score for hadtale - afsenderens navn, og en mulighed for at se indholdet eller slette uset.

Denne tilgang er beslægtet med spam- og malwarefiltre, og forskere fra 'Giving Voice to Digital Democracies'-projektet mener, at det dramatisk kan reducere mængden af hadefulde ytringer, som folk tvinges til at opleve. De sigter efter at have en prototype klar i begyndelsen af 2020.

"Hadefulde ytringer er en form for forsætlig onlineskade, som malware, og kan derfor håndteres ved hjælp af karantæne, " sagde medforfatter og sprogforsker Dr. Stefanie Ullman. "Faktisk, en masse hadefulde ytringer genereres faktisk af software såsom Twitter-bots."

"Virksomheder som Facebook, Twitter og Google reagerer generelt reaktivt på hadefulde ytringer, " sagde medforfatter og ingeniør Dr. Marcus Tomalin. "Dette kan være okay for dem, der ikke støder på det ofte. For andre er det for lidt, for sent."

"Mange kvinder og personer fra minoritetsgrupper i offentligheden modtager anonyme hadefulde ytringer for at turde have en online tilstedeværelse. Vi ser, at dette afskrækker folk fra at gå ind i eller fortsætte i det offentlige liv, ofte dem fra grupper, der har brug for større repræsentation, " han sagde.

Den tidligere amerikanske udenrigsminister Hillary Clinton fortalte for nylig et britisk publikum, at hadefuld tale udgjorde en "trussel mod demokratier", i kølvandet på, at mange kvindelige parlamentsmedlemmer citerer onlinemisbrug som en del af grunden til, at de ikke længere vil stille op til valg.

I en adresse på Georgetown University, Facebooks administrerende direktør Mark Zuckerberg talte om "brede uenigheder om, hvad der kvalificeres som had" og argumenterede:"vi bør tage fejl på siden af større udtryk".

Forskerne siger, at deres forslag ikke er en magisk kugle, men det sidder mellem de "ekstreme libertariske og autoritære tilgange" om enten helt at tillade eller forbyde bestemt sprog online.

Vigtigere, brugeren bliver dommeren. "Mange mennesker kan ikke lide tanken om, at et ikke-valgt selskab eller en mikrostyrende regering beslutter, hvad vi må og ikke må sige til hinanden, " sagde Tomalin.

"Vores system markerer, når du skal være forsigtig, men det er altid dit opkald. Det forhindrer ikke folk i at poste eller se, hvad de kan lide, men det giver tiltrængt kontrol til dem, der bliver oversvømmet af had. "

I avisen, forskerne henviser til detektionsalgoritmer, der opnår 60% nøjagtighed - ikke meget bedre end tilfældigheder. Tomalins maskinlæringslaboratorium har nu fået dette op til 80 %, og han forventer fortsat forbedring af den matematiske modellering.

I mellemtiden, Ullman samler flere "træningsdata":verificerede hadefulde ytringer, som algoritmerne kan lære af. Dette hjælper med at forfine "tillidsscorerne", der bestemmer en karantæne og efterfølgende Hate O'Meter-udlæsning, som kunne indstilles som en følsomhedsskive afhængigt af brugerens præference.

Et grundlæggende eksempel kan involvere et ord som 'tæve':en kvindefjendsk sladder, men også et legitimt begreb i sammenhænge som hundeavl. Det er den algoritmiske analyse af, hvor sådan et ord sidder syntaktisk – typerne af omgivende ord og semantiske relationer mellem dem – der informerer om hadefulde tale.

"Det er ikke nok at identificere individuelle søgeord, vi ser på hele sætningsstrukturer og langt videre. Sociolingvistisk information i brugerprofiler og opslagshistorier kan alle hjælpe med at forbedre klassificeringsprocessen, sagde Ullman.

Tilføjet Tomalin:"Gennem automatiserede karantæner, der giver vejledning om styrken af hadefuldt indhold, vi kan styrke dem, der er modtagende for den hadefulde tale, der forgifter vores online-diskurser."

Imidlertid, forskerne, som arbejder i Cambridges Center for Forskning i Kunst, Humaniora og samfundsvidenskab (CRASSH), sige, at der – som med computervirus – altid vil være et våbenkapløb mellem hadefulde ytringer og systemer til at begrænse det.

Projektet er også begyndt at se på "modtale":måden folk reagerer på hadefulde ytringer. Forskerne agter at indgå i debatter om, hvordan virtuelle assistenter som 'Siri' skal reagere på trusler og intimidering.

Varme artikler

Varme artikler

-

Fylder lithium-ion-celler hurtigereBatteriproducenter venter ofte flere timer for at sikre, at væsken absorberes fuldt ud i porerne i elektrodestakken. I lyset af neutronstrålen så forskere ved Münchens Tekniske Universitet, at elektro

Fylder lithium-ion-celler hurtigereBatteriproducenter venter ofte flere timer for at sikre, at væsken absorberes fuldt ud i porerne i elektrodestakken. I lyset af neutronstrålen så forskere ved Münchens Tekniske Universitet, at elektro -

Følelsesgenkendelse baseret på paralingvistisk informationEksempler på spektrogrammer fra hver af de 4 inkluderede klasser. Kredit:Papakostas et al. Forskere ved University of Texas i Arlington har for nylig udforsket brugen af maskinlæring til følelse

Følelsesgenkendelse baseret på paralingvistisk informationEksempler på spektrogrammer fra hver af de 4 inkluderede klasser. Kredit:Papakostas et al. Forskere ved University of Texas i Arlington har for nylig udforsket brugen af maskinlæring til følelse -

S. Koreas politi razziaer BMW-kontoret på grund af bilbrandeSydkorea har i denne måned midlertidigt forbudt BMW-biler, der endnu ikke havde bestået sikkerhedstjek, fra gaden Sydkoreansk politi raidede torsdag den tyske bilproducent BMWs hovedkvarter i Seou

S. Koreas politi razziaer BMW-kontoret på grund af bilbrandeSydkorea har i denne måned midlertidigt forbudt BMW-biler, der endnu ikke havde bestået sikkerhedstjek, fra gaden Sydkoreansk politi raidede torsdag den tyske bilproducent BMWs hovedkvarter i Seou -

Mistænkt for et stort brud på Capital One søger løsladelse fra fængsletI denne 16. juli, 2019, fil foto, en mand går på tværs af gaden fra et Capital One-sted i San Francisco. Føderale anklagere siger Paige Thompson, kvinden anklaget for at have hacket Capital One og min

Mistænkt for et stort brud på Capital One søger løsladelse fra fængsletI denne 16. juli, 2019, fil foto, en mand går på tværs af gaden fra et Capital One-sted i San Francisco. Føderale anklagere siger Paige Thompson, kvinden anklaget for at have hacket Capital One og min

- Falcons egenskaber

- Forskere er nu i stand til at kortlægge defekter i 2D-krystaller i væske

- Sydkorea tester levering af droner i fjerntliggende regioner

- Fleksibel, stabil og potent mod kræft - ny tilgang til tumorbehandling

- Vera Rubin, som udførte banebrydende arbejde med mørkt stof, dør

- Copernicus Sentinel kortlægger oversvømmelse af orkanen Firenze