AI kan nu læse følelser - men skal det?

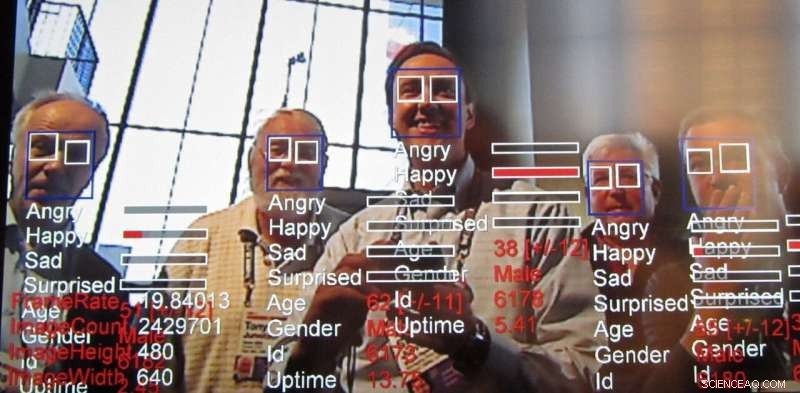

Følelsesgenkendelsesteknologi, en udvækst af ansigtsgenkendelsesteknologi, fortsætter hurtigt med at komme videre. Kredit:Steve Jurvetson/flickr, CC BY-SA

I sin årsrapport AI Now Institute, et tværfagligt forskningscenter, der studerer de samfundsmæssige konsekvenser af kunstig intelligens, opfordrede til et forbud mod teknologi designet til at genkende folks følelser i visse tilfælde. Specifikt, forskerne sagde, at påvirkningsteknologi, også kaldet følelsesgenkendelsesteknologi, bør ikke bruges i beslutninger, der "påvirker menneskers liv og adgang til muligheder, "såsom ansættelsesbeslutninger eller smertevurderinger, fordi det ikke er tilstrækkeligt præcist og kan føre til forudindtagede beslutninger.

Hvad er denne teknologi, som allerede bruges og markedsføres, og hvorfor vækker det bekymring?

Udvækst af ansigtsgenkendelse

Forskere har aktivt arbejdet med computersynsalgoritmer, der kan bestemme menneskers følelser og hensigt, sammen med andre konklusioner, i mindst et årti. Ansigtsudtryksanalyse har eksisteret siden mindst 2003. Computere har været i stand til at forstå følelser endnu længere. Denne nyeste teknologi er afhængig af de datacentriske teknikker kendt som "machine learning, "algoritmer, der behandler data for at" lære ", hvordan man træffer beslutninger, for at opnå endnu mere præcis affektgenkendelse.

Udfordringen ved at læse følelser

Forskere søger altid at gøre nye ting ved at bygge videre på det, der er gjort før. Følelsesgenkendelse er lokkende, fordi, på en eller anden måde, vi som mennesker kan opnå dette relativt godt allerede fra en tidlig alder, og alligevel kapabel til at replikere, at menneskelig dygtighed ved hjælp af computersyn stadig er udfordrende. Selvom det er muligt at gøre nogle ret bemærkelsesværdige ting med billeder, såsom at stilisere et foto for at få det til at se ud som om det var tegnet af en berømt kunstner og endda skabe fotorealistiske ansigter-for ikke at nævne at skabe såkaldte deepfakes-evnen til at udlede egenskaber som menneskelige følelser fra et ægte billede har altid været interessant for forskere.

Følelser er vanskelige, fordi de har en tendens til at afhænge af kontekst. For eksempel, Når nogen koncentrerer sig om noget, ser det ud til, at de simpelthen tænker. Ansigtsgenkendelse er kommet langt med maskinlæring, men identifikation af en persons følelsesmæssige tilstand udelukkende baseret på at se på en persons ansigt mangler centrale oplysninger. Følelser udtrykkes ikke kun gennem en persons udtryk, men også hvor de er, og hvad de laver. Disse kontekstuelle tegn er vanskelige at indføre i selv moderne maskinindlæringsalgoritmer. For at løse dette, der er en aktiv indsats for at udvide kunstig intelligens teknikker til at overveje kontekst, ikke kun for følelsesgenkendelse, men alle former for applikationer.

Læse medarbejdernes følelser

Rapporten udgivet af AI Now belyser nogle måder, hvorpå AI anvendes på arbejdsstyrken for at vurdere medarbejdernes produktivitet og endda så tidligt som i interviewfasen. Analyse af optagelser fra interviews, især for fjerntliggende jobsøgende, er allerede i gang. Hvis ledere kan få en fornemmelse af deres underordnede følelser fra interview til evaluering, beslutningstagning vedrørende andre beskæftigelsesforhold, såsom rejser, kampagner eller opgaver kan ende med at blive påvirket af disse oplysninger. Men der er mange andre måder, hvorpå denne teknologi kan bruges.

Hvorfor bekymringen

Disse typer systemer har næsten altid retfærdighed, ansvarlighed, gennemsigtighed og etiske ("FATE") skavanker bagt i deres mønstermatchning. For eksempel, en undersøgelse fandt ud af, at ansigtsgenkendelsesalgoritmer vurderede ansigter hos sorte mennesker som mere vrede end hvide ansigter, selv når de smilede.

Mange forskergrupper tackler dette problem, men det ser klart ud til på dette tidspunkt, at problemet ikke udelukkende kan løses på det teknologiske niveau. Spørgsmål vedrørende FATE i AI vil kræve en fortsat og samordnet indsats fra dem, der bruger teknologien, for at være opmærksom på disse spørgsmål og løse dem. Som AI Now -rapporten fremhæver:"På trods af stigningen i AI -etisk indhold ... fokuserer etiske principper og udsagn sjældent på, hvordan AI -etik kan implementeres, og om de er effektive." Det bemærker, at sådanne AI -etiske udsagn stort set ignorerer spørgsmål om, hvordan, hvor, og hvem vil sætte sådanne retningslinjer i drift. I virkeligheden, det er sandsynligt, at alle skal være opmærksomme på de typer af fordomme og svagheder, disse systemer præsenterer, ligner, hvordan vi skal være bevidste om vores egne og andres.

Problemet med tæppe teknologi forbud

Større nøjagtighed og lethed ved vedvarende overvågning bringer andre bekymringer ud over etik. Der er også en lang række generelle teknologirelaterede bekymringer vedrørende fortrolighed, spænder fra spredning af kameraer, der fungerer som politifoder til potentielt at gøre følsomme data anonyme.

Med disse etiske og privatlivsproblemer, en naturlig reaktion kan være at opfordre til et forbud mod disse teknikker. Sikkert, at anvende AI på jobinterviewsresultater eller strafferetlige strafudmålingsprocedurer virker farligt, hvis systemerne lærer bias eller på anden måde er upålidelige. Der er dog nyttige applikationer, for eksempel ved at hjælpe med at få øje på advarselsskilte for at forhindre ungdomsmord og opdage spritbilister. Det er en af grundene til, at selv bekymrede forskere, tilsynsmyndigheder og borgere har generelt stoppet med at opfordre til generelle forbud mod AI-relaterede teknologier.

Kombination af AI og menneskelig dømmekraft

Ultimativt, teknologidesignere og samfundet som helhed skal se nøje på, hvordan information fra AI-systemer injiceres i beslutningsprocesser. Disse systemer kan give forkerte resultater ligesom enhver anden form for intelligens. De er også notorisk dårlige til at vurdere deres egen tillid, ikke ulig mennesker, selv i enklere opgaver som evnen til at genkende objekter. Der er også fortsat betydelige tekniske udfordringer ved læsning af følelser, især at overveje kontekst for at udlede følelser.

Hvis folk er afhængige af et system, der ikke er præcist i at træffe beslutninger, brugerne af det system har det dårligere. Det er også velkendt, at mennesker har en tendens til at stole mere på disse systemer end andre autoritetsfigurer. I lyset af dette, vi som samfund er nødt til nøje at overveje disse systemers retfærdighed, ansvarlighed, gennemsigtighed og etik både under design og anvendelse, altid at beholde et menneske som den endelige beslutningstager.

Denne artikel er genudgivet fra The Conversation under en Creative Commons -licens. Læs den originale artikel.

Sidste artikelAI-drevet avatar på tech-show udråbt som kunstigt menneske

Næste artikelKan søstjernebevægelse inspirere til bedre robotter?

Varme artikler

Varme artikler

-

Emissionsfrit energisystem sparer varme fra sommersolen til vinterenEnergisystemet MEST fungerer på en cirkulær måde. Først, væsken fanger energi fra sollys, i en solfanger på taget af en bygning. Derefter opbevares det ved stuetemperatur, fører til minimalt energitab

Emissionsfrit energisystem sparer varme fra sommersolen til vinterenEnergisystemet MEST fungerer på en cirkulær måde. Først, væsken fanger energi fra sollys, i en solfanger på taget af en bygning. Derefter opbevares det ved stuetemperatur, fører til minimalt energitab -

det amerikanske finansministerium, flyselskaber indgår aftale om økonomisk støtteAmerikanske flyselskaber vil se den føderale regering blive en minoritetsaktionær i henhold til en aftale med finansministeriet, sagde en kilde tæt på forhandlingerne Den amerikanske finansministe

det amerikanske finansministerium, flyselskaber indgår aftale om økonomisk støtteAmerikanske flyselskaber vil se den føderale regering blive en minoritetsaktionær i henhold til en aftale med finansministeriet, sagde en kilde tæt på forhandlingerne Den amerikanske finansministe -

Hvordan man gør den frygtede opgave med dataindtastning mindre foragtetArbejdspladser kan holde sig til manuel dataindtastning, selv i den digitale teknologis tidsalder. Kredit:Shutterstock En nylig undersøgelse, der viser, at dataindtastning er en af de mest overf

Hvordan man gør den frygtede opgave med dataindtastning mindre foragtetArbejdspladser kan holde sig til manuel dataindtastning, selv i den digitale teknologis tidsalder. Kredit:Shutterstock En nylig undersøgelse, der viser, at dataindtastning er en af de mest overf -

Socialt assisterende robot hjælper børn med autisme med at læreI denne måned lange, hjemmestudie, børnedeltagere med ASD spillede matematikspil på en touchscreen-tablet, mens en socialt assisterende robot ved navn Kiwi brugte multimodale data til at give personli

Socialt assisterende robot hjælper børn med autisme med at læreI denne måned lange, hjemmestudie, børnedeltagere med ASD spillede matematikspil på en touchscreen-tablet, mens en socialt assisterende robot ved navn Kiwi brugte multimodale data til at give personli

- Video:Den eneste detox, du nogensinde får brug for

- Arktis grønnere, men det vil ikke redde os

- Hvorfor giver Pine Tree Sap?

- Mangfoldighed og immigration øger produktiviteten i mikrobielle samfund

- Olie og gas spildevand som støvundertrykkende mindre end ideelt

- Gamle komodo-dragelignende dyr havde hoveder proportionelt større end dinosaurer