Ny optik til ultrahurtige kameraer skaber nye billedmuligheder

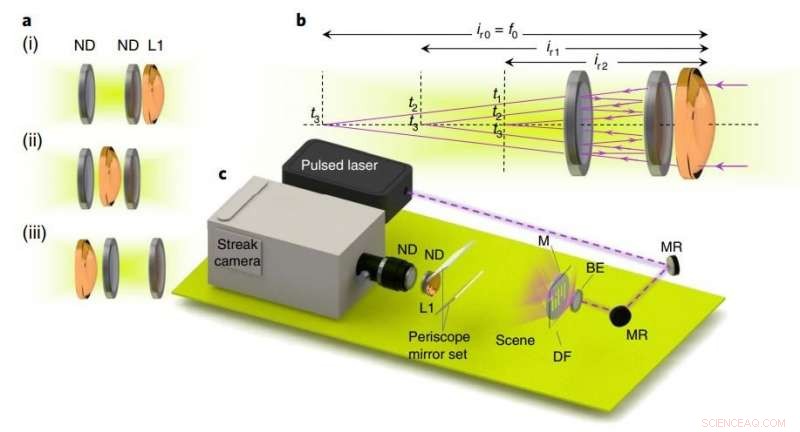

| Eksperimentel opsætning og tidsfoldet billedoversigt. Kredit: Natur fotonik (2018). DOI:10.1038/s41566-018-0234-0

MIT -forskere har udviklet ny fotografioptik, der fanger billeder baseret på tidspunktet for reflekterende lys inde i optikken, i stedet for den traditionelle tilgang, der er afhængig af arrangementet af optiske komponenter. Disse nye principper, siger forskerne, åbne døre til nye muligheder for tid- eller dybdefølsomme kameraer, som ikke er mulige med konventionel fotografioptik.

Specifikt, forskerne designede ny optik til en ultrahurtig sensor kaldet et streak -kamera, der løser billeder fra ultrakorte lysimpulser. Streak-kameraer og andre ultrahurtige kameraer er blevet brugt til at lave en billion-frame-per-second video, scanne gennem lukkede bøger, og give dybdekort over en 3D-scene, blandt andre applikationer. Sådanne kameraer har stolet på konventionel optik, som har forskellige designbegrænsninger. For eksempel, en linse med en given brændvidde, målt i millimeter eller centimeter, skal sidde i en afstand fra en billedsensor, der er lig med eller større end brændvidden for at tage et billede. Dette betyder dybest set, at linserne skal være meget lange.

I et papir offentliggjort i denne uges Natur fotonik , MIT Media Lab -forskere beskriver en teknik, der får et lyssignal til at reflektere frem og tilbage fra omhyggeligt placerede spejle inde i linsesystemet. En hurtig billedsensor tager et separat billede ved hver refleksionstid. Resultatet er en billedsekvens - der hver især svarer til et andet tidspunkt, og i en anden afstand fra linsen. Hvert billede kan tilgås på sit bestemte tidspunkt. Forskerne har opfundet denne teknik "tidsfoldet optik."

"Når du har et hurtigt sensorkamera, at løse lys, der passerer gennem optik, du kan bytte tid med plads, "siger Barmak Heshmat, første forfatter på papiret. "Det er kernebegrebet om tidsfoldning ... Du ser på optikken på det rigtige tidspunkt, og den tid er lig med at se på den i den rigtige afstand. Du kan derefter arrangere optik på nye måder, der har funktioner, der ikke var mulige før. "

I deres undersøgelse, forskerne demonstrerer tre anvendelser til tidsfoldet optik til ultrahurtige kameraer og andre dybdefølsomme billeddannelsesenheder. Disse kameraer, også kaldet "time-of-flight" kameraer, måle den tid, det tager for en lyspuls at reflektere fra en scene og vende tilbage til en sensor, at estimere dybden af 3D-scenen.

Den nye optikarkitektur indeholder et sæt semireflekterende parallelle spejle, der reducerer, eller "fold, "brændvidden, hver gang lyset reflekterer mellem spejlene. Ved at placere spejlesættet mellem linsen og sensoren, forskerne kondenserede afstanden til optikarrangementet med en størrelsesorden, mens de stadig tog et billede af scenen.

Medforfattere på papiret er Matthew Tancik, en kandidatstuderende i MIT datalogi og kunstig intelligenslaboratorium; Guy Satat, en ph.d. elev i Kamerakulturgruppen på Medielab; og Ramesh Raskar, en lektor i mediekunst og videnskab og direktør for Camera Culture Group.

Fold den optiske vej ind i tiden

Forskernes system består af en komponent, der projekterer et femtosekund (kvadrillionendedel af et) laserpuls ind i en scene for at belyse målobjekter. Traditionel fotografioptik ændrer formen på lyssignalet, når det bevæger sig gennem de buede briller. Denne formændring skaber et billede på sensoren.

Men, med forskernes optik, i stedet for at gå til sensoren, signalet hopper først frem og tilbage mellem spejle, der er præcist indrettet til at fange og reflektere lys. Hver af disse refleksioner kaldes en "rundtur". Ved hver rundtur, noget lys fanges af sensoren, der er programmeret til billedet med et bestemt tidsinterval - f.eks. et 1-nanosekund snapshot hvert 30. nanosekund.

En vigtig nyskabelse er, at hver rundtur i lys flytter fokuspunktet - hvor en sensor er placeret for at fange et billede - tættere på linsen. Dette gør det muligt at kondensere linsen drastisk. Sig et streak -kamera ønsker at tage et billede med den lange brændvidde på et traditionelt objektiv. Med tidsfoldet optik, den første rundtur trækker brændpunktet omkring det dobbelte af spejlsættet tættere på linsen, og hver efterfølgende rundtur bringer omdrejningspunktet stadig tættere og tættere på. Afhængigt af antallet af rundrejser, en sensor kan derefter placeres meget tæt på linsen.

Ved at placere sensoren på et præcist fokuspunkt, bestemt af samlede rundrejser, kameraet kan tage et skarpt slutbillede, samt forskellige stadier af lyssignalet, hver kodet på et andet tidspunkt, når signalet ændrer form for at producere billedet. (De første par skud vil være slørede, men efter flere rundrejser vil målobjektet komme i fokus.)

I deres papir, forskerne demonstrerer dette ved at afbilde en femtosekund lyspuls gennem en maske indgraveret med "MIT, "sæt 53 centimeter væk fra linsens blænde. For at tage billedet, det traditionelle 20-centimeter brændviddeobjektiv ville skulle sidde omkring 32 centimeter væk fra sensoren. Den tidsfoldede optik, imidlertid, trak billedet i fokus efter fem rundrejser, med kun en 3,1 centimeter linse-sensor afstand.

Dette kan være nyttigt, Heshmat siger, ved design af mere kompakte teleskoplinser, der fanger, sige, ultrahurtige signaler fra rummet, eller til at designe mindre og lettere linser til satellitter til at forestille sig overfladen af jorden.

Multizoom og flerfarvet

Forskerne afbildede derefter to mønstre med en afstand på omkring 50 centimeter fra hinanden, men hver inden for kameraets synsfelt. Et "X" -mønster var 55 centimeter fra linsen, og et "II" mønster var 4 centimeter fra linsen. Ved præcist at omarrangere optikken - dels ved at placere linsen mellem de to spejle - de formede lyset på en måde, så hver rundtur skabte en ny forstørrelse i en enkelt billedoptagelse. På den måde, det er som om kameraet zoomer ind med hver rundtur. Da de skød laseren ind i scenen, resultatet var to adskilte, fokuserede billeder, skabt i ét skud - X -mønsteret taget på den første rundtur, og II -mønsteret fanget på den anden rundtur.

Forskerne demonstrerede derefter et ultrahurtigt multispektralt (eller flerfarvet) kamera. De designet to farvereflekterende spejle og et bredbåndsspejl-et afstemt til at afspejle en farve, sættes tættere på linsen, og en indstillet til at afspejle en anden farve, sættes længere tilbage fra linsen. De afbildede en maske med et "A" og "B, "med A belyste den anden farve og B belyste den første farve, begge for et par tiendedele af et picosekund.

Når lyset vandrede ind i kameraet, bølgelængder af den første farve reflekteres straks frem og tilbage i det første hulrum, og klokken blev klokket af sensoren. Bølgelængder af den anden farve, imidlertid, passerede gennem det første hulrum, ind i det andet, forsinker lidt deres tid til sensoren. Fordi forskerne vidste, hvilken bølgelængde der ville ramme sensoren på hvilket tidspunkt, de lagde derefter de respektive farver på billedet - den første bølgelængde var den første farve, og den anden var den anden farve. Dette kan bruges i dybdefølende kameraer, som i øjeblikket kun optager infrarød, Siger Heshmat.

Et centralt element i papiret, Heshmat siger, åbner det døre for mange forskellige optiske designs ved at justere hulrumsafstanden, eller ved at bruge forskellige typer hulrum, sensorer, og linser. "Kernebudskabet er, at når du har et kamera, der er hurtigt, eller har en dybdesensor, du behøver ikke at designe optik, som du gjorde for gamle kameraer. Du kan gøre meget mere med optikken ved at se på dem på det rigtige tidspunkt, "Siger Heshmat.

Varme artikler

Varme artikler

-

Sådan beregnes belastningskraftIfølge Sir Isaac Newton er en enheds kraft lig med dens masse ganget med acceleration. Dette grundlæggende princip er det, der bruges til at beregne belastningskraft, som er den kraft, der er imod den

Sådan beregnes belastningskraftIfølge Sir Isaac Newton er en enheds kraft lig med dens masse ganget med acceleration. Dette grundlæggende princip er det, der bruges til at beregne belastningskraft, som er den kraft, der er imod den -

Ny forskning kan gøre dugdråber så små, de er usynligeI det væsentlige, når nanopillerne er høje og slanke, dråberne, der dannes inden i og på sprækkerne, kan springe af overfladen i en meget mindre størrelse, ned til to mikrometer. Ligeledes, korte og k

Ny forskning kan gøre dugdråber så små, de er usynligeI det væsentlige, når nanopillerne er høje og slanke, dråberne, der dannes inden i og på sprækkerne, kan springe af overfladen i en meget mindre størrelse, ned til to mikrometer. Ligeledes, korte og k -

Fysikere bruger terahertz -blinker til at afdække tilstanden, der er skjult af superledelseJigang Wang fra Iowa State og Ames Laboratory ledede eksperimenter, der aktiverede en skjult tilstand af stof i en superledende legering. Kredit:Christopher Gannon/Iowa State University Ved hjælp

Fysikere bruger terahertz -blinker til at afdække tilstanden, der er skjult af superledelseJigang Wang fra Iowa State og Ames Laboratory ledede eksperimenter, der aktiverede en skjult tilstand af stof i en superledende legering. Kredit:Christopher Gannon/Iowa State University Ved hjælp -

Linsetrick fordobler odds for kvanteinteraktionI det kobberomsluttede kammer i midten af dette setup ved Center for Quantum Technologies i Singapore, fotoner preller af et enkelt atom. Det er vigtigt at kontrollere sådanne interaktioner for kvan

Linsetrick fordobler odds for kvanteinteraktionI det kobberomsluttede kammer i midten af dette setup ved Center for Quantum Technologies i Singapore, fotoner preller af et enkelt atom. Det er vigtigt at kontrollere sådanne interaktioner for kvan

- Nanostruktur-oplysende dendritfri metalanode

- En polymer kærlighedshormonsensor til tidlig påvisning af autisme

- Forskere indsamler numeriske beviser for kvantekaos i Sachdev-Ye-Kitaev-modellen

- Anonym ikke mere:kombinere genetik med genealogi for at identificere de døde i umærkede grave

- Sådan konverteres pKa til Ka

- Spitzer studerer en stjernelegeplads med en lang historie