Forskning giver hastighedsboost til kvantecomputere

Et nyt fund fra forskere ved University of Chicago lover at forbedre hastigheden og pålideligheden af nuværende og næste generations kvantecomputere med så meget som ti gange. Ved at kombinere principper fra fysik og datalogi, forskerne udviklede en ny skalerbar compiler, der gør software opmærksom på den underliggende kvantehardware, tilbyder betydelige ydeevnefordele, efterhånden som videnskabsmænd kapløb om at bygge de første praktiske kvantecomputere.

UChicago-forskningsgruppen består af dataloger og fysikere fra EPiQC-samarbejdet (Enabling Practical-scale Quantum Computation), en NSF Expedition in Computing, der startede i 2018. EPiQC sigter mod at bygge bro mellem eksisterende teoretiske algoritmer til praktiske kvantecomputerarkitekturer på enheder på kort sigt.

Sammenlægning af tilgange fra datalogi og fysik

Kerneteknikken bag EPiQC-teamets papir tilpasser kvanteoptimal kontrol, en tilgang udviklet af fysikere længe før kvanteberegning var mulig. Kvanteoptimal kontrol finjusterer kvantesystemers kontrolknapper for kontinuerligt at drive partikler til ønskede kvantetilstande - eller i en computersammenhæng, implementere et ønsket program.

Hvis det lykkes at tilpasse, kvanteoptimal kontrol ville gøre det muligt for kvantecomputere at udføre programmer med den højest mulige effektivitet...men det kommer med en præstationsafvejning.

"Fysikere har faktisk brugt kvanteoptimal kontrol til at manipulere små systemer i mange år, men problemet er, at deres tilgang ikke skaleres, " sagde forsker Yunong Shi.

Selv med banebrydende hardware, det tager flere timer at køre kvanteoptimal kontrol målrettet til en maskine med kun 10 kvantebits (qubits). I øvrigt, denne køretid skalerer eksponentielt, hvilket gør kvanteoptimal kontrol uholdbar for de 20-100 qubit-maskiner, der forventes i det kommende år.

I mellemtiden dataloger har udviklet deres egne metoder til at kompilere kvanteprogrammer ned til kvantehardwarens kontrolknapper. Den computervidenskabelige tilgang har fordelen ved skalerbarhed - kompilatorer kan nemt kompilere programmer til maskiner med tusindvis af qubits. Imidlertid, disse compilere er stort set uvidende om den underliggende kvantehardware. Tit, der er et alvorligt misforhold mellem de kvanteoperationer, som softwaren håndterer, kontra dem, som hardwaren udfører. Som resultat, de kompilerede programmer er ineffektive.

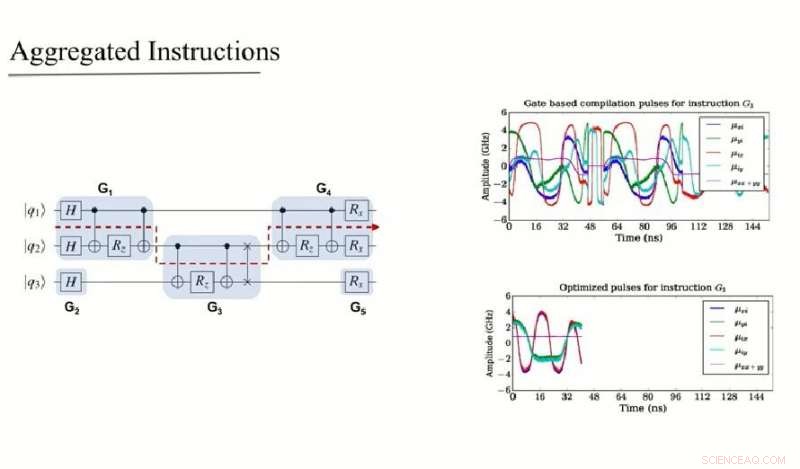

EPiQC-teamets arbejde kombinerer datalogi og fysik-tilgange ved intelligent at opdele store kvanteprogrammer i underprogrammer. Hvert underprogram er lille nok til at det kan håndteres af fysiktilgangen med kvanteoptimal kontrol, uden at løbe ind i præstationsproblemer. Denne tilgang realiserer både skalerbarheden på programniveau af traditionelle compilere fra computervidenskabsverdenen og effektivitetsgevinsterne på underprogramniveau ved kvanteoptimal kontrol.

Den intelligente generation af underprogrammer er drevet af en algoritme til at udnytte kommutativitet - et fænomen, hvor kvanteoperationer kan omarrangeres i en hvilken som helst rækkefølge. På tværs af en bred vifte af kvantealgoritmer, relevant både på kort og lang sigt, EPiQC-teamets compiler opnår to til ti gange udførelseshastigheder over basislinjen. Men på grund af qubits skrøbelighed, speedups i quantum program execution oversættes til eksponentielt højere succesrater for den ultimative beregning. Som Shi understreger, "på kvantecomputere, at fremskynde din henrettelsestid er gør-eller-dø."

Bryde abstraktionsbarrierer

Denne nye kompileringsteknik er en væsentlig afvigelse fra tidligere arbejde. "Tidligere compilere til kvanteprogrammer er blevet modelleret efter compilere til moderne konventionelle computere, " sagde Fred Chong, Seymour Goodman professor i datalogi ved UChicago og ledende PI for EPiQC. Men i modsætning til konventionelle computere, kvantecomputere er notorisk skrøbelige og støjende, så teknikker, der er optimeret til konventionelle computere, passer ikke godt til kvantecomputere. "Vores nye compiler er i modsætning til det tidligere sæt af klassisk inspirerede compilere, fordi den bryder abstraktionsbarrieren mellem kvantealgoritmer og kvantehardware, hvilket fører til større effektivitet på bekostning af at have en mere kompleks compiler."

Mens holdets forskning drejer sig om at gøre compilersoftwaren opmærksom på den underliggende hardware, det er agnostisk over for den specifikke type underliggende hardware. Dette er vigtigt, da der er flere forskellige typer kvantecomputere under udvikling, såsom dem med superledende qubits og fangede ion-qubits.

Teamet forventer at se eksperimentelle realiseringer af deres tilgang inden for de kommende måneder, især nu, hvor en åben industristandard, OpenPulse, er blevet defineret. Denne standard vil muliggøre drift af kvantecomputere på det lavest mulige niveau, efter behov for kvanteoptimale kontrolteknikker. IBMs kvantekøreplan fremhæver OpenPulse-support som et nøglemål for 2019, og andre virksomheder forventes også at annoncere lignende planer.

Holdets fulde papir, "Optimized Compilation of Aggregated Instructions for Realistic Quantum Computers" er nu offentliggjort på arXiv og vil blive præsenteret på ASPLOS computerarkitekturkonferencen i Rhode Island den 17. april. Udover Shi og Chong, medforfattere inkluderer Nelson Leung, Pranav Gokhale, Zane Rossi, David I. Schuster, og Henry Hoffman, alle på University of Chicago.

Varme artikler

Varme artikler

-

Optisk fingeraftryk kan afsløre forurenende stoffer i luftenMolekyler identificeres ved at aktivere mørke elektroniske tilstande i sensormaterialet, resulterer i en ny synlig top. Materialets ændrede optiske fingeraftryk beviser tilstedeværelsen af molekyler

Optisk fingeraftryk kan afsløre forurenende stoffer i luftenMolekyler identificeres ved at aktivere mørke elektroniske tilstande i sensormaterialet, resulterer i en ny synlig top. Materialets ændrede optiske fingeraftryk beviser tilstedeværelsen af molekyler -

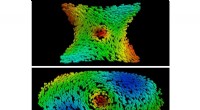

Manipulering af magnetiske teksturerDet øverste billede viser antivortex dannet i regionen med negativ krumning af torus. Den hvirvlende tekstur af en hvirvel kan ses i det nederste billede, som dannede sig langs regionen med positiv kr

Manipulering af magnetiske teksturerDet øverste billede viser antivortex dannet i regionen med negativ krumning af torus. Den hvirvlende tekstur af en hvirvel kan ses i det nederste billede, som dannede sig langs regionen med positiv kr -

At se skoven gennem træerne med et nyt LiDAR -systemSpecielt designet lasersystem og en ny metode baseret på lukket digital holografi gør LiDAR i stand til at gennemskue obskure elementer som løv og net. Kredit:US Naval Research Laboratory Kort tid

At se skoven gennem træerne med et nyt LiDAR -systemSpecielt designet lasersystem og en ny metode baseret på lukket digital holografi gør LiDAR i stand til at gennemskue obskure elementer som løv og net. Kredit:US Naval Research Laboratory Kort tid -

Lavinefotodiode slår ydeevnerekord for LiDAR -modtagereEpitaksialt tværsnit af lavinefotodiodens design. Dopingkoncentrationer er angivet i cm -3 Kredit:Joe C. Campbell El- og computeringeniører ved University of Virginia og University of Texas-Aust

Lavinefotodiode slår ydeevnerekord for LiDAR -modtagereEpitaksialt tværsnit af lavinefotodiodens design. Dopingkoncentrationer er angivet i cm -3 Kredit:Joe C. Campbell El- og computeringeniører ved University of Virginia og University of Texas-Aust

- Hvor meget ilt gør græs?

- Unikke nano-kapsler lover den målrettede lægemiddellevering

- Forskere beskriver reaktionsforløbet i to-lags tynde metalfilm

- Ville du stole på, at en robot passer på dit barn?

- Mutant protein kaster lys over viral formering

- Sikkerhedshuller identificeret i internetprotokol IPsec