Etalumis vender simuleringer om for at afsløre ny videnskab

Etalumis udfører Bayesiansk inferens - en metode til statistisk inferens, hvor Bayes' teorem bruges til at opdatere sandsynligheden for en hypotese, efterhånden som mere bevis eller information bliver tilgængelig - i det væsentlige inverterer simulatoren for at forudsige inputparametre fra observationer. Dette billede giver et overblik over softwarerammerne. Kredit:Wahid Bhimji, Lawrence Berkeley National Laboratory

Forskere har bygget simuleringer for at hjælpe med at forklare adfærd i den virkelige verden, herunder modellering for sygdomsoverførsel og forebyggelse, autonome køretøjer, klimavidenskab, og i søgen efter universets grundlæggende hemmeligheder. Men hvordan man fortolker store mængder eksperimentelle data i form af disse detaljerede simuleringer, er fortsat en vigtig udfordring. Probabilistisk programmering tilbyder en løsning - i det væsentlige reverse engineering af simuleringen - men denne teknik har længe været begrænset på grund af behovet for at omskrive simuleringen i brugerdefinerede computersprog, plus den intense computerkraft, der kræves.

For at løse denne udfordring, et multinationalt samarbejde mellem forskere, der bruger computerressourcer ved Lawrence Berkeley National Laboratorys National Energy Research Scientific Computing Center (NERSC) har udviklet den første probabilistiske programmeringsramme, der er i stand til at styre eksisterende simulatorer og køre i stor skala på HPC-platforme. Systemet, kaldet Etalumis ("simulere" stavet baglæns), blev udviklet af en gruppe videnskabsmænd fra University of Oxford, University of British Columbia (UBC), Intel, New York University, CERN, og NERSC som en del af et Big Data Center-projekt.

Etalumis udfører Bayesiansk inferens - en metode til statistisk inferens, hvor Bayes' sætning bruges til at opdatere sandsynligheden for en hypotese, efterhånden som mere evidens eller information bliver tilgængelig - i det væsentlige inverterer simulatoren for at forudsige inputparametre fra observationer. Holdet indsatte Etalumis for første gang til Large Hadron Collider (LHC) ved CERN, at bringe et nyt niveau af fortolkning til dataanalyse fra LHC's højenergifysikdetektorer. Et papir baseret på Etalumis er blevet udvalgt som finalist for bedste papir på SC19. Forfatterne vil tale om Etalumis på SC19 på tirsdag, 19. november klokken 16.30.

Fra dage til minutter

Bayesiansk inferens bruges i stort set alle videnskabelige discipliner, ifølge Frank Wood, en Etalumis-samarbejdspartner, lektor i datalogi ved UBC, og en af pionererne inden for probabilistisk programmering.

"Jeg var især interesseret i at anvende Bayesiansk inferens på et ekstremt komplekst fysikproblem, og højenergifysikdetektorer føltes som den perfekte prøveplads for vores gruppes banebrydende forskning, " siger han. "Etalumis-projektet gav en unik mulighed for at kombinere et banebrydende neuralt netværk baseret på en 'inference compilation'-tilgang med en softwareramme (pyprob) for direkte at koble denne inferensmotor til eksisterende detaljerede partikelfysiske simulatorer og køre den på ressourcer i HPC-skala."

En sammenligning af nogle af forudsigelserne fra Etalumis-projektets metode til kompilering af slutninger (dispositionshistogrammer), som kan opnå de samme niveauer af præcision som beregningsmæssigt vanskelige metoder (udfyldte histogrammer). Kredit:Lawrence Berkeley National Laboratory

Forskere har allerede robuste simuleringssoftwarepakker, der modellerer fysikken og alt, hvad der sker i detektoren. Etalumis bringer probabilistisk programmering ind for at koble sammen med denne eksisterende software, i det væsentlige giver forskere muligheden for at sige "Vi havde denne observation; hvordan kom vi dertil?"

"Dette projekt er spændende, fordi det gør eksisterende simulatorer på tværs af mange områder inden for videnskab og teknik til genstand for probabilistisk maskinlæring, " siger Atilim Gunes Baydin, hovedudvikler af Etalumis-projektet og hovedforfatter af SC19-papiret. Gunes er i øjeblikket postdoc-forsker i maskinlæring ved University of Oxford. "Dette betyder, at simulatoren ikke længere bruges som en sort boks til at generere syntetiske træningsdata, men som en fortolkelig probabilistisk generativ model, som simulatorens kode allerede specificerer, hvor vi kan udføre slutninger.

"Vi er nødt til at være i stand til at kontrollere programmet for at køre alle muligheder ned, så i dette projekt tilføjede vi denne evne som et softwarelag, " tilføjer Wahid Bhimji, en Big Data Architect i Data and Analytics Services-teamet hos NERSC. Imidlertid, at udføre slutninger i så komplekse omgivelser bringer beregningsmæssige udfordringer. "Konventionelle metoder til denne form for Bayesiansk slutning er ekstremt beregningsmæssigt dyre, " Bhimji tilføjer. "Etalumis giver os mulighed for at gøre på få minutter, hvad der normalt ville tage dage, ved at bruge NERSC HPC-ressourcer."

Dyb fortolkning

For LHC-brugssagen, holdet trænede et neuralt netværk til at udføre inferens, lære at komme med gode forslag til, hvilken detaljeret kæde af fysikprocesser fra simulatoren, der kunne være opstået. Dette krævede forbedringer af PyTorchs dybe læringsramme for at træne et komplekst dynamisk neuralt netværk på mere end 1, 000 noder (32, 000 CPU-kerner) af Cori-supercomputeren hos NERSC. Som resultat, træning, der ville tage måneder med den originale uoptimerede software på en enkelt node, kan nu gennemføres på mindre end 10 minutter på Cori. Forskere fik således en mulighed for at studere de valg, der var med til at producere hvert resultat, give dem en større forståelse af dataene.

"I mange tilfælde ved du, at der er en usikkerhed i at bestemme den fysik, der fandt sted ved en LHC-kollision, men du kender ikke sandsynligheden for alle de processer, der kunne have givet anledning til en bestemt observation; med Etalumis, du får en model af det, " forklarer Bhimji.

Den dybe fortolkning, som Etalumis bringer til dataanalyse fra LHC, kunne understøtte store fremskridt i fysikverdenen. "Tegn på ny fysik kan meget vel gemme sig i LHC-dataene; at afsløre disse signaler kan kræve et paradigmeskifte fra den klassiske algoritmiske behandling af dataene til en mere nuanceret probabilistisk tilgang, " siger Kyle Cranmer, en NYU-fysiker, der var en del af Etalumis-projektet. "Denne tilgang bringer os til grænsen af, hvad der er kendt kvantemekanisk."

Varme artikler

Varme artikler

-

Elementarpartikler skiller sig ad med deres egenskaberEn partikel, der adskiller sig fra dens egenskaber, kan hjælpe med at forklare paradokset ved et spejls indvirkning på en partikel, der aldrig kommer i kontakt med den i kontrafaktisk kvantekommunikat

Elementarpartikler skiller sig ad med deres egenskaberEn partikel, der adskiller sig fra dens egenskaber, kan hjælpe med at forklare paradokset ved et spejls indvirkning på en partikel, der aldrig kommer i kontakt med den i kontrafaktisk kvantekommunikat -

Kemisk trykindstilling magnetiske egenskaberKemisk tryk fra atomersubstitution afstemte magnetiske egenskaber for en velstuderet magnet, mangansilicid. Lidt større atomer (grøn) indtog stedet for nogle af siliciumatomerne i magneten, udvidelse

Kemisk trykindstilling magnetiske egenskaberKemisk tryk fra atomersubstitution afstemte magnetiske egenskaber for en velstuderet magnet, mangansilicid. Lidt større atomer (grøn) indtog stedet for nogle af siliciumatomerne i magneten, udvidelse -

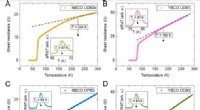

Dynamiske ladningstæthedsudsving gennemtrænger fasediagrammet for en Cu-baseret high-Tc superlederArkmodstande af NBCO- og YBCO -filmene som funktion af temperaturen. Arkmodstanden RΩ er afbildet som en funktion af temperaturen for (A) prøve UD60b (tykkelse:100 nm; afsat under de samme betingelser

Dynamiske ladningstæthedsudsving gennemtrænger fasediagrammet for en Cu-baseret high-Tc superlederArkmodstande af NBCO- og YBCO -filmene som funktion af temperaturen. Arkmodstanden RΩ er afbildet som en funktion af temperaturen for (A) prøve UD60b (tykkelse:100 nm; afsat under de samme betingelser -

Eksotisk aldrig før set partikel opdaget ved CERN(Nederst til højre) Todimensionel fordeling af di-J/ψ-kandidater og dens projektioner på (nederst til venstre) M(1)μμ og (øverst) M(2)μμ. Fire komponenter er til stede, da hver projektion består af si

Eksotisk aldrig før set partikel opdaget ved CERN(Nederst til højre) Todimensionel fordeling af di-J/ψ-kandidater og dens projektioner på (nederst til venstre) M(1)μμ og (øverst) M(2)μμ. Fire komponenter er til stede, da hver projektion består af si

- Sådan bygger du en model af det skæve tårn i Pisa

- Magnetisk materiale slår superhurtig skifterekord

- Supergigantisk stjerne Betelgeuse mindre, tættere på end først antaget

- Nær-infrarød synergiterapi til cancer nanoclusters

- Finansekspert tager Facebook for en domstol i Storbritannien for falske annoncer

- Mere end menneskeligt:Wonders of AI på udstilling i London