Solid-state teknologi til big data i partikelfysik

Når videnskabsmænd skal have adgang til de lagrede filer for at udføre analyser, en lang robotarm stiger ned fra loftet, vælger et bånd, og overfører de data, den gemmer til en harddisk. Kredit:Reidar Hahn, Fermilab

Hos CERNs Large Hadron Collider, så mange som 40 millioner partikelkollisioner sker inden for et enkelt sekund inde i CMS-partikeldetektorens mere end 80 millioner detektionskanaler. Disse kollisioner skaber et enormt digitalt fodaftryk, selv efter computere vinder det til de mest meningsfulde data. Den simple handling at hente information kan betyde at man kæmper mod flaskehalse.

CMS-fysikere ved det amerikanske energiministeriums Fermi National Accelerator Laboratory, som gemmer en stor del af LHC-data, eksperimenterer nu med brugen af NVMe, eller ikke-flygtig hukommelsesekspres, solid state-teknologi til at bestemme den bedste måde at få adgang til lagrede filer på, når videnskabsmænd skal hente dem til analyse.

Besværet med terabytes

Resultaterne af CMS-eksperimentet på CERN har potentialet til at hjælpe med at besvare nogle af de største åbne spørgsmål inden for fysik, såsom hvorfor der er mere stof end antistof i universet, og om der er mere end tre fysiske dimensioner.

Før videnskabsmænd kan besvare sådanne spørgsmål, imidlertid, de skal have adgang til de kollisionsdata, der er registreret af CMS-detektoren, hvoraf meget blev bygget ved Fermilab. Dataadgang er på ingen måde en triviel opgave. Uden online databeskæring, LHC ville generere 40 terabyte data i sekundet, nok til at fylde harddiskene på 80 almindelige bærbare computere. En automatiseret udvælgelsesproces holder kun det vigtige, interessante sammenstød, trimning af antallet af gemte hændelser fra 40 millioner pr. sekund til kun 1, 000.

"Vi bekymrer os kun om en brøkdel af disse kollisioner, så vi har en række udvælgelseskriterier, der afgør, hvilke der skal beholdes, og hvilke der skal smides væk i realtid, " sagde Fermilab videnskabsmand Bo Jayatilaka, der leder NVMe-projektet.

Stadig, selv med selektiv beskæring, titusindvis af terabyte data alene fra CMS-detektoren skal lagres hvert år. Ikke kun det, men for at sikre, at ingen af oplysningerne nogensinde går tabt eller destrueres, to kopier af hver fil skal gemmes. Ét eksemplar opbevares i sin helhed hos CERN, mens den anden kopi er delt mellem partnering institutioner rundt om i verden. Fermilab er den vigtigste udpegede lagerfacilitet i USA til CMS-eksperimentet, med omkring 40 % af eksperimentets datafiler gemt på bånd.

En faststof-løsning

Feynman Computing Center i Fermilab huser tre store databiblioteker fyldt med rækker på rækker af magnetbånd, der gemmer data fra Fermilabs egne eksperimenter, samt fra CMS. Hvis du skulle kombinere hele Fermilabs tapelagringskapacitet, du ville have nogenlunde evnen til at opbevare hvad der svarer til 13, 000 års HD-tv-optagelser.

"Vi har racks fulde af servere, der har harddiske på dem, og de er det primære lagringsmedium, som videnskabsmænd faktisk læser og skriver data til og fra, " sagde Jayatilaka.

Men harddiske - som har været brugt som lagerenheder i computere i de sidste 60 år - er begrænset i mængden af data, de kan indlæse i applikationer på en given tid. Dette skyldes, at de indlæser data ved at hente dem fra roterende diske, som er det eneste adgangspunkt for disse oplysninger. Forskere undersøger måder at implementere nye typer teknologi for at hjælpe med at fremskynde processen.

Til det formål, Fermilab installerede for nylig et enkelt serverrack fyldt med solid-state NVMe-drev på deres Feynman Computing Center for at fremskynde partikelfysikanalyser.

I et forsøg på at fremskynde analyser inden for højenergifysikforskning, Fermilab installerede for nylig et enkelt serverrack fyldt med solid state-drev kaldet NVMe. Kredit:Bo Jayatilaka, Fermilab

Generelt, solid state-drev bruger kompakte elektriske kredsløb til hurtigt at overføre data. NVMe er en avanceret type solid-state-drev, der kan håndtere op til 4, 000 megabyte i sekundet. For at sætte det i perspektiv, den gennemsnitlige harddisk begrænser sig til omkring 150 megabyte i sekundet, gør solid-state til det oplagte valg, hvis hastighed er dit hovedmål.

Men harddiske er ikke blevet henvist til antikken endnu. Hvad de mangler i fart, de opvejer lagerkapaciteten. På nuværende tidspunkt den gennemsnitlige lagergrænse i solid-state-drev er 500 gigabyte, hvilket er den mindste mængde lagerplads, du almindeligvis finder tilgængelig på moderne harddiske. At afgøre, om Fermilab skal erstatte mere af deres harddiskhukommelse med solid-state-drev, vil således kræve en omhyggelig analyse af omkostninger og fordele.

Foretag en analyse

Når forskere analyserer deres data ved hjælp af store computerservere eller supercomputere, de gør det typisk ved sekventielt at hente dele af disse data fra lageret, en opgave velegnet til harddiske.

"Indtil nu, vi har været i stand til at slippe af sted med at bruge harddiske i højenergifysik, fordi vi har en tendens til at håndtere millioner af begivenheder ved at analysere hver begivenhed en ad gangen, " sagde Jayatilaka. "Så til enhver tid, du beder kun om nogle få stykker data fra hver enkelt harddisk."

Men nyere teknikker ændrer den måde, videnskabsmænd analyserer deres data på. Maskinelæring, for eksempel, bliver mere og mere almindeligt inden for partikelfysik, især til CMS-eksperimentet, hvor denne teknologi er ansvarlig for den automatiserede udvælgelsesproces, der holder kun den lille del af dataforskere interesseret i at studere.

Men i stedet for at få adgang til små dele af data, maskinlæringsalgoritmer skal have adgang til det samme stykke data gentagne gange – uanset om det er gemt på en harddisk eller et solid-state-drev. Dette ville ikke være et stort problem, hvis der kun var nogle få processorer, der forsøgte at få adgang til det datapunkt, men i højenergifysikberegninger, der er tusindvis af processorer, der kappes om at få adgang til dette datapunkt samtidigt.

Dette kan hurtigt forårsage flaskehalse og langsomme hastigheder, når du bruger traditionelle harddiske. Slutresultatet er langsommere beregningstider.

Fermilab-forskere tester i øjeblikket NVMe-teknologien for dens evne til at reducere antallet af disse dataflaskehalse.

Fremtiden for computing hos Fermilab

Fermilabs lager- og computerkraft er meget mere end blot et kraftcenter for CMS-eksperimentet. CMS-databehandlings-F&U-indsatsen danner også grundlaget for succesen af det kommende High-Luminosity LHC-program og muliggør det internationale, Fermilab-vært Deep Underground Neutrino Experiment, som begge vil begynde at tage data i slutningen af 2020'erne.

Jayatilaka og hans teams arbejde vil også give fysikere mulighed for at prioritere, hvor NVMe-drev primært skal placeres, hvad enten det er på Fermilab eller hos andre LHC partnerinstitutioners lagerfaciliteter.

Med de nye servere i hånden, holdet undersøger, hvordan man kan implementere den nye solid state-teknologi i den eksisterende computerinfrastruktur hos Fermilab.

Varme artikler

Varme artikler

-

Harvard-team opretter et kold-atom Fermi-Hubbard antiferromagnetUndersøgelse af antiferromagnetisme i Hubbard-modellen med et kvantegasmikroskop. en, Skematisk af det todimensionelle Hubbard fasediagram, inklusive forudsagte faser. b, Forsøgsopstilling. c, Eksempl

Harvard-team opretter et kold-atom Fermi-Hubbard antiferromagnetUndersøgelse af antiferromagnetisme i Hubbard-modellen med et kvantegasmikroskop. en, Skematisk af det todimensionelle Hubbard fasediagram, inklusive forudsagte faser. b, Forsøgsopstilling. c, Eksempl -

Blast, slagsimuleringer kan føre til en bedre forståelse af skader og rustningerSandia National Laboratories forskere Candice Cooper, venstre; Shivonne Haniff, centrum; og Paul Taylor studerer mekanismer bag traumatisk hjerneskade for bedre at forstå, hvordan eksplosioner på en s

Blast, slagsimuleringer kan føre til en bedre forståelse af skader og rustningerSandia National Laboratories forskere Candice Cooper, venstre; Shivonne Haniff, centrum; og Paul Taylor studerer mekanismer bag traumatisk hjerneskade for bedre at forstå, hvordan eksplosioner på en s -

Strækbart hologram kan skifte mellem flere billederHologrammer lavet af elastiske materialer kunne egnede sig til animation. Kredit:American Chemical Society Muligheden for at sende og modtage holografiske beskeder har længe fristet sci-fi-fans. S

Strækbart hologram kan skifte mellem flere billederHologrammer lavet af elastiske materialer kunne egnede sig til animation. Kredit:American Chemical Society Muligheden for at sende og modtage holografiske beskeder har længe fristet sci-fi-fans. S -

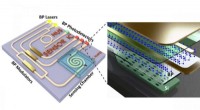

Sort fosfor fremtid i 3D-analyse, molekylært fingeraftrykSkemaer af et on-chip mellem-infrarødt system baseret på sort fosfor-silicium hybrid platform. Det passive fotoniske siliciumlag tjener til at lede det mellem-infrarøde lys, mens sort fosfor spiller e

Sort fosfor fremtid i 3D-analyse, molekylært fingeraftrykSkemaer af et on-chip mellem-infrarødt system baseret på sort fosfor-silicium hybrid platform. Det passive fotoniske siliciumlag tjener til at lede det mellem-infrarøde lys, mens sort fosfor spiller e

- Genanvendelige carbon nanorør kan være fremtidens vandfilter

- Hvordan man identificerer edderkopper fundet i Indiana

- Kina, Frankrig opsender satellit for at studere klimaændringer

- Lytte til celler:Forskere undersøger menneskelige celler med højfrekvent lyd

- YouTube gennemgår børneappen efter klager over indhold

- Trumps forbud mod rejser fra Europa eskalerer smerten for flyselskaberne