SLACs nye røntgenlaserdatasystem vil behandle en million billeder i sekundet

Kredit:Greg Stewart/SLAC National Accelerator Laboratory

Når opgraderingerne til røntgenlaseren på Department of Energy's SLAC National Accelerator Laboratory er afsluttet, den kraftfulde nye maskine vil fange op til 1 terabyte data i sekundet; det er en datahastighed, der svarer til at streame omkring tusinde film i fuld længde på bare et enkelt sekund, og analysere hvert billede i hver film, når de zoomer forbi i denne super-hurtigt fremad-tilstand.

Dataeksperter på laboratoriet finder måder at håndtere denne enorme mængde information på, da Linac Coherent Light Source (LCLS) -opgraderinger kommer online i løbet af de næste flere år.

LCLS accelererer elektroner til næsten lysets hastighed for at generere ekstremt lyse stråler af røntgenstråler. Disse røntgenstråler undersøger en prøve, såsom et protein eller et kvantemateriale, og en detektor fanger en række billeder, der afslører atomets bevægelse i realtid. Ved at samle disse billeder, kemikere, biologer, og materialeforskere kan lave molekylære film af begivenheder som hvordan planter absorberer sollys, eller hvordan vores medicin hjælper med at bekæmpe sygdomme.

Da LCLS bliver opgraderet, forskere bevæger sig fra 120 pulser i sekundet til op til 1 million impulser i sekundet. Det vil skabe en 10, 000 gange lysere røntgenstråle, der vil muliggøre nye undersøgelser af systemer, der ikke kunne undersøges før. Men det vil også komme med en enorm dataudfordring:Røntgenlaseren vil producere flere hundrede til tusinder gange flere data pr. Given periode end før.

For at håndtere disse data, en gruppe forskere under ledelse af LCLS Data Systems Division Director Jana Thayer udvikler nye beregningsværktøjer, herunder computeralgoritmer og måder at oprette forbindelse til supercomputere. Thayers gruppe bruger en kombination af computing, dataanalyse og maskinlæring for at bestemme mønstrene i røntgenbilleder og derefter samle en molekylær film.

Går med strømmen

På LCLS, dataene flyder løbende. "Når forskere får adgang til at køre et eksperiment, det er enten en 12-timers dag eller en 12-timers nat, og begrænset til kun et par skift, inden det næste hold ankommer, "siger Ryan Coffee, Senior videnskabsmand ved SLAC. For effektivt at udnytte værdifuld eksperimentel tid, flaskehalse skal helt undgås for at bevare datastrømmen og deres analyse.

Streaming og lagring af data udgør en betydelig udfordring for netværks- og computerressourcer, og for at kunne overvåge datakvaliteten i næsten realtid betyder, at dataene skal behandles med det samme. Et vigtigt skridt i retning af at gøre dette muligt er at reducere mængden af data så meget som muligt, før de gemmes til yderligere analyse.

For at aktivere dette, Thayers team har implementeret on-the-fly datareduktion ved hjælp af flere former for komprimering for at reducere størrelsen af registrerede data uden at påvirke kvaliteten af det videnskabelige resultat. En form for komprimering, kaldet veto, smider uønskede data ud, såsom billeder, hvor røntgenstrålerne savnede deres mål. En anden, kaldet feature extraction, gemmer kun de videnskabeligt vigtige oplysninger, f.eks. placeringen og lysstyrken af et sted i et røntgenbillede.

"Hvis vi gemte alle rådata, som vi har gjort indtil nu, det ville koste os en kvart milliard dollars om året, "Thayer siger." Vores mission er at finde ud af at reducere dataene, før vi skriver det. En af de virkelig pæne, innovative dele af det nye datasystem, vi udviklede, er datareduktion pipeline, som fjerner irrelevante oplysninger og reducerer de data, der skal overføres og lagres. "

Kaffe siger, "Så sparer du meget på strømmen, men endnu vigtigere, du sparer på gennemstrømning. Hvis du skal sende rådataene via netværket, du vil helt overvælde det ved at prøve at sende billeder ud hvert eneste mikrosekund. "

Gruppen oprettede også et formidlingssted for at lægge dataene, før de går til lagring. Thayer forklarer, "Vi kan ikke skrive til lageret direkte, fordi hvis der er en fejl i systemet, den skal holde pause og vente. Eller hvis der er en nethik, så kan du helt miste data. Så, vi har en lille, men pålidelig buffer, som vi kan skrive til; så kan vi flytte data til permanent lagring. "

Drivende innovation

Thayer understreger, at datasystemet er bygget til at give forskere resultaterne af deres arbejde lige så hurtigt som det nuværende system, så de får information i realtid. Det er også bygget til at rumme ekspansionen inden for LCLS -videnskab i de næste 10 år. Den store udfordring er at følge med i det enorme spring i datahastigheden.

"Hvis du forestiller dig at gå fra at analysere 120 billeder i sekundet til 1 million i sekundet, det kræver meget mere rulning, "siger hun." Computing er ikke magi - det fungerer stadig på samme måde - vi øger bare antallet af hjerner, der arbejder på hvert af billederne. "

Understøttet af en nylig pris fra DOE, og arbejder med kolleger på tværs af DOE's nationale laboratoriekompleks, teamet søger også at inkorporere kunstig intelligens og maskinlæringsteknikker for yderligere at reducere mængden af data, der skal behandles, og at markere interessante funktioner i dataene, når de opstår.

For at forstå LCLS -dataudfordringen, Kaffe tegner en analogi til selvkørende biler:"De skal beregne i realtid:de kan ikke analysere et parti billeder, der lige er optaget og derefter sige" Vi forudsiger, at du skulle have drejet til venstre på billednummer 10. "SLACs datahastighed er meget højere end nogen af disse biler vil opleve, men problemet er det samme - forskere skal styre deres eksperiment for at finde de mest spændende destinationer! "

Opgraderingerne, der driver dette massive spring i datahastighed og ydeevne, kommer i to faser i løbet af de kommende år, herunder LCLS-II og en høj energioppgradering, der følger. Dataeksperternes arbejde vil sikre, at forskere kan drage fuld fordel af begge dele. "I sidste ende vil det have en dramatisk effekt på den type videnskab, vi kan udføre, åbne muligheder, der ikke er mulige i dag, "Kaffe siger.

Varme artikler

Varme artikler

-

Kilogrammet er dødt. Mød Kilogram 2.0NISTs kopi af Le Grand K (forside), den internationale vægt, der definerer et kilo, der opbevares i et hvælving i Frankrig. Fysiske objekter vil blive erstattet af Plancks konstant som definitionen på

Kilogrammet er dødt. Mød Kilogram 2.0NISTs kopi af Le Grand K (forside), den internationale vægt, der definerer et kilo, der opbevares i et hvælving i Frankrig. Fysiske objekter vil blive erstattet af Plancks konstant som definitionen på -

Entanglement sendte over 50 km optisk fiberI en ikke-lineær krystal oplyst af en stærk laser omdannes fotonbølgelængden til den optimale værdi for langdistancerejser. Kredit:IQOQI Innsbruck/Harald Ritsch Kvanteinternettet lover absolut try

Entanglement sendte over 50 km optisk fiberI en ikke-lineær krystal oplyst af en stærk laser omdannes fotonbølgelængden til den optimale værdi for langdistancerejser. Kredit:IQOQI Innsbruck/Harald Ritsch Kvanteinternettet lover absolut try -

Forskere forbedrer yderligere nøjagtigheden af retningsbestemt polarimetrisk kameraFig.1. DPC-system til registrering af alle synsfelter. Kredit:HUANG Chan For nylig, forskere fra Optical Remote Sensing Center ved Anhui Institute of Optics and Fine Mechanics (AIOFM), Hefei Insti

Forskere forbedrer yderligere nøjagtigheden af retningsbestemt polarimetrisk kameraFig.1. DPC-system til registrering af alle synsfelter. Kredit:HUANG Chan For nylig, forskere fra Optical Remote Sensing Center ved Anhui Institute of Optics and Fine Mechanics (AIOFM), Hefei Insti -

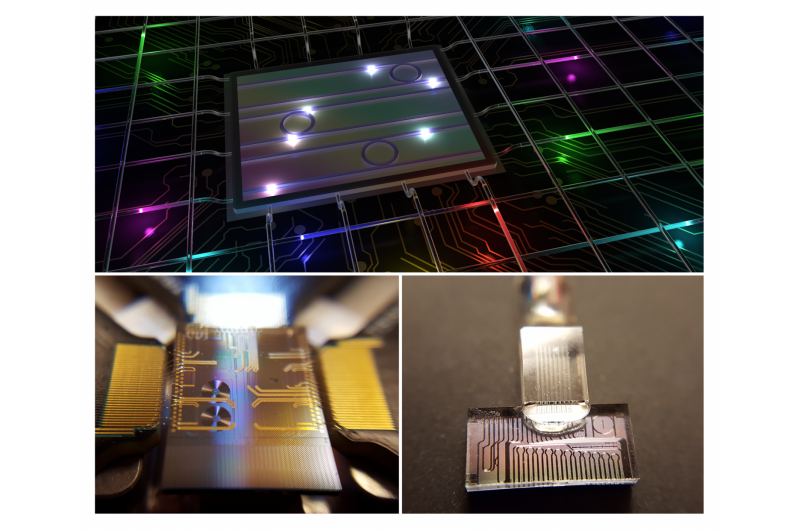

De flerfarvede fotoner, der kan ændre kvanteinformationsvidenskabenØverst:Højdimensionelle farvesammenfiltrede fotontilstande fra en fotonisk chip, manipuleret og transmitteret via telekommunikationssystemer. Til venstre:Fotonisk chip inklusive en ikke-lineær mikroty

De flerfarvede fotoner, der kan ændre kvanteinformationsvidenskabenØverst:Højdimensionelle farvesammenfiltrede fotontilstande fra en fotonisk chip, manipuleret og transmitteret via telekommunikationssystemer. Til venstre:Fotonisk chip inklusive en ikke-lineær mikroty

- Google, Amazon lider af markedstilbageslag på salgsudsigterne

- Ulemperne ved en lille prøvestørrelse

- Hvorfor det kan virke kontraproduktivt at bruge teknologi til at overvåge medarbejdere på arbejdet

- Opgradering af arktisk ismodel til gavn for polarforskning, industri og militær

- Nye detaljer dukker op om temperatur, mobilitet af jordens nedre skorpe i Rocky Mountains

- Dybhavsvulkaner:Vinduer ind i undergrunden