Forskere udvikler den næste generation af reservoir computing

Kredit:Pixabay/CC0 Public Domain

En forholdsvis ny type computing, der efterligner den måde, den menneskelige hjerne fungerer på, var allerede ved at transformere, hvordan forskere kunne tackle nogle af de vanskeligste informationsbehandlingsproblemer.

Nu, forskere har fundet en måde at få det, der kaldes reservoir computing til at fungere mellem 33 og en million gange hurtigere, med betydeligt færre computerressourcer og mindre datainput nødvendig.

Faktisk, i en test af denne næste generations reservoirberegning, forskere løste et komplekst computerproblem på mindre end et sekund på en stationær computer.

Ved hjælp af den nyeste state-of-the-art teknologi, det samme problem kræver en supercomputer til at løse og tager stadig meget længere tid, sagde Daniel Gauthier, hovedforfatter af undersøgelsen og professor i fysik ved Ohio State University.

"Vi kan udføre meget komplekse informationsbehandlingsopgaver på en brøkdel af tiden ved at bruge meget færre computerressourcer i forhold til hvad reservoir computing i øjeblikket kan gøre, "Sagde Gauthier.

"Og reservoir computing var allerede en betydelig forbedring i forhold til, hvad der tidligere var muligt."

Undersøgelsen blev offentliggjort i dag i tidsskriftet Naturkommunikation .

Reservoir computing er en algoritme til maskinlæring udviklet i begyndelsen af 2000'erne og bruges til at løse de "hårdeste af de hårde" computerproblemer, såsom at forudsige udviklingen af dynamiske systemer, der ændrer sig over tid, Sagde Gauthier.

Dynamiske systemer, ligesom vejret, er svære at forudsige, fordi kun en lille ændring i en tilstand kan have massive effekter ned ad linjen, han sagde.

Et berømt eksempel er "sommerfugleeffekten, "hvor - i en metaforisk illustration - ændringer skabt af en sommerfugl, der klapper med vingerne, i sidste ende kan påvirke vejret uger senere.

Tidligere forskning har vist, at reservoir computing er velegnet til læring af dynamiske systemer og kan give præcise prognoser om, hvordan de vil opføre sig i fremtiden, Sagde Gauthier.

Det gør det ved brug af et kunstigt neuralt netværk, lidt som en menneskelig hjerne. Forskere indfører data på et dynamisk netværk i et "reservoir" af tilfældigt forbundne kunstige neuroner i et netværk. Netværket producerer nyttig output, som forskerne kan fortolke og feed back ind i netværket, opbygge en mere og mere præcis prognose for, hvordan systemet vil udvikle sig i fremtiden.

Jo større og mere komplekst systemet og desto mere præcist, som forskerne ønsker, at prognosen skal være, jo større netværket af kunstige neuroner skal være, og jo flere computerressourcer og tid, der er nødvendig for at fuldføre opgaven.

Et problem har været, at reservoiret af kunstige neuroner er en "sort boks, "Sagde Gauthier, og forskere ved ikke nøjagtigt, hvad der foregår inde i det - de ved kun, at det virker.

De kunstige neurale netværk i hjertet af reservoir computing er bygget på matematik, Forklarede Gauthier.

"Vi fik matematikere til at se på disse netværk og spørge, 'I hvor høj grad er alle disse stykker i maskinen virkelig nødvendige?' "Sagde han.

I dette studie, Gauthier og hans kolleger undersøgte dette spørgsmål og fandt ud af, at hele reservoirets computersystem kunne forenkles i høj grad, reducerer dramatisk behovet for computerressourcer og sparer betydelig tid.

De testede deres koncept på en prognoseopgave, der involverede et vejrsystem udviklet af Edward Lorenz, hvis arbejde førte til vores forståelse af sommerfugleeffekten.

Deres næste generations reservoir computing var en klar vinder af nutidens state-of-the-art på denne Lorenz-prognoseopgave. I en relativt simpel simulering udført på en stationær computer, det nye system var 33 til 163 gange hurtigere end den nuværende model.

Men da målet var stor nøjagtighed i prognosen, næste generations reservoirberegning var cirka 1 million gange hurtigere. Og den nye generations computing opnåede den samme nøjagtighed med ækvivalent til kun 28 neuroner, sammenlignet med de 4, 000 nødvendige af den nuværende generations model, Sagde Gauthier.

En vigtig årsag til fremskyndelsen er, at "hjernen" bag denne næste generation af reservoir-computere har brug for meget mindre opvarmning og træning sammenlignet med den nuværende generation for at producere de samme resultater.

Opvarmning er træningsdata, der skal tilføjes som input til reservoircomputeren for at forberede dem til dens egentlige opgave.

"Til vores næste generations reservoir computing, der er næsten ingen opvarmningstid nødvendig, "Sagde Gauthier.

"I øjeblikket, forskere skal indsætte 1, 000 eller 10, 000 datapunkter eller mere for at varme det op. Og det er alle data, der går tabt, der ikke er nødvendig for selve arbejdet. Vi skal kun indsætte et eller to eller tre datapunkter, " han sagde.

Og når først forskere er klar til at træne reservoircomputeren til at lave prognosen, igen, der er brug for meget mindre data i det næste generations system.

I deres test af Lorenz -prognoseopgaven, forskerne kunne få de samme resultater ved hjælp af 400 datapunkter som den nuværende generation produceret ved hjælp af 5, 000 datapunkter eller mere, afhængig af den ønskede nøjagtighed.

"Det spændende er, at denne næste generation af reservoir computing tager det, der allerede var meget godt, og gør det betydeligt mere effektivt, "Sagde Gauthier.

Han og hans kolleger planlægger at udvide dette arbejde til at håndtere endnu mere vanskelige computerproblemer, såsom at forudsige væskedynamik.

"Det er et utroligt udfordrende problem at løse. Vi vil se, om vi kan fremskynde processen med at løse dette problem ved hjælp af vores forenklede model for reservoir computing."

Medforfattere af undersøgelsen var Erik Bollt, professor i el- og computerteknik ved Clarkson University; Aaron Griffith, der modtog sin ph.d. i fysik i Ohio State; og Wendson Barbosa, en postdoktor i fysik ved Ohio State.

Varme artikler

Varme artikler

-

Forskere udvikler en ny metode til at reducere kvantestøjEksempel på en overflade, der passer til mange forsøg med lidt forskellige støjparametre, 1 og 2. Sorte punkter er målinger af en observerbar med forskellige støjhastigheder. Det røde X er det støjfri

Forskere udvikler en ny metode til at reducere kvantestøjEksempel på en overflade, der passer til mange forsøg med lidt forskellige støjparametre, 1 og 2. Sorte punkter er målinger af en observerbar med forskellige støjhastigheder. Det røde X er det støjfri -

Hvorfor solaksioner ikke kan forklare det observerede XENON1T -overskudKunstnerrepræsentation af en Red Giant-stjerne, der udsender aksioner. Aksion-elektronkoblinger af den størrelse, der kræves for at tage højde for XENON1T-overskuddet, ville uundgåeligt gøre andre stj

Hvorfor solaksioner ikke kan forklare det observerede XENON1T -overskudKunstnerrepræsentation af en Red Giant-stjerne, der udsender aksioner. Aksion-elektronkoblinger af den størrelse, der kræves for at tage højde for XENON1T-overskuddet, ville uundgåeligt gøre andre stj -

Ægte holografiske film er inden for rækkeviddeKredit:CC0 Public Domain Holografiske film, som den R2D2, der blev projiceret af prinsesse Leia i Star Wars:A New Hope, har længe været science fiction-provinsen, men for de fleste af os omfanget

Ægte holografiske film er inden for rækkeviddeKredit:CC0 Public Domain Holografiske film, som den R2D2, der blev projiceret af prinsesse Leia i Star Wars:A New Hope, har længe været science fiction-provinsen, men for de fleste af os omfanget -

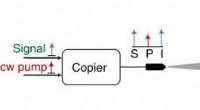

Rumkommunikation:udvikling af en én foton-per-bit modtager ved hjælp af næsten støjfri faseføls…Konceptuelt diagram af en frirumskommunikationsforbindelse med en PSA forforstærket kohærent modtager. S-signal; P pumpe, jeg ledig, PLL faselåst sløjfe, PSA fasefølsom forstærker. Kredit:Lysvidenskab

Rumkommunikation:udvikling af en én foton-per-bit modtager ved hjælp af næsten støjfri faseføls…Konceptuelt diagram af en frirumskommunikationsforbindelse med en PSA forforstærket kohærent modtager. S-signal; P pumpe, jeg ledig, PLL faselåst sløjfe, PSA fasefølsom forstærker. Kredit:Lysvidenskab

- Glødende bakterier opdager begravede landminer

- Sæsonbestemte mønstre i Amazonas forklaret

- Nye kemiske værktøjer til at modificere og studere biomolekyler

- Bor i højarktis, Forsker kendte ikke COVIDs omfang

- Forskere udvikler en optisk lineal, der kan måle ned til nanoskalaen

- Forskere udvikler metode til dyrkning af enkeltarter af enkeltvæggede carbon nanorør