Forskere skaber størst, længste flerfysiske jordskælvsimulering til dato

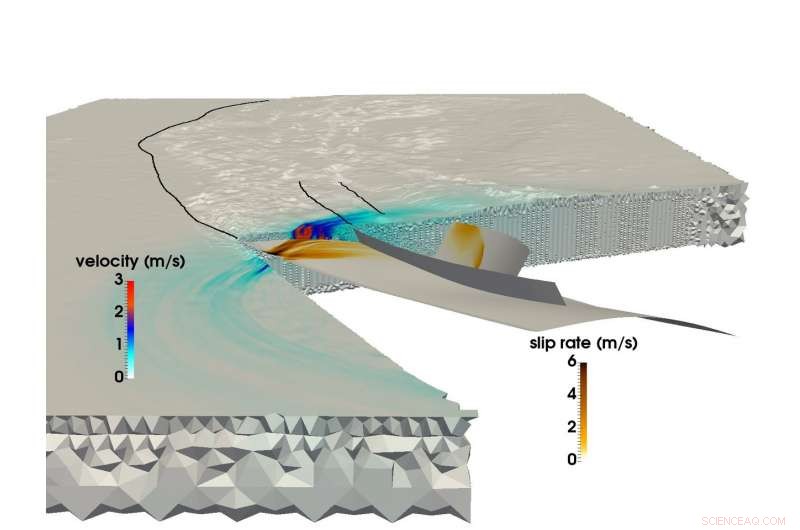

Brug af LRZ's SuperMUC -supercomputer, et fælles forskerhold fra det tekniske universitet i München og Ludwigs-Maximilians-Uni München var i stand til at skabe den største multifysiske simulering af et jordskælv og tsunami. Dette billede viser brudspredning og det resulterende seismiske bølgefelt under Sumatra-Andaman jordskælv i 2004. Kredit:C. Uphoff, S.Rettenberger, M. Bader, Münchens tekniske universitet. E. Madden, T. Ulrich, S. Wollherr, A. Gabriel, Ludwigs-Maximilians-Universität.

Lige før kl. 08.00 lokal tid den 26. december, 2004, mennesker i Sydøstasien startede deres dage, da det tredje stærkeste registrerede jordskælv i historien rippede et 1, 500 kilometer rive i havbunden ud for kysten af den indonesiske ø Sumatra.

Jordskælvet varede mellem 8 og 10 minutter (et af de længste nogensinde registreret), og løftede havbunden flere meter, skaber en tsunami med 30 meter lange bølger, der ødelagde hele samfund. Arrangementet forårsagede næsten 200, 000 dødsfald i 15 lande, og frigav lige så meget energi over og under jorden som flere århundreders amerikanske energiforbrug.

Sumatra-Andaman-jordskælvet, som det kaldes, var lige så overraskende som voldsomt. På trods af store fremskridt inden for overvågning og advarselssystemer for jordskælv i løbet af de sidste 50 år, jordforskere var ude af stand til at forudsige det, fordi der findes relativt få data om så store seismologiske begivenheder. Forskere har et væld af oplysninger om semi-regulære, jordskælv med lavere til medium styrke, men katastrofer som Sumatra-Andaman-begivenheder, der kun sker hvert par hundrede år-er for sjældne til at oprette pålidelige datasæt.

For mere fuldt ud at forstå disse begivenheder, og forhåbentlig give bedre forudsigelses- og afbødningsmetoder, et team af forskere fra Ludwig-Maximilians-Universität München (LMU) og Technical University of Munich (TUM) bruger supercomputeressourcer på Leibniz Supercomputing Center (LRZ) til bedre at forstå disse sjældne, ekstremt farlige seismiske fænomener.

"Vores generelle motivation er at bedre forstå hele processen med, hvorfor nogle jordskælv og resulterende tsunamier er så meget større end andre, "sagde TUM -professor Dr. Michael Bader." Nogle gange ser vi relativt små tsunamier, når jordskælv er store, eller overraskende store tsunamier forbundet med relativt små jordskælv. Simulering er et af værktøjerne til at få indsigt i disse begivenheder. "

Teamet stræber efter "koblede" simuleringer af både jordskælv og efterfølgende tsunamier. Det afsluttede for nylig sin største jordskælvsimulering endnu. Ved hjælp af SuperMUC -supercomputeren på LRZ, holdet var i stand til at simulere 1, 500 kilometer ikke-lineær brudmekanik-jordskælvskilden-koblet til seismiske bølger, der rejser op til Indien og Thailand over lidt mere end 8 minutter af Sumatra-Andaman-jordskælvet. Gennem flere interne beregningsmæssige innovationer, teamet opnåede en 13 gange forbedring i tid til løsning. I anerkendelse af denne præstation, projektet blev nomineret til prisen for bedste papir på SC17, en af verdens førende supercomputerkonferencer, afholdt i år den 12.-17. november i Denver, Colorado.

Megathrust jordskælv, simuleringer i massiv skala

Jordskælv sker, da sten under Jordens overflade pludselig går i stykker, ofte som følge af den langsomme bevægelse af tektoniske plader.

En grov forudsigelse af et havbaseret jordskælvs evne til at udløse en stor tsunami er, om plader sliber mod hinanden eller kolliderer frontalt. Hvis to eller flere plader støder sammen, den ene plade vil ofte tvinge den anden under den. Regioner, hvor denne proces opstår, kaldes subduktionszoner og kan rumme meget store, lavt nedsænkede fejl - såkaldte "megathrusts". Energiudslip på tværs af så store svaghedszoner har tendens til at skabe voldsomme tsunamier, som havbunden stiger en betydelig mængde, midlertidigt fortrænger store mængder vand.

Indtil for nylig, selvom, forskere, der udfører beregningsgeofysik, havde store vanskeligheder med at simulere subduktion jordskælv på det nødvendige detaljeringsniveau og nøjagtighed. Store jordskælvsimuleringer er generelt vanskelige, men subduktionsbegivenheder er endnu mere komplekse.

"Modellering af jordskælv er et multiscale problem i både rum og tid, sagde Dr. Alice Gabriel, den ledende forsker fra LMU -siden af teamet. "Virkeligheden er kompleks, hvilket betyder, at inkorporering af den observerede kompleksitet af jordskælvskilder altid indebærer brug af numeriske metoder, yderst effektiv simuleringssoftware, og, selvfølgelig, højtydende computing (HPC). Kun ved at udnytte HPC kan vi skabe modeller, der både kan løse den dynamiske stressfrigivelse og rupturer, der sker ved et jordskælv, samtidig med at de simulerer forskydning af havbunden over tusinder af kilometer. "

Når forskere simulerer et jordskælv, de bruger et beregningsnet til at opdele simuleringen i mange små stykker. De beregner derefter specifikke ligninger for forskellige aspekter af simuleringen, såsom genereret seismisk rystning eller forskydning af havbunden, blandt andre, over "tidstrin, "eller simuleringsbilleder over tid, der hjælper med at sætte det i gang, meget gerne en bladbog.

Jo finere gitter, jo mere præcis simuleringen, men jo mere beregningsmæssigt krævende bliver det. Ud over, jo mere kompleks jordskælvets geometri er, jo mere komplekst nettet bliver, yderligere komplicerer beregningen. For at simulere subduktion jordskælv, beregningsforskere skal oprette et stort gitter, der også nøjagtigt kan repræsentere de meget overfladiske vinkler, hvor de to kontinentale plader mødes. Dette kræver, at gittercellerne omkring subduktionsområdet er ekstra små, og ofte slank i formen.

I modsætning til kontinentale jordskælv, som er blevet bedre dokumenteret gennem beregning og observation, subduktionsbegivenheder sker ofte dybt i havet, hvilket betyder, at det er meget vanskeligere at begrænse en simulering ved at ryste observationer fra jorden og detaljeret, pålidelige data fra direkte observation og laboratorieforsøg.

Desuden, beregning af en koblet, storskala jordskælv-tsunamisimulering kræver brug af data fra en lang række kilder. Forskere skal tage hensyn til havbundens form, formen og styrken af pladegrænsen, der er sprængt af jordskælvet og den jordiske jordskorps materielle adfærd på hvert niveau, blandt andre aspekter. Teamet har brugt de sidste mange år på at udvikle metoder til mere effektivt at integrere disse forskellige datakilder i en konsistent model.

For at reducere den enorme computertid, holdet udnyttede en metode kaldet "lokal tidstegning". I områder, hvor simuleringerne kræver meget mere rumlige detaljer, forskere skal også "bremse" simuleringen ved at udføre flere tidstrin på disse områder. Andre sektioner, der kræver mindre detaljer, kan udføre meget større - og dermed - langt færre tidstrin.

Hvis teamet skulle køre hele sin simulering på et ensartet lille tidstrin, det ville have krævet cirka 3 millioner individuelle iterationer. Imidlertid, kun få celler i beregningsgitteret krævede denne tidstrinnestørrelse. Store dele kunne beregnes med meget større tidstrin, nogle kræver kun 3000 tidstrin. Dette reducerede den beregningsmæssige efterspørgsel betydeligt og førte til meget af teamets 13-doble speedup. Dette fremskridt førte også til, at teamets simulering var den største, længste første-princip simulering af et jordskælv af denne type.

Fremadgående bevægelse

På grund af sit tætte samarbejde med LRZ -medarbejdere, teamet havde muligheder for at bruge hele SuperMUC -maskinen til sine simuleringer. Bader angav, at disse ekstremt store løb er uvurderlige for teamet at få dybere indsigt i sin forskning. "Der er en stor forskel, hvis du kører på en fjerdedel af en maskine eller en fuld maskine, da den sidste faktor på 4 ofte afslører de kritiske flaskehalse, " han sagde.

Teamets evne til at drage fuld fordel af den nuværende generations supercomputeressourcer har det spændt på fremtiden. Det er ikke nødvendigvis vigtigt, at næste generations maskiner giver LMU-TUM-forskerne mulighed for at køre "større" simuleringer-aktuelle simuleringer kan effektivt simulere et stort nok geografisk område. Hellere, teamet er begejstret for muligheden for at ændre inputdataene og køre mange flere iterationer i løbet af en bestemt mængde computetid.

"Vi har lavet en individuel simulering, forsøger at nøjagtigt gætte startkonfigurationen, såsom de indledende spændinger og kræfter, men alle disse er stadig usikre, "Bader sagde." Så vi vil gerne køre vores simulering med mange forskellige indstillinger for at se, hvordan små ændringer i fejlsystemet eller andre faktorer ville påvirke undersøgelsen. Disse ville være større parameterundersøgelser, hvilket er et andet lag af ydeevne, som en computer skal levere. "

Gabriel nævnte også, at næste generations maskiner forhåbentlig vil kunne simulere presserende, realtidsscenarier, der kan hjælpe med at forudsige farer, da de vedrører sandsynlige efterskælvsområder. Teamet er spændt på at se den næste generations arkitekturer på LRZ og de andre Gauss Center for Supercomputing centre, High-Performance Computing Center Stuttgart og Jülich Supercomputing Center.

Efter Bader's opfattelse, teamets seneste arbejde repræsenterer ikke kun dets største simulering til dato, men også det stadig stærkere samarbejde mellem domæneforskere og beregningsforskere i gruppen. "Dette papir har en stærk seismologisk komponent og en stærk HPC -komponent, "sagde han." Dette er virkelig et 50-50 papir for os. Vores samarbejde er gået pænt, og det er fordi det ikke handler om at få vores eller deres. Begge grupper tjener, og det er virkelig dejligt fælles arbejde. "

Sidste artikelGrønne tage for at reducere virkningerne af klimaændringer

Næste artikelSolrig løsning til at dræbe E. coli

Varme artikler

Varme artikler

-

Endnu et fingerpeg om hurtig bevægelse af det hawaiiske hotspotGraf viser datoerne for vulkaner i de tre vulkankæder i Stillehavet og deres relative bevægelse over tid (til venstre). Placeringen af de tre vulkanske kæder vist på kortet (højre). Stjernerne marke

Endnu et fingerpeg om hurtig bevægelse af det hawaiiske hotspotGraf viser datoerne for vulkaner i de tre vulkankæder i Stillehavet og deres relative bevægelse over tid (til venstre). Placeringen af de tre vulkanske kæder vist på kortet (højre). Stjernerne marke -

Kontrolalgoritmer kunne holde sensorbelastede balloner flydende i orkaner i en ugeUC San Diego-forskere Bewley og Meneghello undersøger den energisk effektive koordinering af sensorbelastede ballonsværme for vedvarende, in situ, realtidsmålinger af udvikling af orkaner. Kredit:Univ

Kontrolalgoritmer kunne holde sensorbelastede balloner flydende i orkaner i en ugeUC San Diego-forskere Bewley og Meneghello undersøger den energisk effektive koordinering af sensorbelastede ballonsværme for vedvarende, in situ, realtidsmålinger af udvikling af orkaner. Kredit:Univ -

Bevaringsomkostningerne kan være højere end aftaltKinesiske bønder høster kartofler i Wolong Nature Reserve. En gennemgribende bevaringsindsats har ført en del afgrødejord tilbage til skoven. Kredit:Michigan State University Gennemgribende politi

Bevaringsomkostningerne kan være højere end aftaltKinesiske bønder høster kartofler i Wolong Nature Reserve. En gennemgribende bevaringsindsats har ført en del afgrødejord tilbage til skoven. Kredit:Michigan State University Gennemgribende politi -

Ny undersøgelse finder forskellige mikrober, der lever ved siden af korallerEt nærbillede af overfladen af en Orbicella faveolata koralkoloni fra et rev i Los Canarreos, Cuba. Kredit:Amy Apprill, Woods Hole Oceanografisk Institution Symbiotiske alger, der lever inde i k

Ny undersøgelse finder forskellige mikrober, der lever ved siden af korallerEt nærbillede af overfladen af en Orbicella faveolata koralkoloni fra et rev i Los Canarreos, Cuba. Kredit:Amy Apprill, Woods Hole Oceanografisk Institution Symbiotiske alger, der lever inde i k

- Astronomer opdager en ekstraordinær calciumrig forbigående

- Iltmigrering ved heterostrukturgrænsefladen

- Forvitrende antarktiske storme:Vejrballondata øger forudsigelsesevnen

- Vejen til forløberen for robuste nanorør, der kan føre til udbredt industriel fremstilling

- Landbrug bliver mere risikabelt under klimaændringer

- Fiberoptik fanger seismiske signaturer af roseparaden