Facebooks algoritmer gav næring til massive udenlandske propagandakampagner under valget i 2020

Kredit:Samtalen

En intern Facebook-rapport viste, at den sociale medieplatforms algoritmer - de regler, dens computere følger for at bestemme det indhold, du ser - gjorde det muligt for desinformationskampagner baseret i Østeuropa at nå ud til næsten halvdelen af alle amerikanere i tiden op til præsidentvalget i 2020, ifølge en rapport i Technology Review.

Kampagnerne producerede de mest populære sider for kristent og sort amerikansk indhold, og nåede samlet set 140 millioner amerikanske brugere om måneden. 75 procent af de personer, der blev eksponeret for indholdet, havde ikke fulgt nogen af siderne. Folk så indholdet, fordi Facebooks indholdsanbefalingssystem lagde det ind i deres nyhedsfeeds.

Sociale medieplatforme er stærkt afhængige af folks adfærd for at bestemme det indhold, du ser. I særdeleshed, de ser efter indhold, som folk reagerer på eller "engagerer" med ved at like, kommentere og dele. Troldefarme, organisationer, der spreder provokerende indhold, udnytte dette ved at kopiere indhold med højt engagement og sende det som deres eget.

Som datalog, der studerer måden, hvorpå et stort antal mennesker interagerer ved hjælp af teknologi, Jeg forstår logikken i at bruge skarernes visdom i disse algoritmer. Jeg ser også betydelige faldgruber i, hvordan de sociale medievirksomheder gør det i praksis.

På tærsklen til valget i 2020, troldefarme kørte store sidenetværk på FB rettet mod Christian, Sort, &Indfødte amerikanere. En intern rapport, der sporer situationen, beskrev den som "virkelig forfærdelig." Nogle af siderne forbliver to år senere. https://t.co/Wa43f8rG0N

— Karen Hao (@_KarenHao) 17. september 2021

Fra løver på savannen til likes på Facebook

Begrebet skarers visdom antager, at brug af signaler fra andres handlinger, meninger og præferencer som guide vil føre til fornuftige beslutninger. For eksempel, kollektive forudsigelser er normalt mere nøjagtige end individuelle. Kollektiv intelligens bruges til at forudsige finansielle markeder, sport, valg og endda sygdomsudbrud.

Gennem millioner af års evolution, disse principper er blevet kodet ind i den menneskelige hjerne i form af kognitive skævheder, der kommer med navne som familiaritet, blot eksponering og bandwagon-effekt. Hvis alle begynder at løbe, du bør også begynde at løbe; måske nogen så en løve komme og løbe kunne redde dit liv. Du ved måske ikke hvorfor, men det er klogere at stille spørgsmål senere.

Din hjerne opfanger spor fra omgivelserne – inklusive dine jævnaldrende – og bruger enkle regler til hurtigt at omsætte disse signaler til beslutninger:Tag med vinderen, følge flertallet, kopiere din nabo. Disse regler fungerer bemærkelsesværdigt godt i typiske situationer, fordi de er baseret på sunde antagelser. For eksempel, de antager, at folk ofte handler rationelt, det er usandsynligt, at mange tager fejl, fortiden forudsiger fremtiden, og så videre.

Teknologien giver folk mulighed for at få adgang til signaler fra meget større antal andre mennesker, de fleste af dem kender de ikke. Kunstig intelligens-applikationer gør stor brug af disse popularitets- eller "engagement"-signaler, fra at vælge søgemaskineresultater til at anbefale musik og videoer, og fra at foreslå venner til at rangere opslag på nyhedsfeeds.

Ikke alt viralt fortjener at være

Vores forskning viser, at stort set alle webteknologiplatforme, såsom sociale medier og nyhedsanbefalingssystemer, har en stærk popularitetsbias. Når applikationer er drevet af signaler som engagement snarere end eksplicitte søgemaskineforespørgsler, popularitetsbias kan føre til skadelige utilsigtede konsekvenser.

Sociale medier som Facebook, Instagram, Twitter, YouTube og TikTok er stærkt afhængige af AI-algoritmer til at rangere og anbefale indhold. Disse algoritmer tager som input, hvad du kan lide, kommentere og del – med andre ord, indhold, du engagerer dig i. Målet med algoritmerne er at maksimere engagementet ved at finde ud af, hvad folk kan lide og placere det øverst i deres feeds.

På overfladen virker dette rimeligt. Hvis folk kan lide troværdige nyheder, ekspertudtalelser og sjove videoer, disse algoritmer bør identificere sådant indhold af høj kvalitet. Men folkemængdernes visdom gør her en central antagelse:at anbefale, hvad der er populært, vil hjælpe med at "boble op" indhold af høj kvalitet.

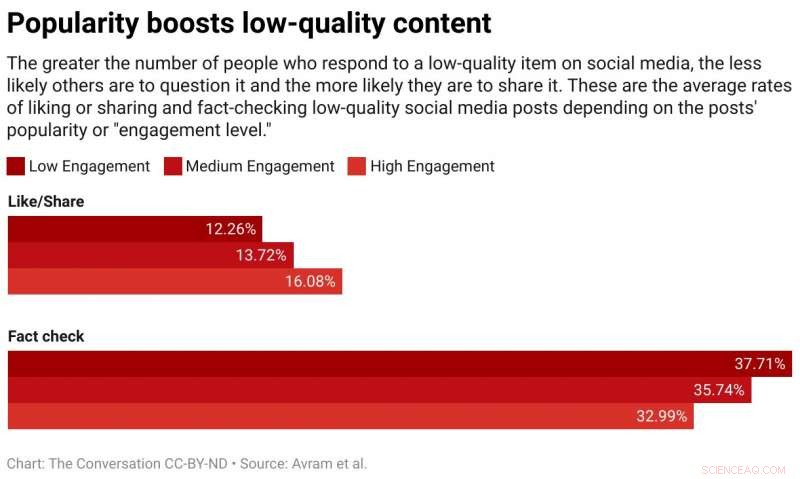

Vi testede denne antagelse ved at studere en algoritme, der rangerer varer ved hjælp af en blanding af kvalitet og popularitet. Vi fandt, at generelt, popularitetsbias er mere tilbøjelige til at sænke den overordnede kvalitet af indholdet. Årsagen er, at engagement ikke er en pålidelig indikator for kvalitet, når få mennesker har været udsat for en vare. I disse tilfælde, engagement genererer et støjende signal, og algoritmen vil sandsynligvis forstærke denne indledende støj. Når populariteten af en vare af lav kvalitet er stor nok, det vil blive ved med at blive forstærket.

Algoritmer er ikke det eneste, der påvirkes af engagement bias - det kan også påvirke mennesker. Beviser viser, at information overføres via "kompleks smitte, "det betyder jo flere gange folk bliver eksponeret for en idé online, jo mere sandsynligt er det, at de adopterer og videredeler det. Når sociale medier fortæller folk, at et element bliver viralt, deres kognitive fordomme slår ind og udmønter sig i den uimodståelige trang til at være opmærksom på det og dele det.

Ikke så kloge skarer

Vi kørte for nylig et eksperiment ved hjælp af en nyhedskompetence-app kaldet Fakey. Det er et spil udviklet af vores laboratorium, som simulerer et nyhedsfeed som Facebook og Twitter. Spillere ser en blanding af aktuelle artikler fra falske nyheder, junk science, hyperpartiske og konspiratoriske kilder, såvel som almindelige kilder. De får point for at dele eller like nyheder fra pålidelige kilder og for at markere artikler med lav troværdighed til faktatjek.

Vi fandt ud af, at spillere er mere tilbøjelige til at like eller dele og mindre tilbøjelige til at markere artikler fra kilder med lav troværdighed, når spillere kan se, at mange andre brugere har engageret sig i disse artikler. Eksponering for engagementsmålingerne skaber således en sårbarhed.

Folkeskarernes visdom svigter, fordi den er bygget på den falske antagelse, at mængden består af forskellige, uafhængige kilder. Der kan være flere årsager til, at dette ikke er tilfældet.

Først, på grund af folks tendens til at omgås lignende mennesker, deres onlinekvarterer er ikke særlig forskellige. Den lethed, hvormed brugere af sociale medier kan blive venner med dem, de er uenige med, skubber folk ind i homogene fællesskaber, ofte omtalt som ekkokamre.

Sekund, fordi mange menneskers venner er hinandens venner, de påvirker hinanden. Et berømt eksperiment viste, at det at vide, hvilken musik dine venner kan lide, påvirker dine egne erklærede præferencer. Dit sociale ønske om at indordne sig forvrænger din uafhængige dømmekraft.

Tredje, popularitetssignaler kan spilles. I årenes løb, søgemaskiner har udviklet sofistikerede teknikker til at modvirke såkaldte "link farms" og andre ordninger til at manipulere søgealgoritmer. Sociale medieplatforme, på den anden side, er lige begyndt at lære om deres egne sårbarheder.

Folk, der sigter på at manipulere informationsmarkedet, har oprettet falske konti, som trolde og sociale bots, og organiserede falske netværk. De har oversvømmet netværket for at skabe det indtryk, at en konspirationsteori eller en politisk kandidat er populær, at snyde både platformsalgoritmer og folks kognitive skævheder på én gang. De har endda ændret strukturen af sociale netværk for at skabe illusioner om flertallets meninger.

Opkald ned engagement

Hvad skal man gøre? Teknologiske platforme er i øjeblikket i defensiven. De bliver mere aggressive under valg med at fjerne falske konti og skadelig misinformation. Men disse bestræbelser kan være beslægtet med en omgang whack-a-mole.

En anderledes, forebyggende tilgang ville være at tilføje friktion. Med andre ord, at bremse processen med at sprede information. Højfrekvent adfærd såsom automatiseret like og deling kan hæmmes af CAPTCHA-tests eller gebyrer. Dette ville ikke kun mindske mulighederne for manipulation, men med mindre information ville folk være i stand til at være mere opmærksomme på, hvad de ser. Det ville give mindre plads til engagement bias at påvirke folks beslutninger.

Det ville også hjælpe, hvis sociale medievirksomheder justerede deres algoritmer til at stole mindre på engagement for at bestemme det indhold, de tjener dig. Måske vil afsløringerne af Facebooks viden om troldefarme, der udnytter engagement, give den nødvendige fremdrift.

Denne artikel er genudgivet fra The Conversation under en Creative Commons-licens. Læs den originale artikel.

Varme artikler

Varme artikler

-

Mini-mod hjem kan hjælpe hårde sovende med at komme væk fra gaden for altid:studereInde i et af de første modulopbyggede mini-hjem i England skabt til dem, der oplever hjemløshed. Kredit:Jimmys Cambridge En ny undersøgelse af de første modulære mini-hjem i England skabt til dem,

Mini-mod hjem kan hjælpe hårde sovende med at komme væk fra gaden for altid:studereInde i et af de første modulopbyggede mini-hjem i England skabt til dem, der oplever hjemløshed. Kredit:Jimmys Cambridge En ny undersøgelse af de første modulære mini-hjem i England skabt til dem, -

Vejr forbundet med følelser udtrykt på sociale medierKredit:George Hodan/public domain Følelser udtrykt på Facebook og Twitter kan være forbundet med visse vejrmønstre, ifølge en undersøgelse offentliggjort 25. april, 2018 i open-access journal PLO

Vejr forbundet med følelser udtrykt på sociale medierKredit:George Hodan/public domain Følelser udtrykt på Facebook og Twitter kan være forbundet med visse vejrmønstre, ifølge en undersøgelse offentliggjort 25. april, 2018 i open-access journal PLO -

Hvad er brugen af genteknologi til at overføre humane gener til bakterier?Overførsel af et humant gen til bakterier er en nyttig måde at gøre mere af det gens proteinprodukt på. Det er også en måde at skabe mutante former af et humant gen, der kan genindføres i humane celle

Hvad er brugen af genteknologi til at overføre humane gener til bakterier?Overførsel af et humant gen til bakterier er en nyttig måde at gøre mere af det gens proteinprodukt på. Det er også en måde at skabe mutante former af et humant gen, der kan genindføres i humane celle -

Hånddesinfektionsmiddel er fantastisk til at bevare insekt -DNAForskere har opdaget, at håndsprit er et rigtig godt konserveringsmiddel for insekter som denne barkbille. Kschulze/Ullstein Bild/Getty/HowStuffWorks For det sidste årti, hære af barkbiller har været

Hånddesinfektionsmiddel er fantastisk til at bevare insekt -DNAForskere har opdaget, at håndsprit er et rigtig godt konserveringsmiddel for insekter som denne barkbille. Kschulze/Ullstein Bild/Getty/HowStuffWorks For det sidste årti, hære af barkbiller har været

- Dit personlige rum er ikke længere fysisk - det er et globalt datanetværk

- Forskerteam udvikler nye kompakte og energieffektive nanoskala mikrobølgeoscillatorer

- Olieplatforme kunne pumpe emissioner under Nordsøen

- Båndbredde til allestedsnærværende 5G og mere kan være lige rundt om hjørnet med dette nye mikr…

- Observerer nano-bio-interaktioner i realtid

- Kulstøv bliver hvidt sne sort i den sibiriske by