Computersystemet transskriberer ord, som brugerne taler lydløst

Arnav Kapur, en forsker i gruppen Fluid Interfaces på MIT Media Lab, demonstrerer AlterEgo -projektet .. Kredit:Lorrie Lejeune/MIT

MIT -forskere har udviklet en computergrænseflade, der kan transskribere ord, som brugeren verbaliserer internt, men faktisk ikke taler højt.

Systemet består af en bærbar enhed og et tilhørende computersystem. Elektroder i enheden opfanger neuromuskulære signaler i kæben og ansigtet, der udløses af interne verbaliseringer - siger ord "i dit hoved" - men er ikke detekterbare for det menneskelige øje. Signalerne føres til et maskinlæringssystem, der er blevet uddannet til at korrelere bestemte signaler med bestemte ord.

Enheden indeholder også et par knogleledende hovedtelefoner, som overfører vibrationer gennem ansigtets knogler til det indre øre. Fordi de ikke blokerer øregangen, hovedtelefonerne gør det muligt for systemet at formidle information til brugeren uden at afbryde samtalen eller på anden måde forstyrre brugerens auditive oplevelse.

Enheden er således en del af et komplet lydløst computingsystem, der lader brugeren uopdageligt stille og modtage svar på vanskelige beregningsproblemer. I et af forskernes eksperimenter, for eksempel, emner brugte systemet til lydløst at rapportere modstanderes træk i et skakspil og lige så stille modtage computeranbefalede svar.

"Motivationen til dette var at bygge en IA-enhed-en intelligensforstørrelsesenhed, "siger Arnav Kapur, en kandidatstuderende ved MIT Media Lab, der ledede udviklingen af det nye system. "Vores idé var:Kunne vi have en computerplatform, der er mere intern, der smelter sammen menneske og maskine på nogle måder, og det føles som en intern forlængelse af vores egen erkendelse? "

"Vi kan stort set ikke leve uden vores mobiltelefoner, vores digitale enheder, "siger Pattie Maes, en professor i mediekunst og videnskab og kapurs specialevejleder. "Men i øjeblikket brugen af disse enheder er meget forstyrrende. Hvis jeg vil slå noget op, der er relevant for en samtale, jeg har, Jeg skal finde min telefon og indtaste adgangskoden og åbne en app og indtaste et søgeord, og det hele kræver, at jeg helt skifter opmærksomhed fra mit miljø og de mennesker, jeg er sammen med, til selve telefonen. Så, mine studerende og jeg har i meget lang tid eksperimenteret med nye formfaktorer og nye former for oplevelser, der gør det muligt for folk stadig at drage fordel af al den vidunderlige viden og service, som disse enheder giver os, men gør det på en måde, så de kan forblive i nuet. "

Forskerne beskriver deres enhed i et papir, de præsenterede på Association for Computing Machinery's ACM Intelligent User Interface -konference. Kapur er første forfatter på papiret, Maes er seniorforfatter, og de får selskab af Shreyas Kapur, en bachelor i elektroteknik og datalogi.

Subtile signaler

Ideen om, at interne verbaliseringer har fysiske korrelater, har eksisteret siden 1800 -tallet, og det blev seriøst undersøgt i 1950'erne. Et af målene med hastighedslæsningsbevægelsen i 1960'erne var at eliminere intern verbalisering, eller "subvokalisering, "som det er kendt.

Men subvokalisering som computerinterface er stort set uudforsket. Forskernes første trin var at bestemme, hvilke steder i ansigtet der er kilderne til de mest pålidelige neuromuskulære signaler. Så de gennemførte eksperimenter, hvor de samme emner blev bedt om at subvokalisere den samme række ord fire gange, med en række 16 elektroder på forskellige ansigtssteder hver gang.

Forskerne skrev kode for at analysere de resulterende data og fandt ud af, at signaler fra syv bestemte elektrodeplaceringer konsekvent var i stand til at skelne subvokaliserede ord. I konferencepapiret, forskerne rapporterer en prototype af en bærbar grænseflade for tavse tale, som vikler rundt om nakken som et telefonhovedtelefon og har tentakellignende buede vedhæng, der rører ansigtet på syv steder på hver side af munden og langs kæberne.

Men i de nuværende forsøg forskerne får sammenlignelige resultater ved kun at bruge fire elektroder langs en kæbe, hvilket skulle føre til en mindre påtrængende bærbar enhed.

Når de havde valgt elektrodeplaceringerne, forskerne begyndte at indsamle data om et par beregningsopgaver med begrænsede ordforråd - cirka 20 ord hver. Den ene var aritmetisk, hvor brugeren ville subvokalisere store additions- eller multiplikationsproblemer; en anden var skakansøgningen, hvor brugeren ville rapportere træk ved hjælp af standard skaknummereringssystemet.

Derefter, for hver ansøgning de brugte et neuralt netværk til at finde sammenhænge mellem bestemte neuromuskulære signaler og bestemte ord. Ligesom de fleste neurale netværk, den, forskerne brugte, er arrangeret i lag af enkle behandlingsnoder, hver af dem er forbundet til flere noder i lagene over og under. Data føres ind i bundlaget, hvis noder behandler det og sender dem til det næste lag, hvis noder behandler det og sender dem til det næste lag, og så videre. Outputtet af det endelige lagudbytte er resultatet af en eller anden klassificeringsopgave.

Den grundlæggende konfiguration af forskernes system inkluderer et neuralt netværk, der er uddannet til at identificere subvokaliserede ord fra neuromuskulære signaler, men det kan tilpasses til en bestemt bruger gennem en proces, der kun omskoler de sidste to lag.

Praktiske spørgsmål

Ved hjælp af prototypen bærbar grænseflade, forskerne gennemførte en brugervenlighedsundersøgelse, hvor 10 forsøgspersoner brugte cirka 15 minutter hver på at tilpasse den aritmetiske applikation til deres egen neurofysiologi, brugte derefter yderligere 90 minutter på at bruge det til at udføre beregninger. I den undersøgelse, systemet havde en gennemsnitlig transkriptionsnøjagtighed på omkring 92 procent.

Men, Kapur siger, systemets ydeevne bør forbedres med flere træningsdata, som kunne indsamles under normal brug. Selvom han ikke har knust tallene, han vurderer, at det bedre uddannede system, han bruger til demonstrationer, har en nøjagtighedsrate, der er højere end den, der er rapporteret i brugervenlighedsundersøgelsen.

I det løbende arbejde, forskerne indsamler et væld af data om mere detaljerede samtaler, i håb om at bygge applikationer med meget mere ekspansive ordforråd. "Vi er midt i at indsamle data, og resultaterne ser pæne ud, "Kapur siger." Jeg tror, vi får en fuld samtale en dag. "

"Jeg tror, at de er lidt underbud på, hvad jeg synes er et reelt potentiale for arbejdet, "siger Thad Starner, en professor i Georgia Tech's College of Computing. "Synes godt om, sige, at kontrollere flyene på asfalten i Hartsfield lufthavn her i Atlanta. Du har jetstøj rundt omkring dig, du har disse store øreværn på-ville det ikke være fantastisk at kommunikere med stemmen i et miljø, hvor du normalt ikke ville være i stand til det? Du kan forestille dig alle disse situationer, hvor du har et støjsvagt miljø, som et hangarskibs flygedæk, eller endda steder med en masse maskiner, som et kraftværk eller en trykpresse. Dette er et system, der ville give mening, især fordi folk i denne type situationer ofte bruger beskyttelsesudstyr. For eksempel, hvis du er en jagerpilot, eller hvis du er brandmand, du har allerede disse masker på. "

"Den anden ting, hvor dette er ekstremt nyttigt, er særlige ops, "Tilføjer Starner." Der er mange steder, hvor det ikke er et støjende miljø, men et stille miljø. En masse tid, special-ops folk har håndbevægelser, men du kan ikke altid se dem. Ville det ikke være fantastisk at have lydløs tale til kommunikation mellem disse mennesker? Den sidste er mennesker med handicap, hvor de ikke kan stemme normalt. For eksempel, Roger Ebert havde ikke evnen til at tale mere, fordi han mistede kæben for kræft. Kunne han lave denne slags tavse tale og derefter have en synthesizer, der ville tale ordene? "

Denne historie er genudgivet med tilladelse fra MIT News (web.mit.edu/newsoffice/), et populært websted, der dækker nyheder om MIT -forskning, innovation og undervisning.

Sidste artikelZiplines levering drone system redesign øger mulighederne

Næste artikelHvad gør en hurtigere maskinskriver?

Varme artikler

Varme artikler

-

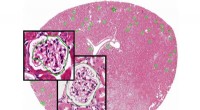

Nyt segmenteringsværktøj giver læger mulighed for at lære computere at annotere medicinske bille…Billedet viser, hvordan UB-værktøjet fungerer, når de anvendes på histologiske billeddata. Det store baggrundsbillede viser et musenyrevævssnit med nyrestrukturer kaldet glomeruli markeret via automat

Nyt segmenteringsværktøj giver læger mulighed for at lære computere at annotere medicinske bille…Billedet viser, hvordan UB-værktøjet fungerer, når de anvendes på histologiske billeddata. Det store baggrundsbillede viser et musenyrevævssnit med nyrestrukturer kaldet glomeruli markeret via automat -

Brasiliens domstol omstøder suspensionen af Boeing-Embraer-bindingenBoeing og Embraer har foreslået en binding, der vil give den amerikanske rumfartsgigant en 80 procents ejerandel i det brasilianske selskabs kommercielle luftfartsforretning En appeldomstol i Bras

Brasiliens domstol omstøder suspensionen af Boeing-Embraer-bindingenBoeing og Embraer har foreslået en binding, der vil give den amerikanske rumfartsgigant en 80 procents ejerandel i det brasilianske selskabs kommercielle luftfartsforretning En appeldomstol i Bras -

Atomindustrien satser stort på små kraftværkerNuScale Power sigter mod at bygge landets første avancerede lille modulære reaktor. Kredit:US Department of Energy Indtil nu, at producere atomkraft har krævet massive faciliteter omgivet af hekta

Atomindustrien satser stort på små kraftværkerNuScale Power sigter mod at bygge landets første avancerede lille modulære reaktor. Kredit:US Department of Energy Indtil nu, at producere atomkraft har krævet massive faciliteter omgivet af hekta -

Ville du droppe din bil, hvis offentlig transport var gratis? Her er hvad forskere har fundetAt reducere trængsel og luftforurening kræver færre biler. Kredit:Kichigin/Shutterstock Luxembourg blev for nylig det første land i verden, der gjorde al offentlig transport gratis. Fra 1. marts 2

Ville du droppe din bil, hvis offentlig transport var gratis? Her er hvad forskere har fundetAt reducere trængsel og luftforurening kræver færre biler. Kredit:Kichigin/Shutterstock Luxembourg blev for nylig det første land i verden, der gjorde al offentlig transport gratis. Fra 1. marts 2

- Genbrug af vand kan være nøglen til fremtiden for hydraulisk frakturering

- Elektroniske kredsløb printet med én mikron opløsning

- Datamodeller peger på en potentielt forskelligartet metabolisk menu hos Enceladus

- Afslutning af orlov vil ramme ældre arbejdstagere hårdt:Sådan mildnes slaget

- Video:Flyv din satellit!

- Hvordan COVID-19 påvirker landmænd og fødevareforsyningskæden