Kunstig intelligens – mellem videnskabelig, etiske og kommercielle spørgsmål

Den 18. marts i Tempe, Arizona, en selvkørende Uber-bil ramte og dræbte Elaine Herzberg, som gik sin cykel over en gade. Den menneskelige chauffør skulle overvåge bilens adfærd, men gjorde det ikke. Dets systemer opdagede tilsyneladende ikke offeret, da den hverken satte farten ned eller forsøgte at undgå at ramme. Kredit:Herzberg Wikimedia

Det fatale uheld med en selvkørende bil drevet af Uber i USA var en tragisk, men rettidig påmindelse om farerne ved virksomheder, der skynder sig at implementere kunstig intelligens for at være de første på markedet.

På tidspunktet for styrtet, chaufføren, der skulle have været klar til at reagere i netop sådan en hændelse som denne, kiggede ned. Selve bilen havde tilsyneladende helt undladt at se fodgængeren og satte ikke farten ned eller forsøgte at undgå at ramme hende.

Test i den virkelige verden, og risici

Igen, vi ser en teknologi, der primært bliver testet til at fungere under normale forhold, så den kan rulles ud på markedet og ikke nødvendigvis bygges med sikkerhed som det primære fokus. Som den tidligere udvikler af Ubers machine learning og AI-platform har sagt, bilfirmaer bør træne deres biler i simulerede miljøer, som kan programmeres til at træne dem i, hvordan de opdager og undgår en række muligheder for tilfældige hændelser, som bilen kan støde på på vejen.

Machine learning lider af et grundlæggende problem, idet dens evne til at udføre en opgave afhænger af data, der bruges til at træne den. Hvilken nøjagtige algoritme den ender med at bruge til at opfylde sit endelige formål, og hvilke funktioner der er de vigtigste, er stort set ukendt. Med dyb læring, de mange lag, der udgør maskinlæringssoftwarens overordnede neurale netværk, gør denne proces endnu mere mystisk og ukendt.

Vi ved, at maskinlæringssoftware opfanger skævheder i de data, der bruges til at teste det. Software, der bruges til at beregne risikoen for, at en gerningsmand begår en fremtidig forbrydelse, og som ofte bruges af domstole i USA, har vist sig systematisk at beregne en væsentlig lavere risiko for hvide lovovertrædere end for farvede personer. Andre forskere har vist, at maskinlæringsalgoritmer lærer kønsbias, der er iboende i de tekster, der bruges til at træne dem.

Farerne ved nu at vide, hvordan tingene fungerer, er tydeligt blevet demonstreret af Facebooks nylige indrømmelse af, at det virkelig ikke vidste, hvad folk gjorde med data fra millioner af dets brugere, som Facebook havde opfordret dem til at tage. Med brugen af sin platform til spredning af målrettede falske nyheder under det amerikanske præsidentvalg, Facebook indrømmede igen, at det ikke havde indset, at udenlandske regeringer ville udnytte denne naivitet til at underminere demokratiet.

Mere end bare Facebook

Det ville være forkert at udpege Facebook for at være den eneste virksomhed, der ikke vidste, at deres software kunne udnyttes til at skade enkeltpersoner og samfund. Ændringerne af "retten til at blive glemt" til databeskyttelseslovgivningen og vedtaget af Den Europæiske Union blev formuleret specifikt for at håndtere Googles manglende vilje til at rette op på bivirkninger af sin søgning på privatlivets fred. Lovgivning i mange lande for at gøre indberetning af databrud obligatorisk, har været nødvendig, fordi virksomheder ikke var villige til at tage cybersikkerhed, og beskyttelse af deres brugeres data, helt seriøst.

I betragtning af fortiden, der er ingen grund til at tro, at virksomheder, der implementerer systemer baseret på AI, tænker på sikkerhed og privatliv ved design. Tværtimod, maskinlæring kræver data, meget af det, og så virksomheder erhverver enorme datalagre med detaljeret information for at udnytte dem gennem algoritmer. Mens man kan argumentere for, at man håndterede ansvarligt, store mængder data vil være uvurderlige for forskning, i sundhedsspørgsmål, især risikoen ved at indsamle, lagring og brug af disse data, især i kommercielle omgivelser er meget høje.

Den franske regerings rapport

I Frankrig, Cédric Villani – den feltprisvindende matematiker og medlem af nationalforsamlingen – har leveret sin endelige rapport, der beskriver en national strategi for undersøgelse og udnyttelse af kunstig intelligens. Anbefalingerne dækker mange af de potentielle problemer, der kan opstå ved at forsøge at balancere kravene til forskning, innovation og kommercialisering af kunstig intelligens. De anerkender også behovet for at beskytte samfundet og individers privatliv og sikkerhed og foreslår en aktiv rolle for regeringen i at sikre, at AI bruges på en måde, der gavner samfundet og respekterer menneskerettigheder og værdier.

Imidlertid, intet af dette bliver nemt. Der har allerede været påstande om, at Europas generelle databeskyttelsesforordning (GDPR) træder i fuld kraft den 25. vil sætte EU-virksomheder i en konkurrencemæssig ulempe sammenlignet med deres konkurrenter i Nordamerika og Asien.

Man må håbe, at tragedier som den 49-årige Elaine Herzbergs død, kørt ned af en selvkørende Uber-bil, og den udbredte forargelse af Facebooks tilsidesættelse af sine brugeres personlige data vil minde folk om, at der er en fordel ved målte teknologiske fremskridt og ikke nutidens mantra om teknologiske fremskridt for enhver pris.

Denne artikel blev oprindeligt publiceret på The Conversation. Læs den originale artikel.  Denne artikel blev oprindeligt publiceret på The Conversation. Læs den originale artikel.

Denne artikel blev oprindeligt publiceret på The Conversation. Læs den originale artikel.

Sidste artikelStyrker fremskridt inden for trådløs forbindelse til fremtiden

Næste artikelRobotter, der kan lære som mennesker

Varme artikler

Varme artikler

-

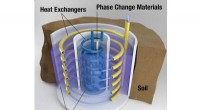

Geotermisk energilagringssystem for at reducere spidsbelastningen af elektricitetORNL -forskere har udviklet et system, der lagrer elektricitet som termisk energi i underjordiske tanke, giver boligejere mulighed for at reducere deres elkøb i spidsbelastningsperioder og samtidig hj

Geotermisk energilagringssystem for at reducere spidsbelastningen af elektricitetORNL -forskere har udviklet et system, der lagrer elektricitet som termisk energi i underjordiske tanke, giver boligejere mulighed for at reducere deres elkøb i spidsbelastningsperioder og samtidig hj -

Systemet gør det muligt for overvågningskameraer at tale med offentligheden gennem individuelle sm…Byregeringer vil kunne bruge Purdue Universitys offentlige kamerateknologi til at sende advarsler til distraherede fodgængere, når biler nærmer sig. Kredit:Purdue University Purdue University-forsk

Systemet gør det muligt for overvågningskameraer at tale med offentligheden gennem individuelle sm…Byregeringer vil kunne bruge Purdue Universitys offentlige kamerateknologi til at sende advarsler til distraherede fodgængere, når biler nærmer sig. Kredit:Purdue University Purdue University-forsk -

Neurale netværk muliggør autonom navigation af katetreI fremtiden, kunstig intelligens vil hjælpe neuroradiologer under endovaskulær kirurgi. Kredit:Fraunhofer-Gesellschaft Når en patient får et slagtilfælde, hvert minut tæller. Her, hurtig handling

Neurale netværk muliggør autonom navigation af katetreI fremtiden, kunstig intelligens vil hjælpe neuroradiologer under endovaskulær kirurgi. Kredit:Fraunhofer-Gesellschaft Når en patient får et slagtilfælde, hvert minut tæller. Her, hurtig handling -

General Motors strejke nærmer sig tredje ugeTidligere på ugen, Bernie Sanders blev den seneste demokratiske præsidentkandidat til at besøge strejkende UAW-arbejdere på en General Motors fabrik Repræsentanter fra General Motors og United Aut

General Motors strejke nærmer sig tredje ugeTidligere på ugen, Bernie Sanders blev den seneste demokratiske præsidentkandidat til at besøge strejkende UAW-arbejdere på en General Motors fabrik Repræsentanter fra General Motors og United Aut

- Ny analyse af hjernens netværksaktivitet giver unik indsigt i epileptiske anfald

- Sådan fjerner du olie fra havvand

- I fodsporene af SpaceX - en kinesisk virksomhed ser udviklingen af en genanvendelig løfteraket

- For skisportssteder i det vestlige USA, for meget sne er en god ve

- Ny kilde til jordskælv og tsunamier i Greater Tokyo-regionen identificeret

- Sådan gennemsnitlig to procentprocent