AI-forskere designer et privatlivsfilter til dine billeder, der deaktiverer ansigtsgenkendelsessystemer

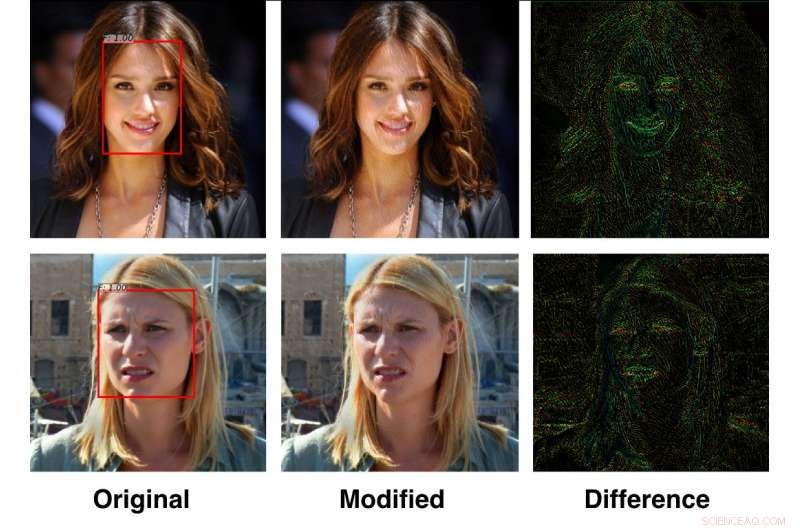

Forskere i U of T Engineering har designet et 'privatlivsfilter', der forstyrrer ansigtsgenkendelsesalgoritmer. Systemet er afhængigt af to AI-skabte algoritmer:den ene udfører kontinuerlig ansigtsgenkendelse, og en anden designet til at forstyrre den første. Kredit:Avishek Bose

Hver gang du uploader et billede eller en video til en social medieplatform, dets ansigtsgenkendelsessystemer lærer lidt mere om dig. Disse algoritmer indtager data om, hvem du er, din placering og personer, du kender – og de forbedres konstant.

Efterhånden som bekymringerne for privatliv og datasikkerhed på sociale netværk vokser, U of T Engineering-forskere ledet af professor Parham Aarabi og kandidatstuderende Avishek Bose har skabt en algoritme til dynamisk at forstyrre ansigtsgenkendelsessystemer.

"Personligt privatliv er et reelt problem, da ansigtsgenkendelse bliver bedre og bedre, " siger Aarabi. "Dette er en måde, hvorpå nyttige anti-ansigtsgenkendelsessystemer kan bekæmpe denne evne."

Deres løsning udnytter en dyb læringsteknik kaldet modstridende træning, som stiller to kunstig intelligens-algoritmer op mod hinanden. Aarabi og Bose designede et sæt af to neurale netværk:det første arbejde med at identificere ansigter, og den anden arbejder på at forstyrre den førstes ansigtsgenkendelsesopgave. De to kæmper konstant og lærer af hinanden, opsætning af et igangværende AI-våbenkapløb.

Resultatet er et Instagram-lignende filter, der kan anvendes på billeder for at beskytte privatlivets fred. Deres algoritme ændrer meget specifikke pixels i billedet, lave ændringer, der næsten er umærkelige for det menneskelige øje.

"Den forstyrrende AI kan 'angribe', hvad det neurale net til ansigtsdetektion leder efter, " siger Bose. "Hvis detektions-AI leder efter øjenkrogen, for eksempel, den justerer øjenkrogene, så de er mindre synlige. Det skaber meget subtile forstyrrelser i billedet, men for detektoren er de betydelige nok til at narre systemet."

Aarabi og Bose testede deres system på 300-W ansigtsdatasættet, en industristandardpool med mere end 600 ansigter, der omfatter en bred vifte af etniciteter, lysforhold og miljøer. De viste, at deres system kunne reducere andelen af ansigter, der oprindeligt kunne påvises, fra næsten 100 procent ned til 0,5 procent.

"Nøglen her var at træne de to neurale netværk mod hinanden - hvor det ene skaber et stadig mere robust ansigtsdetektionssystem, og den anden skaber et stadig stærkere værktøj til at deaktivere ansigtsgenkendelse, " siger Bose, hovedforfatter på projektet. Holdets undersøgelse vil blive offentliggjort og præsenteret på 2018 IEEE International Workshop on Multimedia Signal Processing senere på sommeren.

Ud over at deaktivere ansigtsgenkendelse, den nye teknologi forstyrrer også billedbaseret søgning, funktionsidentifikation, vurdering af følelser og etnicitet, og alle andre ansigtsbaserede attributter, der kunne udtrækkes automatisk.

Næste, teamet håber at gøre privatlivsfilteret offentligt tilgængeligt, enten via en app eller en hjemmeside.

"For ti år siden skulle disse algoritmer defineres af mennesker, men nu lærer neurale net af sig selv – du behøver ikke at levere dem andet end træningsdata, " siger Aarabi. "I sidste ende kan de gøre nogle virkelig fantastiske ting. Det er en fascinerende tid i marken, der er et enormt potentiale."

Varme artikler

Varme artikler

-

En projektor havde alt for sjov med bilteknologiStop det. Kan du narre et Tesla Autopilot-system med en projektor? Virkelig, betragtes et projiceret billede af et menneske af bilsystemet som en virkelig person? Og siger du, at Mobileye 630 PRO b

En projektor havde alt for sjov med bilteknologiStop det. Kan du narre et Tesla Autopilot-system med en projektor? Virkelig, betragtes et projiceret billede af et menneske af bilsystemet som en virkelig person? Og siger du, at Mobileye 630 PRO b -

Gendannelse af balance i maskinlæringsdatasætFem repræsentative prøver for hver klasse (række) i CIFAR-10-datasættet. For hver klasse, disse prøver er opnået med generative modeller trænet efter at have droppet 40 % af billederne fra den specifi

Gendannelse af balance i maskinlæringsdatasætFem repræsentative prøver for hver klasse (række) i CIFAR-10-datasættet. For hver klasse, disse prøver er opnået med generative modeller trænet efter at have droppet 40 % af billederne fra den specifi -

Hvorfor svulmer og revner beton?Betonstrukturer, der er blevet beskadiget af AAR (alkali-aggregatreaktion), udviser disse typiske revner. Den mørke farve rundt om kanterne af revnerne er forårsaget af utætte AAR-produkter. Kredit:Sw

Hvorfor svulmer og revner beton?Betonstrukturer, der er blevet beskadiget af AAR (alkali-aggregatreaktion), udviser disse typiske revner. Den mørke farve rundt om kanterne af revnerne er forårsaget af utætte AAR-produkter. Kredit:Sw -

Brug af AI til at udvikle nye smagsoplevelserSkærmbillede af teknologi baseret på IBM Research AI til produktsammensætning brugt af McCormick &Company til smagsudvikling. Kredit:McCormick &Company McCormick &Company, en pioner inden for smag

Brug af AI til at udvikle nye smagsoplevelserSkærmbillede af teknologi baseret på IBM Research AI til produktsammensætning brugt af McCormick &Company til smagsudvikling. Kredit:McCormick &Company McCormick &Company, en pioner inden for smag

- Bred genetisk variation på den pontisk-kaspiske steppe

- Forstærker til terahertz gittervibrationer i en halvlederkrystal

- Fakta om cedertræer

- Nye luftstrømsvideoer viser, hvorfor masker med udåndingsventiler ikke bremser spredningen af CO…

- Forskere analyserer struktur, mekanisme for fagprotein, der stjæler elektroner

- Trojanske hesteproteiner er et skridt fremad for nanopartikelbaserede anticancer- og demensbehandlin…