Lukning af løkken for robotgreb

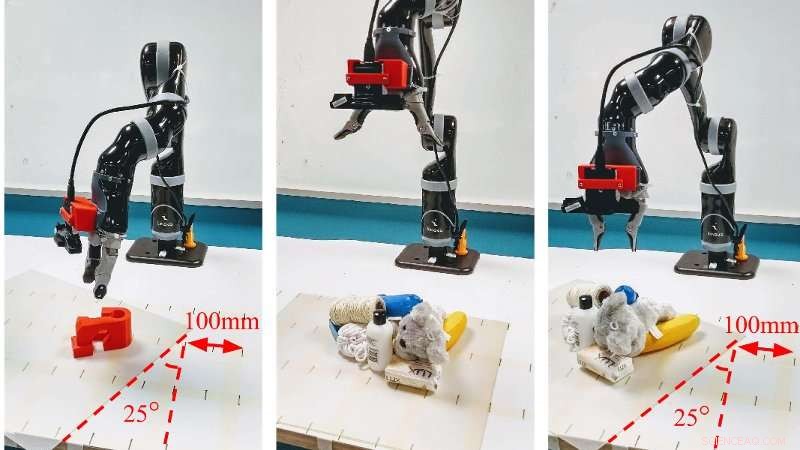

Kredit:Queensland University of Technology

Robotikere hos QUT har udviklet en hurtigere og mere præcis måde, hvorpå robotter kan gribe objekter, herunder i rodede og skiftende miljøer, som har potentiale til at forbedre deres anvendelighed i både industrielle og private omgivelser.

- Den nye tilgang gør det muligt for en robot hurtigt at scanne miljøet og kortlægge hver pixel, den fanger til dens grebskvalitet ved hjælp af et dybdebillede

- Tests fra den virkelige verden har opnået høje nøjagtighedsgrader på op til 88 % for dynamisk greb og op til 92 % i statiske eksperimenter.

- Tilgangen er baseret på et Generative Grasping Convolutional Neural Network

QUTs Dr. Jürgen Leitner sagde, at det var en grundlæggende opgave for mennesker at gribe og tage en genstand op, det havde vist sig utroligt svært for maskiner.

"Vi har været i stand til at programmere robotter, i meget kontrollerede miljøer, at hente meget specifikke varer. Imidlertid, en af de vigtigste mangler ved nuværende robotgribesystemer er manglende evne til hurtigt at tilpasse sig forandringer, som når en genstand bliver flyttet, " sagde Dr. Leitner.

"Verden er ikke forudsigelig - ting ændrer sig og bevæger sig og bliver blandet sammen og, tit, det sker uden varsel – så robotter skal være i stand til at tilpasse sig og arbejde i meget ustrukturerede miljøer, hvis vi vil have dem til at være effektive, " han sagde.

Den nye metode, udviklet af Ph.D. forsker Douglas Morrison, Dr. Leitner og den fremtrædende professor Peter Corke fra QUT's Science and Engineering Fakultet, er en realtid, objektuafhængig gribesyntesemetode til greb i lukket sløjfe.

"Den Generative Grasping Convolutional Neural Network-tilgang fungerer ved at forudsige kvaliteten og posituren af et to-fingret greb ved hver pixel. Ved at kortlægge, hvad der er foran den ved hjælp af et dybdebillede i en enkelt passage, robotten behøver ikke at prøve mange forskellige mulige greb, før den træffer en beslutning, undgå lange regnetider, " sagde hr. Morrison.

"I vores test i den virkelige verden, vi opnåede en succesrate på 83 % på et sæt hidtil usete objekter med modstridende geometri og 88 % på et sæt husholdningsgenstande, der blev flyttet under grebsforsøget. Vi opnår også 81 % nøjagtighed, når vi griber i dynamisk rod."

Dr. Leitner sagde, at tilgangen overvandt en række begrænsninger ved de nuværende dyb-lærende gribeteknikker.

"For eksempel, i Amazon Picking Challenge, som vores hold vandt i 2017, vores robot CartMan ville kigge ind i en beholder med genstande, tage en beslutning om, hvor det bedste sted var at gribe en genstand og derefter blindt gå ind for at prøve at samle den op, " han sagde

"Ved at bruge denne nye metode, vi kan behandle billeder af de objekter, som en robot ser inden for omkring 20 millisekunder, som giver robotten mulighed for at opdatere sin beslutning om, hvor den skal gribe et objekt og derefter gøre det med meget større formål. Dette er især vigtigt i rodede rum, " han sagde.

Kredit:Queensland University of Technology

Dr. Leitner sagde, at forbedringerne ville være værdifulde for industriel automatisering og i hjemmet.

"Denne forskningslinje gør os i stand til at bruge robotsystemer, ikke kun i strukturerede omgivelser, hvor hele fabrikken er bygget baseret på robotegenskaber. Den giver os også mulighed for at gribe objekter i ustrukturerede miljøer, hvor tingene ikke er perfekt planlagt og ordnet, og robotter skal tilpasse sig forandringer.

"Dette har fordele for industrien – fra lagre til online shopping og sortering, til frugtplukning. Det kan også bruges i hjemmet, efterhånden som mere intelligente robotter udvikles til ikke bare at støvsuge eller moppe et gulv, men også at samle ting op og lægge dem væk."

Holdets papir Closing the Loop for Robotic Grasping:A Real-time, Generative Grasp Synthesis Approach vil blive præsenteret i denne uge på Robotics:Science and Systems, den mest selektive internationale robotkonference, som afholdes på Carnegie Mellon University i Pittsburgh USA.

Sidste artikelUber vinder licens tilbage i London - men er sat på prøve

Næste artikelFotoforfalskning fanget via overlisteteknikker

Varme artikler

Varme artikler

-

Løsning af et 50 år gammelt puslespil inden for signalbehandling, del toHer er tre eksempler på 16-punkts chirp-konturer på enhedscirklen. ICZT-algoritmen udviklet af Iowa State-ingeniører kan arbejde med alle tre, mens den tidligere brugte kun kan arbejde med den sidste

Løsning af et 50 år gammelt puslespil inden for signalbehandling, del toHer er tre eksempler på 16-punkts chirp-konturer på enhedscirklen. ICZT-algoritmen udviklet af Iowa State-ingeniører kan arbejde med alle tre, mens den tidligere brugte kun kan arbejde med den sidste -

En selvhelende svedfølerKredit:American Chemical Society Bærbare sensorer, der sporer puls eller trin, er populære fitnessprodukter. Men i fremtiden, en god sved kan give nyttig information om en persons helbred. Nu, for

En selvhelende svedfølerKredit:American Chemical Society Bærbare sensorer, der sporer puls eller trin, er populære fitnessprodukter. Men i fremtiden, en god sved kan give nyttig information om en persons helbred. Nu, for -

Forskere ser på tidligere databehandlinger for at låse op for 3-D-printede mekaniske logiske porte…Forskere og ingeniører fra Lawrence Livermore National Laboratory kombinerer mekanisk databehandling med 3D-printning som en del af et forsøg på at skabe følende materialer, der kan reagere på ændring

Forskere ser på tidligere databehandlinger for at låse op for 3-D-printede mekaniske logiske porte…Forskere og ingeniører fra Lawrence Livermore National Laboratory kombinerer mekanisk databehandling med 3D-printning som en del af et forsøg på at skabe følende materialer, der kan reagere på ændring -

Bærbar køle- og varmeplaster kan tjene som personlig termostat og spare energiPrototype af køle- og varmeplasteret indlejret i et mesh-armbånd. Kredit:David Baillot/UC San Diego Jacobs School of Engineering Ingeniører ved University of California San Diego har udviklet en b

Bærbar køle- og varmeplaster kan tjene som personlig termostat og spare energiPrototype af køle- og varmeplasteret indlejret i et mesh-armbånd. Kredit:David Baillot/UC San Diego Jacobs School of Engineering Ingeniører ved University of California San Diego har udviklet en b

- Nye fingeraftryk tilføjet til kemisk identifikationsdatabase

- Autonom robot, der interagerer med mennesker ved hjælp af naturligt sprog og synsbehandling

- Ekspeditionen måler solbevægelser set under sidste sommers totale solformørkelse

- PICO -detektor for mørkt stof mere følsom end forventet

- Hvordan Coronavirus har hjulpet med at rense luften

- Bookmakere udnytter fansens følelser for at tjene penge, viser ny forskning