Ingeniører udvikler nye teknikker til at narre objektdetekteringssystemer

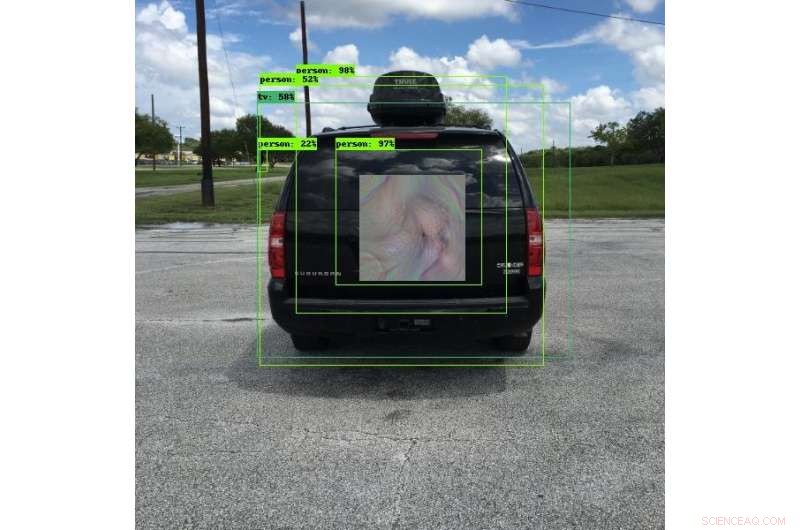

Mange af nutidens køretøjer bruger objektdetekteringssystemer til at hjælpe med at undgå kollisioner. SwRI-ingeniører udviklede unikke mønstre, der kan narre disse systemer til at se noget andet, at se genstandene et andet sted eller slet ikke se genstandene. På dette bilede, objektdetektionssystemet ser en person i stedet for et køretøj. Denne forskning vil give ingeniører mulighed for grundigt at teste objektdetekteringssystemer og forbedre sikkerheden for de dybe læringsalgoritmer, de bruger. Kredit:Southwest Research Institute

Nye modstridende teknikker udviklet af ingeniører ved Southwest Research Institute kan gøre objekter "usynlige" for billeddetekteringssystemer, der bruger dyb-læringsalgoritmer. Disse teknikker kan også narre systemer til at tro, at de ser et andet objekt eller kan ændre placeringen af objekter. Teknikken mindsker risikoen for kompromis i automatiserede billedbehandlingssystemer.

"Deep-learning neurale netværk er yderst effektive til mange opgaver, " siger forskningsingeniør Abe Garza fra SwRI Intelligent Systems Division. "Men, dyb læring blev vedtaget så hurtigt, at sikkerhedsimplikationerne af disse algoritmer ikke blev fuldt ud overvejet."

Deep-learning algoritmer udmærker sig ved at bruge former og farver til at genkende forskellene mellem mennesker og dyr eller biler og lastbiler, for eksempel. Disse systemer registrerer pålideligt objekter under en række forhold og, som sådan, bruges i utallige applikationer og industrier, ofte til sikkerhedskritiske formål. Bilindustrien bruger deep-learning objektdetektionssystemer på veje til vognbaneassistent, teknologier til vognbaneskift og kollisionsundgåelse. Disse køretøjer er afhængige af kameraer til at opdage potentielt farlige genstande omkring dem. Mens billedbehandlingssystemerne er afgørende for at beskytte liv og ejendom, Algoritmerne kan snydes af parter, der har til hensigt at forårsage skade.

Sikkerhedsforskere, der arbejder med "adversariel læring", finder og dokumenterer sårbarheder i dyb- og andre maskinlæringsalgoritmer. Ved at bruge SwRIs interne forskningsmidler, Garza og seniorforsker David Chambers udviklede noget, der ligner futuristisk, Mønstre i bøhmisk stil. Når den bæres af en person eller monteres på et køretøj, mønstrene narrer objektdetekteringskameraer til at tro, at objekterne ikke er der, at de er noget andet, eller at de er et andet sted. Ondsindede parter kan placere disse mønstre i nærheden af veje, potentielt skabe kaos for køretøjer udstyret med objektdetektorer.

Hvad der ligner et farverigt mønster for det menneskelige øje, ligner en cykel til et genstandsdetekteringssystem. Mens deep-learning algoritmer, der bruges i disse systemer, er pålidelige, de kan blive bedraget med specielle billeder. SwRI-forskere udvikler teknikker til at mindske risikoen for kompromis i disse systemer. Kredit:Southwest Research Institute

"Disse mønstre får algoritmerne i kameraet til enten at fejlklassificere eller fejlplacere objekter, skabe en sårbarhed, " sagde Garza. "Vi kalder disse mønstre 'perception invariant' adversarielle eksempler, fordi de ikke behøver at dække hele objektet eller være parallelle med kameraet for at narre algoritmen. Algoritmerne kan fejlklassificere objektet, så længe de fornemmer en del af mønsteret."

Selvom de kan ligne unikke og farverige udstillinger af kunst for det menneskelige øje, disse mønstre er designet på en sådan måde, at kamerasystemer til objektdetektering ser dem meget specifikt. Et mønster forklædt som en reklame på bagsiden af en standset bus kan få et kollisionsundgåelsessystem til at tro, at det ser en harmløs indkøbspose i stedet for bussen. Hvis køretøjets kamera ikke kan registrere det sande objekt, den kunne fortsætte med at bevæge sig fremad og ramme bussen, forårsager en potentielt alvorlig kollision.

"Det første skridt til at løse disse udnyttelser er at teste de dybe indlæringsalgoritmer, " sagde Garza. Holdet har skabt en ramme, der er i stand til gentagne gange at teste disse angreb mod en række deep-learning detektionsprogrammer, hvilket vil være yderst nyttigt til at teste løsninger.

SwRI-forskere fortsætter med at evaluere, hvor meget, eller hvor lidt, af mønsteret er nødvendig for at fejlklassificere eller fejlplacere et objekt. Arbejde med kunder, denne forskning vil give holdet mulighed for at teste objektdetekteringssystemer og i sidste ende forbedre sikkerheden ved deep-learning algoritmer.

Varme artikler

Varme artikler

-

Den amerikanske senator Schumer opfordrer til undersøgelse af FaceAppSchumer er ikke den eneste demokrat, der er bekymret Populær Rusland-baseret applikation FaceApp, som giver brugerne mulighed for at ændre deres udseende til at se ældre eller yngre ud, blev besku

Den amerikanske senator Schumer opfordrer til undersøgelse af FaceAppSchumer er ikke den eneste demokrat, der er bekymret Populær Rusland-baseret applikation FaceApp, som giver brugerne mulighed for at ændre deres udseende til at se ældre eller yngre ud, blev besku -

Mobiltelefoner hjælper med at omdanne katastrofehjælpMobiltelefoner kan bruges til at fastslå, hvor hjælp er mest nødvendig efter naturkatastrofer Mobiltelefoner hjælper med at omdanne, hvordan nødhjælpsorganisationer reagerer på humanitære kriser v

Mobiltelefoner hjælper med at omdanne katastrofehjælpMobiltelefoner kan bruges til at fastslå, hvor hjælp er mest nødvendig efter naturkatastrofer Mobiltelefoner hjælper med at omdanne, hvordan nødhjælpsorganisationer reagerer på humanitære kriser v -

Nanobowl -arrays giver perovskite solceller med iriserende farverSkematisk illustration og fotografier af farverige perovskite solceller baseret på nanobowl -arrays. Kredit:Science China Press Med modning af perovskit solceller (PSCer) teknologi, det er yderst

Nanobowl -arrays giver perovskite solceller med iriserende farverSkematisk illustration og fotografier af farverige perovskite solceller baseret på nanobowl -arrays. Kredit:Science China Press Med modning af perovskit solceller (PSCer) teknologi, det er yderst -

Ny vandsimulering fanger små detaljer selv i store scenerRamme fra en animation i realtid. Simuleringen dækker et enormt område med hundredvis af flydende objekter, men kan stadig indeholde små detaljer, der kun er synlige på tæt hold. Kredit:Stefan Jeschke

Ny vandsimulering fanger små detaljer selv i store scenerRamme fra en animation i realtid. Simuleringen dækker et enormt område med hundredvis af flydende objekter, men kan stadig indeholde små detaljer, der kun er synlige på tæt hold. Kredit:Stefan Jeschke

- Regner det i en ørken?

- Skal vi sige farvel til Arctics unikke natur?

- Bevis på, at store grupper reagerer langsommere på kriser på grund af falsk information

- <p> Genbrug er en moralsk ansvarlig beslutning, der er let at organisere, hvis du har en papirkurv. …

- Pendling i en alder af havstigning. Miami Beach -appen kunne fortælle dig, hvordan du undgår overs…

- Hvilken type levesteder lever krabber i?