Forbedring af sikkerheden, da kunstig intelligens flytter til smartphones

Kredit:Ji Lin

Smartphones, sikkerhedskameraer, og højttalere er blot nogle få af de enheder, der snart vil køre mere kunstig intelligens-software til at fremskynde billed- og talebehandlingsopgaver. En komprimeringsteknik, kendt som kvantisering, glatter vejen ved at gøre deep learning -modeller mindre for at reducere beregnings- og energiomkostninger. Men mindre modeller, det viser sig, gøre det lettere for ondsindede angribere at narre et AI-system til at opføre sig forkert-en bekymring, da mere kompleks beslutningstagning overdrages til maskiner.

I en ny undersøgelse, MIT- og IBM -forskere viser, hvor sårbare komprimerede AI -modeller er for modstridende angreb, og de tilbyder en løsning:tilføj en matematisk begrænsning under kvantiseringsprocessen for at reducere chancerne for, at en AI vil blive byttet til et lidt modificeret billede og fejlklassificere det, de ser.

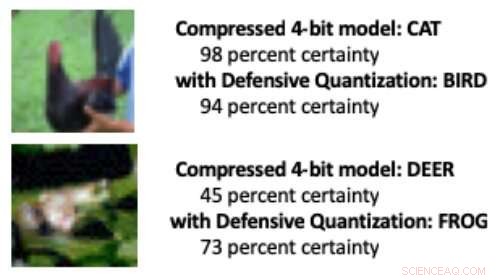

Når en deep learning -model reduceres fra standard 32 bit til en lavere bitlængde, Det er mere sandsynligt, at fejlklassificering af ændrede billeder skyldes en fejlforstærkningseffekt:Det manipulerede billede bliver mere forvrænget for hvert ekstra lag af behandling. Til sidst, modellen er mere tilbøjelig til at fejle en fugl med en kat, for eksempel, eller en frø til et rådyr.

Modeller kvantiseret til 8 bits eller færre er mere modtagelige for modstridende angreb, forskerne viser, med nøjagtighed, der falder fra en allerede lav 30-40 procent til mindre end 10 procent, når bitbredden falder. Men at kontrollere Lipschitz -begrænsningen under kvantisering genopretter en vis modstandsdygtighed. Da forskerne tilføjede begrænsningen, de så små præstationsgevinster i et angreb, med de mindre modeller i nogle tilfælde bedre end 32-bit modellen.

Da et par pixels blev manipuleret i ovenstående billeder for at simulere et modsat angreb, en standardkomprimeret model fejlklassificerede kyllingen som "kat" og frøen som "hjorte". Men da forskere tilføjede en begrænsning under komprimering, modellen klassificerede dyrene korrekt endda bedre end en 32-bit model med fuld præcision. Kredit:Massachusetts Institute of Technology

"Vores teknik begrænser fejlforstærkning og kan endda gøre komprimerede deep learning-modeller mere robuste end modeller med fuld præcision, "siger Song Han, en adjunkt i MIT's afdeling for elektroteknik og datalogi og medlem af MIT's Microsystems Technology Laboratories. "Med korrekt kvantisering, vi kan begrænse fejlen. "

Teamet planlægger at forbedre teknikken yderligere ved at træne den på større datasæt og anvende den på en bredere vifte af modeller. "Modeller med dyb læring skal være hurtige og sikre, når de bevæger sig ind i en verden af internetforbundne enheder, "siger studieforfatter Chuang Gan, en forsker ved MIT-IBM Watson AI Lab. "Vores teknik til defensiv kvantisering hjælper på begge fronter."

Forskerne, der inkluderer MIT -kandidatstuderende Ji Lin, præsentere deres resultater på den internationale konference om læringsrepræsentationer i maj.

Ved at gøre AI -modeller mindre, så de kører hurtigere og bruger mindre energi, Han bruger selv AI til at skubbe grænserne for modelkomprimeringsteknologi. I relateret nyere arbejde, Han og hans kolleger viser, hvordan forstærkningslæring kan bruges til automatisk at finde den mindste bitlængde for hvert lag i en kvantiseret model baseret på, hvor hurtigt enheden, der kører modellen, kan behandle billeder. Denne fleksible bitbredde -tilgang reducerer latenstid og energiforbrug med hele 200 procent i forhold til en fast, 8-bit model, siger Han. Forskerne vil præsentere deres resultater på konferencen Computer Vision and Pattern Recognition i juni.

Denne historie er genudgivet med tilladelse fra MIT News (web.mit.edu/newsoffice/), et populært websted, der dækker nyheder om MIT -forskning, innovation og undervisning.

Varme artikler

Varme artikler

-

Innovativ undersøgelse undersøger menneskeskabende interaktionKredit:Olivier Le Moal, Shutterstock Hvordan kan folk motiveres til at forbedre deres energiforbrug? En EU-finansieret tværkulturel undersøgelse ser på, hvordan mennesker interagerer med bygningst

Innovativ undersøgelse undersøger menneskeskabende interaktionKredit:Olivier Le Moal, Shutterstock Hvordan kan folk motiveres til at forbedre deres energiforbrug? En EU-finansieret tværkulturel undersøgelse ser på, hvordan mennesker interagerer med bygningst -

Russiske hackere infiltrerede tyske ministerier netværk:rapportHackergruppen kendt som APT28 – som har været knyttet til Ruslands GRU militære efterretningstjeneste – formåede at plante malware i de tyske ministeriers netværk i muligvis så længe som et år Rus

Russiske hackere infiltrerede tyske ministerier netværk:rapportHackergruppen kendt som APT28 – som har været knyttet til Ruslands GRU militære efterretningstjeneste – formåede at plante malware i de tyske ministeriers netværk i muligvis så længe som et år Rus -

Hackere forårsager de fleste databrud, men ulykker af normale mennesker er langt vækKredit:Shutterstock Har du nogensinde fået dine personlige oplysninger lækket på internettet? Måske var det noget, du købte online fra et websted, kun for at finde ud af, at virksomheden blev hack

Hackere forårsager de fleste databrud, men ulykker af normale mennesker er langt vækKredit:Shutterstock Har du nogensinde fået dine personlige oplysninger lækket på internettet? Måske var det noget, du købte online fra et websted, kun for at finde ud af, at virksomheden blev hack -

Game over for gamere? Britiske studier medregner Brexit-omkostningerGaming beskæftiger 20, 000 mennesker i hele Storbritannien Kunne det muligvis være game over for de lyse hoveder bag Grand Theft Auto og andre globale spilhits? Britiske udviklere har stille og r

Game over for gamere? Britiske studier medregner Brexit-omkostningerGaming beskæftiger 20, 000 mennesker i hele Storbritannien Kunne det muligvis være game over for de lyse hoveder bag Grand Theft Auto og andre globale spilhits? Britiske udviklere har stille og r