Facebook genererer automatisk videoer, der fejrer ekstremistiske billeder

Et banner med teksten "Den Islamiske Stat" vises på Facebook-siden af en bruger, der identificerer sig som Nawan Al-Farancsa. Siden var stadig live tirsdag, 7. maj kl. 2019, da skærmgrebet blev foretaget. Facebook siger, at det har robuste systemer til at fjerne indhold fra ekstremistiske grupper, men en forseglet whistleblower -klage, der er gennemgået af AP, siger, at forbudt indhold forbliver på nettet og er let at finde. (Facebook via AP)

Den animerede video begynder med et foto af jihads sorte flag. Sekunder senere, det blinker højdepunkterne i et års indlæg på sociale medier:plaketter med antisemitiske vers, tale om gengældelse og et foto af to mænd, der bærer flere jihadiflag, mens de brænder stjerner og striber.

Det blev ikke produceret af ekstremister; det blev oprettet af Facebook. I en smart smule selvpromovering, den sociale mediegigant tager et år med en brugers indhold og genererer automatisk en festlig video. I dette tilfælde, brugeren kaldte sig selv "Abdel-Rahim Moussa, kalifatet. "

"Tak fordi du er her, fra Facebook, "Videoen afsluttes i en tegneserieboble, før virksomhedens berømte" tommelfinger op "blinker.

Facebook kan godt lide at give indtryk af, at det holder sig foran ekstremister ved at fjerne deres indlæg, ofte før brugerne overhovedet ser dem. Men en fortrolig whistleblower -klage til Securities and Exchange Commission indhentet af Associated Press hævder, at det sociale medieselskab har overdrevet sin succes. Værre endnu, det viser, at virksomheden utilsigtet anvender propaganda fra militante grupper til automatisk at generere videoer og sider, der kan bruges til netværk af ekstremister.

Ifølge klagen, over en fem-måneders periode sidste år, forskere overvågede sider af brugere, der var tilknyttet grupper, som det amerikanske udenrigsministerium har udpeget som terrororganisationer. I den periode, 38% af posterne med fremtrædende symboler på ekstremistiske grupper blev fjernet. I sin egen anmeldelse, AP fandt ud af, at fra denne måned, meget af det forbudte indhold, der er citeret i undersøgelsen - en eksekveringsvideo, billeder af afskårne hoveder, propaganda til ære for martyrmilitanter - gled gennem det algoritmiske web og forblev let at finde på Facebook.

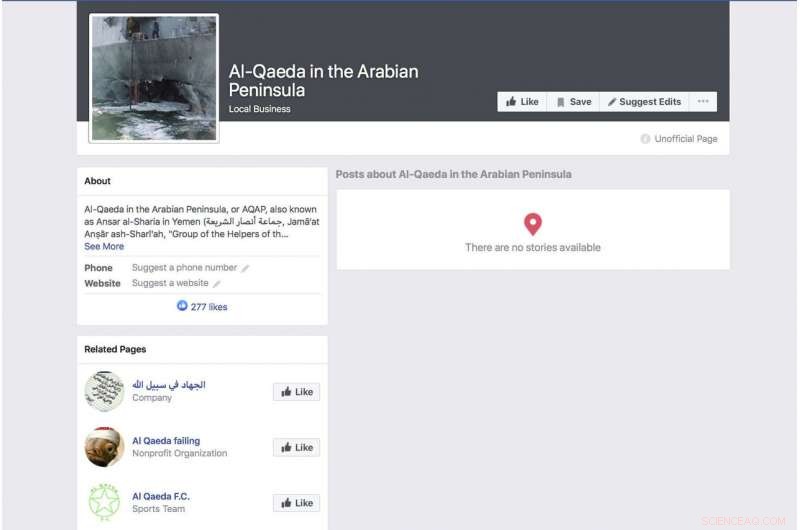

En automatisk auto-genereret Facebook-side for en gruppe, der identificerer sig som terrorgruppen "Al-Qaeda på den arabiske halvø", viser et foto af det bombede amerikanske flådekrigsskib USS Cole. Siden var stadig live fra tirsdag d. 7. maj kl. 2019, da skærmgrebet blev foretaget. Facebook siger, at det har robuste systemer til at fjerne indhold fra ekstremistiske grupper, men en forseglet whistleblower's klage gennemgået af AP siger, at forbudt indhold stadig er på nettet og let at finde. (Facebook via AP)

Klagen lander, da Facebook forsøger at holde sig foran en voksende række kritik over sin privatlivspraksis og dens evne til at beholde hadefulde ytringer, livestreamede mord og selvmord fra sin tjeneste. I lyset af kritik, CEO Mark Zuckerberg har talt om sin stolthed over virksomhedens evne til automatisk at luge voldelige indlæg ud automatisk via kunstig intelligens. Under et indtjeningsopkald i sidste måned, for eksempel, han gentog en omhyggeligt formuleret formulering, som Facebook har brugt.

"I områder som terrorisme, for al-Qaida og ISIS-relateret indhold, nu 99 procent af det indhold, vi tager ned i kategorien, vores systemer markerer proaktivt, før nogen ser det, sagde han. Så tilføjede han:"Sådan ser rigtig godt ud."

Zuckerberg gav ikke et skøn over, hvor meget af det samlede forbudte materiale, der fjernes.

Forskningen bag SEC -klagen er rettet mod at belyse klare fejl i virksomhedens tilgang. Sidste år, forskere begyndte at overvåge brugere, der eksplicit identificerede sig som medlemmer af ekstremistiske grupper. Det var ikke svært at dokumentere. Nogle af disse mennesker angiver endda de ekstremistiske grupper som deres arbejdsgivere. En profil, der varslet af det sorte flag fra en al-Qaida-tilknyttet gruppe, angav hans arbejdsgiver, måske facetagtigt, som Facebook. Profilen, der inkluderede den automatisk genererede video med flagafbrænding, havde også en video af al-Qaida-leder Ayman al-Zawahiri, der opfordrede jihadigrupper til ikke at kæmpe indbyrdes.

Selvom undersøgelsen langt fra er omfattende - blandt andet fordi Facebook sjældent gør meget af sine data offentligt tilgængelige - siger forskere, der er involveret i projektet, at det er let at identificere disse profiler ved hjælp af en grundlæggende søgeord og det faktum, at så få af dem er blevet fjernet, tyder på at Facebooks påstande om, at dets systemer fanger mest ekstremistisk indhold, ikke er nøjagtige.

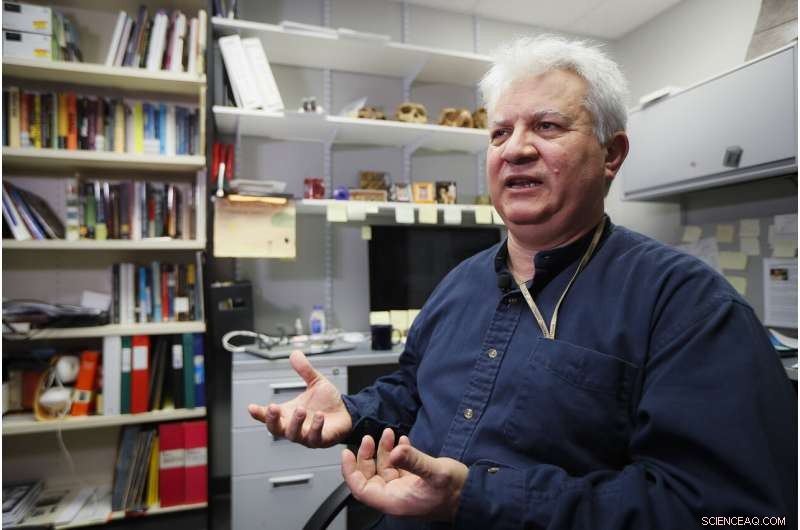

Amr Al Azm, en professor i Mellemøstens historie og antropologi ved Shawnee State University, taler på sit kontor den 25. april, 2019, i Portsmouth, Ohio. Facebook giver indtryk af, at det stopper langt de fleste ekstremistiske indlæg, før brugerne nogensinde ser dem. Men en fortrolig whistleblower -klage til Securities and Exchange Commission indhentet af Associated Press hævder, at det sociale medieselskab har overdrevet sin succes. "Jeg mener, at det bare strækker fantasien til mere end vantro, "siger, Al Azm en af forskerne involveret i projektet. "Hvis en lille gruppe forskere kan finde hundredvis af sider med indhold ved simple søgninger, hvorfor kan en kæmpe virksomhed med alle sine ressourcer ikke gøre det? "(AP Photo/John Minchillo)

"Jeg mener, det strækker bare fantasien til mere end vantro, "siger Amr Al Azm, en af forskerne involveret i projektet. "Hvis en lille gruppe forskere kan finde hundredvis af sider med indhold ved simple søgninger, hvorfor kan en kæmpe virksomhed med alle sine ressourcer ikke gøre det? "

Al Azm, professor i historie og antropologi ved Shawnee State University i Ohio, har også ledet en gruppe i Syrien, der dokumenterer plyndring og smugling af antikviteter.

Facebook indrømmer, at dets systemer ikke er perfekte, men siger, at det gør forbedringer.

"Efter at have foretaget tunge investeringer, vi opdager og fjerner terrorismeindhold med en langt højere succesrate end for to år siden, "sagde virksomheden i en erklæring." Vi hævder ikke at finde alt, og vi er stadig vågne i vores bestræbelser mod terrorgrupper rundt om i verden. "

Reagerer på AP's rapportering, Rep. Bennie Thompson, D-frøken., formanden for House Homeland Security Committee udtrykte frustration over, at Facebook har gjort så lidt fremskridt med at blokere indhold på trods af forsikringer, han modtog fra virksomheden.

En Facebook -side til bruger Ramadan kareem, at når oversat til engelsk lister brugeren som arbejder ved "Islamisk Stat i Sham og Irak." Siden var stadig live tirsdag, 7. maj kl. 2019, da skærmgrebet blev foretaget. Facebook siger, at det har robuste systemer til at fjerne indhold fra ekstremistiske grupper, men en forseglet whistleblower's klage gennemgået af AP siger, at forbudt indhold stadig er på nettet og let at finde. (Facebook via AP)

"Dette er endnu et dybt bekymrende eksempel på Facebooks manglende evne til at styre sine egne platforme - og i hvilket omfang det har brug for at rydde op i sine handlinger, "sagde han." Facebook må ikke kun befri sine platforme for terroristisk og ekstremistisk indhold, men det skal også være i stand til at forhindre, at det forstærkes. "

Men som en klar indikation af, hvor let brugerne kan undgå Facebook, en side fra en bruger kaldet "Nawan al-Farancsa" har en overskrift, hvis hvide bogstaver på sort baggrund siger på engelsk "Den Islamiske Stat". Banneret er præget med et foto af en eksplosiv svampesky, der stiger fra en by.

Profilen burde have tiltrukket sig opmærksomhed fra Facebook-såvel som mod-efterretningsbureauer. Det blev oprettet i juni 2018, viser brugeren som kommer fra Tjetjenien, engang et militant hotspot. Der står, at han boede i Heidelberg, Tyskland, og studerede på et universitet i Indonesien. Nogle af brugerens venner lagde også militant indhold op.

Siden, stadig oppe i de seneste dage, tilsyneladende undslap Facebooks systemer, på grund af en indlysende og langvarig unddragelse af mådehold, som Facebook burde være dygtig til at genkende:Bogstaverne var ikke søgbar tekst, men indlejret i en grafisk blok. Men virksomheden siger, at dens teknologi scanner lyd, video og tekst - herunder når den er integreret - til billeder, der afspejler vold, forbudte gruppers våben eller logoer.

Den sociale netværksgigant har været udsat for hårde to år fra 2016, da Ruslands brug af sociale medier til at blande sig i det amerikanske præsidentvalg kom i fokus. Zuckerberg bagatelliserede oprindeligt den rolle Facebook spillede i indflydelsesoperationen fra russisk efterretningstjeneste, men virksomheden undskyldte senere.

En Facebook -side for en bruger, der oversættes til engelsk som "bitterhedens lys", der viser brugeren som læge hos Islamisk Stat. Siden var stadig live fra tirsdag d. 7. maj kl. 2019, da skærmgrebet blev foretaget. Facebook siger, at det har robuste systemer til at fjerne indhold fra ekstremistiske grupper, men en whistleblower's klage gennemgået af AP siger, at forbudt indhold stadig er på nettet og let at finde. (Facebook via AP)

Facebook siger, at det nu beskæftiger 30, 000 mennesker, der arbejder med dets sikkerheds- og sikkerhedspraksis, gennemgang af potentielt skadeligt materiale og alt andet, der måske ikke hører hjemme på webstedet. Stadig, virksomheden sætter meget stor vægt på kunstig intelligens og dets systemers evne til i sidste ende at luge dårlige ting ud uden hjælp fra mennesker. Den nye forskning tyder på, at målet er langt væk, og nogle kritikere hævder, at virksomheden ikke gør en oprigtig indsats.

Når materialet ikke fjernes, det behandles på samme måde som alt andet, der blev sendt af Facebooks 2,4 milliarder brugere - fejret i animerede videoer, forbundet og kategoriseret og anbefalet af algoritmer.

Men det er ikke kun algoritmerne, der er skyld i det. Forskerne fandt ud af, at nogle ekstremister bruger Facebooks "Frame Studio" til at sende militant propaganda. Værktøjet lader folk dekorere deres profilbilleder inden for grafiske rammer - for at støtte årsager eller fejre fødselsdage, for eksempel. Facebook siger, at disse indrammede billeder skal godkendes af virksomheden, før de bliver lagt ud.

Hany Farid, en digital retsmedicinsk ekspert ved University of California, Berkeley, der rådgiver kontraekstremisme-projektet, en gruppe i New York og London med fokus på bekæmpelse af ekstremistiske beskeder, siger, at Facebooks kunstige intelligenssystem fejler. Han siger, at virksomheden ikke er motiveret til at tackle problemet, fordi det ville være dyrt.

"Hele infrastrukturen er grundlæggende mangelfuld, "sagde han." Og der er meget lidt appetit på at rette op på det, for det Facebook og de andre sociale mediefirmaer ved er, at når de begynder at være ansvarlige for materiale på deres platforme, åbner det en hel dåse orme. "

-

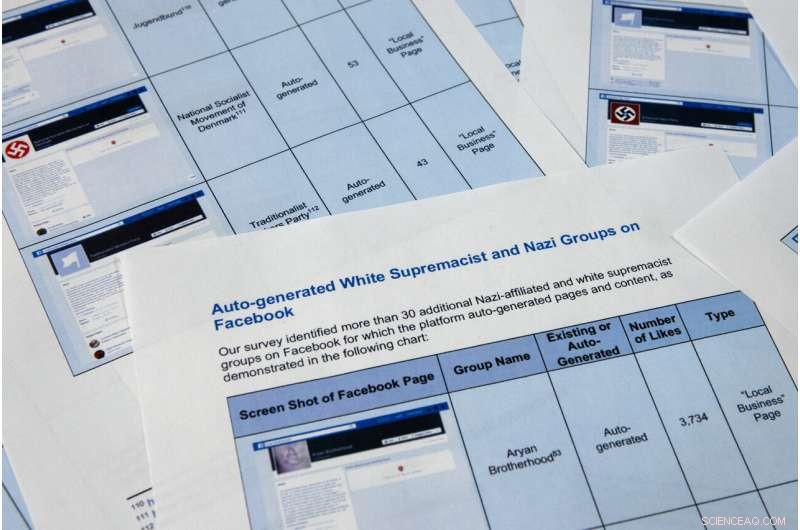

Sider fra en fortrolig whistleblower -rapport opnået af The Associated Press fotograferes tirsdag, 7. maj kl. 2019, i Washington. Facebook kan godt lide at give indtryk af, at det stopper langt de fleste ekstremistiske indlæg, før brugerne nogensinde ser dem., men den fortrolige whistleblower's klage til Securities and Exchange Commission påstår, at det sociale medieselskab har overdrevet sin succes. Værre endnu, det viser, at virksomheden gør brug af propaganda fra militante grupper til automatisk at generere videoer og sider, der kan bruges til netværk af ekstremister. (AP Photo/Jon Elswick)

-

Sider fra en fortrolig whistleblower -rapport opnået af The Associated Press fotograferes tirsdag, 7. maj kl. 2019, i Washington. Facebook kan godt lide at give indtryk af, at det stopper langt de fleste ekstremistiske indlæg, før brugerne nogensinde ser dem., men den fortrolige whistleblower's klage til Securities and Exchange Commission påstår, at det sociale medieselskab har overdrevet sin succes. Værre endnu, det viser, at virksomheden gør brug af propaganda fra militante grupper til automatisk at generere videoer og sider, der kan bruges til netværk af ekstremister. Forskerne i SEC-klagen identificerede over 30 auto-genererede sider til hvide supremacistiske grupper, hvis indhold Facebook forbyder. (AP Photo/Jon Elswick)

-

I denne 11. april, 2018, fil foto, Facebooks administrerende direktør, Mark Zuckerberg, vidner før en høring i House Energy and Commerce på Capitol Hill i Washington. Facebook giver indtryk af, at det stopper langt de fleste ekstremistiske indlæg, før brugerne nogensinde ser dem. Men en fortrolig whistleblower -klage til Securities and Exchange Commission indhentet af Associated Press hævder, at det sociale medieselskab har overdrevet sin succes. (AP Photo/Andrew Harnik, Fil)

En anden Facebook-genereringsfunktion, der er gået galt, skraber beskæftigelsesoplysninger fra brugerens sider for at oprette forretningssider. Funktionen formodes at producere sider, der skal hjælpe virksomheder med at netværke, men i mange tilfælde tjener de som et brandet landingsrum for ekstremistiske grupper. Funktionen gør det muligt for Facebook -brugere at lide sider for ekstremistiske organisationer, herunder al-Qaida, gruppen Islamisk Stat og den somaliske baserede al-Shabab, effectively providing a list of sympathizers for recruiters.

At the top of an auto-generated page for al-Qaida in the Arabian Peninsula, the AP found a photo of the damaged hull of the USS Cole, which was bombed by al-Qaida in a 2000 attack off the coast of Yemen that killed 17 U.S. Navy sailors. It's the defining image in AQAP's own propaganda. The page includes the Wikipedia entry for the group and had been liked by 277 people when last viewed this week.

As part of the investigation for the complaint, Al Azm's researchers in Syria looked closely at the profiles of 63 accounts that liked the auto-generated page for Hay'at Tahrir al-Sham, a group that merged from militant groups in Syria, including the al-Qaida affiliated al-Nusra Front. The researchers were able to confirm that 31 of the profiles matched real people in Syria. Some of them turned out to be the same individuals Al Azm's team was monitoring in a separate project to document the financing of militant groups through antiquities smuggling.

Facebook also faces a challenge with U.S. hate groups. I marts, the company announced that it was expanding its prohibited content to also include white nationalist and white separatist content— previously it only took action with white supremacist content. It says that it has banned more than 200 white supremacist groups. But it's still easy to find symbols of supremacy and racial hatred.

The researchers in the SEC complaint identified over 30 auto-generated pages for white supremacist groups, whose content Facebook prohibits. They include "The American Nazi Party" and the "New Aryan Empire." A page created for the "Aryan Brotherhood Headquarters" marks the office on a map and asks whether users recommend it. One endorser posted a question:"How can a brother get in the house."

A Facebook page for an auto generated Facebook page for a local business, translated into English from Arabic, calling itself 'Islamic State in Sham and Iraq. The page was still live as of Tuesday, May 7, 2019, when the screen grab was made. Facebook says it has robust systems in place to remove content from extremist groups, but a sealed whistleblower's complaint reviewed by the AP says banned content remains on the web and easy to find. (Facebook via AP)

Even supremacists flagged by law enforcement are slipping through the net. Following a sweep of arrests beginning in October, federal prosecutors in Arkansas indicted dozens of members of a drug trafficking ring linked to the New Aryan Empire. A legal document from February paints a brutal picture of the group, alleging murder, kidnapping and intimidation of witnesses that in one instance involved using a searing-hot knife to scar someone's face. It also alleges the group used Facebook to discuss New Aryan Empire business.

But many of the individuals named in the indictment have Facebook pages that were still up in recent days. They leave no doubt of the users' white supremacist affiliation, posting images of Hitler, swastikas and a numerical symbol of the New Aryan Empire slogan, "To The Dirt"—the members' pledge to remain loyal to the end. One of the group's indicted leaders, Jeffrey Knox, listed his job as "stomp down Honky." Facebook then auto-generated a "stomp down Honky" business page.

Social media companies have broad protection in U.S. law from liability stemming from the content that users post on their sites. But Facebook's role in generating videos and pages from extremist content raises questions about exposure. Legal analysts contacted by the AP differed on whether the discovery could open the company up to lawsuits.

At a minimum, the research behind the SEC complaint illustrates the company's limited approach to combatting online extremism. The U.S. State Department lists dozens of groups as "designated foreign terrorist organizations" but Facebook in its public statements says it focuses its efforts on two, the Islamic State group and al-Qaida. But even with those two targets, Facebook's algorithms often miss the names of affiliated groups. Al Azm says Facebook's method seems to be less effective with Arabic script.

For eksempel, a search in Arabic for "Al-Qaida in the Arabian Peninsula" turns up not only posts, but an auto-generated business page. One user listed his occupation as "Former Sniper" at "Al-Qaida in the Arabian Peninsula" written in Arabic. Another user evaded Facebook's cull by reversing the order of the countries in the Arabic for ISIS or "Islamic State of Iraq and Syria."

Amr Al Azm, a professor of Middle East History and Anthropology at Shawnee State University, speaks at his office on April 25, 2019, in Portsmouth, Ohio. Facebook gives the impression that it's stopping the vast majority of extremist posts before users ever see them. But a confidential whistleblower's complaint to the Securities and Exchange Commission obtained by The Associated Press alleges the social media company has exaggerated its success. "I mean that's just stretching the imagination to beyond incredulity, "siger, Al Azm one of the researchers involved in the project. "If a small group of researchers can find hundreds of pages of content by simple searches, why can't a giant company with all its resources do it?" (AP Photo/John Minchillo)

John Kostyack, a lawyer with the National Whistleblower Center in Washington who represents the anonymous plaintiff behind the complaint, said the goal is to make Facebook take a more robust approach to counteracting extremist propaganda.

"Right now we're hearing stories of what happened in New Zealand and Sri Lanka—just heartbreaking massacres where the groups that came forward were clearly openly recruiting and networking on Facebook and other social media, " he said. "That's not going to stop unless we develop a public policy to deal with it, unless we create some kind of sense of corporate social responsibility."

Farid, the digital forensics expert, says that Facebook built its infrastructure without thinking through the dangers stemming from content and is now trying to retrofit solutions.

"The policy of this platform has been:'Move fast and break things.' I actually think that for once their motto was actually accurate, " he says. "The strategy was grow, grow, grow, profit, profit, profit and then go back and try to deal with whatever problems there are."

© 2019 Associated Press. Alle rettigheder forbeholdes.

Varme artikler

Varme artikler

-

Som fødende væve, stater ramte Facebook, Google med nye sonderDenne torsdag, 3. januar, 2013, filbillede viser Googles hovedkvarter i Mountain View, Californien. To biparti-grupper af statsadvokater lancerer separate antitrust-undersøgelser af Facebook og Google

Som fødende væve, stater ramte Facebook, Google med nye sonderDenne torsdag, 3. januar, 2013, filbillede viser Googles hovedkvarter i Mountain View, Californien. To biparti-grupper af statsadvokater lancerer separate antitrust-undersøgelser af Facebook og Google -

Ossia klæder sig til en ny dag inden for trådløs opladningKredit:Ossia Teknologien skrider fremad, grænser - og stagnerer i en genstridig flad linje. Teknologien har fremvist maskiner, der kan lære at lave en sofistikeret pizza, identificere individer ve

Ossia klæder sig til en ny dag inden for trådløs opladningKredit:Ossia Teknologien skrider fremad, grænser - og stagnerer i en genstridig flad linje. Teknologien har fremvist maskiner, der kan lære at lave en sofistikeret pizza, identificere individer ve -

Kommer til iPhone 11 fra Anker:En Apple-godkendt ekstern blitz til at lyse dine billeder opDet kinesiske elektronikfirma Anker planlægger angiveligt at frigive en Apple-godkendt ekstern flash til smartphones, så den iPhone 11, du fik til jul, kan bruges mere som et kamera. Den nye fotogadg

Kommer til iPhone 11 fra Anker:En Apple-godkendt ekstern blitz til at lyse dine billeder opDet kinesiske elektronikfirma Anker planlægger angiveligt at frigive en Apple-godkendt ekstern flash til smartphones, så den iPhone 11, du fik til jul, kan bruges mere som et kamera. Den nye fotogadg -

Verdens største batteri i Australien til at trumfe MuskDen britiske milliardærforretningsmand Sanjeev Gupta vil bygge verdens største batteri i det sydlige Australien, overhalede den amerikanske stjerne -iværksætter Elon Musks projekt i samme stat sidste

Verdens største batteri i Australien til at trumfe MuskDen britiske milliardærforretningsmand Sanjeev Gupta vil bygge verdens største batteri i det sydlige Australien, overhalede den amerikanske stjerne -iværksætter Elon Musks projekt i samme stat sidste

- Spiralarme giver skolebørn mulighed for at veje sorte huller

- Skadelige virkninger af chlor gas

- Hvordan er coroners og medicinske undersøgere forskellige?

- Fremskynde brintproduktionen ved hjælp af de magiske topologiske overfladetilstande

- Investering i LEGO kan give afkast på op til 600 procent

- Tinder, Grindr anklaget for ulovlig deling af brugerdata