Skæringspunktet mellem vision og sprog

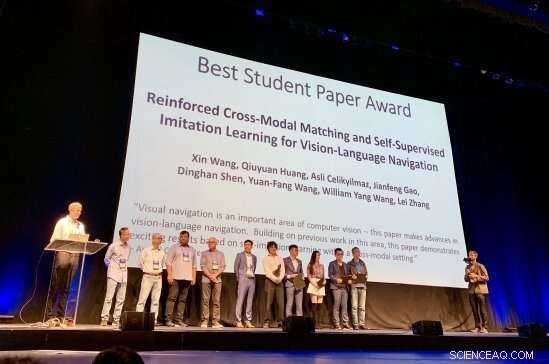

Forskerne bag 2019 CVPR Best Student Paper Award er anerkendt for deres arbejde Kredit: Matthew Turk

Ni tusinde to hundrede forskere i kunstig intelligens. Fem tusind et hundrede femogtres forskningsartikler indsendt, heraf kun 1, 300 blev accepteret. En bedste studerende papir.

Og prisen gik til:UC Santa Barbara ph.d.-studerende i datalogi Xin Wang. Hans studenteropgave, "Forstærket cross-modal matching og selvovervåget imitationslæring til syn-sprognavigation, " dukkede op som nr. 1 i sin kategori ved den 31. IEEE/CVF-konference om computersyn og mønstergenkendelse (CVPR), en af de vigtigste konferencer inden for datalogi i dag. Prisbegivenheden fandt sted i Long Beach, på tirsdag, 18. juni.

"Xin begyndte at arbejde sammen med mig i 2017 som ph.d.-studerende om emner relateret til sprog- og synsforskning, " sagde William Wang, adjunkt ved Institut for Datalogi ved UCSB's Ingeniørhøjskole. "Siden marts 2018, vi har studeret vision-sprognavigationsproblemet:Hvordan bruger du verbale instruktioner til at lære robotter at målrette destinationer, uden adgang til et kort?"

En robot, der kan navigere baseret på vision og udføre opgaver under instruktioner i almindeligt sprog, lyder som science fiction, men det er tættere på virkeligheden, end du måske tror.

"Jeg har arbejdet på krydsfeltet mellem vision og sprog i et stykke tid, " Xin Wang sagde, "og jeg tror på, at et af de store træk ved AI er at få robotter til at interagere med den visuelle og fysiske verden, især via naturligt sprog.

"Vision-sprog navigation kan muliggøre mange praktiske applikationer, for eksempel, robotter i hjemmet, " fortsatte han. "Alle, især handicappede, kan bede robotten om at udføre nogle bestemte opgaver, for eksempel 'Gå i køkkenet og kom med en kop vand til mig.' Vision-sprog navigation tjener som en grundlæggende opgave at forstå både visuelle scener og naturlige sprog instruktioner, samt udføre fysiske handlinger for at udføre opgaver på højt niveau."

Men det, der falder så naturligt for mennesker - at navigere gennem en scene og udføre opgaver ved hjælp af real-time miljøsignaler og menneskelige koncepter - kræver en fleksibel, alligevel elegante rammer, hvor robotter kan lære at forbinde de data, de opfanger, til betydningen af de instruktioner, de modtager. Det er en iterativ proces, kræver forstærkning, feedback og tilpasning. Xin Wangs arbejde, ifølge hans rådgiver, "introducerer flere innovative ideer til at forbedre generaliseringen af vision-sprognavigationsalgoritmen."

"Dette gennembrud inden for sprog- og synsforskning vil sætte robotter i stand til bedre at hjælpe mennesker i mange daglige og specielle rutiner, herunder rengøring og vedligeholdelse af hjemmet, genstand at finde og hente, fjernbetjening, hjælpe blinde mennesker, katastrofehjælp, og så videre, " sagde William Wang. "Det har potentialet til at påvirke millioner af mennesker og forbedre livskvaliteten for mennesker, herunder at befri mennesker fra kedelige husholdningsopgaver, så vi kan få tid til kreative aktiviteter."

Forskningen til 2019 CVPR Best Student Paper, som bygger på tidligere samarbejder på UCSB om modelbaseret og modelfri forstærkningslæring med ph.d. studerende Wenhan Xiong, blev gennemført i sommeren 2018 under et praktikophold hos Microsoft Research (MSR), under mentorer Qiuyuan Huang, Asli Celikyilmaz, Jianfeng Gao og Lei Zhang.

Ifølge CVPR Best Paper-udvalget, "Visuel navigation er et vigtigt område inden for computersyn - denne artikel gør fremskridt inden for vision-sprognavigation. Med udgangspunkt i tidligere arbejde på dette område, dette papir demonstrerer spændende resultater baseret på selvimiterende læring inden for en tværmodal setting."

"Vi vil gerne lykønske Xin Wang og William Wang med denne ekstremt prestigefyldte anerkendelse for deres arbejde inden for et område, der er helt i front inden for datalogi, " sagde College of Engineering Dean Rod Alferness. "Vi er glade for, at de er en del af UCSB-fællesskabet."

"Jeg er virkelig beæret over at modtage denne pris, " sagde Xin Wang. "Jeg vil gerne takke mine rådgivere William og Yuan-Fang oprigtigt, og MSR-samarbejdspartnerne for deres stærke støtte og værdifulde vejledning. Hvad angår fremtiden, Jeg håber, at flere og flere forskere kan arbejde på denne spændende og nødvendige forskningsretning, mod mere praktiske og interaktive robotter, der bygger bro mellem syn og sprog for mennesker. Jeg vil bestemt hellige mig til at få det til at ske."

Varme artikler

Varme artikler

-

Windows Sandbox tilbyder sikker zone, hvis appen ser mistænkelig udKredit:Microsoft Windows Sandbox får en masse presse og med god grund:Windows-watchers siger, at det vil være et sikkert sted at parkere hmmm eksekverbare filer, dem, der kunne (eller ikke kunne)

Windows Sandbox tilbyder sikker zone, hvis appen ser mistænkelig udKredit:Microsoft Windows Sandbox får en masse presse og med god grund:Windows-watchers siger, at det vil være et sikkert sted at parkere hmmm eksekverbare filer, dem, der kunne (eller ikke kunne) -

Kunstig intelligens åbner nyt vindue om komplekse byspørgsmålArbejdere fra Chicago Department of Transportation installerer en node til Array of Things, et distribueret sansningsnetværk til bymiljøer, på Damen og Archer -avenuer i Chicago centrum. Kredit:Rob Mi

Kunstig intelligens åbner nyt vindue om komplekse byspørgsmålArbejdere fra Chicago Department of Transportation installerer en node til Array of Things, et distribueret sansningsnetværk til bymiljøer, på Damen og Archer -avenuer i Chicago centrum. Kredit:Rob Mi -

Facebooks udvider krisen over brugerdataDenne 17. januar, 2017, filfoto viser et Facebook-logo, der vises i et opstartsfirma, der samles på Paris Station F, i Paris. Facebook tager baby skridt for nu for at tage fat på den seneste fortrolig

Facebooks udvider krisen over brugerdataDenne 17. januar, 2017, filfoto viser et Facebook-logo, der vises i et opstartsfirma, der samles på Paris Station F, i Paris. Facebook tager baby skridt for nu for at tage fat på den seneste fortrolig -

Ford står over for vrede i Frankrig over lukning af fabrikkenStop jobnedskæringer lød fagforeningernes T-shirts, der hilste den franske økonomi- og finansminister Bruno Le Maire på et møde mandag med Ford-ledelsen om skæbnen for Blanquefort-fabrikken uden for B

Ford står over for vrede i Frankrig over lukning af fabrikkenStop jobnedskæringer lød fagforeningernes T-shirts, der hilste den franske økonomi- og finansminister Bruno Le Maire på et møde mandag med Ford-ledelsen om skæbnen for Blanquefort-fabrikken uden for B

- Algoritmer afslører mønstre, der hjælper med at bekæmpe falske nyheder

- På vej til det praktiske, billige superledere med uudforskede materialer

- Lavpris Moon-mission placerer Indien blandt månepionerer

- Apparat til samtidig måling af gasser, der reducerer indendørs luftkvalitet

- Vi skabte diamanter på få minutter uden varme ved at efterligne kraften ved en asteroide -kollisio…