Eliminering af bias i AI

Kredit:Sébastien Thibault

Hos mennesker, intelligens er ingen inokulation mod skævhed og bigotteri. Det samme gælder for computere. Intelligente maskiner lærer om verden gennem filtrene af menneskeligt sprog og historisk adfærd - hvilket betyder, at de lige så let kan absorbere menneskehedens værste værdier, som de kan bedst muligt.

Forskere, der sigter på at udvikle stadigt smartere maskiner, har deres arbejde skåret for dem for at sikre, at de ikke utilsigtet gennemsyrer computere med kvindehad, racisme eller andre former for bigotteri.

"Det er en stor risiko, " siger Marzyeh Ghassemi, en assisterende professor ved University of Torontos afdeling for datalogi og Det Medicinske Fakultet, der fokuserer på sundhedsapplikationer til kunstig intelligens (AI). "Som alle fremskridt, der springer samfund fremad, der er store risici, som vi skal beslutte os for at acceptere eller ikke at acceptere."

Bias kan snige sig ind i algoritmer på mange måder. I en meget indflydelsesrig gren af AI kendt som "naturlig sprogbehandling, " problemer kan opstå fra "tekstkorpuset" - det kildemateriale, som algoritmen bruger til at lære om forholdet mellem forskellige ord.

Naturlig sprogbehandling, eller "NLP, " gør det muligt for en computer at forstå tale i menneskelig stil - uformel, samtale og kontekstuel. NLP-algoritmer gennemsøger milliarder af ord med træningstekst – korpuset kan være, sige, hele Wikipedia. Én algoritme virker ved at tildele hvert ord et sæt tal, der afspejler forskellige aspekter af dets betydning - "konge" og "dronning" for eksempel, ville have lignende karakterer i forbindelse med ideen om royalty, men modsatte scores i forhold til køn. NLP er et kraftfuldt system, der gør det muligt for maskiner at lære om relationer mellem ord – i nogle tilfælde, uden direkte menneskelig involvering.

"Selvom vi ikke altid underviser dem specifikt, det de lærer er utroligt, " siger Kawin Ethayarajh, en forsker, der til dels fokuserer på retfærdighed og retfærdighed i AI-applikationer. "Men det er også et problem. I korpuset forholdet mellem 'konge' og 'dronning' kan ligne forholdet mellem 'læge' og 'sygeplejerske'."

Men selvfølgelig, alle konger er mænd; ikke alle læger er mænd. Og ikke alle sygeplejersker er kvinder.

Når en algoritme absorberer de sexistiske troper af historiske menneskelige holdninger, det kan føre til konsekvenser i det virkelige liv, som det skete i 2014, da Amazon udviklede en algoritme til at undersøge jobansøgeres CV'er. Virksomheden trænede sine maskiner ved at bruge 10 års ansættelsesbeslutninger. Men i 2015 de erkendte, at i test, systemet gav ufortjent præference til CV'er fra mandlige ansøgere. De tilpassede systemet for at tvinge det til at ignorere kønsoplysninger, men i sidste ende lukkede projektet ned, før de rent faktisk tog det i brug, da de ikke kunne være sikre på, at deres algoritme ikke udøvede andre former for diskrimination.

Afbødende sexistisk kildemateriale kan involvere teknologiske og metodiske justeringer. "Hvis vi kan forstå præcis, hvilke underliggende antagelser korpuset har, der forårsager, at disse skævheder læres, vi kan enten vælge korpus uden disse skævheder eller rette det under træningsprocessen, " siger Ethayarajh.

Det er almindelig praksis for forskere at designe en algoritme, der automatisk korrigerer fordomsfulde antagelser. Ved at justere vægten af de tal, den tildeler hvert ord, computeren kan undgå at lave sexistiske eller racistiske associationer.

Men hvad er det præcist for antagelser, der skal rettes? Hvordan ser en fair-minded AI egentlig ud? Debatter om privilegier, fordomme, mangfoldighed og systemisk skævhed er langt fra afgjort. Skal en ansættelsesalgoritme have en holdning til positiv særbehandling? Skal en selvkørende bil være særlig opmærksom, hvis et andet køretøj har et "Baby on Board"-mærkat? Hvordan bør en AI-drevet analyse af juridiske dokumenter tage højde for den historiske behandling af oprindelige folk? Omstridte samfundsproblemer forsvinder ikke, blot fordi maskiner overtager bestemte anbefalinger eller beslutninger.

Mange mennesker ser Canadas fejlbehæftede, men relativt succesrige model for multikulturalisme som en chance for at lede i retfærdig AI-forskning.

"Canada har bestemt en mulighed, " siger Ronald Baecker, en professor emeritus i datalogi og forfatter til Computers and Society:Modern Perspectives. Han ser en rolle for regeringen med at rette op på de samfundsmæssige uligheder, uretfærdigheder og skævheder forbundet med kunstig intelligens ved, for eksempel, opsætning af beskyttelse for medarbejdere, der vælger at udtale sig imod partiske eller uretfærdige AI-drevne produkter. "Der er behov for mere tænkning og lovgivning med hensyn til begrebet, hvad jeg vil kalde 'samvittighedsnægtelse' af højteknologiske medarbejdere."

Han mener også, at datalogerne, der udvikler smarte teknologier, bør være forpligtet til at studere den samfundsmæssige virkning af et sådant arbejde. "Det er vigtigt, at fagfolk, der arbejder med kunstig intelligens, anerkender deres ansvar, " siger han. "Vi har at gøre med liv-og-død situationer i stadig vigtigere aktiviteter, hvor AI bliver brugt."

Algoritmer, der hjælper dommere med at sætte kaution og dømme kriminelle, kan absorbere langvarige skævheder i retssystemet, såsom at behandle racialiserede mennesker, som om de er mere tilbøjelige til at begå yderligere forbrydelser. Algoritmerne kan markere folk fra visse samfund som at udgøre en for høj risiko til at modtage et banklån. De kan også være bedre til at diagnosticere hudkræft hos hvide mennesker end hos mennesker med mørkere hud, som følge af at være blevet trænet på skævt kildemateriale.

Indsatsen er utrolig høj i sundhedsvæsenet, hvor ulige algoritmer kunne skubbe folk, der tidligere har været dårligt betjent, endnu længere ud i marginerne.

I sit arbejde på U of T og på Vector Institute for Artificial Intelligence, Ghassemi, ligesom andre forskere, gør sig umage med at identificere potentielle skævheder og ulighed i hendes algoritmer. Hun sammenligner anbefalingerne og forudsigelserne fra hendes diagnostiske værktøjer med resultater i den virkelige verden, måling af deres nøjagtighed for forskellige køn, løb, alder og socioøkonomiske faktorer.

I teorien, Canada tilbyder et forspring for forskere, der er interesseret i sundhedsapplikationer, der afspejler værdier om retfærdighed, mangfoldighed og inklusion. Vores universelle sundhedssystem skaber et lager af elektroniske sundhedsjournaler, der giver et væld af medicinske data, der kan bruges til at træne AI-drevne applikationer. Dette potentiale trak Ghassemi til Toronto. Men teknologien, Information, formatering og regler for adgang til disse registreringer varierer fra provins til provins, gør det kompliceret at skabe den slags datasæt, der kan bringe forskningen fremad.

Ghassemi var også overrasket over at erfare, at disse optegnelser kun sjældent indeholder data om race. Det betyder, at hvis hun bruger en algoritme til at bestemme, hvor godt en given behandling tjener forskellige sektorer af samfundet, hun kunne identificere forskelle mellem mænd og kvinder, for eksempel, men ikke mellem hvide mennesker og raciserede mennesker. Som resultat, i hendes undervisning og forskning, hun bruger offentligt tilgængelige amerikanske data, der indeholder information om race.

"Revision af mine egne modeller [ved hjælp af amerikanske data], Jeg kan vise, når noget har større unøjagtighed for mennesker med forskellig etnicitet, " siger hun. "Jeg kan ikke foretage denne vurdering i Canada. Der er ingen måde for mig at tjekke."

Ghassemi er interesseret i at skabe AI-applikationer, der er retfærdige i deres egen ret - og som også kan hjælpe mennesker med at modvirke deres egne skævheder. "Hvis vi kan levere værktøjer baseret på store forskellige befolkningsgrupper, vi giver lægerne noget, der vil hjælpe dem med at træffe bedre valg, " hun siger.

Kvinder, for eksempel, er betydeligt underdiagnosticeret for hjertesygdomme. En AI kunne markere en sådan fare for en læge, der kunne overse den. "Det er et sted, hvor en teknologisk løsning kan hjælpe, fordi læger er mennesker, og mennesker er partiske, " hun siger.

Ethayarajh er enig med Ghassemi og Baecker i, at Canada har en vigtig mulighed for at presse sin fordel på retfærdighed og bias i kunstig intelligens-forskning.

"Jeg tror, at AI-forskere her er meget opmærksomme på problemet, " siger Ethayarajh. "Jeg tror, at en del af det er, hvis du ser dig omkring på kontoret, du ser mange forskellige ansigter. De mennesker, der arbejder på disse modeller, vil være slutbrugere af disse modeller. Mere bredt, Jeg synes, der er et meget stærkt kulturelt fokus på retfærdighed, der gør dette til et vigtigt område for forskere her i landet."

Varme artikler

Varme artikler

-

Førstedame indkalder teknologivirksomheder for at tackle cybermobningI denne 5. feb. 2018 foto, Førstedame Melania Trump lytter, mens hun mødes med personale på Cincinnati Childrens Hospital Medical Center, i Cincinnati. Førstedame Melania Trump samler teknologigigante

Førstedame indkalder teknologivirksomheder for at tackle cybermobningI denne 5. feb. 2018 foto, Førstedame Melania Trump lytter, mens hun mødes med personale på Cincinnati Childrens Hospital Medical Center, i Cincinnati. Førstedame Melania Trump samler teknologigigante -

Lufthansa stiger til rekordoverskud i 2017Fortjenesten blev yderligere forstærket af den fulde integration af Brussels Airlines i Lufthansas forretning. Den tyske flyselskabsgigant Lufthansa rapporterede om rekordoverskud for 2017 torsdag

Lufthansa stiger til rekordoverskud i 2017Fortjenesten blev yderligere forstærket af den fulde integration af Brussels Airlines i Lufthansas forretning. Den tyske flyselskabsgigant Lufthansa rapporterede om rekordoverskud for 2017 torsdag -

Facebook forsvarer datadeling efter ny rapport om partneraftalerFacebook er under skærpet undersøgelse af sin datapraksis efter nylige rapporter om sine aftaler, der giver tekniske partnere adgang til private brugeroplysninger Facebook forsvarede sin praksis f

Facebook forsvarer datadeling efter ny rapport om partneraftalerFacebook er under skærpet undersøgelse af sin datapraksis efter nylige rapporter om sine aftaler, der giver tekniske partnere adgang til private brugeroplysninger Facebook forsvarede sin praksis f -

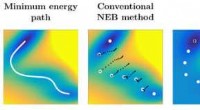

Algoritmer hjælper med at finde minimale energibaner og sadelpunkter mere effektivtKredit:J. Chem. Fys. 147, 152720 (2017), AIP Publishing Olli-Pekka Koistinen, doktorand ved Aalto University, udviklet maskinlæringsalgoritmer baseret på gaussisk procesregression for at forbedre

Algoritmer hjælper med at finde minimale energibaner og sadelpunkter mere effektivtKredit:J. Chem. Fys. 147, 152720 (2017), AIP Publishing Olli-Pekka Koistinen, doktorand ved Aalto University, udviklet maskinlæringsalgoritmer baseret på gaussisk procesregression for at forbedre

- Forskellige typer anemometer

- Forskere afslører hovedårsagen til resistens i faste elektrolytter

- Forskere genoplivede en Wrangel Island mammut muterede gener

- Ny undersøgelse undersøger sammenhængen mellem race, etnicitet og eksklusiv disciplineringspraksi…

- Maskinlæring kunne hjælpe med at søge efter gravitationsbølger

- Nye Hubble-data tyder på, at der mangler en ingrediens i de nuværende teorier om mørkt stof