En dyb læringsteknik til kontekstbevidst følelsesgenkendelse

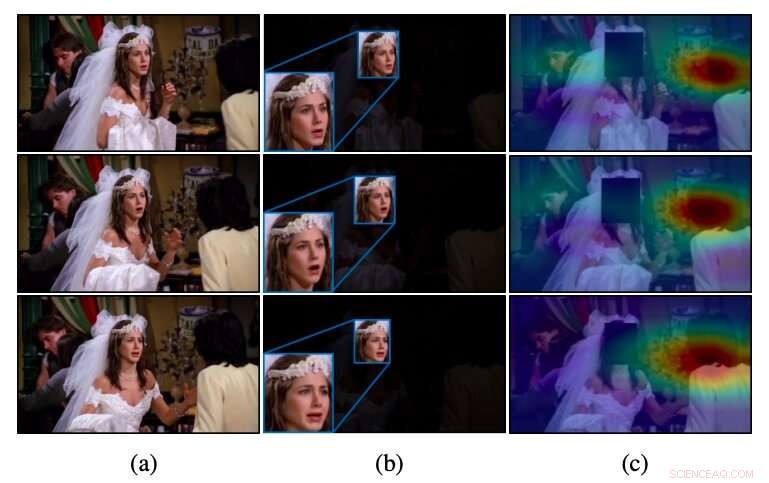

Intuition af CAER-Net til uprimede videoer, som i (a) konventionelle metoder, der kun udnytter ansigtsområderne, som i (b), ofte ikke genkender følelser. I modsætning til disse metoder, CAER-Net fokuserer på både ansigt og opmærksom kontekstområder, som vist i (c). Kredit:Lee et al.

Et team af forskere ved Yonsei University og École Polytechnique Fédérale de Lausanne (EPFL) har for nylig udviklet en ny teknik, der kan genkende følelser ved at analysere folks ansigter i billeder sammen med kontekstuelle funktioner. De præsenterede og skitserede deres dybe læringsbaserede arkitektur, kaldet CAER-Net, i et papir, der på forhånd blev offentliggjort på arXiv.

For flere år, forskere verden over har forsøgt at udvikle værktøjer til automatisk at opdage menneskelige følelser ved at analysere billeder, videoer eller lydklip. Disse værktøjer kan have mange applikationer, for eksempel, forbedre robot-menneskelige interaktioner eller hjælpe læger med at identificere tegn på psykiske eller neurale lidelser (f.eks. , baseret på atypiske talemønstre, ansigtstræk, etc.).

Indtil nu, de fleste teknikker til genkendelse af følelser i billeder har været baseret på analysen af folks ansigtsudtryk, hovedsageligt forudsat at disse udtryk bedst formidler menneskers følelsesmæssige reaktioner. Som resultat, de fleste datasæt til træning og evaluering af følelsesgenkendelsesværktøjer (f.eks. AFEW- og FER2013 -datasættene) indeholder kun beskårne billeder af menneskelige ansigter.

En central begrænsning af konventionelle følelsesgenkendelsesværktøjer er, at de ikke opnår tilfredsstillende præstationer, når følelsesmæssige signaler i menneskers ansigter er tvetydige eller ikke kan skelnes. I modsætning til disse fremgangsmåder, mennesker er i stand til at genkende andres følelser, ikke kun baseret på deres ansigtsudtryk, men også på kontekstuelle spor (f.eks. de handlinger, de udfører, deres interaktion med andre, hvor de er, etc.).

Tidligere undersøgelser tyder på, at analyse af både ansigtsudtryk og kontekstrelaterede funktioner betydeligt kan øge ydelsen af følelsesgenkendelsesværktøjer. Inspireret af disse fund, forskerne ved Yonsei og EPFL satte sig for at udvikle en dyb læringsbaseret arkitektur, der kan genkende folks følelser i billeder baseret på både deres ansigtsudtryk og kontekstuelle oplysninger.

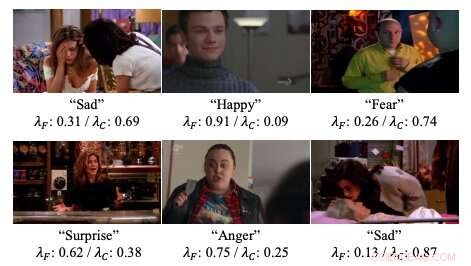

Eksempler på opmærksomhedsvægte i neurale netværk udviklet af forskerne. Kredit:Lee et al.

"Vi præsenterer dybe netværk til kontekstbevidst følelsesgenkendelse, kaldet CAER-Net, der udnytter ikke kun menneskeligt ansigtsudtryk, men også kontekstinformation, på en fælles og boostende måde, "forskerne skrev i deres papir." Nøgletanken er at skjule menneskers ansigter i en visuel scene og søge andre sammenhænge baseret på en opmærksomhedsmekanisme. "

CAER-Net, arkitekturen udviklet af forskere, består af to centrale undernetværk og encodere, der separat udtrækker ansigtstræk og kontekstuelle områder i et billede. Disse to typer funktioner kombineres derefter ved hjælp af adaptive fusionsnetværk og analyseres sammen for at forudsige menneskers følelser i et givet billede.

Ud over CAER-Net, forskerne introducerede også et nyt datasæt til kontekstbevidst følelsesgenkendelse, som de omtaler som CAER. Billeder i dette datasæt skildrer både menneskers ansigter og deres omgivelser/kontekst, derfor kunne det tjene som et mere effektivt benchmark for træning i evaluering af teknikker til følelsesgenkendelse.

Forskerne evaluerede deres følelsesgenkendelsesteknik i en række eksperimenter, ved hjælp af både det datasæt, de har udarbejdet, og AFEW -datasættet. Deres fund tyder på, at analyse af både ansigtsudtryk og kontekstuel information kan øge ydelsen af følelsesgenkendelsesværktøjer betydeligt, som det fremgår af tidligere undersøgelser.

"Vi håber, at resultaterne af denne undersøgelse vil lette yderligere fremskridt inden for kontekstbevidst følelsesgenkendelse og dens relaterede opgaver, "skrev forskerne.

© 2019 Science X Network

Sidste artikelForskere udvikler laveffekt, billigt netværk til 5G-forbindelse

Næste artikelSmart software til smarte enheder

Varme artikler

Varme artikler

-

Hvordan vejnettet bestemmer trafikkapacitetenRosengartenstrasse, Zürich. Det er nu muligt at bruge en bys infrastruktur til at estimere antallet af biler, den kan håndtere, før trængsel begynder at bygge op. Kredit:Keystone/Ennio Leanza ETH

Hvordan vejnettet bestemmer trafikkapacitetenRosengartenstrasse, Zürich. Det er nu muligt at bruge en bys infrastruktur til at estimere antallet af biler, den kan håndtere, før trængsel begynder at bygge op. Kredit:Keystone/Ennio Leanza ETH -

Bilproducenter rapporterer om lavere amerikansk bilsalg i 1. kvartal på grund af virushitLandsdækkende nedlukninger hærger den amerikanske økonomi, og bilproducenter er ikke immune Bilproducenter rapporterede om lavere salg i USA onsdag, med indkøb, der dykkede i marts, da coronavirus

Bilproducenter rapporterer om lavere amerikansk bilsalg i 1. kvartal på grund af virushitLandsdækkende nedlukninger hærger den amerikanske økonomi, og bilproducenter er ikke immune Bilproducenter rapporterede om lavere salg i USA onsdag, med indkøb, der dykkede i marts, da coronavirus -

Undersøgelse tyder på, at elbiler ikke er en fare for mennesker med pacemakereKredit:CC0 Public Domain Et internationalt team af forskere har udført tests for at afgøre, om elektromagnetiske bølger fra elektriske køretøjer eller ladestationer kan forårsage problemer for men

Undersøgelse tyder på, at elbiler ikke er en fare for mennesker med pacemakereKredit:CC0 Public Domain Et internationalt team af forskere har udført tests for at afgøre, om elektromagnetiske bølger fra elektriske køretøjer eller ladestationer kan forårsage problemer for men -

Virtual reality gør sprøjt, men ikke klar til prime timeKredit:CC0 Public Domain Virtual reality viste sin spektakulære side frem på Consumer Electronics Show i denne uge, whisking folk på hockeyarenaer, baseballbaner og endda ind på internettet med ani

Virtual reality gør sprøjt, men ikke klar til prime timeKredit:CC0 Public Domain Virtual reality viste sin spektakulære side frem på Consumer Electronics Show i denne uge, whisking folk på hockeyarenaer, baseballbaner og endda ind på internettet med ani

- Kinas planer om at løse månens mysterier

- Fugl med høj, seglformet næb afslører skjult mangfoldighed i dinosaurernes tidsalder

- Carbon nanorør transistorer kan føre til billige, fleksibel elektronik

- Skift på nordpolen

- Opstart af flyvende biler støttet af Googles grundlægger tilbyder testflyvninger

- Arktisk issmeltning ændrer havstrømme