Når det kommer til robotter, pålidelighed kan have mere betydning end ræsonnement

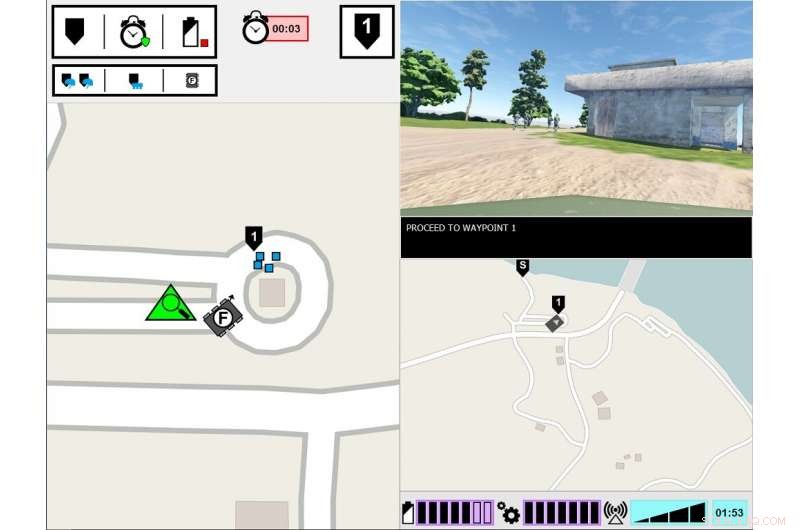

ASM eksperimentel grænseflade. Skærmen i venstre side viser den ledende soldats synspunkt på opgavemiljøet. Skærmen i højre side viser ASM's kommunikationsgrænseflade. Kredit:US Army

Hvad skal der til for at et menneske kan stole på en robot? Det er, hvad hærens forskere afslører i en ny undersøgelse af, hvordan mennesker og robotter arbejder sammen.

Forskning i team af mennesker og agenter, eller HAT, har undersøgt, hvordan gennemsigtigheden af agenter - såsom robotter, ubemandede køretøjer eller softwareagenter - påvirker menneskelig tillid, opgavens udførelse, arbejdsbyrde og opfattelse af agenten. Agent gennemsigtighed refererer til dens evne til at formidle sin hensigt til mennesker, ræsonnement og fremtidsplaner.

Ny hær-ledet forskning finder, at menneskelig tillid til robotter falder, efter at robotten begår en fejl, selv når den er gennemsigtig med sin ræsonnementsproces. Papiret, "Agentgennemsigtighed og pålidelighed i menneske-robot-interaktion:Indflydelsen på brugernes tillid og opfattet pålidelighed, "er blevet offentliggjort i august -udgaven af IEEE-transaktioner på mennesker-maskinesystemer .

Til dato, forskning har stort set fokuseret på HAT med fuldstændig pålidelige intelligente agenter - hvilket betyder, at agenterne ikke laver fejl - men dette er en af de få undersøgelser, der har undersøgt, hvordan agentgennemsigtighed interagerer med agentens pålidelighed. I denne seneste undersøgelse, mennesker var vidne til en robot, der begik en fejl, og forskere fokuserede på, om mennesker opfattede robotten som mindre pålidelig, selv da mennesket fik indsigt i robotens ræsonneringsproces.

"At forstå, hvordan robotens adfærd påvirker deres menneskelige holdkammerater, er afgørende for udviklingen af effektive human-robot-teams, samt design af grænseflader og kommunikationsmetoder mellem teammedlemmer, "sagde Dr. Julia Wright, hovedforsker for dette projekt og forsker ved US Army Combat Capabilities Development Command's Army Research Laboratory, også kendt som ARL. "Denne forskning bidrager til hærens multi-domæneoperationer bestræbelser på at sikre overmatch i kunstig intelligens-aktiverede kapaciteter. Men det er også tværfagligt, da dens resultater vil informere psykologers arbejde, robotikere, ingeniører, og systemdesignere, der arbejder på at lette en bedre forståelse mellem mennesker og autonome agenter i bestræbelserne på at lave autonome holdkammerater frem for blot værktøjer.

Denne forskning var en fælles indsats mellem ARL og University of Central Florida Institute for Simulations and Training, og er den tredje og sidste undersøgelse i projektet Autonomous Squad Member (ASM), sponsoreret af Office of Defence Secretary's Autonomy Research Pilot Initiative. ASM er en lille jordrobot, der interagerer med og kommunikerer med et infanterihold.

Tidligere ASM -undersøgelser undersøgte, hvordan en robot ville kommunikere med en menneskelig holdkammerat. Brug af den situationsbevidsthedsbaserede Agent Transparency-model som en vejledning, forskellige visualiseringsmetoder til at formidle agentens mål, hensigter, ræsonnement, begrænsninger, og forventede resultater blev undersøgt og testet. Et ikonografisk modul med ét overblik blev udviklet baseret på disse tidlige undersøgelsesresultater, og blev derefter brugt i efterfølgende undersøgelser til at undersøge effektiviteten af gennemsigtighed af midler i HAT.

Forskere gennemførte denne undersøgelse i et simuleret miljø, hvor deltagerne observerede et human-agent soldathold, som omfattede ASM, krydser et uddannelsesforløb. Deltagernes opgave var at overvåge teamet og evaluere robotten. Soldat-robot-teamet stødte på forskellige begivenheder under kurset og reagerede derefter. Mens soldaterne altid reagerede korrekt på begivenheden, lejlighedsvis misforstod robotten situationen, fører til forkerte handlinger. Mængden af information, robotten delte, varierede mellem forsøgene. Mens robotten altid forklarede sine handlinger, årsagerne bag dens handlinger og det forventede resultat af sine handlinger, i nogle forsøg delte robotten også ræsonnementet bag sine beslutninger, dens underliggende logik. Deltagerne så flere soldat-robothold, og deres vurderinger af robotterne blev sammenlignet.

Undersøgelsen fandt, at uanset robotens gennemsigtighed i forklaringen af dens ræsonnement, robotens pålidelighed var den ultimative afgørende faktor for at påvirke deltagernes fremskrivninger af robotens fremtidige pålidelighed, tillid til robotten og opfattelsen af robotten. Det er, efter at deltagerne var vidne til en fejl, de fortsatte med at vurdere robotens pålidelighed lavere, selv når robotten ikke lavede nogen efterfølgende fejl. Selvom disse evalueringer langsomt forbedrede sig over tid, så længe robotten ikke begik yderligere fejl, deltagernes tillid til deres egne vurderinger af robotens pålidelighed forblev sænket gennem resten af forsøgene, sammenlignet med deltagere, der aldrig så en fejl. Desuden, deltagere, der var vidne til en robotfejl, rapporterede om lavere tillid til robotten, sammenlignet med dem, der aldrig var vidne til en robotfejl.

Øget agentgennemsigtighed viste sig at forbedre deltagernes tillid til robotten, men kun da robotten indsamlede eller filtrerede oplysninger. Dette kan indikere, at deling af dybdegående oplysninger kan afbøde nogle af virkningerne af upålidelig automatisering til specifikke opgaver, Sagde Wright. Derudover deltagerne vurderede den upålidelige robot som mindre animeret, sympatisk, intelligent, og sikker end den pålidelige robot.

"Tidligere undersøgelser tyder på, at kontekst er vigtig for at bestemme nytten af gennemsigtighedsinformation, "Sagde Wright." Vi skal bedre forstå, hvilke opgaver der kræver mere dybdegående forståelse af agentens ræsonnement, og hvordan man kan skelne, hvad den dybde ville indebære. Fremtidig forskning bør undersøge måder at levere gennemsigtighedsinformation baseret på opgavekravene. "

Varme artikler

Varme artikler

-

kræsen, sulten, eller har smerter? Forskere skaber et AI-værktøj til at fortælle babyer, at de g…Kredit:CC0 Public Domain Alle forældre kender frustrationen ved at reagere på en babys gråd, spekulerer på, om deres barn er sulten, våd, træt, trænger til et kram, eller måske endda i smerte. En

kræsen, sulten, eller har smerter? Forskere skaber et AI-værktøj til at fortælle babyer, at de g…Kredit:CC0 Public Domain Alle forældre kender frustrationen ved at reagere på en babys gråd, spekulerer på, om deres barn er sulten, våd, træt, trænger til et kram, eller måske endda i smerte. En -

Frankrigs lufttrafik ansvarlig for tredjedel af Europas forsinkelser:rapportFransk flyvekontrol er ansvarlig for en tredjedel af forsinkelserne i Europa, ifølge en senatsrapport Hindret af strejker og forældet udstyr, Fransk flyvekontrol er ansvarlig for en tredjedel af l

Frankrigs lufttrafik ansvarlig for tredjedel af Europas forsinkelser:rapportFransk flyvekontrol er ansvarlig for en tredjedel af forsinkelserne i Europa, ifølge en senatsrapport Hindret af strejker og forældet udstyr, Fransk flyvekontrol er ansvarlig for en tredjedel af l -

At se, hvordan computere tænker, hjælper mennesker med at stoppe maskiner og afslører AI-svaghede…Kredit:University of Maryland Den kunstige intelligenss hellige gral er en maskine, der virkelig forstår menneskeligt sprog og fortolker mening ud fra kompleks, nuancerede passager. Da IBMs Watson

At se, hvordan computere tænker, hjælper mennesker med at stoppe maskiner og afslører AI-svaghede…Kredit:University of Maryland Den kunstige intelligenss hellige gral er en maskine, der virkelig forstår menneskeligt sprog og fortolker mening ud fra kompleks, nuancerede passager. Da IBMs Watson -

Den anden virustrussel:stigning i cyberangreb med COVID-temaCyberangreb præger folks frygt og angst for coronavirus-epidemien, siger sikkerhedseksperter Det kan ligne en e-mail fra en vejleder med en vedhæftet fil om den nye arbejde hjemmefra-politik. Men

Den anden virustrussel:stigning i cyberangreb med COVID-temaCyberangreb præger folks frygt og angst for coronavirus-epidemien, siger sikkerhedseksperter Det kan ligne en e-mail fra en vejleder med en vedhæftet fil om den nye arbejde hjemmefra-politik. Men

- Asteroide minedrift kan starte om 10-20 år fra nu, siger brancheekspert

- Vedvarende opløsningsmidler afledt af lignin sænker spild i biobrændstofproduktion

- Ekstraordinært tykke organiske lysemitterende dioder løser nagende problemer

- BASF for at begrænse brugen af ægskandale pesticider

- Video:Hvordan kemi kan forbedre billige varm kakao

- Amerikansk affald, der driver global affaldsoverflod:undersøgelse