At se, hvordan computere tænker, hjælper mennesker med at stoppe maskiner og afslører AI-svagheder

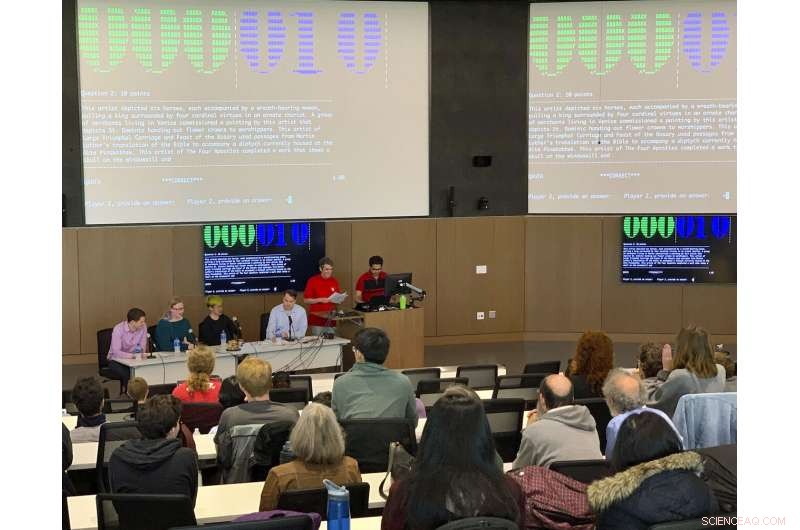

Kredit:University of Maryland

Den kunstige intelligenss hellige gral er en maskine, der virkelig forstår menneskeligt sprog og fortolker mening ud fra kompleks, nuancerede passager. Da IBMs Watson-computer slog den berømte "Jeopardy!" mester Ken Jennings i 2011, det virkede som om, at den milepæl var nået. Imidlertid, enhver, der har prøvet at føre en samtale med den virtuelle assistent Siri, ved, at computere har en lang vej at gå for virkelig at forstå menneskeligt sprog. For at blive bedre til at forstå sprog, edb -systemer skal træne ved hjælp af spørgsmål, der udfordrer dem og afspejler kompleksiteten af menneskeligt sprog.

Forskere fra University of Maryland har fundet ud af, hvordan man pålideligt kan skabe sådanne spørgsmål gennem et menneske-computer-samarbejde, udvikle et datasæt på mere end 1, 200 spørgsmål, der mens det er nemt for folk at svare, stump de bedste computersvarersystemer i dag. Det system, der lærer at mestre disse spørgsmål, vil have en bedre sprogforståelse end noget system, der findes i øjeblikket. Arbejdet er beskrevet i en artikel offentliggjort i 2019-udgaven af tidsskriftet Transaktioner af Foreningen for Datalingvistik .

"De fleste spørgsmål, der besvarer edb-systemer, forklarer ikke, hvorfor de svarer, som de gør, men vores arbejde hjælper os med at se, hvad computere rent faktisk forstår, " sagde Jordan Boyd-Graber, lektor i datalogi ved UMD og seniorforfatter af papiret. "Ud over, vi har produceret et datasæt til at teste på computere, som vil afsløre, om et computersprogsystem rent faktisk læser og laver den samme slags behandling, som mennesker er i stand til at gøre."

Det mest aktuelle arbejde med at forbedre programmer til besvarelse af spørgsmål bruger enten menneskelige forfattere eller computere til at generere spørgsmål. Den iboende udfordring i disse tilgange er, at når mennesker skriver spørgsmål, de ved ikke, hvilke specifikke elementer i deres spørgsmål, der forvirrer computeren. Når computere skriver spørgsmålene, enten skriver de formel, udfyld de tomme spørgsmål eller lav fejl, nogle gange genererer nonsens.

For at udvikle deres nye tilgang til mennesker og computere, der arbejder sammen om at generere spørgsmål, Boyd-Graber og hans team skabte en computergrænseflade, der afslører, hvad en computer "tænker", når en menneskelig forfatter skriver et spørgsmål. Forfatteren kan derefter redigere sit spørgsmål for at udnytte computerens svagheder.

I den nye grænseflade, en menneskelig forfatter skriver et spørgsmål, mens computerens gæt vises i rækkefølge på skærmen, og de ord, der fik computeren til at gætte, er fremhævet.

For eksempel, hvis forfatteren skriver "Hvilken komponists variationer over et tema af Haydn var inspireret af Karl Ferdinand Pohl?" og systemet svarer korrekt "Johannes Brahms, " grænsefladen fremhæver ordene "Ferdinand Pohl" for at vise, at denne sætning førte den til svaret. Ved at bruge denne information, forfatteren kan redigere spørgsmålet for at gøre det vanskeligere for computeren uden at ændre spørgsmålets betydning. I dette eksempel, forfatteren erstattede navnet på manden, der inspirerede Brahms, "Karl Ferdinand Pohl, "med en beskrivelse af sit job, "arkivaren for Wiener Musikverein, " og computeren var ikke i stand til at svare korrekt. Eksperter fra menneskelige quizspil kunne stadig nemt besvare det redigerede spørgsmål korrekt.

Ved at arbejde sammen, mennesker og computere pålideligt udviklet 1, 213 computerstumping-spørgsmål, som forskerne testede under en konkurrence, hvor man stillede erfarne menneskelige spillere-fra trivia-hold på ungdomsuniversitetet til "Jeopardy!" mestre - mod computere. Selv det svageste menneskelige hold besejrede det stærkeste computersystem.

"I tre eller fire år, folk har været klar over, at computerspørgsmålsbesvarelsessystemer er meget skrøbelige og meget let kan narre, " sagde Shi Feng, en UMD datalogi kandidatstuderende og en medforfatter af papiret. "Men dette er det første papir, vi er opmærksomme på, som faktisk bruger en maskine til at hjælpe mennesker med at bryde selve modellen."

Forskerne siger, at disse spørgsmål ikke kun vil tjene som et nyt datasæt for dataloger til bedre at forstå, hvor naturlig sprogbehandling fejler, men også som et træningsdatasæt til udvikling af forbedrede maskinlæringsalgoritmer. Spørgsmålene afslørede seks forskellige sprogfænomener, der konsekvent støder computere.

Disse seks fænomener falder i to kategorier. I den første kategori er sproglige fænomener:parafrasering (f.eks. At sige "spring fra et stup" i stedet for "springe fra en klippe"), distraherende sprog eller uventede sammenhænge (såsom en henvisning til en politisk figur, der dukker op i en ledetråd om noget, der ikke er relateret til politik). Den anden kategori omfatter ræsonnement færdigheder:spor, der kræver logik og beregning, mental triangulering af elementer i et spørgsmål, eller sammensætte flere trin for at danne en konklusion.

"Mennesker er i stand til at generalisere mere og se dybere sammenhænge, "Sagde Boyd-Graber." De har ikke den ubegrænsede hukommelse til computere, men de har alligevel en fordel ved at kunne se skoven for træerne. At katalogisere de problemer, computere har, hjælper os med at forstå de problemer, vi skal løse, så vi faktisk kan få computere til at begynde at se skoven gennem træerne og besvare spørgsmål på den måde, mennesker gør. "

Der er lang vej igen, før det sker, tilføjede Boyd-Graber, som også har medudnævnelser ved University of Maryland Institute for Advanced Computer Studies (UMIACS) samt UMD's College of Information Studies and Language Science Center. Men dette arbejde giver et spændende nyt værktøj til at hjælpe computerforskere med at nå dette mål.

"Dette papir lægger en forskningsdagsorden for de næste mange år, så vi faktisk kan få computere til at besvare spørgsmål godt, " han sagde.

Varme artikler

Varme artikler

-

Team lander nyt effektivitetsgennembrud for nye solcellematerialerDr. Xiaojing Hao og hendes team har opnået fire effektivitetsrekorder i de seneste to år. Kredit:University of New South Wales UNSW solenergiforsker og Scientia Fellow Dr. Xiaojing Hao og hendes t

Team lander nyt effektivitetsgennembrud for nye solcellematerialerDr. Xiaojing Hao og hendes team har opnået fire effektivitetsrekorder i de seneste to år. Kredit:University of New South Wales UNSW solenergiforsker og Scientia Fellow Dr. Xiaojing Hao og hendes t -

USA ser på alternative sanktioner for Chinas ZTE:RossRoss kaldte det amerikanske handelsunderskud skamfuldt og skammeligt, i mange tilfælde på grund af protektionisme. USAs handelsminister Wilbur Ross sagde mandag, at han ledte efter alternative mid

USA ser på alternative sanktioner for Chinas ZTE:RossRoss kaldte det amerikanske handelsunderskud skamfuldt og skammeligt, i mange tilfælde på grund af protektionisme. USAs handelsminister Wilbur Ross sagde mandag, at han ledte efter alternative mid -

Nordamerikanske bilproducenter opfordrer til, at NAFTA -forhandlingerne genoptagesNordamerikanske bilindustrigrupper offentliggjorde en fælles erklæring, der opfordrede deres regeringer til at opdatere den nordamerikanske frihandelsaftale i kølvandet på stejle tariffer på varer, he

Nordamerikanske bilproducenter opfordrer til, at NAFTA -forhandlingerne genoptagesNordamerikanske bilindustrigrupper offentliggjorde en fælles erklæring, der opfordrede deres regeringer til at opdatere den nordamerikanske frihandelsaftale i kølvandet på stejle tariffer på varer, he -

IBM demonstrerer nyt gennembrud inden for AI -ydelseKredit:IBM IBM har vist et nyt gennembrud inden for AI -ydelse. Ved at bruge machine learning på POWER9 med NVIDIA Tesla V100 GPUer, IBM -teknologi kan nu forudsige sandsynligheden for, at en brug

IBM demonstrerer nyt gennembrud inden for AI -ydelseKredit:IBM IBM har vist et nyt gennembrud inden for AI -ydelse. Ved at bruge machine learning på POWER9 med NVIDIA Tesla V100 GPUer, IBM -teknologi kan nu forudsige sandsynligheden for, at en brug

- Museumsfrivillige opdager nye arter af uddøde hejre på fossilstedet i North Florida

- Ny teknologi til at opdage bitre mandler i realtid

- COVID-19 presser universiteter til at skifte til onlinekurser - men er de klar?

- Undersøgelse giver fingerpeg om, hvordan klimaet påvirkede pandemien i 1918

- Kanoner Four Features of Homeostasis

- Udslip på et atomkraftværk viser potentielle forbrændingsrisici fra et husholdningskemikalie