Wrangling af store data i realtid, praktisk intelligens

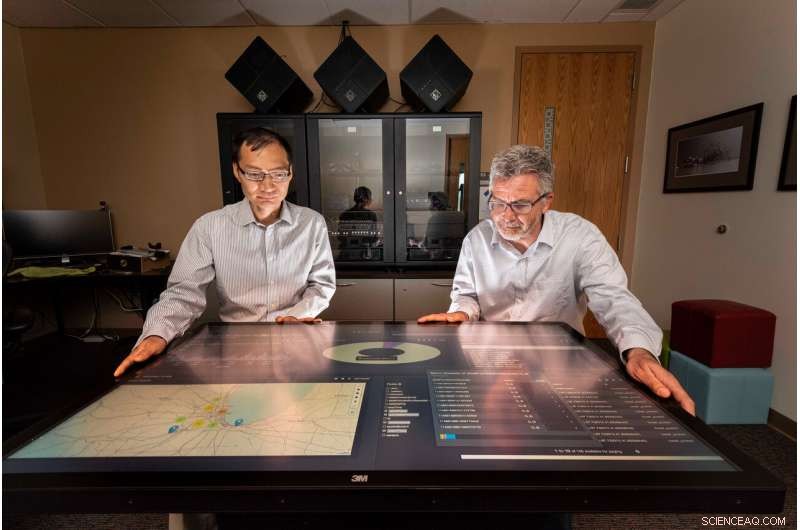

Sandia National Laboratories computerforskere Tian Ma, venstre, og Rudy Garcia, ledet et projekt for at levere praktisk information fra streaming data i næsten realtid. Kredit:Randy Montoya

Sociale medier, kameraer, sensorer og mere genererer enorme mængder data, der kan overvælde analytikere, der siver gennem det hele for meningsfuld, brugbar information til at give beslutningstagere såsom politiske ledere og feltkommandører, der reagerer på sikkerhedstrusler.

Sandia National Laboratories forskere arbejder på at mindske denne byrde ved at udvikle videnskaben til at indsamle indsigt fra data i næsten realtid.

"Mængden af data, der produceres af sensorer og sociale medier, blomstrer - hver dag genereres der omkring 2,5 quintillion (eller 2,5 milliarder milliarder) bytes data, "sagde Tian Ma, en Sandia-computerforsker og projektleder. "Omkring 90% af alle data er blevet genereret i de sidste to år - der er flere data, end vi har folk til at analysere. Efterretningssamfund er dybest set overvældede, og problemet er, at du ender med, at mange data sidder på diske, der kan blive overset. "

Sandia-forskere arbejdede med studerende ved University of Illinois Urbana-Champaign, en Academic Alliance -partner, at udvikle analytiske og beslutningstagende algoritmer til streaming af datakilder og integrere dem i en næsten real-time distribueret databehandlingsramme ved hjælp af store dataværktøjer og computerressourcer hos Sandia. Rammerne tager forskellige data fra flere kilder og genererer brugbar information, der kan reageres på i næsten realtid.

For at teste rammerne, forskerne og de studerende brugte trafikdata fra Chicago såsom billeder, integrerede sensorer, tweets og streamingtekst for med succes at måle trafikbelastning og foreslå hurtigere køreruter rundt om det for en pendler i Chicago. Forskergruppen valgte trafikeksemplet i Chicago, fordi de indtastede data har lignende egenskaber som data, der typisk observeres af nationale sikkerhedsformål, sagde Rudy Garcia, en Sandia-computerforsker og projektleder.

Drukner i data

"Vi opretter data uden selv at tænke over det, "sagde Laura Patrizi, en Sandia -datalog og medlem af forskergruppen, under en tale på United States Geospatial Intelligence Foundations GEOINT Symposium i 2019. "Når vi går rundt med vores telefon i lommen eller tweeter om frygtelig trafik, vores telefon sporer vores placering og kan vedhæfte en geolocation til vores tweet. "

For at udnytte denne data -lavine, analytikere bruger typisk big data -værktøjer og maskinlæringsalgoritmer til at finde og fremhæve væsentlig information, men processen kører på registrerede data, Sagde Ma.

"Vi ville se, hvad der kan analyseres med data i realtid fra flere datakilder, ikke hvad man kan lære af minedrift af historiske data, "Ma sagde." Handlingsbar intelligens er det næste niveau af dataanalyse, hvor analyse tages i brug til næsten real-time beslutningstagning. Succes med denne forskning vil have en stærk indvirkning på mange tidskritiske nationale sikkerhedsprogrammer. "

Opbygning af en databehandlingsramme

Teamet stablede distribuerede teknologier i en række databehandlingsrørledninger, der indtager, kuraterer og indekserer dataene. Forskerne, der vred med dataene, specificerede, hvordan rørledningerne skulle indsamle og rense dataene.

"Hver type data, vi indtager, har sit eget dataskema og format, "Sagde Garcia." For at dataene kan være nyttige, det skal først kurateres, så det let kan opdages til en begivenhed. "

Hortonworks Data Platform, kører på Sandias computere, blev brugt som softwareinfrastruktur til databehandling og analytiske rørledninger. Inden for Hortonworks, teamet udviklede og integrerede Apache Storm -topologier for hver datapipeline. De kuraterede data blev derefter gemt i Apache Solr, en virksomheds søgemaskine og database. PyTorch og Lucidwork's Banana blev brugt til registrering af køretøjsobjekter og datavisualisering.

At finde de rigtige data

"Det er svært at indbringe store mængder data, men det er endnu mere udfordrende at finde de oplysninger, du virkelig leder efter, "Sagde Garcia." F.eks. under projektet ville vi se tweets, der siger noget i stil med "Flyvekontrol har holdt os på jorden den sidste time ved Midway." Trafik er i tweetet, men det er ikke relevant for motorvejstrafik. "

For at bestemme niveauet for trafikpropper på en Chicago -motorvej, ideelt set kunne værktøjet bruge en række datatyper, herunder et trafikkamera, der viser flow i begge retninger, geolokaliserede tweets om ulykker, vejsensorer, der måler gennemsnitshastighed, satellitbilleder af områderne og trafikskilte, der estimerer den aktuelle rejsetid mellem milepæle, sagde Forest Danford, en Sandia -datalog og medlem af forskergruppen.

"Imidlertid, vi får også masser af dårlige data som et webkamera -billede, der er svært at læse, og det er sjældent, at vi ender med mange forskellige datatyper, der er meget tæt placeret i tid og rum, "Danford sagde." Vi havde brug for en mekanisme til at lære om de mere end 90 millioner begivenheder (relateret til trafik i Chicago), vi har observeret for at kunne træffe beslutninger baseret på ufuldstændige eller ufuldkomne oplysninger. "

Teamet tilføjede en trafikpropper -klassifikator ved at træne fusionerede computersystemer, der er modelleret på den menneskelige hjerne, på funktioner udvundet af mærkede billeder og tweets, og andre begivenheder, der svarede til dataene i tid og rum. Den uddannede klassifikator var i stand til at generere forudsigelser om trafikbelastning baseret på driftsdata på et givet tidspunkt og sted, Sagde Danford.

Professorer Minh Do og Ramavarapu Sreenivas og deres studerende på UIUC arbejdede med objektgenkendelse og billedgenkendelse i realtid med web-kamera-billeddannelse og udviklede robuste ruteplanlægningsprocesser baseret på de forskellige datakilder.

"At udvikle kogent videnskab til praktisk intelligens kræver, at vi kæmper med informationsbaseret dynamik, "Sreenivas sagde." Den hellige gral her er at løse specifikationsproblemet. Vi skal vide, hvad vi vil, før vi bygger noget, der giver os, hvad vi vil. Det her er meget sværere end det ser ud til, og dette projekt er det første skridt i at forstå præcis, hvad vi gerne vil have. "

Bevæger sig fremad, Sandia -teamet overfører arkitekturen, analyser og erfaringer fra andre regeringsprojekter i Chicago og vil fortsætte med at undersøge analyseværktøjer, foretage forbedringer af Labs 'objektgenkendelsesmodel og arbejde på at skabe meningsfuld, praktisk intelligens.

"Vi forsøger at gøre data synlige, tilgængelig og anvendelig, "Sagde Garcia." Og hvis vi kan gøre det gennem disse big data -arkitekturer, så tror jeg, vi hjælper. "

Varme artikler

Varme artikler

-

Air New Zealand idømt en bøde i en sag om luftfragtkartel i AustralienAir New Zealand blev idømt en bøde for ulovlige prisaftaler med andre flyselskaber om fragttjenester til Australien Air New Zealand blev onsdag idømt en bøde på 15 millioner USD (11 millioner USD)

Air New Zealand idømt en bøde i en sag om luftfragtkartel i AustralienAir New Zealand blev idømt en bøde for ulovlige prisaftaler med andre flyselskaber om fragttjenester til Australien Air New Zealand blev onsdag idømt en bøde på 15 millioner USD (11 millioner USD) -

Forskere laver en applikation, der sikrer anonymitet og troværdighedForskerne oprettede en internetbrowserudvidelse, der automatisk bekræfter indlægs ægthed. Den kryptografiske signatur, synligt under hvert indlæg til venstre, er skjult, når du kører udvidelsen til hø

Forskere laver en applikation, der sikrer anonymitet og troværdighedForskerne oprettede en internetbrowserudvidelse, der automatisk bekræfter indlægs ægthed. Den kryptografiske signatur, synligt under hvert indlæg til venstre, er skjult, når du kører udvidelsen til hø -

Foto minedriftKredit:CC0 Public Domain Tag ikke andet end minder, efterlad ikke andet end fodaftryk ... at den slidte rejsendes mantra kan moderniseres til at sige tag intet andet end fotos. Ja, moderne rejsend

Foto minedriftKredit:CC0 Public Domain Tag ikke andet end minder, efterlad ikke andet end fodaftryk ... at den slidte rejsendes mantra kan moderniseres til at sige tag intet andet end fotos. Ja, moderne rejsend -

Papirsensorer fjerner stikket af diabetisk testSahika Inal, Shofarul Wustoni og Eloise Bihar (l-r) inspicerer et sæt af de inkjet-printede sensorer. Kredit:2018 KAUST En teknik, der gør det muligt for biologisk aktive enzymer at overleve strab

Papirsensorer fjerner stikket af diabetisk testSahika Inal, Shofarul Wustoni og Eloise Bihar (l-r) inspicerer et sæt af de inkjet-printede sensorer. Kredit:2018 KAUST En teknik, der gør det muligt for biologisk aktive enzymer at overleve strab

- Kelp DNA registrerer ødelæggende kraft ved gammelt jordskælv

- NASA kortlægger overfladeændringer fra jordskælv i Californien

- En solreflektor til Jorden? Forskere udforsker de potentielle risici og fordele

- Bare tilsæt vand og behandle hjernekræft

- Sådan finder du gennemsnitlig atommasse

- Anvendelse af metaller med høj termoelektrisk effektfaktor til at skabe en effektiv hel-solid-state…