Denne AI-fuglekikker lader dig se gennem øjnene på en maskine

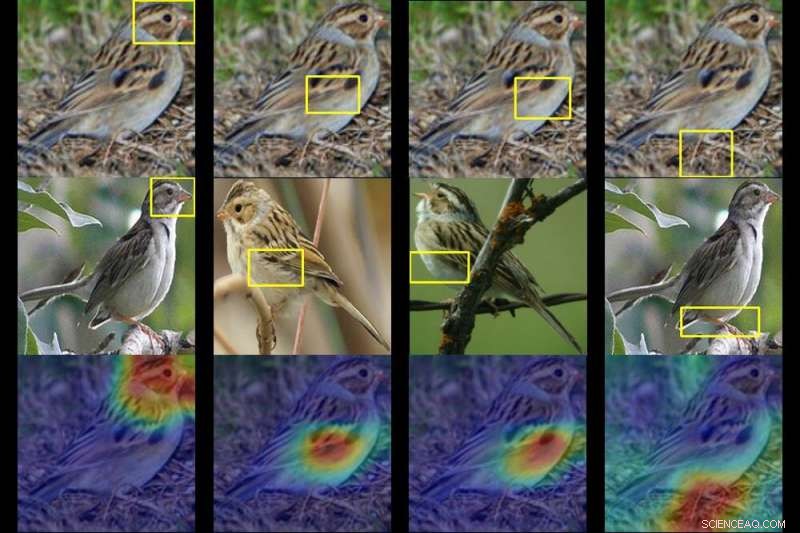

Et Duke-hold trænede en computer til at identificere op til 200 fuglearter fra blot et billede. Givet et billede af en mystisk fugl (øverst), A.I. spytter varmekort ud, der viser, hvilke dele af billedet, der minder mest om typiske artstræk, det har set før. Kredit:Duke University

Det kan tage mange års erfaring med fuglekiggeri at skelne en art fra den næste. Men ved at bruge en kunstig intelligens-teknik kaldet deep learning, Forskere fra Duke University har trænet en computer til at identificere op til 200 fuglearter fra blot et billede.

Den virkelige innovation, imidlertid, er, at A.I. værktøj viser også sin tankegang, på en måde, som selv en, der ikke kender en pingvin fra en lunde, kan forstå.

Holdet trænede deres dybe neurale netværk - algoritmer baseret på den måde, hjernen fungerer på - ved at fodre den 11, 788 billeder af 200 fuglearter at lære af, lige fra svømmeænder til svævende kolibrier.

Forskerne fortalte aldrig netværket "det her er et næb" eller "det er vingefjer." Givet et billede af en mystisk fugl, netværket er i stand til at udvælge vigtige mønstre i billedet og risikere et gæt ved at sammenligne disse mønstre med typiske artstræk, det har set før.

Undervejs spytter den en række varmekort ud, der i det væsentlige siger:"Dette er ikke en hvilken som helst sangfugl. Det er en hættesanger, og her er træk - som dets maskerede hoved og gule mave - der giver det væk."

Duke datalogi Ph.D. studerende Chaofan Chen og undergraduate Oscar Li ledede forskningen, sammen med andre teammedlemmer af Prediction Analysis Lab ledet af Duke professor Cynthia Rudin.

De fandt ud af, at deres neurale netværk er i stand til at identificere den korrekte art op til 84 % af tiden - på niveau med nogle af dets bedst præsterende modparter, som ikke afslører, hvordan de er i stand til at fortælle, sige, den ene spurv fra den næste.

Rudin siger, at deres projekt handler om mere end at navngive fugle. Det handler om at visualisere, hvad dybe neurale netværk virkelig ser, når de ser på et billede.

Lignende teknologi bruges til at tagge folk på sociale netværkssider, spotte mistænkte kriminelle i overvågningskameraer, og træne selvkørende biler til at opdage ting som lyskryds og fodgængere.

Problemet, Rudin siger:er, at de fleste deep learning tilgange til computersyn er notorisk uigennemsigtige. I modsætning til traditionel software, deep learning-software lærer af dataene uden at være eksplicit programmeret. Som resultat, præcis, hvordan disse algoritmer 'tænker', når de klassificerer et billede, er ikke altid klart.

Rudin og hendes kolleger forsøger at vise, at A.I. behøver ikke at være sådan. Hun og hendes laboratorium designer deep learning-modeller, der forklarer ræsonnementet bag deres forudsigelser, gør det klart, præcis hvorfor og hvordan de kom med deres svar. Når en sådan model laver en fejl, dens indbyggede gennemsigtighed gør det muligt at se hvorfor.

Til deres næste projekt, Rudin og hendes team bruger deres algoritme til at klassificere mistænkelige områder i medicinske billeder som mammografi. Hvis det virker, deres system hjælper ikke kun læger med at opdage klumper, forkalkninger og andre symptomer, der kan være tegn på brystkræft. Det vil også vise, hvilke dele af mammogrammet, det går ind på, afsløre, hvilke specifikke træk der ligner mest de kræftlæsioner, den har set før hos andre patienter.

På den måde, Rudin siger:deres netværk er designet til at efterligne den måde, læger stiller en diagnose på. "Det er case-baseret ræsonnement, " sagde Rudin. "Vi håber, at vi bedre kan forklare læger eller patienter, hvorfor deres billede blev klassificeret af netværket som enten ondartet eller godartet."

Holdet præsenterer et papir om deres resultater på den treogtredive konference om neurale informationsbehandlingssystemer (NeurIPS 2019) i Vancouver den 12. december.

Varme artikler

Varme artikler

-

Twitter CEO forsvarer beslutningen om ikke at forbyde Alex Jones, InfowarsI denne tirsdag, 19 juli, 2016 filbillede, Alex Jones, midt til højre, bliver eskorteret af politiet ud af en flok demonstranter uden for det republikanske konvent i Cleveland. Facebook siger, at det

Twitter CEO forsvarer beslutningen om ikke at forbyde Alex Jones, InfowarsI denne tirsdag, 19 juli, 2016 filbillede, Alex Jones, midt til højre, bliver eskorteret af politiet ud af en flok demonstranter uden for det republikanske konvent i Cleveland. Facebook siger, at det -

Facebook tilbyder 100 millioner dollars for at hjælpe virus-ramte nyhedsmedierFacebook forpligter 100 millioner dollars til at hjælpe nyhedsorganisationer, der kæmper som følge af COVID-19-pandemien Facebook sagde mandag, at de donerede 100 millioner dollars til at støtte n

Facebook tilbyder 100 millioner dollars for at hjælpe virus-ramte nyhedsmedierFacebook forpligter 100 millioner dollars til at hjælpe nyhedsorganisationer, der kæmper som følge af COVID-19-pandemien Facebook sagde mandag, at de donerede 100 millioner dollars til at støtte n -

Intet webcam? New Mevo kan udfylde tomrummet og streame til Facebook, Twitter og YouTube© Mevo Mevo Start-kameraet Mevo lille webcam-lignende kamera, opfundet som en ren livestreaming-løsning til dem, der ikke ønskede at bruge deres omfangsrige kameraer eller batteri-udfordrede telef

Intet webcam? New Mevo kan udfylde tomrummet og streame til Facebook, Twitter og YouTube© Mevo Mevo Start-kameraet Mevo lille webcam-lignende kamera, opfundet som en ren livestreaming-løsning til dem, der ikke ønskede at bruge deres omfangsrige kameraer eller batteri-udfordrede telef -

Japans Honda, Hino slutter sig til SoftBank-Toyota mobilitetsprojektI denne 4. okt. 2018, fil foto, Softbank Group Corp.-formand Masayoshi Son, venstre, og Toyota Motor Corp.-præsident Akio Toyoda giver hånd efter deres tale som en del af en fælles pressekonference i

Japans Honda, Hino slutter sig til SoftBank-Toyota mobilitetsprojektI denne 4. okt. 2018, fil foto, Softbank Group Corp.-formand Masayoshi Son, venstre, og Toyota Motor Corp.-præsident Akio Toyoda giver hånd efter deres tale som en del af en fælles pressekonference i

- Jordens geologi Interne processer

- Undersøgelse baner vejen for oprettelse af tænd- og slukknapper til kemiske reaktioner

- Xerox holder fast i HP's tilbud, sætter mandag deadline

- Skylning af nitrogen fra havvandbaserede toiletter

- Hvordan betyder saltvand rustmetaller?

- Guldnanopartikler bringer forskere tættere på en behandling for kræft