Gennemgang af det usynlige net genetisk

Kredit:CC0 Public Domain

Det verdensomspændende web er vokset enormt siden dets akademiske og forskningsmæssige start i 1991, og dens efterfølgende ekspansion til det offentlige og kommercielle domæne. I første omgang, det var et netværk af hyperlinkede sider og andre digitale ressourcer. Meget tidligt, det blev indlysende, at nogle ressourcer var så store, at det ville give mere mening at generere de materialer, som individuelle brugere krævede, dynamisk i stedet for at gemme hver enkelt digital enhed som en unik genstand.

I dag, utallige hjemmesider er dynamiske, hvert unikt besøg trækker information og data dynamisk fra en backend-database og præsenterer det for brugeren on-demand. Hvorimod statiske sider nemt kan spideres af søgemaskiner, databaseindhold, der driver dynamiske websteder, er utilgængeligt. Selv så længe siden som i 2001, hvor der allerede var adskillige terabyte offentligt, statiske webdata, det blev anslået, at det "usynlige web, " eller "skjult web, " ikke at forveksle med "det mørke web, " var omkring 550 gange større end de synlige ressourcer.

Skriver i International Journal of Business Intelligence and Data Mining, et team fra Indien beskriver, hvordan de har udviklet en genetisk algoritme-baseret intelligent multiagent-arkitektur, der kan udtrække oplysninger fra det usynlige web. Værktøjerne kunne tillade selv materialer, der angiveligt er forbudt for konventionelle søgemaskiner, at blive spideret, skrabet, og katalogiseret til en bred vifte af applikationer.

D. Weslin fra Bharathiar University og Joshva Devadas fra Vellore Institute of Technology beskriver detaljerne og fordelene ved deres tilgang i det seneste nummer af tidsskriftet. "De eksperimentelle resultater viser, at den foreslåede arkitektur giver bedre præcision og genkaldelse end de eksisterende webcrawlere, " skriver holdet.

Sidste artikelFiat Chrysler:langvarige virusproblemer kan skade Europa-fabrikken

Næste artikelInkjet printteknologi til batterielementer

Varme artikler

Varme artikler

-

Windows 7, Ford Flex, Yahoo Groups er blandt produkter, der forsvinder i 2020Kredit:CC0 Public Domain I livet, intet varer evigt. Og i 2020 nogle bilkøbere, internetbrugere og ikke-helt-65-årige bliver nødt til at regne med denne hårde sandhed, da en række af de produkter

Windows 7, Ford Flex, Yahoo Groups er blandt produkter, der forsvinder i 2020Kredit:CC0 Public Domain I livet, intet varer evigt. Og i 2020 nogle bilkøbere, internetbrugere og ikke-helt-65-årige bliver nødt til at regne med denne hårde sandhed, da en række af de produkter -

For 2019, smarture er slankere, slicker og bliver mere overkommeligEn ven kiggede for nylig på smarturet på mit håndled og sagde:Hvorfor har du det på? Han holdt sin mobiltelefon op. Dette kan alt, hvad der kan. Mere, faktisk, derfor vil smartwatches aldrig være for

For 2019, smarture er slankere, slicker og bliver mere overkommeligEn ven kiggede for nylig på smarturet på mit håndled og sagde:Hvorfor har du det på? Han holdt sin mobiltelefon op. Dette kan alt, hvad der kan. Mere, faktisk, derfor vil smartwatches aldrig være for -

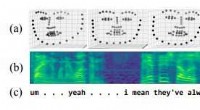

Analyse af talesprog og 3-D ansigtsudtryk for at måle sværhedsgraden af depressionMultimodale data. For hver klinisk samtale, forskerne bruger:(a) video af 3D-ansigtsscanninger, (b) lydoptagelse, visualiseret som et log-mel spektrogram, og (c) teksttransskription af patientens tale

Analyse af talesprog og 3-D ansigtsudtryk for at måle sværhedsgraden af depressionMultimodale data. For hver klinisk samtale, forskerne bruger:(a) video af 3D-ansigtsscanninger, (b) lydoptagelse, visualiseret som et log-mel spektrogram, og (c) teksttransskription af patientens tale -

Virtuel virkelighed:En revolutionerende revolution inden for eSportSpillere, der kommer op af sofaen, er et tema for dette års Paris Games Week Indkapslet i headset og med elektroniske replikaer af våben i hænderne, spillerne strejfer rundt på arenaen, dukker dig

Virtuel virkelighed:En revolutionerende revolution inden for eSportSpillere, der kommer op af sofaen, er et tema for dette års Paris Games Week Indkapslet i headset og med elektroniske replikaer af våben i hænderne, spillerne strejfer rundt på arenaen, dukker dig

- Galaktisk vindkvælende stjernedannelse er den fjerneste hidtil set

- Hvordan dinosaurforskning kan hjælpe medicin

- Ujævne havniveaustigninger bundet til klimaændringer

- Mobiltelefontjenesten kan være plettet for formørkende i landdistrikterne

- To bittesmå supercomputing Pioneer nanosatellitter lanceret

- Optiske effekter af den divalente funktionalisering af kulstofnanorør