Folk foretrækker, at robotter forklarer sig selv - og et kort resumé skærer det ikke

En robot og et menneske, der interagerer. Kredit:Tommy Ton, tontommy.com, CC BY-ND

Kunstig intelligens kommer ind i vores liv på mange måder - på vores smartphones, i vores hjem, i vores biler. Disse systemer kan hjælpe folk med at lave aftaler, køre og endda diagnosticere sygdomme. Men da AI -systemer fortsat tjener vigtige og samarbejdende roller i menneskers liv, et naturligt spørgsmål er:Kan jeg stole på dem? Hvordan ved jeg, at de vil gøre, hvad jeg forventer?

Forklarbar AI (XAI) er en gren af AI -forskning, der undersøger, hvordan kunstige midler kan gøres mere gennemsigtige og troværdige for deres menneskelige brugere. Troværdighed er afgørende, hvis robotter og mennesker skal arbejde sammen. XAI søger at udvikle AI -systemer, som mennesker finder pålidelige - samtidig med at de udfører godt for at udføre designede opgaver.

I Center for Vision, Kognition, Læring, og autonomi ved UCLA, vi og vores kolleger er interesserede i, hvilke faktorer der gør maskiner mere troværdige, og hvor godt forskellige læringsalgoritmer muliggør tillid. Vores laboratorium bruger en slags vidensrepræsentation - en verdensmodel, som en AI bruger til at fortolke sine omgivelser og træffe beslutninger - som lettere kan forstås af mennesker. Dette hjælper naturligvis med forklaring og gennemsigtighed, derved forbedre tillid hos mennesker.

I vores seneste forskning, vi eksperimenterede med forskellige måder, hvorpå en robot kunne forklare sine handlinger for en menneskelig observatør. Interessant nok, de forklaringsformer, der skabte mest menneskelig tillid, svarede ikke til de læringsalgoritmer, der gav den bedste opgaveudførelse. Dette tyder på, at præstationer og forklaringer ikke i sagens natur er afhængige af hinanden - optimering til den ene alene fører måske ikke til det bedste resultat for den anden. Denne divergens kræver robottesign, der tager højde for både god opgaveydelse og pålidelige forklaringer.

Undervisning i robotter

Ved gennemførelsen af denne undersøgelse vores gruppe var interesseret i to ting. Hvordan lærer en robot bedst at udføre en bestemt opgave? Derefter, hvordan reagerer folk på robotens forklaring på dens handlinger?

Vi lærte en robot at lære af menneskelige demonstrationer, hvordan man åbner en medicinflaske med en sikkerhedslås. En person bar en taktil handske, der registrerede menneskehåndens positurer og kræfter, da den åbnede flasken. Disse oplysninger hjalp robotten med at lære, hvad mennesket gjorde på to måder:symbolsk og haptisk. Symbolisk refererer til meningsfulde repræsentationer af dine handlinger:f.eks. ordet "greb". Haptisk refererer til de følelser, der er forbundet med din krops holdninger og bevægelser:f.eks. fornemmelsen af at dine fingre lukker sammen.

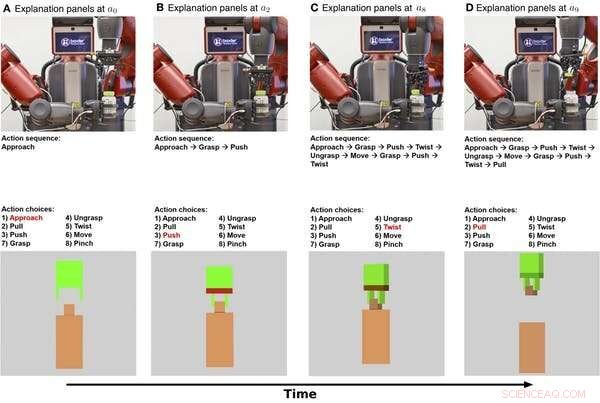

Symboliske og haptiske forklaringer på, at en robot åbner en medicinflaske vist over tid. Den øverste række er stillbilleder fra en video af robotten, der udfører opgaven. Den midterste række viser en symbolsk forklaring på opgaven. Den nederste række viser en haptisk forklaring. Kredit:Edmonds et al., Sci. Robot. 4, eaay4663 (2019)

Først, robotten lærte en symbolsk model, der koder for sekvensen af trin, der er nødvendige for at fuldføre opgaven med at åbne flasken. Sekund, robotten lærte en haptisk model, der gør det muligt for robotten at "forestille sig" sig selv i rollen som den menneskelige demonstrator og forudsige, hvilken handling en person ville tage, når den støder på bestemte stillinger og kræfter.

Det viser sig, at robotten var i stand til at opnå sin bedste ydeevne, når den kombinerede de symbolske og haptiske komponenter. Robotten klarede sig bedre ved at bruge kendskabet til trinene til udførelse af opgaven og sanntidsføling fra dens griber end at bruge enten alene.

At opnå menneskelig tillid

Nu hvor robotten ved, hvad den skal gøre, hvordan kan den forklare sin adfærd for en person? Og hvor godt fremmer den forklaring menneskelig tillid?

For at forklare dens handlinger, robotten kan trække på sin interne beslutningsproces såvel som sin adfærd. Den symbolske model giver trin-for-trin beskrivelser af robotens handlinger, og den haptiske model giver en fornemmelse af, hvad robotgreberen "føler".

I vores eksperiment, vi tilføjede en yderligere forklaring på mennesker:en tekstopskrivning, der gav et resumé, efter at robotten var færdig med at forsøge at åbne medicinflasken. Vi ville se, om resumébeskrivelser ville være lige så effektive som den trinvise symbolsk forklaring på at opnå menneskelig tillid.

Vi spurgte 150 mennesker, opdelt i fire grupper, at observere robotten, der forsøger at åbne medicinflasken. Robotten gav derefter hver gruppe en anden forklaring på opgaven:symbolsk, trin for trin, haptisk - armpositioner og bevægelser, tekstoversigt, eller symbolsk og haptisk sammen. En baseline -gruppe observerede kun en video af robotten, der forsøgte at åbne flasken, uden at give yderligere forklaringer.

Vi fandt ud af, at både de symbolske og haptiske forklaringer gav mest tillid, med den symbolske komponent, der bidrager mest. Interessant nok, forklaringen i form af en tekstoversigt skabte ikke mere tillid end blot at se robotten udføre opgaven, hvilket indikerer, at mennesker foretrækker, at robotter giver trin-for-trin forklaringer på, hvad de laver.

UCLA -forskere tester en robot, efter at den har lært, hvordan man åbner en medicinflaske ved at observere menneskelige demonstranter. Kredit:UCLA Samueli School of Engineering, CC BY-ND

Design til både ydeevne og tillid

Det mest interessante resultat af denne forskning er, at det, der får robotter til at fungere godt, ikke er det samme, som får folk til at se dem som troværdige. Robotten havde brug for både de symbolske og haptiske komponenter for at gøre det bedste stykke arbejde. Men det var den symbolske forklaring, der fik folk til at stole mest på robotten.

Denne divergens fremhæver vigtige mål for fremtidig AI- og robotforskning:at fokusere på at forfølge både opgaveudførelse og forklarelighed. Kun fokusering på opgaveudførelse kan ikke føre til en robot, der forklarer sig godt. Vores laboratorium bruger en hybridmodel til at levere både højtydende og pålidelige forklaringer.

Ydeevne og forklaring supplerer ikke naturligt hinanden, så begge mål skal prioriteres fra starten, når man bygger AI -systemer. Dette arbejde repræsenterer et vigtigt skridt i systematisk at studere hvordan mennesker-maskine relationer udvikler sig, men der skal gøres meget mere. Et udfordrende skridt for fremtidig forskning vil være at gå fra "Jeg stoler på, at robotten gør X" til "Jeg stoler på robotten."

For robotter at tjene en plads i folks dagligdag, mennesker har brug for at stole på deres robot -modstykker. At forstå, hvordan robotter kan give forklaringer, der fremmer menneskelig tillid, er et vigtigt skridt i retning af at gøre det muligt for mennesker og robotter at arbejde sammen.

Denne artikel er genudgivet fra The Conversation under en Creative Commons -licens. Læs den originale artikel.

Varme artikler

Varme artikler

-

Aussie vagthund gør klar til at slå ned på Google, FacebookAustraliens konkurrencevagthund er klar til at opfordre til vidtrækkende nye regler for teknologigiganter som Facebook Australiens konkurrencevagthund er klar til at opfordre til vidtrækkende nye

Aussie vagthund gør klar til at slå ned på Google, FacebookAustraliens konkurrencevagthund er klar til at opfordre til vidtrækkende nye regler for teknologigiganter som Facebook Australiens konkurrencevagthund er klar til at opfordre til vidtrækkende nye -

Tekniske ledere presser på for mere fokus på Det Hvide Hus på AII denne 2. april, 2017, fil foto, Det Hvide Hus er oplyst med blåt lys til ære for World Autism Awareness Day i Washington. Top amerikanske tech -chefer og forskere samles på et topmøde i Det Hvide Hu

Tekniske ledere presser på for mere fokus på Det Hvide Hus på AII denne 2. april, 2017, fil foto, Det Hvide Hus er oplyst med blåt lys til ære for World Autism Awareness Day i Washington. Top amerikanske tech -chefer og forskere samles på et topmøde i Det Hvide Hu -

Hurtig opladning beskadiger elbils batterierEt lithium-ion elbilbatteri, der revnede efter hurtig opladning i industristandard. Kredit:Ozkan Lab/UCR Kommercielle hurtigladestationer udsætter elbilbatterier for høje temperaturer og høj modst

Hurtig opladning beskadiger elbils batterierEt lithium-ion elbilbatteri, der revnede efter hurtig opladning i industristandard. Kredit:Ozkan Lab/UCR Kommercielle hurtigladestationer udsætter elbilbatterier for høje temperaturer og høj modst -

Nintendo siger, at de arbejder sammen med Tencent for at frigive Switch i KinaMario fra Super Mario Bros. er allerede en velkendt karakter Den japanske spilgigant Nintendo sagde fredag, at de samarbejder med det kinesiske internetfirma Tencent om at udrulle sin populære Swi

Nintendo siger, at de arbejder sammen med Tencent for at frigive Switch i KinaMario fra Super Mario Bros. er allerede en velkendt karakter Den japanske spilgigant Nintendo sagde fredag, at de samarbejder med det kinesiske internetfirma Tencent om at udrulle sin populære Swi