Autonome køretøjer kan narre til at se ikke-eksisterende forhindringer

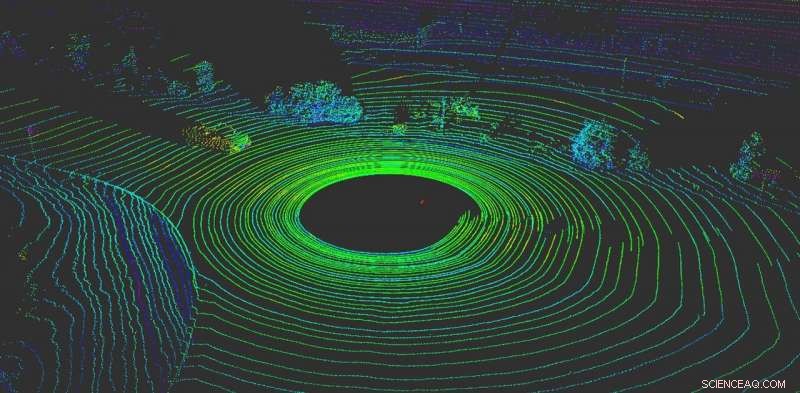

LiDAR hjælper et autonomt køretøj med at 'visualisere', hvad der er omkring det. Kredit:Yulong Can med data fra Baidu Apollo, CC BY-ND

Intet er vigtigere for et autonomt køretøj end at fornemme, hvad der sker omkring det. Ligesom menneskelige chauffører, autonome køretøjer har brug for evnen til at træffe øjeblikkelige beslutninger.

I dag, de fleste autonome køretøjer er afhængige af flere sensorer for at opfatte verden. De fleste systemer bruger en kombination af kameraer, radarsensorer og LiDAR (light detection and rangeing) sensorer. Ombord, computere fusionerer disse data for at skabe et omfattende overblik over, hvad der sker omkring bilen. Uden disse data, autonome køretøjer ville ikke have noget håb om sikkert at navigere i verden. Biler, der bruger flere sensorsystemer, fungerer både bedre og er sikrere - hvert system kan tjene som kontrol for de andre - men intet system er immunt mod angreb.

Desværre, disse systemer er ikke idiotsikre. Kamerabaserede opfattelsessystemer kan narres simpelthen ved at sætte klistermærker på trafikskilte for helt at ændre deres betydning.

Vores arbejde, fra RobustNet Research Group ved University of Michigan, har vist, at det LiDAR-baserede perceptionssystem kan omfattes, også. Ved strategisk at spoofe LiDAR-sensorsignalerne, angrebet er i stand til at narre køretøjets LiDAR-baserede opfattelsessystem til at "se" en ikke-eksisterende hindring. Hvis dette sker, et køretøj kan forårsage et sammenstød ved at blokere trafikken eller bremse brat.

Spoofing af LiDAR-signaler

LiDAR-baserede perceptionssystemer har to komponenter:sensoren og maskinlæringsmodellen, der behandler sensorens data. En LiDAR-sensor beregner afstanden mellem sig selv og dens omgivelser ved at udsende et lyssignal og måle, hvor lang tid det tager for dette signal at hoppe af en genstand og vende tilbage til sensoren. Denne varighed af denne frem og tilbage er også kendt som "flyvetidspunktet."

En LiDAR-enhed udsender titusindvis af lyssignaler i sekundet. Derefter bruger maskinlæringsmodellen de returnerede pulser til at male et billede af verden omkring køretøjet. Det svarer til, hvordan en flagermus bruger ekkolokalisering til at vide, hvor forhindringer er om natten.

Problemet er, at disse impulser kan forfalskes. For at narre sensoren, en angriber kan skinne sit eget lyssignal ved sensoren. Det er alt hvad du behøver for at blande sensoren sammen.

Imidlertid, det er vanskeligere at forfalde LiDAR -sensoren til at "se" et "køretøj", der ikke er der. At lykkes, angriberen skal præcist time de signaler, der er skudt mod offeret LiDAR. Dette skal ske på nanosekundniveau, da signalerne kører med lysets hastighed. Små forskelle vil skille sig ud, når LiDAR'en beregner afstanden ved hjælp af den målte flyvetid.

Hvis en angriber narrer LiDAR -sensoren med succes, den skal så også snyde machine learning-modellen. Arbejde udført i OpenAI -forskningslaboratoriet viser, at maskinlæringsmodeller er sårbare over for specialfremstillede signaler eller input - det, der kaldes modsætningseksempler. For eksempel, specielt genererede klistermærker på trafikskilte kan narre kamerabaseret opfattelse.

Vi fandt ud af, at en angriber kunne bruge en lignende teknik til at lave forstyrrelser, der virker mod LiDAR. De ville ikke være et synligt klistermærke, men forfalskede signaler specielt skabt til at narre maskinindlæringsmodellen til at tro, at der er forhindringer til stede, når der faktisk ikke er nogen. LiDAR -sensoren føder hackers falske signaler til maskinindlæringsmodellen, som vil genkende dem som en hindring.

Det modstridende eksempel - det falske objekt - kunne udformes til at opfylde forventningerne til maskinlæringsmodellen. For eksempel, angriberen kan skabe signalet om en lastbil, der ikke bevæger sig. Derefter, at udføre angrebet, de kan sætte den op i et vejkryds eller placere den på et køretøj, der kører foran et selvkørende køretøj.

To mulige angreb

For at demonstrere det designede angreb, vi valgte et autonomt køresystem, der bruges af mange bilproducenter:Baidu Apollo. Dette produkt har over 100 partnere og har indgået en masseproduktionsaftale med flere producenter, herunder Volvo og Ford.

Ved at bruge sensordata fra den virkelige verden indsamlet af Baidu Apollo-teamet, vi demonstrerede to forskellige angreb. Først og fremmest, et "nødbremseangreb, "vi viste, hvordan en angriber pludselig kan standse et køretøj i bevægelse ved at narre det til at tro, at en forhindring dukkede op på dets vej. I det andet, et "AV -fryseangreb, "Vi brugte en forfalsket forhindring til at narre et køretøj, der var blevet stoppet ved et rødt lys, for at forblive stoppet, efter at lyset blev grønt.

Ved at udnytte sårbarhederne ved autonome køreopfattelsessystemer, vi håber at udløse en alarm for teams, der bygger autonome teknologier. Forskning i nye typer sikkerhedsproblemer i de autonome køresystemer er lige begyndt, og vi håber at afdække flere mulige problemer, før de kan udnyttes ude på vejen af dårlige skuespillere.

Denne artikel er genudgivet fra The Conversation under en Creative Commons -licens. Læs den originale artikel.

Varme artikler

Varme artikler

-

Forudsiger forurening med tingenes internetKredit:CC0 Public Domain Nyere forskning tyder på, at hjerteanfald, cerebralt slagtilfælde, og astmaanfald stiger alle med stigende luftforurening i vores byer, og selvfølgelig de bredere probleme

Forudsiger forurening med tingenes internetKredit:CC0 Public Domain Nyere forskning tyder på, at hjerteanfald, cerebralt slagtilfælde, og astmaanfald stiger alle med stigende luftforurening i vores byer, og selvfølgelig de bredere probleme -

At lære at tale igen:livet uden internet i TongaTonga, som ligger næsten 3, 300 kilometer (2, 000 miles) øst for Australien, blev kastet ud i digitalt mørke i fjorten dage Et to ugers cyber-blackout forårsagede økonomisk hovedpine og social hje

At lære at tale igen:livet uden internet i TongaTonga, som ligger næsten 3, 300 kilometer (2, 000 miles) øst for Australien, blev kastet ud i digitalt mørke i fjorten dage Et to ugers cyber-blackout forårsagede økonomisk hovedpine og social hje -

Valutamodvind trænger Bayer i 1. kvartalBayer sikrede sig regulatorisk godkendelse af forbindelsen med Monsanto fra Europa-Kommissionen i marts Det tyske kemikaliefirma Bayer sagde torsdag, at modvind med valutakurser havde undermineret

Valutamodvind trænger Bayer i 1. kvartalBayer sikrede sig regulatorisk godkendelse af forbindelsen med Monsanto fra Europa-Kommissionen i marts Det tyske kemikaliefirma Bayer sagde torsdag, at modvind med valutakurser havde undermineret -

NBC giver pris, detaljer om den nye Peacock-streamingtjenesteLogoet for NBCUniversals kommende streamingtjeneste, Påfugl, vises på en computerskærm torsdag, 16. januar, 2020, i New York. NBCUniversal forventes at afsløre prisen og andre detaljer om Peacock på t

NBC giver pris, detaljer om den nye Peacock-streamingtjenesteLogoet for NBCUniversals kommende streamingtjeneste, Påfugl, vises på en computerskærm torsdag, 16. januar, 2020, i New York. NBCUniversal forventes at afsløre prisen og andre detaljer om Peacock på t

- En ny metode til at forstå gamle møntbilleder

- Eclipse-balloner for at studere effekten af Mars-lignende miljø på livet

- Udbredt database med molekylære fingeraftryk opgraderet

- Alaska Air tilbyder charterflyvning for at se solformørkelse

- Tropisk cyklon Trevor fylder Australias Carpentaria -golf i NASA -billede

- Discovery fremmer ferroelektrik i jagten på transistorer med lavere effekt