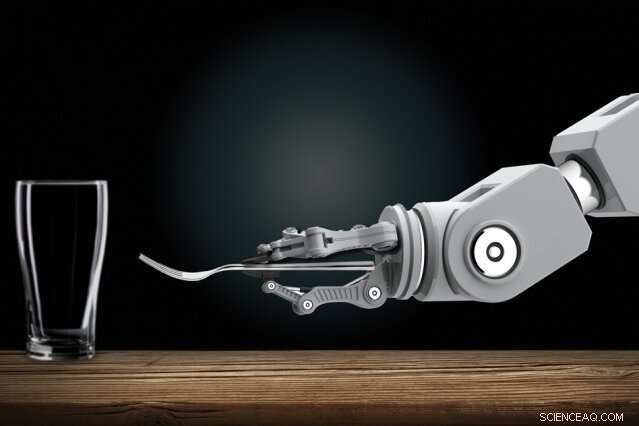

Ved at observere mennesker, robotter lærer at udføre komplekse opgaver, såsom at dække bord

Robotikere udvikler automatiserede robotter, der kan lære nye opgaver udelukkende ved at observere mennesker. Hjemme, du vil måske en dag vise en husrobot, hvordan man udfører rutinemæssige gøremål. Kredit:Christine Daniloff, MIT

At træne interaktive robotter kan en dag blive en nem opgave for alle, selv dem uden programmeringsekspertise. Robotikere udvikler automatiserede robotter, der kan lære nye opgaver udelukkende ved at observere mennesker. Hjemme, du vil måske en dag vise en husrobot, hvordan man udfører rutinemæssige gøremål. På arbejdspladsen, du kunne træne robotter som nye medarbejdere, viser dem, hvordan man udfører mange opgaver.

At gøre fremskridt med denne vision, MIT-forskere har designet et system, der lader disse typer robotter lære komplicerede opgaver, som ellers ville hindre dem med for mange forvirrende regler. En sådan opgave er at dække et middagsbord under visse betingelser.

I sin kerne, forskernes "Planning with Uncertain Specifications" (PUnS) system giver robotter den menneskelignende planlægningsevne til samtidig at veje mange tvetydige – og potentielt modstridende – krav for at nå et slutmål. Derved, systemet vælger altid den mest sandsynlige handling at tage, baseret på en "tro" om nogle sandsynlige specifikationer for den opgave, den skal udføre.

I deres arbejde, forskerne kompilerede et datasæt med information om, hvordan otte objekter - et krus, glas, ske, gaffel, kniv, middagstallerken, lille tallerken, og skål - kunne placeres på et bord i forskellige konfigurationer. En robotarm observerede først tilfældigt udvalgte menneskelige demonstrationer af at dække bordet med genstandene. Derefter, forskerne gav armen til opgave automatisk at sætte et bord i en bestemt konfiguration, i eksperimenter fra den virkelige verden og i simulering, baseret på hvad den havde set.

At lykkes, robotten skulle veje mange mulige placeringsordrer, selv når genstande blev fjernet med vilje, stablet, eller skjult. Normalt, alt det ville forvirre robotter for meget. Men forskernes robot lavede ingen fejl i flere eksperimenter i den virkelige verden, og kun en håndfuld fejl over titusindvis af simulerede testkørsler.

"Visionen er at lægge programmering i hænderne på domæneeksperter, der kan programmere robotter på intuitive måder, i stedet for at beskrive ordrer til en ingeniør om at tilføje til deres kode, " siger førsteforfatter Ankit Shah, en kandidatstuderende i Institut for Luftfart og Astronautik (AeroAstro) og Interactive Robotics Group, som understreger, at deres arbejde kun er et skridt i opfyldelsen af den vision. "Den vej, Robotter skal ikke længere udføre forprogrammerede opgaver. Fabriksarbejdere kan lære en robot at udføre flere komplekse monteringsopgaver. Huslige robotter kan lære at stable skabe, fylde opvaskemaskinen, eller dække bord fra folk derhjemme."

Med Shah på papiret er AeroAstro og Interactive Robotics Group kandidatstuderende Shen Li og Interactive Robotics Group leder Julie Shah, en lektor i AeroAstro og Computer Science and Artificial Intelligence Laboratory.

Bots afdækning af væddemål

Robotter er gode planlæggere i opgaver med klare "specifikationer, "som hjælper med at beskrive den opgave, robotten skal udføre, overvejer sine handlinger, miljø, og slutmål. At lære at dække bord ved at observere demonstrationer, er fuld af usikre specifikationer. Genstande skal placeres på bestemte steder, afhængig af menuen og hvor gæsterne sidder, og i visse rækkefølger, afhængigt af en vares umiddelbare tilgængelighed eller sociale konventioner. Nuværende tilgange til planlægning er ikke i stand til at håndtere sådanne usikre specifikationer.

En populær tilgang til planlægning er "forstærkende læring, " en prøve-og-fejl maskinlæringsteknik, der belønner og straffer dem for handlinger, mens de arbejder på at fuldføre en opgave. Men for opgaver med usikre specifikationer, det er svært at definere klare belønninger og straffe. Kort sagt, robotter lærer aldrig rigtigt fra forkert.

Forskernes system, kaldet PUnS (til planlægning med usikre specifikationer), gør det muligt for en robot at holde en "tro" over en række mulige specifikationer. Selve troen kan så bruges til at uddele belønninger og straffe. "Roboten afdækker i bund og grund sine indsatser i forhold til, hvad der er tilsigtet med en opgave, og tager handlinger, der tilfredsstiller dens tro, i stedet for at vi giver det en klar specifikation, " siger Ankit Shah.

Systemet er bygget på "lineær tidslogik" (LTL), et udtryksfuldt sprog, der muliggør robot-ræsonnement om nuværende og fremtidige resultater. Forskerne definerede skabeloner i LTL, der modellerer forskellige tidsbaserede forhold, som hvad der skal ske nu, skal til sidst ske, og skal ske, indtil der sker noget andet. Robottens observationer af 30 menneskelige demonstrationer til opstilling af bordet gav en sandsynlighedsfordeling over 25 forskellige LTL-formler. Hver formel kodede en lidt anden præference - eller specifikation - til opstilling af tabellen. Den sandsynlighedsfordeling bliver dens tro.

"Hver formel koder for noget forskelligt, men når robotten overvejer forskellige kombinationer af alle skabelonerne, og forsøger at tilfredsstille alt sammen, det ender med at gøre det rigtige til sidst, " siger Ankit Shah.

Følgende kriterier

Forskerne udviklede også flere kriterier, der guider robotten mod at tilfredsstille hele troen på disse kandidatformler. En, for eksempel, opfylder den mest sandsynlige formel, som kasserer alt andet bortset fra skabelonen med størst sandsynlighed. Andre opfylder det største antal unikke formler, uden at overveje deres samlede sandsynlighed, eller de opfylder flere formler, der repræsenterer højeste samlede sandsynlighed. En anden minimerer simpelthen fejl, så systemet ignorerer formler med høj sandsynlighed for fejl.

Designere kan vælge et af de fire kriterier, der skal forudindstilles før træning og test. Hver har sin egen afvejning mellem fleksibilitet og risikoaversion. Valget af kriterier afhænger helt af opgaven. I sikkerhedskritiske situationer, for eksempel, en designer kan vælge at begrænse muligheden for fejl. Men hvor konsekvenserne af fiasko ikke er så alvorlige, designere kan vælge at give robotter større fleksibilitet til at prøve forskellige tilgange.

With the criteria in place, the researchers developed an algorithm to convert the robot's belief—the probability distribution pointing to the desired formula—into an equivalent reinforcement learning problem. This model will ping the robot with a reward or penalty for an action it takes, based on the specification it's decided to follow.

In simulations asking the robot to set the table in different configurations, it only made six mistakes out of 20, 000 tries. In real-world demonstrations, it showed behavior similar to how a human would perform the task. If an item wasn't initially visible, for eksempel, the robot would finish setting the rest of the table without the item. Derefter, when the fork was revealed, it would set the fork in the proper place. "That's where flexibility is very important, " Shah says. "Otherwise it would get stuck when it expects to place a fork and not finish the rest of table setup."

Næste, the researchers hope to modify the system to help robots change their behavior based on verbal instructions, corrections, or a user's assessment of the robot's performance. "Say a person demonstrates to a robot how to set a table at only one spot. The person may say, 'do the same thing for all other spots, ' or, 'place the knife before the fork here instead, '" Shah says. "We want to develop methods for the system to naturally adapt to handle those verbal commands, without needing additional demonstrations."

Denne historie er genudgivet med tilladelse fra MIT News (web.mit.edu/newsoffice/), et populært websted, der dækker nyheder om MIT-forskning, innovation og undervisning.

Varme artikler

Varme artikler

-

Suit hævder, at Amazons Alexa overtræder love ved at optage børns stemmer uden samtykkeKredit:CC0 Public Domain En retssag anlagt i Seattle tirsdag hævder, at Amazon optager børn, der bruger deres Alexa-enheder uden deres samtykke, i strid med love, der regulerer optagelser i mindst

Suit hævder, at Amazons Alexa overtræder love ved at optage børns stemmer uden samtykkeKredit:CC0 Public Domain En retssag anlagt i Seattle tirsdag hævder, at Amazon optager børn, der bruger deres Alexa-enheder uden deres samtykke, i strid med love, der regulerer optagelser i mindst -

Hvordan driver du milliarder af sensorer? Ved at omdanne spildvarme til elektricitetFigur 1:Dette billede viser det udvendige udseende af den udviklede kompakte, ultra letvægts fleksibel termoelektrisk konverteringsenhed. Kredit:Osaka University Sammenkoblet sundhedspleje og mang

Hvordan driver du milliarder af sensorer? Ved at omdanne spildvarme til elektricitetFigur 1:Dette billede viser det udvendige udseende af den udviklede kompakte, ultra letvægts fleksibel termoelektrisk konverteringsenhed. Kredit:Osaka University Sammenkoblet sundhedspleje og mang -

Boeing rapporterer ingen nye jet-ordrer i januarBoeing rapporterede ingen nye flyordrer i januar og et fald i jetleverancer, da den langvarige grundstødning af 737 MAX fortsatte med at tynge selskabet Boeing rapporterede tirsdag ingen nye flyor

Boeing rapporterer ingen nye jet-ordrer i januarBoeing rapporterede ingen nye flyordrer i januar og et fald i jetleverancer, da den langvarige grundstødning af 737 MAX fortsatte med at tynge selskabet Boeing rapporterede tirsdag ingen nye flyor -

Forsyningsselskaber begynder at investere i store batterier i stedet for at bygge nye kraftværkerDette er hvad en 5 megawatt, lithium-ion energilagringssystem ser ud. Kredit:Pacific Northwest National Laboratory På grund af deres faldende omkostninger, lithium-ion-batterier dominerer nu en ræ

Forsyningsselskaber begynder at investere i store batterier i stedet for at bygge nye kraftværkerDette er hvad en 5 megawatt, lithium-ion energilagringssystem ser ud. Kredit:Pacific Northwest National Laboratory På grund af deres faldende omkostninger, lithium-ion-batterier dominerer nu en ræ

- Tab af is i Antarktis forventes at påvirke fremtidige klimaændringer

- Brug af mobiltelefoner som rumvejrfløje

- Typhoon In-Fa gennemblæser det østlige Kina

- Finder folk terrorisme vigtigere efter store angreb?

- Husstørrelse er en faktor i håndteringen af den globale klima -nødsituation

- Disse 6 nye SUV'er er ventetiden værd