En beregningsgenvej til neurale netværk

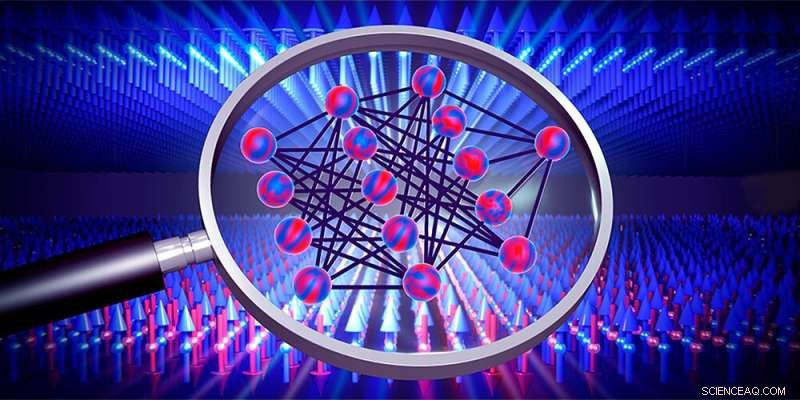

Neurale netværk (midten) kan bruges til at undersøge faseovergange, for eksempel af magnetiske materialer (pile). Kredit:Institut for Fysik, Universitetet i Basel

Neurale netværk er lærende algoritmer, der tilnærmer løsningen på en opgave ved at træne med tilgængelige data. Det er dog normalt uklart, hvordan de præcist opnår dette. To unge Basel-fysikere har nu udledt matematiske udtryk, der gør, at man kan beregne den optimale løsning uden at træne et netværk. Deres resultater giver ikke kun indsigt i, hvordan disse læringsalgoritmer fungerer, men kan også hjælpe med at opdage ukendte faseovergange i fysiske systemer i fremtiden.

Neurale netværk er baseret på princippet om hjernens funktion. Sådanne computeralgoritmer lærer at løse problemer gennem gentagen træning og kan for eksempel skelne objekter eller behandle talesprog.

I flere år nu har fysikere forsøgt at bruge neurale netværk til også at opdage faseovergange. Faseovergange kender vi fra hverdagen, for eksempel når vand fryser til is, men de forekommer også i mere kompleks form mellem forskellige faser af magnetiske materialer eller kvantesystemer, hvor de ofte er svære at opdage.

Julian Arnold og Frank Schäfer, to ph.d. studerende i forskergruppen af prof. Dr. Christoph Bruder ved universitetet i Basel, har nu egenhændigt udledt matematiske udtryk, hvormed sådanne faseovergange kan opdages hurtigere end før. De har for nylig offentliggjort deres resultater i Physical Review X .

Hvis du springer træningen over, sparer du tid

Et neuralt netværk lærer ved systematisk at variere parametre i mange træningsrunder for at få forudsigelserne beregnet af netværket til at matche de træningsdata, der føres ind i det mere og mere. Disse træningsdata kan være pixel af billeder eller faktisk resultater af målinger på et fysisk system, der viser faseovergange, som man gerne vil lære noget om.

"Neurale netværk er allerede blevet ret gode til at detektere faseovergange", siger Arnold, "men hvordan de præcist gør det, forbliver normalt helt uklart." For at ændre den situation og kaste lidt lys ind i den "sorte boks" i et neuralt netværk, så Arnold og Schäfer på det særlige tilfælde med netværk med et uendeligt antal parametre, som i princippet også gennemgår uendeligt mange træningsrunder.

Generelt har det været kendt i lang tid, at forudsigelser af sådanne netværk altid tenderer mod en vis optimal løsning. Arnold og Schäfer tog dette som udgangspunkt for at udlede matematiske formler, der gør det muligt direkte at beregne den optimale løsning uden egentlig at skulle træne netværket. "Denne genvej reducerer computertiden enormt," forklarer Arnold:"Den tid, det tager at beregne vores løsning, er kun så lang som en enkelt træningsrunde i et lille netværk."

Indsigt i netværket

Ud over at spare tid har metoden udviklet af Basel-fysikerne også den fordel, at de afledte ligninger giver en vis indsigt i funktionen af de neurale netværk og dermed af de fysiske systemer, der undersøges.

Indtil videre har Arnold og Schäfer testet deres metode på computergenereret data. Snart vil de også anvende metoden på rigtige måledata. Dette kan i fremtiden gøre det muligt at detektere endnu ukendte faseovergange, for eksempel i kvantesimulatorer eller i nye materialer. + Udforsk yderligere

Ny metode til at sammenligne neurale netværk afslører, hvordan kunstig intelligens fungerer

Varme artikler

Varme artikler

-

TIM vinder 5G-licenser i ItalienTIM har budt på en 80MHz blok på 3700 MHz (til en pris af 1,69 millioner euro) og en 200MHz blok på 26 GHz (til en pris af 33 millioner euro) Italiens TIM-teleselskab blev tirsdag tildelt nye nati

TIM vinder 5G-licenser i ItalienTIM har budt på en 80MHz blok på 3700 MHz (til en pris af 1,69 millioner euro) og en 200MHz blok på 26 GHz (til en pris af 33 millioner euro) Italiens TIM-teleselskab blev tirsdag tildelt nye nati -

Beskyttelse af vores digitale arv i en tid med cybertruslerKredit:CC0 Public Domain En af regeringens centrale funktioner er at indsamle og arkivere nationale registre. Dette omfatter alt fra ejendomsregistre og fødselsregistre, dødsfald og skatter, til p

Beskyttelse af vores digitale arv i en tid med cybertruslerKredit:CC0 Public Domain En af regeringens centrale funktioner er at indsamle og arkivere nationale registre. Dette omfatter alt fra ejendomsregistre og fødselsregistre, dødsfald og skatter, til p -

ExaNoDe bygger banebrydende 3-D computerenhedsprototype til exascaleKredit:Exanode Det europæiske ExaNoDe-projekt har bygget en banebrydende computerenhedsprototype, der baner vejen for morgendagens exascale supercomputere, dem, der er i stand til at udføre en mil

ExaNoDe bygger banebrydende 3-D computerenhedsprototype til exascaleKredit:Exanode Det europæiske ExaNoDe-projekt har bygget en banebrydende computerenhedsprototype, der baner vejen for morgendagens exascale supercomputere, dem, der er i stand til at udføre en mil -

Nye energihøstere viser potentiale, der passer som hånd i handskeZhong Wang PhD21, en forskningsmedarbejder ved Alan G. MacDiarmid NanoTech Institute ved UT Dallas, viser en handske, som han syede twistronfibre ind i, som er energi-høstende garn lavet af kulstof na

Nye energihøstere viser potentiale, der passer som hånd i handskeZhong Wang PhD21, en forskningsmedarbejder ved Alan G. MacDiarmid NanoTech Institute ved UT Dallas, viser en handske, som han syede twistronfibre ind i, som er energi-høstende garn lavet af kulstof na

- Magnetiske felter driver astrofysiske jetformer

- Quantum computing i stor skala:Forskere opnår kompakte, følsom qubit -aflæsning

- Vejen til at reducere plastforurening

- Kakaduopdagelsen afslører blomstrende middelalderlige handelsruter rundt om Australiens nordlige de…

- Magnetiske bølger forklarer mysteriet om Solens ydre lag

- Ikke-giftig prototype af saltvandsbatteri kan oplades på få sekunder