Folk, der har mistillid til medmennesker, viser større tillid til kunstig intelligens

Kredit:Pixabay/CC0 Public Domain

En persons mistillid til mennesker forudsiger, at de vil have mere tillid til kunstig intelligenss evne til at moderere indhold online, ifølge en nyligt offentliggjort undersøgelse. Resultaterne, siger forskerne, har praktiske konsekvenser for både designere og brugere af AI-værktøjer på sociale medier.

"Vi fandt et systematisk mønster af individer, der har mindre tillid til andre mennesker, der viser større tillid til AI's klassificering," sagde S. Shyam Sundar, James P. Jimirro professor i medieeffekter ved Penn State. "Baseret på vores analyse ser det ud til, at dette skyldes, at brugerne påberåber sig ideen om, at maskiner er nøjagtige, objektive og fri for ideologisk skævhed."

Undersøgelsen, offentliggjort i tidsskriftet New Media &Society fandt også, at "power users", som er erfarne brugere af informationsteknologi, havde den modsatte tendens. De stolede mindre på AI-moderatorerne, fordi de mener, at maskiner mangler evnen til at opdage nuancer af menneskeligt sprog.

Undersøgelsen viste, at individuelle forskelle såsom mistillid til andre og strømforbrug forudsiger, om brugere vil påberåbe sig positive eller negative egenskaber ved maskiner, når de står over for et AI-baseret system til indholdsmoderering, hvilket i sidste ende vil påvirke deres tillid til systemet. Forskerne foreslår, at personalisering af grænseflader baseret på individuelle forskelle positivt kan ændre brugeroplevelsen. Typen af indholdsmoderering i undersøgelsen involverer overvågning af opslag på sociale medier for problematisk indhold som hadefulde ytringer og selvmordstanker.

"En af grundene til, at nogle kan være tøvende med at stole på indholdsmodereringsteknologi, er, at vi er vant til frit at udtrykke vores meninger online. Vi føler, at moderation af indhold kan tage det fra os," siger Maria D. Molina, en adjunkt i kommunikationskunst og videnskab ved Michigan State University, og den første forfatter til dette papir. "Denne undersøgelse kan tilbyde en løsning på det problem ved at antyde, at for folk, der har negative stereotyper af AI til moderation af indhold, er det vigtigt at styrke menneskelig involvering, når de træffer en beslutning. På den anden side, for mennesker med positive stereotyper af maskiner, vi kan forstærke maskinens styrke ved at fremhæve elementer som nøjagtigheden af AI."

Undersøgelsen fandt også, at brugere med konservativ politisk ideologi var mere tilbøjelige til at stole på AI-drevet moderation. Molina og medforfatter Sundar, som også leder Penn State's Media Effects Research Laboratory, sagde, at dette kan stamme fra en mistillid til almindelige medier og sociale medievirksomheder.

Forskerne rekrutterede 676 deltagere fra USA. Deltagerne fik at vide, at de hjalp med at teste et indholdsmodereringssystem, der var under udvikling. De fik definitioner på hadefulde ytringer og selvmordstanker, efterfulgt af et af fire forskellige opslag på sociale medier. Indlæggene blev enten markeret for at passe til disse definitioner eller ikke markeret. Deltagerne fik også at vide, om beslutningen om at markere posten eller ej blev truffet af AI, et menneske eller en kombination af begge.

Demonstrationen blev efterfulgt af et spørgeskema, der spurgte deltagerne om deres individuelle forskelle. Forskellene omfattede deres tilbøjelighed til at mistro andre, politisk ideologi, erfaring med teknologi og tillid til kunstig intelligens.

"Vi bliver bombarderet med så meget problematisk indhold, fra misinformation til hadefulde ytringer," sagde Molina. "Men i sidste ende handler det om, hvordan vi kan hjælpe brugere med at kalibrere deres tillid til AI på grund af teknologiens faktiske egenskaber, snarere end at blive påvirket af disse individuelle forskelle."

Molina og Sundar siger, at deres resultater kan være med til at forme fremtidig accept af kunstig intelligens. Ved at skabe systemer, der er tilpasset brugeren, kunne designere lindre skepsis og mistillid og opbygge passende afhængighed af kunstig intelligens.

"En stor praktisk implikation af undersøgelsen er at finde ud af kommunikations- og designstrategier til at hjælpe brugere med at kalibrere deres tillid til automatiserede systemer," sagde Sundar, som også er direktør for Penn State's Center for Social Responsible Artificial Intelligence. "Visse grupper af mennesker, der har en tendens til at have for meget tiltro til AI-teknologi, bør advares om dens begrænsninger, og de, der ikke tror på dens evne til at moderere indhold, bør informeres fuldt ud om omfanget af menneskelig involvering i processen." + Udforsk yderligere

Brugere stoler lige så meget på AI som mennesker for at markere problematisk indhold

Varme artikler

Varme artikler

-

Apple og Qualcomm juridisk løsning kan bane vej for første 5G iPhoneKredit:CC0 Public Domain Apple og Qualcomm har afgjort deres mangeårige royalty- og patenttvister, hjælper potentielt med at bane vejen for den første 5G-kompatible iPhone så snart som i år, selvo

Apple og Qualcomm juridisk løsning kan bane vej for første 5G iPhoneKredit:CC0 Public Domain Apple og Qualcomm har afgjort deres mangeårige royalty- og patenttvister, hjælper potentielt med at bane vejen for den første 5G-kompatible iPhone så snart som i år, selvo -

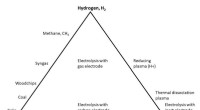

Klimavenlig metalproduktion:Hvorfor er det svært?Figuren viser et kort over muligheder for hvilke stoffer, der har evnen til at fjerne ilt fra malme, dem der kaldes reduktionsmiddel. Kredit:Norwegian University of Science and Technology De fleste

Klimavenlig metalproduktion:Hvorfor er det svært?Figuren viser et kort over muligheder for hvilke stoffer, der har evnen til at fjerne ilt fra malme, dem der kaldes reduktionsmiddel. Kredit:Norwegian University of Science and Technology De fleste -

At lære chatbots, hvordan man gør det rigtigeAI-chatbots kæmper stadig med at forstå virkningen af deres ord. Kredit:Shutterstock I denne tidsalder med information - og misinformation - udfordrer teknologiske fremskridt os til at genoverve

At lære chatbots, hvordan man gør det rigtigeAI-chatbots kæmper stadig med at forstå virkningen af deres ord. Kredit:Shutterstock I denne tidsalder med information - og misinformation - udfordrer teknologiske fremskridt os til at genoverve -

Hovedproblemet med virtual reality? Det er næsten lige så dumt som det virkelige livJonglering med Pluto, nogen som helst? Jindrich Adolf fra det tjekkiske institut for informatik, Robotik og kybernetik beskriver en anden verden -VR -oplevelse. Kredit:Western Sydney University Fo

Hovedproblemet med virtual reality? Det er næsten lige så dumt som det virkelige livJonglering med Pluto, nogen som helst? Jindrich Adolf fra det tjekkiske institut for informatik, Robotik og kybernetik beskriver en anden verden -VR -oplevelse. Kredit:Western Sydney University Fo

- Risikokommunikationseksperter analyserer visuelle reaktioner på tornado -advarselsgrafik

- Brug af sociale værdier for profit gør dem billigere, en ny undersøgelse advarer

- Diagnostisk biosensor registrerer hurtigt SARS-CoV-2 fra nasopharyngeale podninger

- Autonome køretøjer kan revolutionere byturismen

- Sådan bruger du en magnet til at skabe elektricitet

- Forskere identificerer funktioner, der kan gøre nogen til en virus-superspreder