Forskere udvikler en kunstig intelligens-model til autonom kørsel

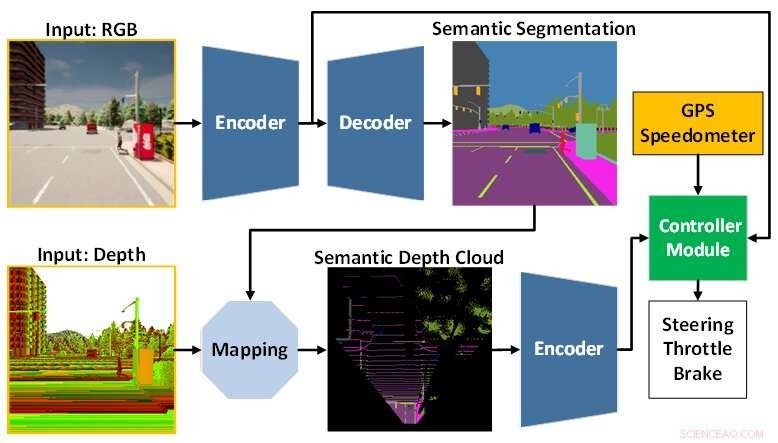

AI-modelarkitekturen er sammensat af perceptionsmodulet (blåt) og controllermodulet (grønt). Perceptionsmodulet er ansvarlig for at opfatte miljøet baseret på observationsdata fra et RGBD-kamera. I mellemtiden er controllermodulet ansvarlig for at afkode den udtrukne information for at estimere graden af styring, gas og bremsning. Kredit:Toyohashi University of Technology

Et forskerhold bestående af Oskar Natan, ph.d. studerende, og hans vejleder, professor Jun Miura, som er tilknyttet Active Intelligent System Laboratory (AISL), Department of Computer Science Engineering, Toyohashi University of Technology, har udviklet en AI-model, der kan håndtere perception og kontrol samtidigt for en autonom kørsel køretøj.

AI-modellen opfatter miljøet ved at udføre flere synsopgaver, mens den kører køretøjet efter en sekvens af rutepunkter. Desuden kan AI-modellen køre køretøjet sikkert under forskellige miljøforhold under forskellige scenarier. Evalueret under punkt-til-punkt navigationsopgaver opnår AI-modellen den bedste køreevne af visse nyere modeller i et standardsimuleringsmiljø.

Autonom kørsel er et komplekst system, der består af flere delsystemer, der håndterer flere perceptions- og kontrolopgaver. Det er dog dyrt og ineffektivt at implementere flere opgavespecifikke moduler, da der stadig er behov for adskillige konfigurationer for at danne et integreret modulært system.

Desuden kan integrationsprocessen føre til tab af information, da mange parametre justeres manuelt. Med hurtig deep learning-forskning kan dette problem løses ved at træne en enkelt AI-model med end-to-end og multi-task manerer. Modellen kan således levere navigationskontrol udelukkende baseret på observationerne fra et sæt sensorer. Da manuel konfiguration ikke længere er nødvendig, kan modellen administrere informationen helt selv.

Den udfordring, der er tilbage for en ende-til-ende-model, er, hvordan man udtrækker nyttig information, så controlleren kan estimere navigationskontrollerne korrekt. Dette kan løses ved at levere en masse data til perceptionsmodulet for bedre at opfatte det omgivende miljø. Derudover kan en sensorfusionsteknik bruges til at forbedre ydeevnen, da den fusionerer forskellige sensorer for at fange forskellige dataaspekter.

En enorm beregningsbelastning er dog uundgåelig, da en større model er nødvendig for at behandle flere data. Desuden er en dataforbehandlingsteknik nødvendig, da forskellige sensorer ofte kommer med forskellige datamodaliteter. Ydermere kan ubalancelæring under træningsprocessen være et andet problem, da modellen udfører både perceptions- og kontrolopgaver samtidigt.

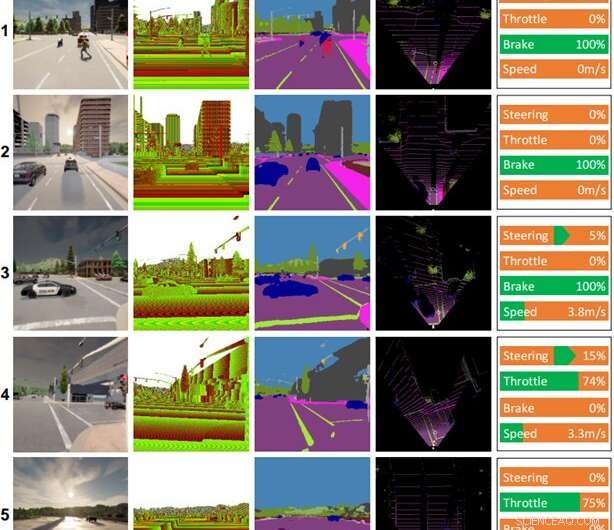

Nogle køreoptegnelser lavet af AI-modellen. Kolonner (fra venstre mod højre):farvebillede, dybdebillede, semantisk segmenteringsresultat, fugleperspektiv (BEV) kort, kontrolkommando. Vejret og tidspunktet for hver scene er som følger:(1) klar middag, (2) overskyet solnedgang, (3) midregnfuld middag, (4) solnedgang med hård regn, (5) våd solnedgang. Kredit:Toyohashi University of Technology

For at besvare disse udfordringer foreslår teamet en AI-model, der er trænet med ende-til-ende og multi-task-manerer. Modellen er lavet af to hovedmoduler, nemlig perceptions- og controllermoduler. Perceptionsfasen begynder med at behandle RGB-billeder og dybdekort leveret af et enkelt RGBD-kamera.

Derefter dekodes informationen udtrukket fra perceptionsmodulet sammen med køretøjshastighedsmåling og rutepunktkoordinater af controllermodulet for at estimere navigationskontrollerne. For at sikre, at alle opgaver kan udføres ens, anvender teamet en algoritme kaldet modificeret gradientnormalisering (MGN) til at balancere læringssignalet under træningsprocessen.

Holdet overvejer efterligningslæring, da det giver modellen mulighed for at lære fra et datasæt i stor skala, der matcher en næsten menneskelig standard. Desuden designede teamet modellen til at bruge et mindre antal parametre end andre for at reducere beregningsbelastningen og accelerere slutningen på en enhed med begrænsede ressourcer.

Baseret på det eksperimentelle resultat i en standard autonom køresimulator, CARLA, afsløres det, at sammensmeltning af RGB-billeder og dybdekort for at danne et fugleperspektiv (BEV) semantisk kort kan øge den samlede ydeevne. Da perceptionsmodulet har en bedre overordnet forståelse af scenen, kan controllermodulet udnytte nyttig information til at estimere navigationskontrollerne korrekt. Ydermere oplyser teamet, at den foreslåede model er at foretrække til udrulning, da den opnår bedre køreegenskaber med færre parametre end andre modeller.

Forskningen blev offentliggjort i IEEE Transactions on Intelligent Vehicles , og teamet arbejder i øjeblikket på modifikationer og forbedringer af modellen for at tackle flere problemer, når man kører under dårlige lysforhold, såsom om natten, i kraftig regn osv. Som en hypotese mener teamet, at tilføjelse af en sensor, der er upåvirket af ændringer i lysstyrke eller belysning, såsom LiDAR, vil det forbedre modellens sceneforståelse og resultere i bedre køreegenskaber. En anden fremtidig opgave er at anvende den foreslåede model til autonom kørsel i den virkelige verden. + Udforsk yderligere

Ny fundamentmodel forbedrer nøjagtigheden til billedfortolkning af fjernregistrering

Varme artikler

Varme artikler

-

Bygget til afstand og hastighed, Tunabot kan belyse, hvordan fisk bevæger sigDet er som en Porsche, der går gennem Cambridge -trafik, ”George Lauder sagde om den” Tunabot ”, han var med til at udvikle. Det går ikke 100 miles i timen, men det kan gå til sporet og optræde på et

Bygget til afstand og hastighed, Tunabot kan belyse, hvordan fisk bevæger sigDet er som en Porsche, der går gennem Cambridge -trafik, ”George Lauder sagde om den” Tunabot ”, han var med til at udvikle. Det går ikke 100 miles i timen, men det kan gå til sporet og optræde på et -

Førende i 3D-betontrykProfessor Jay Sanjayan er direktør for Swinburnes Center for Bæredygtig Infrastruktur og professor i betonstrukturer. Kredit:Swinburne University of Technology Den transformative teknologi til 3-D

Førende i 3D-betontrykProfessor Jay Sanjayan er direktør for Swinburnes Center for Bæredygtig Infrastruktur og professor i betonstrukturer. Kredit:Swinburne University of Technology Den transformative teknologi til 3-D -

Dommer siger, at Twitter-Musk-retssagen stadig er på vejHverken Twitter eller Elon Musk har bedt retten om at sætte sagen i bero, så dommeren besluttede, at hun ville fortsætte med at presse på mod vores retssag Dommeren, der præsiderer over Twitters ju

Dommer siger, at Twitter-Musk-retssagen stadig er på vejHverken Twitter eller Elon Musk har bedt retten om at sætte sagen i bero, så dommeren besluttede, at hun ville fortsætte med at presse på mod vores retssag Dommeren, der præsiderer over Twitters ju -

Nissan CEO, der er ramt af en krise, vil trække sig, når bestyrelsen mødesRapporter i Japan siger, at Nissans administrerende direktør, Hiroto Saikawa, vil træde tilbage over problemer med hans løn Administrerende direktør for den kriseramte japanske bilproducent Nissan

Nissan CEO, der er ramt af en krise, vil trække sig, når bestyrelsen mødesRapporter i Japan siger, at Nissans administrerende direktør, Hiroto Saikawa, vil træde tilbage over problemer med hans løn Administrerende direktør for den kriseramte japanske bilproducent Nissan