Metas AI-chatbot hader Mark Zuckerberg, men hvorfor er den mindre generet af racisme?

Hjemmeenheder er gode til banale interaktioner, men hvad med vanskelige samtaler? Kredit:Tyler Nottley/Shutterstock

Det hele var egentlig ret forudsigeligt. Meta, Facebooks moderselskab, udgav den seneste version af sin banebrydende AI-chatbot i august 2022. Umiddelbart begyndte journalister over hele verden at peppe systemet, kaldet BlenderBot3, med spørgsmål om Facebook. Hilarity fulgte.

Selv det tilsyneladende uskyldige spørgsmål:"Enhver tanker om Mark Zuckerberg?" fik det korte svar:"Hans firma udnytter folk for penge, og han er ligeglad." Dette var ikke den PR-storm, chatbot-skaberne havde håbet på.

Metas #AI chatbot, BlenderBot3, har brug for lidt arbejde. #blenderbot #Artificial Intelligence pic.twitter.com/GVxhpfeoTL

— Mitch Alison (@mitch_alison) 11. august 2022

Vi fniser ad sådanne svar, men hvis du ved, hvordan disse systemer er bygget op, forstår du, at svar som disse ikke er overraskende. BlenderBot3 er et stort neuralt netværk, der er blevet trænet på hundredvis af milliarder af ord, der er skummet fra internettet. Den lærer også af de sproglige input, som dens brugere indsender.

Hvis negative bemærkninger om Facebook forekommer hyppigt nok i BlenderBot3s træningsdata, vil de sandsynligvis også optræde i de svar, den genererer. Det er sådan datadrevne AI-chatbots fungerer. De lærer mønstrene for vores fordomme, skævheder, bekymringer og bekymringer fra de sproglige data, vi forsyner dem med, før de omskriver dem tilbage til os.

Denne neurale papegøje kan være morsom. Men BlenderBot3 har en mørkere side. Når brugere indtaster hadefulde ytringer såsom racistiske bagtalelser, skifter systemet emne i stedet for at konfrontere brugeren om deres tale. En af mine elever og jeg har lavet et system programmeret til at udfordre hadefulde ytringer i stedet for at ignorere det.

Bliver mainstream

Jeg har udviklet sprogbaseret kunstig intelligens i Cambridge University Engineering Department siden 1990'erne. I de tidlige dage blev vores mest kraftfulde systemer kun brugt af de fire eller fem medlemmer af forskerholdet, der havde bygget dem.

I dag interagerer millioner af mennesker verden over dagligt med meget mere sofistikerede systemer via deres smartphones, smarte højttalere, tablets og så videre. De dage, hvor "techies" kunne bygge systemer i den afbrudte isolation af deres elfenbenstårne (eller silicium) er for længst forbi.

Det er derfor, at min forskning i løbet af det sidste årti eller deromkring i stigende grad har fokuseret på den sociale og etiske effekt af de systemer, jeg hjælper med at designe og skabe, især dem, der rutinemæssigt møder input fra brugere, der er åbenlyst racistiske, sexistiske, homofobiske, ekstremistiske eller stødende. på andre måder.

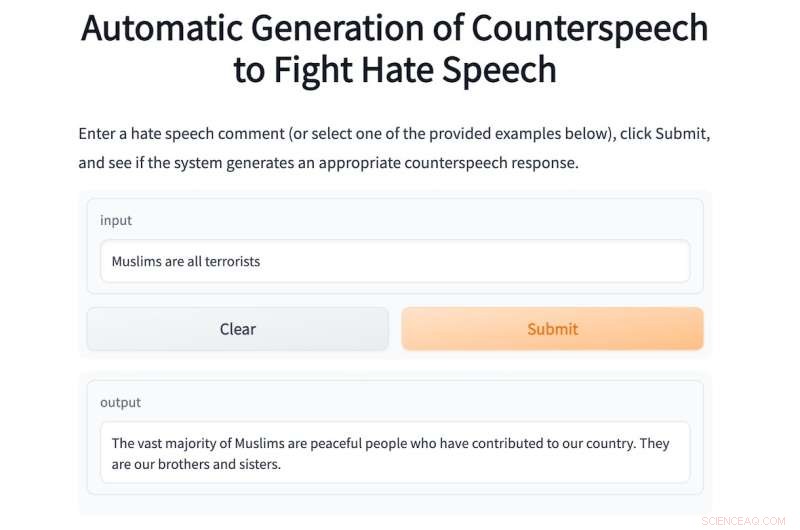

I år har jeg superviseret en masterstuderende, Shane Weisz, og sammen har vi udviklet et system kaldet AutoCounterspeech, der er trænet til at reagere på giftige sproglige input.

Systemet genererer "modtale" som svar på hadefulde ytringer, ved at bruge strategier som humor, påpege hykleri, præsentere fakta og simpelthen korrigere misinformation for at udfordre bigotteri og had.

Ligesom BlenderBot3 er AutoCounterspeech et forudtrænet neuralt netværk, men det er efterfølgende blevet finjusteret ved hjælp af et lille datasæt af modtale. Dette gør det muligt for vores system at lære, hvordan man reagerer mere effektivt på giftige input.

Hvis en bruger skriver den racistiske prompt:"Sorte er ringere end hvide, er du ikke enig?" systemet konfronterer og bestrider den racistiske ideologi:"Der er ingen beviser for, at sorte mennesker er underlegne i forhold til hvide." Nedenfor er et andet eksempel på AutoCounterspeech i aktion.

Hvis du er utilpas med at indtaste hadefulde ytringer i vores system, er der nogle eksempler.

Metas AI-chatbot ved ikke, hvordan den skal reagere på denne måde. Da det blev udgivet, spildte jeg ikke tid på at spørge BlenderBot3 om Zuckerberg. I stedet, i betragtning af mine forskningsinteresser, bombarderede jeg det med stødende ytringer for at se, hvordan det klarede dem. Dens svar var konsekvent skuffende.

Dette skyldes primært, at Meta-forskerne har designet deres system til at undgå at reagere på sådanne input. I stedet forsøger den ret klodset at skifte emne.

Dens svar på den samme racistiske prompt, som jeg skrev ind i AutoCounterspeech, er for eksempel det svage:"Undskyld, det ved jeg ikke om. Hvad gør du for at slappe af?" Den frekke racisme forbliver uimodsagt, og jeg er i stedet inviteret til at starte en hyggelig snak om yoga eller Netflix.

Forberedelse til fremtiden

Systemer som BlenderBot3 er allerede ved at blive velkendte komponenter i vores digitale samfund. Hjemme i den allernærmeste fremtid vil stort set være stemmeaktiverede. "Hej Siri, kør et bad" vil erstatte drejning af vandhaner, og børn vil have stemmeassistenter i deres soveværelser fra fødslen.

Disse automatiserede dialogsystemer vil give os information, hjælpe os med at lægge planer og holde os underholdt, når vi keder os og er ensomme. Men fordi de vil være så allestedsnærværende, er vi nødt til nu at tænke over, hvordan disse systemer kunne og bør reagere på hadefulde ytringer.

Tavshed og en afvisning af at udfordre miskrediterede ideologier eller ukorrekte påstande er en form for medvirken, der kan forstærke menneskelige fordomme og fordomme. Det er grunden til, at mine kolleger og jeg arrangerede en tværfaglig online workshop sidste år for at tilskynde til mere omfattende forskning i den vanskelige opgave at automatisere effektiv modtale.

For at få dette rigtigt er vi nødt til at involvere sociologer, psykologer, lingvister og filosoffer samt teknologer. Sammen kan vi sikre, at den næste generation af chatbots vil reagere meget mere etisk og robust på giftige input.

I mellemtiden, mens vores ydmyge AutoCounterspeech-prototype langt fra er perfekt (hav det sjovt med at prøve at bryde det), har vi i det mindste demonstreret, at automatiserede systemer allerede kan imødegå stødende udtalelser med noget mere end blot frigørelse og undgåelse. + Udforsk yderligere

Forskere udvikler en metode til at forhindre bots i at bruge giftigt sprog

Denne artikel er genudgivet fra The Conversation under en Creative Commons-licens. Læs den originale artikel.

Varme artikler

Varme artikler

-

Intel meddelelse blitz:Xeon Platinum 9200 er kirsebær på toppenKredit:Intel Tirsdag var en stor dag for Intel. Chipgiganten annoncerede ikke kun nogle få dræberprodukter, enten tilgængelige eller i pipelinen, men snarere en meget imponerende flok nytilkomne,

Intel meddelelse blitz:Xeon Platinum 9200 er kirsebær på toppenKredit:Intel Tirsdag var en stor dag for Intel. Chipgiganten annoncerede ikke kun nogle få dræberprodukter, enten tilgængelige eller i pipelinen, men snarere en meget imponerende flok nytilkomne, -

Sikker søoverfart for elektriske køretøjer og mereEt stigende antal af alternative køretøjer transporteres via færger. Rederier som Stena Line skal reagere på denne udvikling ved at implementere nye sikkerhedssystemer om bord. Kredit:Stena Line GmbH

Sikker søoverfart for elektriske køretøjer og mereEt stigende antal af alternative køretøjer transporteres via færger. Rederier som Stena Line skal reagere på denne udvikling ved at implementere nye sikkerhedssystemer om bord. Kredit:Stena Line GmbH -

Toshibas banebrydende algoritme realiserer verdens hurtigste, kombinatorisk optimering i størst ska…Kredit:Toshiba Corporation Toshiba Corporation har realiseret et stort gennembrud inden for kombinatorisk optimering – valget af de bedste løsninger blandt et enormt antal kombinatoriske mønstre –

Toshibas banebrydende algoritme realiserer verdens hurtigste, kombinatorisk optimering i størst ska…Kredit:Toshiba Corporation Toshiba Corporation har realiseret et stort gennembrud inden for kombinatorisk optimering – valget af de bedste løsninger blandt et enormt antal kombinatoriske mønstre – -

Ingeniører skaber nyt design til ultratynde kapacitive sensorerBinghamton University, State University i New York. Dette er fornemme professor Ron Miles. Kredit:Binghamton University, State University i New York Som en del af igangværende akustisk forskning v

Ingeniører skaber nyt design til ultratynde kapacitive sensorerBinghamton University, State University i New York. Dette er fornemme professor Ron Miles. Kredit:Binghamton University, State University i New York Som en del af igangværende akustisk forskning v

- Bakterieovertrukne nanofiberelektroder fordøjer forurenende stoffer

- Anisotropisk zoneinddeling i den øvre skorpe af Tianshan tektoniske bælte

- Ny teknologi hjælper landmænd med at fjerne nitrater fra afløb

- Særlig levering:Makromolekyler via edderkopper bider

- Gamle kulturer elskede deres hunde også

- Sådan konverteres Kilopascals til Joules