Hvordan engagement gør dig sårbar over for manipulation og misinformation på sociale medier

Kredit:Samtalen

Facebook har stille og roligt eksperimenteret med at reducere mængden af politisk indhold, det lægger i brugernes nyhedsfeeds. Tiltaget er en stiltiende erkendelse af, at den måde, virksomhedens algoritmer fungerer på, kan være et problem.

Sagens kerne er skelnen mellem at fremprovokere et svar og at levere indhold, som folk ønsker. Sociale mediealgoritmer - de regler, deres computere følger for at bestemme det indhold, du ser - er stærkt afhængige af folks adfærd for at træffe disse beslutninger. Især ser de efter indhold, som folk reagerer på eller "engagerer" med ved at like, kommentere og dele.

Som datalog, der studerer måden, hvorpå et stort antal mennesker interagerer ved hjælp af teknologi, forstår jeg logikken i at bruge skarernes visdom i disse algoritmer. Jeg ser også betydelige faldgruber i, hvordan de sociale medievirksomheder gør det i praksis.

Fra løver på savannen til likes på Facebook

Begrebet menneskemængdens visdom antager, at brug af signaler fra andres handlinger, meninger og præferencer som guide vil føre til fornuftige beslutninger. For eksempel er kollektive forudsigelser normalt mere nøjagtige end individuelle. Kollektiv intelligens bruges til at forudsige finansielle markeder, sport, valg og endda sygdomsudbrud.

Gennem millioner af års evolution er disse principper blevet kodet ind i den menneskelige hjerne i form af kognitive skævheder, der kommer med navne som fortrolighed, blot-eksponering og bandwagon-effekt. Hvis alle begynder at løbe, bør du også begynde at løbe; måske nogen så en løve komme og løbe kunne redde dit liv. Du ved måske ikke hvorfor, men det er klogere at stille spørgsmål senere.

Din hjerne opfanger spor fra omgivelserne – inklusive dine jævnaldrende – og bruger enkle regler til hurtigt at omsætte disse signaler til beslutninger:Gå med vinderen, følg flertallet, kopier din nabo. Disse regler fungerer bemærkelsesværdigt godt i typiske situationer, fordi de er baseret på sunde antagelser. For eksempel antager de, at folk ofte handler rationelt, det er usandsynligt, at mange tager fejl, fortiden forudsiger fremtiden, og så videre.

Teknologi giver folk mulighed for at få adgang til signaler fra meget større antal andre mennesker, hvoraf de fleste ikke kender. Kunstig intelligens-applikationer gør stor brug af disse popularitets- eller "engagement"-signaler, fra valg af søgemaskineresultater til at anbefale musik og videoer og fra at foreslå venner til at rangordne indlæg på nyhedsfeeds.

Ikke alt viralt fortjener at være

Vores forskning viser, at stort set alle webteknologiplatforme, såsom sociale medier og nyhedsanbefalingssystemer, har en stærk popularitetsbias. Når applikationer er drevet af signaler som engagement snarere end eksplicitte søgemaskineforespørgsler, kan popularitetsbias føre til skadelige utilsigtede konsekvenser.

Sociale medier som Facebook, Instagram, Twitter, YouTube og TikTok er stærkt afhængige af AI-algoritmer til at rangere og anbefale indhold. Disse algoritmer tager som input, hvad du "kan lide", kommenterer og deler - med andre ord indhold, du engagerer dig i. Målet med algoritmerne er at maksimere engagementet ved at finde ud af, hvad folk kan lide og placere det øverst i deres feeds.

På overfladen virker dette rimeligt. Hvis folk kan lide troværdige nyheder, ekspertudtalelser og sjove videoer, bør disse algoritmer identificere sådant indhold af høj kvalitet. Men folkemængdernes visdom gør her en central antagelse:at anbefale, hvad der er populært, vil hjælpe med at "boble op" indhold af høj kvalitet.

Vi testede denne antagelse ved at studere en algoritme, der rangerer varer ved hjælp af en blanding af kvalitet og popularitet. Vi fandt ud af, at popularitetsbias generelt er mere tilbøjelige til at sænke indholdets overordnede kvalitet. Årsagen er, at engagement ikke er en pålidelig indikator for kvalitet, når få mennesker har været udsat for en vare. I disse tilfælde genererer engagement et støjende signal, og algoritmen vil sandsynligvis forstærke denne indledende støj. Når populariteten af en vare af lav kvalitet er stor nok, vil den blive ved med at blive forstærket.

Algoritmer er ikke det eneste, der påvirkes af engagement bias - det kan også påvirke mennesker. Beviser viser, at information overføres via "kompleks smitte", hvilket betyder, at jo flere gange nogen bliver udsat for en idé online, jo større er sandsynligheden for, at de adopterer og videredeler den. Når sociale medier fortæller folk, at et element bliver viralt, slår deres kognitive skævheder ind og udmønter sig i den uimodståelige trang til at være opmærksom på den og dele den.

Ikke så kloge folkemængder

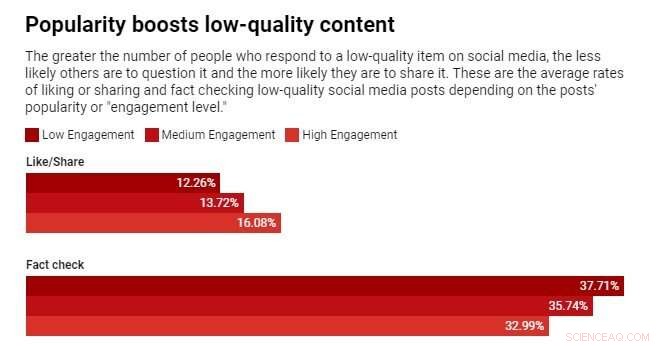

Vi kørte for nylig et eksperiment ved hjælp af en nyhedskompetence-app kaldet Fakey. Det er et spil udviklet af vores laboratorium, som simulerer et nyhedsfeed som Facebook og Twitter. Spillere ser en blanding af aktuelle artikler fra falske nyheder, junk science, hyperpartiske og konspiratoriske kilder samt mainstream-kilder. De får point for at dele eller like nyheder fra pålidelige kilder og for at markere artikler med lav troværdighed til faktatjek.

Vi fandt ud af, at spillere er mere tilbøjelige til at like eller dele og mindre tilbøjelige til at markere artikler fra kilder med lav troværdighed, når spillere kan se, at mange andre brugere har engageret sig i disse artikler. Eksponering for engagementsmålingerne skaber således en sårbarhed.

Folkemængdens visdom svigter, fordi den er bygget på den falske antagelse, at mængden består af forskellige, uafhængige kilder. Der kan være flere årsager til, at dette ikke er tilfældet.

For det første, på grund af folks tendens til at omgås lignende mennesker, er deres onlinekvarterer ikke særlig forskellige. Den lethed, hvormed en bruger af sociale medier kan blive uvenner med dem, de er uenige med, skubber folk ind i homogene fællesskaber, ofte omtalt som ekkokamre.

For det andet, fordi mange menneskers venner er hinandens venner, påvirker de hinanden. Et berømt eksperiment viste, at det at vide, hvilken musik dine venner kan lide, påvirker dine egne erklærede præferencer. Dit sociale ønske om at indordne sig forvrænger din uafhængige dømmekraft.

For det tredje kan popularitetssignaler spilles. Gennem årene har søgemaskiner udviklet sofistikerede teknikker til at modvirke såkaldte "link farms" og andre ordninger til at manipulere søgealgoritmer. Sociale medieplatforme er på den anden side lige begyndt at lære om deres egne sårbarheder.

Folk, der sigter på at manipulere informationsmarkedet, har oprettet falske konti, som trolde og sociale bots, og organiseret falske netværk. De har oversvømmet netværket for at skabe det indtryk, at en konspirationsteori eller en politisk kandidat er populær, og snyder både platformsalgoritmer og folks kognitive skævheder på én gang. De har endda ændret strukturen af sociale netværk for at skabe illusioner om flertallets meninger.

Dial down engagement

Hvad skal man gøre? Teknologiske platforme er i øjeblikket i defensiven. De bliver mere aggressive under valg med at fjerne falske konti og skadelig misinformation. Men disse bestræbelser kan være beslægtet med en omgang whack-a-mole.

En anden, forebyggende tilgang ville være at tilføje friktion. Med andre ord at bremse processen med at sprede information. Højfrekvent adfærd såsom automatiseret like og deling kan hæmmes af CAPTCHA-tests eller gebyrer. Dette ville ikke kun mindske mulighederne for manipulation, men med mindre information ville folk være i stand til at være mere opmærksomme på, hvad de ser. Det ville give mindre plads til engagement bias at påvirke folks beslutninger.

Det ville også hjælpe, hvis sociale medievirksomheder justerede deres algoritmer til at stole mindre på engagement for at bestemme det indhold, de tjener dig.

Varme artikler

Varme artikler

-

Uber viser en stor stigning i regeringens anmodninger om rytteroplysningerUber sagde onsdag, at antallet af anmodninger om data om sine ryttere fra embedsmænd i USA og Canada steg kraftigt sidste år pga. delvis, til en stigende interesse for information om køreturfirmaets b

Uber viser en stor stigning i regeringens anmodninger om rytteroplysningerUber sagde onsdag, at antallet af anmodninger om data om sine ryttere fra embedsmænd i USA og Canada steg kraftigt sidste år pga. delvis, til en stigende interesse for information om køreturfirmaets b -

Antennesystem med ti gange hurtigere hastighed i dataoverførsel og modtagelseAntennen til Lincoln Laboratorys in-band full-duplex phased-array-system ses med dens beskyttende emballage fjernet for at afsløre de individuelle antenner, der udgør phased-arrayet. Kredit:Massachuse

Antennesystem med ti gange hurtigere hastighed i dataoverførsel og modtagelseAntennen til Lincoln Laboratorys in-band full-duplex phased-array-system ses med dens beskyttende emballage fjernet for at afsløre de individuelle antenner, der udgør phased-arrayet. Kredit:Massachuse -

Raging Fortnite eSport-spil får $100 millioner i præmiepuljeFortnite, en af de populære konkurrencer inden for eSport, eller videospil som tilskuersport, vil være en præmiepulje på $100 millioner fra producenten Epic Games Epic Games i mandags satte gang

Raging Fortnite eSport-spil får $100 millioner i præmiepuljeFortnite, en af de populære konkurrencer inden for eSport, eller videospil som tilskuersport, vil være en præmiepulje på $100 millioner fra producenten Epic Games Epic Games i mandags satte gang -

Klip af snoren:Efterhånden som priserne stiger, her er hvordan du stadig kan spare penge på stream…Kredit:CC0 Public Domain Årevis, at klippe betalings-tv-ledningen er blevet set som en måde at spare penge på – du betaler ikke for kanaler, du ikke ser, og du er fri for langsigtede kontrakter.

Klip af snoren:Efterhånden som priserne stiger, her er hvordan du stadig kan spare penge på stream…Kredit:CC0 Public Domain Årevis, at klippe betalings-tv-ledningen er blevet set som en måde at spare penge på – du betaler ikke for kanaler, du ikke ser, og du er fri for langsigtede kontrakter.

- Plankton er Jordens mindste ubesværede helt

- Biologer opdagede vejen til grupper af lophophore

- Føderal modvilje mod klimabeskyttelsespolitikker kan give energi til nogle byer, siger forsker

- Hvordan bump i 2D-materialer kunne udjævne kvanteundersøgelser

- Pentagon afviser Boeing tankskibsleverancer på grund af kvalitetsproblemer

- Europas interiør kan være varmt nok til at brænde havbundens vulkaner