Smartere eksperimenter for hurtigere materialeopdagelse

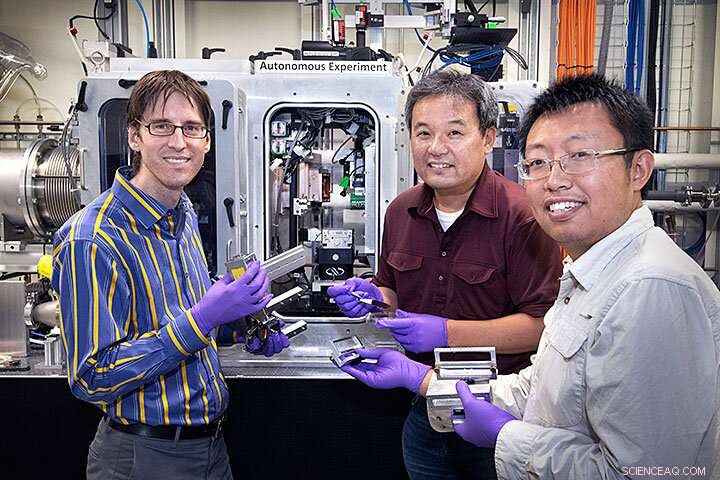

(fra venstre mod højre) Kevin Yager, Masafumi Fukuto, og Ruipeng Li forberedte Complex Materials Scattering (CMS) beamline ved NSLS-II til en måling ved hjælp af den nye beslutningstagningsalgoritme, som er udviklet af Marcus Noack (ikke på billedet). Kredit:Brookhaven National Laboratory

Et team af forskere fra det amerikanske energiministeriums Brookhaven National Laboratory og Lawrence Berkeley National Laboratory designet, skabt, og testede med succes en ny algoritme til at træffe smartere videnskabelige målingsbeslutninger. Algoritmen, en form for kunstig intelligens (AI), kan træffe selvstændige beslutninger om at definere og udføre det næste trin i et eksperiment. Holdet beskrev mulighederne og fleksibiliteten af deres nye måleværktøj i et papir offentliggjort den 14. august, 2019 i Videnskabelige rapporter .

Fra Galileo og Newton til den nylige opdagelse af gravitationsbølger, at udføre videnskabelige eksperimenter for at forstå verden omkring os har været drivkraften bag vores teknologiske fremskridt i hundreder af år. At forbedre den måde, forskere udfører deres eksperimenter på, kan have enorm indflydelse på, hvor hurtigt disse eksperimenter giver anvendelige resultater for nye teknologier.

I løbet af de sidste årtier, forskere har fremskyndet deres eksperimenter gennem automatisering og et stadigt voksende udvalg af hurtige måleværktøjer. Imidlertid, nogle af de mest interessante og vigtige videnskabelige udfordringer – såsom at skabe forbedrede batterimaterialer til energilagring eller nye kvantematerialer til nye typer computere – kræver stadig meget krævende og tidskrævende eksperimenter.

Ved at skabe en ny beslutningsalgoritme som en del af et fuldt automatiseret eksperimentelt setup, det tværfaglige team fra to af Brookhavens DOE Office of Science brugerfaciliteter - Center for Functional Nanomaterials (CFN) og National Synchrotron Light Source II (NSLS-II) - og Berkeley Labs Center for Advanced Mathematics for Energy Research Applications (CAMERA) tilbyder muligheden for at studere disse udfordringer på en mere effektiv måde.

Udfordringen med kompleksitet

Målet med mange eksperimenter er at få viden om det materiale, der studeres, og videnskabsmænd har en velafprøvet måde at gøre dette på:De tager en prøve af materialet og måler, hvordan det reagerer på ændringer i sit miljø.

En standardtilgang for forskere på brugerfaciliteter som NSLS-II og CFN er manuelt at scanne gennem målingerne fra et givent eksperiment for at bestemme det næste område, hvor de måske ønsker at køre et eksperiment. Men adgangen til disse faciliteters avancerede materialekarakteriseringsværktøjer er begrænset, så måletiden er kostbar. Et forskerhold har måske kun et par dage til at måle deres materialer, så de skal have mest muligt ud af hver måling.

"Nøglen til at opnå et minimum af målinger og maksimal kvalitet af den resulterende model er at gå, hvor usikkerheden er stor, sagde Marcus Noack, en postdoc ved CAMERA og hovedforfatter af undersøgelsen. "At udføre målinger der vil mest effektivt reducere den overordnede modelusikkerhed."

Som Kevin Yager, en medforfatter og CFN-forsker, påpegede, "Det endelige mål er ikke kun at tage data hurtigere, men også at forbedre kvaliteten af de data, vi indsamler. Jeg tænker på det som eksperimentalister, der skifter fra at mikrostyre deres eksperiment til at styre på et højere niveau. I stedet for at skulle beslutte, hvor de skal måle næste gang på prøven, forskerne kan i stedet tænke på det store billede, hvilket i sidste ende er, hvad vi som videnskabsmænd forsøger at gøre."

"Denne nye tilgang er et anvendt eksempel på kunstig intelligens, " sagde medforfatter Masafumi Fukuto, en videnskabsmand ved NSLS-II. "Beslutningsalgoritmen erstatter intuitionen hos den menneskelige eksperimentator og kan scanne gennem dataene og træffe smarte beslutninger om, hvordan eksperimentet skal forløbe."

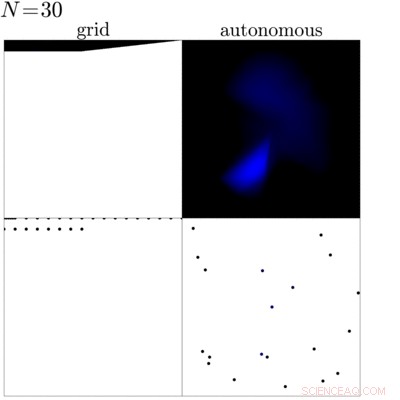

Denne animation viser en sammenligning mellem en traditionel gittermåling (venstre) af en prøve med en måling styret af den nyudviklede beslutningstagningsalgoritme (højre). Denne sammenligning viser, at algoritmen kan identificere kanterne og den indre del af prøven og fokuserer målingen i disse områder for at få mere viden om prøven. Kredit:Brookhaven National Laboratory

Mere information for mindre?

I praksis, før du starter et eksperiment, forskerne definerer et sæt mål, de ønsker at få ud af målingen. Med disse mål sat, algoritmen ser på de tidligere målte data, mens eksperimentet er i gang for at bestemme den næste måling. På sin søgen efter den bedste næste måling, algoritmen skaber en surrogatmodel af dataene, som er et kvalificeret gæt på, hvordan materialet vil opføre sig i de næste mulige trin, og beregner usikkerheden - i bund og grund hvor sikker den er i sit gæt - for hvert mulige næste skridt. Baseret på dette, den vælger derefter den mest usikre mulighed for at måle næste gang. Tricket her er ved at vælge det mest usikre trin at måle næste gang, algoritmen maksimerer mængden af viden, den opnår ved at foretage denne måling. Algoritmen maksimerer ikke kun informationsgevinsten under målingen, den definerer også, hvornår eksperimentet skal afsluttes ved at finde ud af det øjeblik, hvor eventuelle yderligere målinger ikke vil resultere i mere viden.

"Grundtanken er, givet en masse eksperimenter, hvordan kan du automatisk vælge den næstbedste?" sagde James Sethian, direktør for CAMERA og medforfatter til undersøgelsen. "Marcus har bygget en verden, som bygger en omtrentlig surrogatmodel på basis af dine tidligere eksperimenter og foreslår det bedste eller mest passende eksperiment at prøve næste gang."

Hvordan vi kom hertil

For at gøre autonome eksperimenter til virkelighed, holdet skulle tackle tre vigtige stykker:automatiseringen af dataindsamlingen, realtidsanalyse, og, selvfølgelig, beslutningsalgoritmen.

"Dette er en spændende del af dette samarbejde, " sagde Fukuto. "Vi leverede alle en vigtig brik til det:CAMERA-teamet arbejdede på beslutningsalgoritmen, Kevin fra CFN udviklede dataanalysen i realtid, og vi hos NSLS-II sørgede for automatiseringen til målingerne."

Holdet implementerede først deres beslutningsalgoritme ved Complex Materials Scattering (CMS) beamline ved NSLS-II, som CFN og NSLS-II driver i partnerskab. Dette instrument tilbyder ultraklare røntgenstråler til at studere nanostrukturen af forskellige materialer. Som den førende strålelinjeforsker af dette instrument, Fukuto havde allerede designet beamline med automatisering i tankerne. Strålelinjen tilbyder en prøveudvekslingsrobot, automatisk prøvebevægelse i forskellige retninger, og mange andre nyttige værktøjer til at sikre hurtige målinger. Sammen med Yagers dataanalyse i realtid, beamline var – designmæssigt – den perfekte pasform til det første "smarte" eksperiment.

Det første "smarte" eksperiment

Det første fuldt autonome eksperiment, holdet udførte, var at kortlægge omkredsen af en dråbe, hvor nanopartikler adskiller sig ved hjælp af en teknik kaldet small-angle X-ray spredning ved CMS beamline. Under røntgenspredning med små vinkler, forskerne skinner lyse røntgenstråler på prøven og, afhængig af prøvens atomare til nanoskala struktur, røntgenstrålerne preller af i forskellige retninger. Forskerne bruger derefter en stor detektor til at fange de spredte røntgenstråler og beregne egenskaberne af prøven på det oplyste sted. I dette første eksperiment, forskerne sammenlignede standardmetoden med at måle prøven med målinger, der blev foretaget, da den nye beslutningsalgoritme udløste skud. Algoritmen var i stand til at identificere dråbens område og fokuserede på dens kanter og indre dele i stedet for baggrunden.

"Efter vores egen indledende succes, vi ønskede at anvende algoritmen mere, så vi nåede ud til nogle få brugere og foreslog at teste vores nye algoritme på deres videnskabelige problemer, " sagde Yager. "De sagde ja, og siden da har vi målt forskellige prøver. En af de mest interessante var en undersøgelse af en prøve, der blev fremstillet til at indeholde et spektrum af forskellige materialetyper. Så i stedet for at lave og måle et enormt antal prøver og måske gå glip af en interessant kombination, brugeren lavede en enkelt prøve, der indeholdt alle mulige kombinationer. Vores algoritme var derefter i stand til at udforske denne enorme mangfoldighed af kombinationer effektivt, " han sagde.

Hvad er det næste?

Efter de første vellykkede eksperimenter, forskerne planlægger at forbedre algoritmen yderligere og dermed dens værdi for det videnskabelige samfund. En af deres ideer er at gøre algoritmen "fysikbevidst" - ved at drage fordel af alt, der allerede er kendt om materiale under undersøgelse - så metoden kan være endnu mere effektiv. En anden udvikling i gang er at bruge algoritmen under syntese og bearbejdning af nye materialer, for eksempel at forstå og optimere processer, der er relevante for avanceret fremstilling, da disse materialer er inkorporeret i enheder fra den virkelige verden. Holdet tænker også på det større billede og ønsker at overføre den autonome metode til andre eksperimentelle opstillinger.

"Jeg tror, at brugere ser strålelinjerne i NSLS-II eller mikroskoper af CFN lige som kraftfulde karakteriseringsværktøjer. Vi forsøger at ændre disse muligheder til en kraftfuld materialeopdagelsesfacilitet, " sagde Fukuto.

Sidste artikelAI lærer at modellere vores univers

Næste artikelSammenfiltrede fotoner genererede millioner af miles fra hinanden

Varme artikler

Varme artikler

-

Danske forskere udvikler budgetoptisk ammoniaksensorKredit:CC0 Public Domain I samarbejde med Danmarks Tekniske Universitet (DTU) Institut for Ingeniørvidenskab ved Aarhus Universitet har udviklet fotonisk sensorteknologi, der kan bane vejen for en

Danske forskere udvikler budgetoptisk ammoniaksensorKredit:CC0 Public Domain I samarbejde med Danmarks Tekniske Universitet (DTU) Institut for Ingeniørvidenskab ved Aarhus Universitet har udviklet fotonisk sensorteknologi, der kan bane vejen for en -

Quantum cocktail giver indsigt i hukommelseskontrolEksperimenter, hvor atomer blev nedsænket i en rystet krystal lavet af lys, give ny indsigt, der kan være nyttig til at forstå den grundlæggende adfærd af magnetiske lagerenheder. Kredit:Michael Messe

Quantum cocktail giver indsigt i hukommelseskontrolEksperimenter, hvor atomer blev nedsænket i en rystet krystal lavet af lys, give ny indsigt, der kan være nyttig til at forstå den grundlæggende adfærd af magnetiske lagerenheder. Kredit:Michael Messe -

Kan du virkelig knuse et glas med en høj seddel?Hvis betingelserne er de rigtige, det er muligt at knuse glas med den menneskelige stemme. Purestock/Thinkstock Det er operaens ækvivalent til scenen med slip-on-the-banan-skrællen:Sopranen på scenen

Kan du virkelig knuse et glas med en høj seddel?Hvis betingelserne er de rigtige, det er muligt at knuse glas med den menneskelige stemme. Purestock/Thinkstock Det er operaens ækvivalent til scenen med slip-on-the-banan-skrællen:Sopranen på scenen -

Eksperiment med ultrakold rubidium løfter af med forskningsraketNyttelast af den lydende raket i integrationshallen ved European Space and Sounding Rocket Range (Esrange) i Sverige Kredit:André Wenzlawski, JGU Fysikere ønsker at bruge ultrakolde gasser i rumme

Eksperiment med ultrakold rubidium løfter af med forskningsraketNyttelast af den lydende raket i integrationshallen ved European Space and Sounding Rocket Range (Esrange) i Sverige Kredit:André Wenzlawski, JGU Fysikere ønsker at bruge ultrakolde gasser i rumme

- Hvad er kameleons fjende?

- Er stjernespillere overvurderet i MLB? En nøglestatistik - vinder over erstatningsspiller - tåler …

- Ultraviolet lyser på solsystemets oprindelse

- Samtidig påvisning af flere spin -tilstande i en enkelt kvantepunkt

- Sådan beregnes højde & hastighed

- Teknik til at lave transparente polyethylenfilm så stærke som aluminium