Grafikkort farm for at hjælpe med at søge efter ny fysik på LHCb

Kredit:CC0 Public Domain

For første gang, data fra LHCb, et stort fysikeksperiment, vil blive behandlet på en farm af GPU'er. Denne løsning er ikke kun meget billigere, men det vil hjælpe med at reducere klyngestørrelsen og behandle data med hastigheder på op til 40 Tbit/s. Forskningspapiret er udgivet i Computing og software til Big Science .

En tværfaglig taskforce af forskere fra et af de største internationale samarbejder inden for højenergifysik LHC skønhed ved CERN har foreslået en ny måde at behandle enorm datastrøm fra partikeldetektoren. Holdet består af forskere fra førende europæiske og amerikanske universiteter. Den russiske del af holdet var repræsenteret af HSE og Yandex School of Data Analysis. Hovedformålet med forslaget er at give samarbejdet en robust, effektiv og fleksibel løsning, der kunne håndtere øget dataflow, der forventes i den kommende dataoptagelsesperiode. Denne løsning er ikke kun meget billigere, men det vil hjælpe med at reducere klyngestørrelsen og behandle data med hastigheder på op til 40 Tbit/s.

Især LHC og LHCb blev skabt med det formål at søge efter "ny fysik, " noget ud over standardmodellen. Selvom forskningen har opnået moderat succes, håb om at finde helt nye partikler, såsom WIMP'er, har fejlet. Mange fysikere mener, at for at opnå nye resultater, statistikker over partikelkollision ved LHC bør øges betydeligt. Men dette kræver ikke kun nyt accelerationsudstyr – opgraderinger er i øjeblikket undervejs og skal være afsluttet i 2021-2022 – men også helt nye systemer til at behandle data om partikelkollisioner. For at registrere begivenhederne på LHCb som korrekt registreret, det rekonstruerede spor skal matche det, der er modelleret af algoritmen. Hvis der ikke er noget match, dataene er udelukket. Omkring 70 % af alle kollisioner i LHC er udelukket på denne måde, hvilket betyder, at der kræves seriøs beregningskapacitet til denne foreløbige analyse.

En gruppe forskere, herunder Andrey Ustyuzhanin, Mikhail Belous og Sergei Popov fra HSE University, præsenterede et nyt papir med en algoritme for en farm af GPU'er som en første højniveau-trigger (HLT1) til hændelsesregistrering og detektion på LHCb-detektoren. Konceptet har fået navnet Allen, efter Frances Allen, en forsker i beregningssystemteori og den første kvinde, der har modtaget Turing-prisen.

I modsætning til tidligere udløsere, det nye system overfører data fra CPU'er til GPU'er. Disse kan omfatte både professionelle løsninger (såsom Tesla GPU'er, de mest avancerede på markedet) og almindelige "gamer" GPU'er fra NVIDIA eller AMD. Takket være dette, unbracontriggeren afhænger ikke af en bestemt udstyrsleverandør, som gør det nemmere at skabe og reducerer omkostningerne. Med de højeste ydeevne systemer, triggeren kan behandle data med op til 40 Tbit/s.

I en standardordning, information om alle hændelser går fra detektoren til en nul-niveau (L0) trigger, som består af programmerbare chips (FPGA). De udfører udvælgelse på grundniveau. I den nye ordning der vil ikke være nogen L0-trigger. Dataene går straks til gården, hvor hver af de 300 GPU'er samtidigt behandler millioner af hændelser i sekundet.

Efter indledende begivenhedsregistrering og detektion, kun de udvalgte data med værdifuld fysisk information går til almindelige x86-processorer af andet-niveau triggere (HLT2). Dette betyder, at den primære beregningsbelastning relateret til hændelsesklassificering sker på gården ved hjælp af GPU'er undtagelsesvis.

Denne ramme vil hjælpe med at løse begivenhedsanalyse og udvælgelsesopgaver mere effektivt:GPU'er er oprindeligt skabt som et multikanalsystem med flere kerner. Og mens CPU'er er gearet til fortløbende informationsbehandling, GPU'er bruges til massive simultane beregninger. Ud over, de har et mere specifikt og begrænset sæt opgaver, hvilket øger ydeevnen.

Ifølge Denis Derkach, leder af LHCb-teamet på HSE University, takket være beslutningen om ikke at bruge CPU'er, den nye farm er velegnet til fremtidig LHCb-dataoptagelse. Ud over, Allen vil koste betydeligt mindre end et lignende system på CPU'er. Det vil også være enklere end de tidligere hændelsesregistreringssystemer ved acceleratorer.

Den langsigtede fordel ved den nye tilgang er særlig vigtig. Udstyr til mange fysikeksperimenter bliver i øjeblikket opgraderet over hele verden. Og praktisk talt hver sådan opgradering fører til en voksende strøm af bearbejdet information. Tidligere, eksperimenter brugte undtagelsesvis ikke systemer baseret på GPU'er. Men fordelene ved Allen - en enklere arkitektur og lavere omkostninger - er så indlysende, at denne tilgang uden tvivl vil tage føringen ud over LHCb-eksperimentet.

Varme artikler

Varme artikler

-

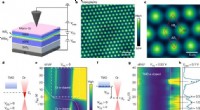

En ikke-invasiv måde at afbilde Wigner-krystaller direkte påFig. 1:STM-måling af Wigner-krystaltilstande i et dual-gated WSe2/WS2 moiré-supergitter. Kredit:DOI:10.1038/s41586-021-03874-9 Et team af forskere ved University of California i Berkeley, arbejder

En ikke-invasiv måde at afbilde Wigner-krystaller direkte påFig. 1:STM-måling af Wigner-krystaltilstande i et dual-gated WSe2/WS2 moiré-supergitter. Kredit:DOI:10.1038/s41586-021-03874-9 Et team af forskere ved University of California i Berkeley, arbejder -

Decentraliserede systemer er mere effektive til at nå et mål, når dets komponenter ikke er alt fo…Et team af forskere, herunder Neil Johnson, professor i fysik ved George Washington University, har opdaget, at decentrale systemer fungerer bedre, når de enkelte dele er mindre i stand. Dr. Johnson

Decentraliserede systemer er mere effektive til at nå et mål, når dets komponenter ikke er alt fo…Et team af forskere, herunder Neil Johnson, professor i fysik ved George Washington University, har opdaget, at decentrale systemer fungerer bedre, når de enkelte dele er mindre i stand. Dr. Johnson -

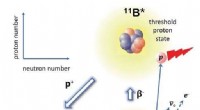

Praktisk placering af en nær-tærskel proton-emitterende resonans i bor-11Den ß-forsinkede protonemission af 11Be. Neutronhalo-grundtilstanden af 11Be gennemgår beta-henfald til en exciteret tilstand på 10B, som ligger lige over proton-henfaldstærsklen. Denne tilstand hen

Praktisk placering af en nær-tærskel proton-emitterende resonans i bor-11Den ß-forsinkede protonemission af 11Be. Neutronhalo-grundtilstanden af 11Be gennemgår beta-henfald til en exciteret tilstand på 10B, som ligger lige over proton-henfaldstærsklen. Denne tilstand hen -

Ny LHCb -analyse ser stadig tidligere spændende resultaterLHCb -eksperimentet ved CERN. Kredit:CERN På et seminar i dag på CERN, LHCb -samarbejdet præsenterede en ny analyse af data fra en specifik transformation, eller henfald, som en partikel kaldet B0

Ny LHCb -analyse ser stadig tidligere spændende resultaterLHCb -eksperimentet ved CERN. Kredit:CERN På et seminar i dag på CERN, LHCb -samarbejdet præsenterede en ny analyse af data fra en specifik transformation, eller henfald, som en partikel kaldet B0

- Ny metode kan identificere revner i metal længe før de forårsager katastrofer

- Hurtig accept af udenlandsk madtradition i bronzealderens Europa

- De skjulte omkostninger ved online shopping – for kunder og forhandlere

- Maskinindlæringsteknik hjælper bærbare enheder med at blive bedre til at diagnosticere søvnforst…

- Kemiske reaktioner involveret i bagning af en kage

- Forskere, der bruger partikler i nanoskala til at bekæmpe kræft