Ny teori antyder en mere effektiv måde at udvikle kvantealgoritmer på

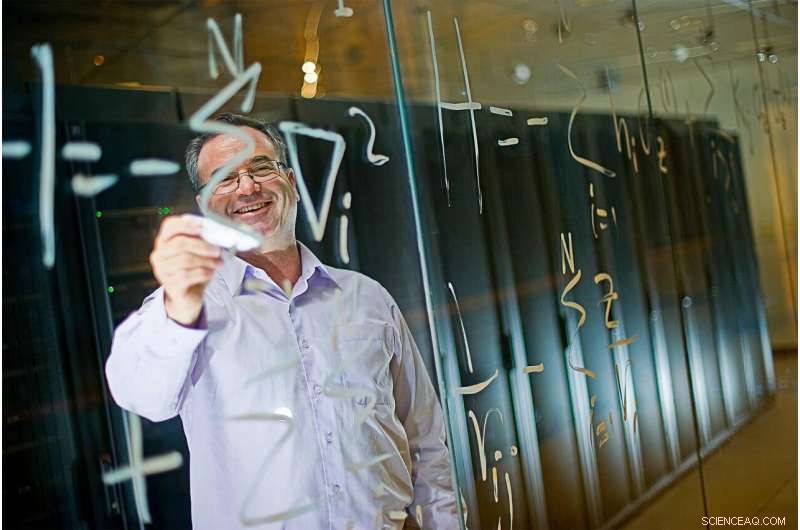

Sabre Kais' forskningsgruppe hos Purdue udvikler kvantealgoritmer og kvantemaskinelæringsmetoder. Kredit:Purdue University

I 2019, Google hævdede, at det var den første til at demonstrere en kvantecomputer, der udfører en beregning ud over evnerne til nutidens mest kraftfulde supercomputere.

Men det meste af tiden, At skabe en kvantealgoritme, der har en chance for at slå en klassisk computer, er en tilfældig proces, Forskere fra Purdue University siger. For at bringe mere vejledning til denne proces og gøre den mindre vilkårlig, disse videnskabsmænd udviklede en ny teori, der i sidste ende kan føre til mere systematisk design af kvantealgoritmer.

Den nye teori, beskrevet i en artikel offentliggjort i tidsskriftet Avancerede kvanteteknologier , er det første kendte forsøg på at bestemme, hvilke kvantetilstande der kan skabes og behandles med et acceptabelt antal kvanteporte for at udkonkurrere en klassisk algoritme.

Fysikere omtaler dette koncept med at have det rigtige antal porte til at kontrollere hver tilstand som 'kompleksitet'. Da kompleksiteten af en kvantealgoritme er tæt forbundet med kompleksiteten af kvantetilstande involveret i algoritmen, teorien kunne derfor bringe orden i søgen efter kvantealgoritmer ved at karakterisere, hvilke kvantetilstande der opfylder disse kompleksitetskriterier.

En algoritme er en sekvens af trin til at udføre en beregning. Algoritmen er normalt implementeret på et kredsløb.

I klassiske computere, kredsløb har porte, der skifter bit til enten 0 eller 1 tilstand. En kvantecomputer er i stedet afhængig af beregningsenheder kaldet "qubits", der lagrer 0 og 1 tilstande samtidigt i superposition, giver mulighed for at behandle flere oplysninger.

Hvad der ville gøre en kvantecomputer hurtigere end en klassisk computer er enklere informationsbehandling, kendetegnet ved den enorme reduktion i antallet af kvanteporte i et kvantekredsløb sammenlignet med et klassisk kredsløb.

I klassiske computere stiger antallet af porte i kredsløb eksponentielt i forhold til størrelsen af problemet af interesse. Denne eksponentielle model vokser så forbavsende hurtigt, at den bliver fysisk umulig at håndtere for selv et moderat stort problem af interesse.

"For eksempel, selv et lille proteinmolekyle kan indeholde hundredvis af elektroner. Hvis hver elektron kun kan antage to former, for at simulere 300 elektroner ville det kræve 2300 klassiske tilstande, som er mere end antallet af alle atomer i universet, sagde Saber Kais, en professor i Purdues afdeling for kemi og medlem af Purdue Quantum Science and Engineering Institute.

For kvantecomputere, der er en måde for kvanteporte at opskalere "polynomielt" - i stedet for blot eksponentielt som en klassisk computer - med størrelsen af problemet (som antallet af elektroner i det sidste eksempel). "Polynomial" betyder, at der ville være drastisk færre trin (gates) nødvendige for at behandle den samme mængde information, at gøre en kvantealgoritme bedre end en klassisk algoritme.

Forskere har hidtil ikke haft en god måde at identificere, hvilke kvantetilstande der kunne opfylde denne betingelse for polynomisk kompleksitet.

"Der er et meget stort søgerum til at finde de tilstande og rækkefølge af porte, der matcher i kompleksitet for at skabe en nyttig kvantealgoritme, der er i stand til at udføre beregninger hurtigere end en klassisk algoritme, sagde Kais, hvis forskergruppe udvikler kvantealgoritmer og kvantemaskinelæringsmetoder.

Kais og Zixuan Hu, en Purdue postdoc associeret, brugte den nye teori til at identificere en stor gruppe kvantetilstande med polynomisk kompleksitet. De viste også, at disse tilstande kan dele en koefficientfunktion, der kunne bruges til bedre at identificere dem, når man designer en kvantealgoritme.

"I betragtning af enhver kvantetilstand, vi er nu i stand til at designe en effektiv koefficientprøvetagningsprocedure for at bestemme, om den tilhører klassen eller ej, " sagde Hu.

Varme artikler

Varme artikler

-

Drejecylindre for at genskabe naturmønstreFigur 1:Computergenererede billeder viser placeringen af partikler før og efter en kontrolleret rotation tilføjes (a) og angiver nogle af de strukturer, der er fremstillet med enkeltpartikler og bla

Drejecylindre for at genskabe naturmønstreFigur 1:Computergenererede billeder viser placeringen af partikler før og efter en kontrolleret rotation tilføjes (a) og angiver nogle af de strukturer, der er fremstillet med enkeltpartikler og bla -

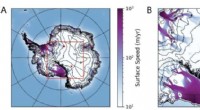

Undersøgelse giver en ny forklaring på neutrinoanomalier i AntarktisEt kort (venstre) og zoom-ind (højre) over Antarktis, viser de to unormale opadpegende hændelser - repræsenteret ved røde prikker - observeret af ANITA-eksperimentet, overlejret med overfladeishastigh

Undersøgelse giver en ny forklaring på neutrinoanomalier i AntarktisEt kort (venstre) og zoom-ind (højre) over Antarktis, viser de to unormale opadpegende hændelser - repræsenteret ved røde prikker - observeret af ANITA-eksperimentet, overlejret med overfladeishastigh -

Forskere observerer stationær Hawking -stråling i et analogt sort hulKredit:CC0 Public Domain Sorte huller er områder i rummet, hvor tyngdekraften er meget stærk - så stærk, at intet, der kommer ind i dem, kan slippe ud, inklusive lys. Teoretiske forudsigelser tyde

Forskere observerer stationær Hawking -stråling i et analogt sort hulKredit:CC0 Public Domain Sorte huller er områder i rummet, hvor tyngdekraften er meget stærk - så stærk, at intet, der kommer ind i dem, kan slippe ud, inklusive lys. Teoretiske forudsigelser tyde -

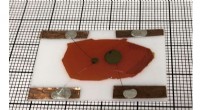

Forskere demonstrerer den første stabile halvlederneutrondetektorEn prototype af en arbejder, neutrondetektor i lommeformat fremstillet af et højt lithiumholdigt materiale. Kredit:Northwestern University/Argonne National Laboratory Homeland Security kan snart f

Forskere demonstrerer den første stabile halvlederneutrondetektorEn prototype af en arbejder, neutrondetektor i lommeformat fremstillet af et højt lithiumholdigt materiale. Kredit:Northwestern University/Argonne National Laboratory Homeland Security kan snart f

- Forskere opdager en ny klasse af kemisk reaktion

- Brasiliens vicepræsident siger ingen restriktioner for Huawei

- ExoMars får øje på en unik grøn glød på den røde planet

- Revneformering er asymmetrisk i polære materialer

- Folk betragter sundhedsrisici for indendørs luft som større, end hvad forskningsdata antyder

- Franske hoteller sagsøger Airbnb med påstand om unfair konkurrence