Forskning overvejer, hvordan man kan tackle store datasæt og flere parameterproblemer i partikelfysik

Abstrakt:

Området for partikelfysik kræver omfattende dataanalyse på grund af de enorme mængder data, der genereres af eksperimenter. Samtidig kræver forståelse af grundlæggende fysik, at man beskæftiger sig med komplekse modeller, der involverer adskillige parametre. Dette papir udforsker de specifikke udfordringer, man står over for, når man beskæftiger sig med så store datasæt og flere parameterproblemer i partikelfysiske eksperimenter, og diskuterer potentielle løsninger til at løse disse problemer effektivt. Vi fokuserer på teknikker og metoder, der muliggør nøjagtig og effektiv analyse af komplekse data, der hjælper med at optrevle universets forviklinger.

Introduktion:

Fremskridt inden for partikelfysiske eksperimenter har ført til en eksponentiel vækst i mængden af indsamlede data. At analysere denne enorme information udgør betydelige beregningsmæssige udfordringer. Derudover involverer de underliggende teorier i partikelfysik ofte indviklede modeller med adskillige justerbare parametre, hvilket introducerer yderligere kompleksitet. Dette papir har til formål at kaste lys over de vanskeligheder, der er forbundet med at håndtere omfattende datasæt og flere parametre i partikelfysik, og udforsker innovative teknikker til at tackle disse forhindringer med succes.

Udfordringer:

1. Datavolumen og kompleksitet: Partikelfysiske eksperimenter producerer enorme mængder data, som kræver betydelige beregningsressourcer til behandling, lagring og analyse. Selve størrelsen og indviklede struktur af dataene gør traditionelle dataanalysemetoder utilstrækkelige og nødvendiggør specialiserede tilgange.

2. Parameteroptimering: Mange modeller i partikelfysik involverer et stort antal parametre, der kræver finjustering for at matche eksperimentelle observationer. Denne optimeringsproces giver udfordringer på grund af de indviklede korrelationer mellem parametre og den høje dimensionalitet af parameterrummet.

3. Statistiske usikkerheder: Eksperimentelle målinger kommer med statistiske usikkerheder, der påvirker nøjagtigheden af modelforudsigelser. At kvantificere og udbrede disse usikkerheder gennem komplekse dataanalysepipelines bliver stadig mere udfordrende, især når man håndterer store datamængder.

4. Beregningsintensitet: Beregningerne involveret i partikelfysiske eksperimenter er ofte beregningsintensive og kræver avancerede algoritmer og effektive optimeringsteknikker til at håndtere komplekse modeller og store datasæt inden for rimelige tidsrammer.

Løsninger:

1. Distribueret computing: Brug af distribuerede computerrammer, såsom Hadoop og Spark, muliggør effektiv behandling af store datasæt på tværs af flere noder, hvilket reducerer beregningstiden.

2. Datakomprimeringsteknikker: Anvendelse af datakomprimeringsalgoritmer hjælper med at reducere datavolumen uden væsentligt tab af information, hvilket gør datalagring og analyse mere overskuelig.

3. Reduktion af dimensionalitet: Teknikker som Principal Component Analysis og Singular Value Decomposition kan reducere dimensionaliteten af parameterrum, hvilket afhjælper optimeringsproblemer.

4. Bayesiansk slutning: Bayesianske metoder tilbyder en principiel tilgang til parameterestimering og usikkerhedskvantificering, hvilket muliggør robust håndtering af statistiske usikkerheder.

5. GPU-beregning: Udnyttelse af Graphical Processing Units (GPU'er) accelererer beregningsintensive opgaver, hvilket muliggør hurtigere behandling af store datasæt.

6. Machine Learning Algoritmer: Maskinlæringsalgoritmer kan bruges til at identificere mønstre og lave forudsigelser i komplekse data, hvilket hjælper med modeludvikling og parameteroptimering.

Konklusion:

At tæmme store datasæt og konfrontere udfordringen med flere parametre er afgørende for fremskridt inden for partikelfysik. Dette papir har fremhævet de specifikke vanskeligheder, man støder på, når man håndterer sådanne kompleksiteter, og præsenteret lovende løsninger til at overvinde disse forhindringer. Ved at omfavne avancerede beregningsteknikker og innovative algoritmer kan partikelfysiske eksperimenter effektivt udnytte rigdommen af tilgængelige data, hvilket fører til dybere indsigt i universets grundlæggende natur.

Varme artikler

Varme artikler

-

Kun for en dag, LHC kolliderer xenonstrålerTeamet, der arbejder med ionkørslen i CERN -kontrolcentret, når xenon -kørslen begynder. Kredit:Jules Ordan/CERN I dag, LHC får en forsmag på noget usædvanligt. I otte timer, Large Hadron Collider

Kun for en dag, LHC kolliderer xenonstrålerTeamet, der arbejder med ionkørslen i CERN -kontrolcentret, når xenon -kørslen begynder. Kredit:Jules Ordan/CERN I dag, LHC får en forsmag på noget usædvanligt. I otte timer, Large Hadron Collider -

Ny teknologi lader kvantebits holde information i 10, 000 gange længere end tidligere rekordNy teknologi lader kvantebits holde information i 10, 000 gange længere end tidligere rekord. Kredit:Tohoku University Kvantebits, eller qubits, kan holde kvanteinformation meget længere nu takket

Ny teknologi lader kvantebits holde information i 10, 000 gange længere end tidligere rekordNy teknologi lader kvantebits holde information i 10, 000 gange længere end tidligere rekord. Kredit:Tohoku University Kvantebits, eller qubits, kan holde kvanteinformation meget længere nu takket -

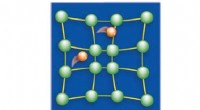

Knækker mysteriet om perfekt superledereffektivitetDenne figur viser, hvordan elektroner parres op for at forårsage superledning. I stedet for at rejse selvstændigt, elektronerne parres i par, der flyder gennem metal uden modstand. Kredit:US Departmen

Knækker mysteriet om perfekt superledereffektivitetDenne figur viser, hvordan elektroner parres op for at forårsage superledning. I stedet for at rejse selvstændigt, elektronerne parres i par, der flyder gennem metal uden modstand. Kredit:US Departmen -

Nyopdaget fænomen accelererer elektroner, når de går ind i en viskøs tilstandNy forskning viser, at elektroner, der passerer gennem en smal indsnævring i et stykke metal, kan bevæge sig meget hurtigere end forventet, og at de bevæger sig hurtigere, hvis der er flere af dem - e

Nyopdaget fænomen accelererer elektroner, når de går ind i en viskøs tilstandNy forskning viser, at elektroner, der passerer gennem en smal indsnævring i et stykke metal, kan bevæge sig meget hurtigere end forventet, og at de bevæger sig hurtigere, hvis der er flere af dem - e

- Forskere skaber en trådløs, batterifri, biologisk nedbrydelig blodgennemstrømningssensor

- Forskere udvikler billigere, hurtigere test for E. coli i drikkevand

- Værktøjer til overvågning af antibiotikaresistens i Puerto Ricanske vandskel efter orkanen Maria

- Fødslen af en yngre søskende aktiverer langvarige stressreaktioner hos unge bonoboer

- Undersøgelse viser, hvordan mikroplastikpartikler adskiller sig på tværs af Atlanterhavet

- Hedebølge forårsager massiv afsmeltning af Grønlands indlandsis