Narre mennesket via ændringer af billeder

Kredit:OpenAI

Godt, så meget for en antagelse, der nu lyder for let at acceptere - at den storslåede menneskelige hjerne har det over en maskine hver dag. Virkelig? Fortolker vi verden mere præcist, end et "konvolutionelt neuralt netværk" kan?

Som Even Ackerman påpegede, "når et CNN [konvolutionsnervalt netværk] præsenteres med et billede, det ser på et statisk gitter med rektangulære pixels. "

Vi ser på billeder og ser dem korrekt, såsom mennesker og dyr; CNN'er ser mere på ting som computere.

Et forskerhold rejser spørgsmål om lette antagelser, imidlertid. De undersøger, hvad der sker med modsætningseksempler med hensyn til mennesker.

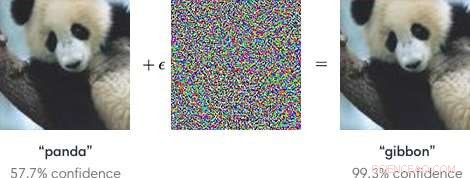

Input til maskinlæringsmodeller designet til at få modellerne til at begå en fejl er "modstridende eksempler". Modsatrettede eksempler, som sådan, kan potentielt være farligt.

Kort fortalt, "Modsat eksempler er ondsindede input, der er designet til at narre maskinlæringsmodeller, "ifølge en Google Research -side.

Som et blogindlæg i OpenAI forklarede, angribere kunne målrette mod autonome køretøjer ved at bruge klistermærker eller maling til at skabe et modsatrettet stopskilt, som køretøjet ville tolke som et 'udbytte' eller andet tegn.

Forskerne, ved at tale om maskinlæringsmodeller som sårbare over for modstridende eksempler, bemærkede, at små ændringer af billeder kan få computervisionsmodeller til at begå fejl, såsom at identificere en skolebus som en struds.

Bloggen fra OpenAI refererede til modstridende eksempler som et konkret problem inden for AI -sikkerhed.

Have sagt, at, hvad med modsætningseksempler, der narrer mennesker? Kan det ske?

Holdet, sagde Even Ackerman i IEEE -spektrum , "besluttede at prøve at finde ud af, om de samme teknikker, der narrer kunstige neurale netværk, også kan narre de biologiske neurale netværk inde i vores hoveder."

Forskningspapiret, der beskriver deres arbejde, er "Modsætningseksempler, der narrer både menneskelig og computer vision, "på arXiv.

"Her, vi skaber de første modstridende eksempler designet til at narre mennesker, "skrev de. De fandt ud af, at" modsatrettede eksempler, der stærkt overføres på tværs af computervisionsmodeller, påvirker klassifikationerne foretaget af tidsbegrænsede menneskelige observatører. "(Ackerman bemærkede, at i undersøgelsen, mennesker havde kun mellem 60 og 70 millisekunder til at se på hvert billede og træffe en beslutning.)

IEEE -spektrum Selv Ackerman diskuterede, hvad de gjorde, og præsenterede et sæt med to billeder fra Google Brain for at understøtte hans forklaring.

Ackerman viste "et billede af en kat til venstre. Til højre, kan du fortælle om det er et billede af den samme kat, eller et billede af en lignende hund? Forskellen mellem de to billeder er, at den til højre er blevet tweaket lidt af en algoritme for at gøre det svært for en type computermodel kaldet et konvolutionsnervalt netværk (CNN) at kunne fortælle, hvad det egentlig er. I dette tilfælde, CNN mener, at det ser på en hund frem for en kat, men det bemærkelsesværdige er, at de fleste mennesker tænker det samme. "

Hvad? Hvordan kan mennesker begå den samme fejl? Ackerman sagde, at det kunne være muligt at målrette udviklingen af et modsætningsbillede mod mennesker "ved at vælge modeller, der matcher det menneskelige visuelle system så tæt som muligt."

Men hvad er det egentlig, der roder ved menneskets evne til at være korrekt? Ackerman sagde, at forskerne påpegede, at "vores modstridende eksempler er designet til at narre menneskelig opfattelse, så vi bør være forsigtige med at bruge subjektiv menneskelig opfattelse for at forstå, hvordan de fungerer. "

Han sagde, at de var villige til at foretage nogle generaliseringer "om et par forskellige kategorier af ændringer, herunder 'forstyrrende objektkanter, især ved midfrekvensmodulationer vinkelret på kanten; forstærkning af kanter både ved at øge kontrasten og skabe teksturgrænser; ændring af tekstur; og udnytter mørke områder i billedet, hvor den perceptuelle størrelse af små forstyrrelser kan være større. '"

Hvordan de testede:Emner med normalt eller korrigeret syn deltog i forsøget.

"For hver gruppe, et vellykket kontradiktorisk image var i stand til at narre folk til at vælge det forkerte medlem af gruppen, ved at identificere den som en hund, når den faktisk er en kat, eller omvendt, "Sagde Ackerman.

Emner blev bedt om at klassificere billeder, der dukkede op på skærmen ved at trykke på knapperne i en responstid boks, sagde forfatterne.

Ackerman skrev, "Den korte tid, som billedet blev vist, formindskede forskellen mellem, hvordan CNN'er opfatter verden, og hvordan mennesker gør."

Eksperimentet involverede tre grupper af billeder:kæledyr (katte og hunde), grøntsager (kål og broccoli), og "fare" (edderkopper og slanger).

Ackermans kommentar til forskningsresultaterne var, at "der er overlapning mellem den perceptuelle manipulation af CNN'er og manipulation af mennesker. Det betyder, at maskinlæringsteknikker potentielt kan bruges til subtilt at ændre ting som billeder eller videoer på en måde, der kan ændre vores opfattelse af (and reaction to) them without us ever realizing what was going on."

He added that "we'll have to be careful, and keep in mind that just like those computers, sometimes we're far too easy to fool."

"Adversarial Examples that Fool both Human and Computer Vision" is by Gamaleldin F. Elsayed, Shreya Shankar, Brian Cheung, Nicolas Papernot, Alex Kurakin, Ian Goodfellow, and Jascha Sohl-Dickstein, on arXiv.

© 2018 Tech Xplore

Varme artikler

Varme artikler

-

Limber mini-gepardrobot leverer en imponerende backflip-ydelseMITs nye mini gepard robot er fjedrende, let på fødderne, og vejer kun 20 kilo. Kredit:Bryce Vickmark MIT Biomimetic Robotics Laboratory har fået sin andel af seriøst sød med den seneste video af

Limber mini-gepardrobot leverer en imponerende backflip-ydelseMITs nye mini gepard robot er fjedrende, let på fødderne, og vejer kun 20 kilo. Kredit:Bryce Vickmark MIT Biomimetic Robotics Laboratory har fået sin andel af seriøst sød med den seneste video af -

Godt, det var let:To-faktor autentificering hack feeds på falsk e-mailKredit:CC0 Public Domain To-faktor-godkendelse kan slå, som en hacker -demo har vist. Der lægges stor vægt på en video, hvor Kevin Mitnick, KnownBe4 chef hacking officer, afslørede tofaktorudnytte

Godt, det var let:To-faktor autentificering hack feeds på falsk e-mailKredit:CC0 Public Domain To-faktor-godkendelse kan slå, som en hacker -demo har vist. Der lægges stor vægt på en video, hvor Kevin Mitnick, KnownBe4 chef hacking officer, afslørede tofaktorudnytte -

Forskere dechifrerer elektrisk ledningsevne i doterede organiske halvledereIllustration af et organisk halvlederlag (grønne molekyler) med dopingmolekyle (lilla). Kredit:Sebastian Hutsch, Frank Ortmann Organiske halvledere muliggør fremstilling af trykte og mekanisk flek

Forskere dechifrerer elektrisk ledningsevne i doterede organiske halvledereIllustration af et organisk halvlederlag (grønne molekyler) med dopingmolekyle (lilla). Kredit:Sebastian Hutsch, Frank Ortmann Organiske halvledere muliggør fremstilling af trykte og mekanisk flek -

Zuckerberg i centrum af konflikten om Holocaust-benægtelse (Opdatering)I et podcastinterview med teknologiwebstedet Recode onsdag, Zuckerberg sagde, at mens Facebook var dedikeret til at stoppe spredningen af falske nyheder, visse overbevisninger, der oprigtigt blev ho

Zuckerberg i centrum af konflikten om Holocaust-benægtelse (Opdatering)I et podcastinterview med teknologiwebstedet Recode onsdag, Zuckerberg sagde, at mens Facebook var dedikeret til at stoppe spredningen af falske nyheder, visse overbevisninger, der oprigtigt blev ho