Forskere finder algoritmer til storskala hjernesimuleringer

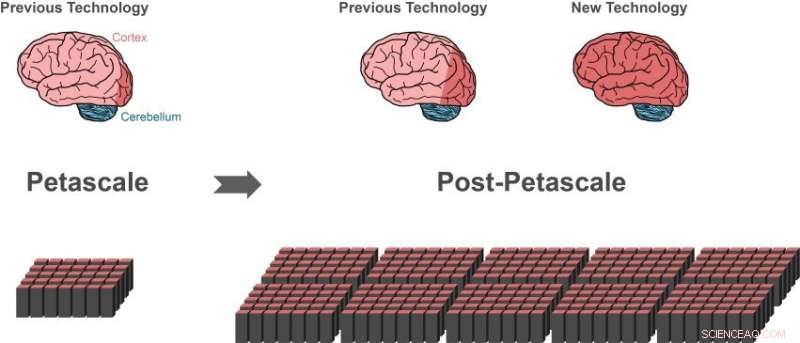

Tidligere simuleringsteknologi kan repræsentere omkring 1 procent af nervecellerne (neuroner) i en menneskelig hjerne (mørkerødt område af hjernen til venstre) ved hjælp af en petascale supercomputer (nederst til venstre). Kun små fremskridt (mørkerødt område af midterhjernen) ville være muligt på næste generation af supercomputere, der vil overgå ydeevnen af nutidens avancerede supercomputere med 10 til 100 gange. Større dele af den menneskelige hjerne kan repræsenteres med den nye teknologi, bruger den samme mængde computerhukommelse (nederst til højre).i 10 procent af hjernen er omtrent på størrelse med hele cortex (mørkerødt område af hjernen til højre), hvilket er afgørende for højere forarbejdning. En stor del af de andre neuroner er i lillehjernen (blå). Kredit:Forschungszentrum Jülich

En international gruppe af forskere har taget et afgørende skridt i retning af at skabe teknologien til at opnå simuleringer af hjerneskala-netværk på fremtidige supercomputere af exascale-klassen. Gennembruddet, udgivet i Grænser i neuroinformatik , tillader større dele af den menneskelige hjerne at blive repræsenteret, bruger den samme mængde computerhukommelse. Samtidigt, den nye algoritme fremskynder hjernesimuleringer på eksisterende supercomputere markant.

Den menneskelige hjerne er et organ af utrolig kompleksitet, sammensat af 100 milliarder indbyrdes forbundne nerveceller. Imidlertid, selv med hjælp fra de mest kraftfulde supercomputere til rådighed, det er i øjeblikket umuligt at simulere udvekslingen af neuronale signaler i netværk af denne størrelse.

"Siden 2014, vores software kan simulere omkring en procent af neuronerne i den menneskelige hjerne med alle deres forbindelser, siger Markus Diesmann, Direktør ved Jülich Institute of Neuroscience and Medicine (INM-6). For at opnå denne imponerende bedrift, softwaren kræver hele hovedhukommelsen af petascale supercomputere, såsom K-computeren i Kobe og JUQUEEN i Jülich.

Diesmann har arbejdet i mere end 20 år på simuleringssoftwaren NEST – en gratis, open source-simuleringskode i udbredt brug af det neurovidenskabelige samfund og en kernesimulator i European Human Brain Project, hvor han leder projekter inden for områderne teoretisk neurovidenskab og på High-Performance Analytics og Computing Platform.

Med NEST, adfærden for hver neuron i netværket er repræsenteret af en håndfuld matematiske ligninger. Fremtidige exascale computere, såsom post-K computeren planlagt i Kobe og JUWELS i Jülich, vil overgå ydeevnen af nutidens avancerede supercomputere med 10 til 100 gange. For første gang, forskere vil have computerkraft til rådighed til at simulere neuronale netværk på størrelse med den menneskelige hjerne.

Tilsyneladende en blindgyde

Mens den nuværende simuleringsteknologi gjorde det muligt for forskere at begynde at studere store neuronale netværk, det repræsenterede også en blindgyde på vejen til exascale teknologi. Supercomputere er sammensat af omkring 100, 000 små computere, kaldet noder, hver udstyret med et antal processorer, der udfører de faktiske beregninger.

"Før en simulering af et neuronalt netværk kan finde sted, neuroner og deres forbindelser skal skabes virtuelt, hvilket betyder, at de skal instansieres i nodernes hukommelse. Under simuleringen ved en neuron ikke på hvilken af noderne den har målneuroner, derfor, dens korte elektriske impulser skal sendes til alle noder. Hver knude kontrollerer derefter, hvilke af alle disse elektriske impulser, der er relevante for de virtuelle neuroner, der findes på denne knude, " forklarer Susanne Kunkel fra KTH Royal Institute of Technology i Stockholm.

Den nuværende algoritme til netværksoprettelse er effektiv, fordi alle noder konstruerer deres særlige del af netværket på samme tid. Men at sende alle elektriske impulser til alle noder er ikke egnet til simuleringer på exascale-systemer.

"At kontrollere relevansen af hver elektrisk puls effektivt kræver en bit information pr. processor for hver neuron i hele netværket. For et netværk på 1 milliard neuroner, en stor del af hukommelsen i hver node forbruges af kun denne enkelte bit information pr. neuron, " tilføjer Markus Diesmann.

Dette er hovedproblemet, når man simulerer endnu større netværk:mængden af computerhukommelse, der kræves pr. processor for de ekstra bits pr. neuron, stiger med størrelsen af det neuronale netværk. På omfanget af den menneskelige hjerne, dette ville kræve, at den tilgængelige hukommelse for hver processor er 100 gange større end i nutidens supercomputere. Det her, imidlertid, er usandsynligt tilfældet i den næste generation af supercomputere. Antallet af processorer pr. compute node vil stige, men hukommelsen pr. processor og antallet af compute noder vil snarere forblive det samme.

Gennembrud af ny algoritme

Gennembruddet udgivet i Grænser i neuroinformatik er en ny måde at konstruere det neuronale netværk på i supercomputeren. På grund af algoritmerne, den nødvendige hukommelse på hver node øges ikke længere med netværksstørrelsen. I begyndelsen af simuleringen, den nye teknologi giver knuderne mulighed for at udveksle information om, hvem der skal sende neuronal aktivitetsdata til hvem. Når denne viden er tilgængelig, udvekslingen af neuronal aktivitetsdata mellem noder kan organiseres således, at en node kun modtager den information, den kræver. En ekstra bit for hver neuron i netværket er ikke længere nødvendig.

En gavnlig bivirkning

Mens de testede deres nye ideer, forskerne kom med en yderligere nøgleindsigt, rapporterer Susanne Kunkel:"Da vi analyserede de nye algoritmer, indså vi, at vores nye teknologi ikke kun ville muliggøre simuleringer på exascale-systemer, men det ville også gøre simuleringer hurtigere på nuværende tilgængelige supercomputere."

Faktisk, da hukommelsesforbruget nu er under kontrol, hastigheden af simuleringer bliver hovedfokus for den videre teknologiske udvikling. For eksempel, en stor simulering af 0,52 milliarder neuroner forbundet med 5,8 billioner synapser, der kørte på supercomputeren JUQUEEN i Jülich, krævede tidligere 28,5 minutter at beregne et sekunds biologisk tid. Med den forbedrede simulering af datastrukturer, tiden reduceres til 5,2 minutter.

"Med den nye teknologi kan vi udnytte den øgede parallelitet af moderne mikroprocessorer meget bedre end tidligere, som vil blive endnu vigtigere i exascale computere, " bemærker Jakob Jordan, hovedforfatter af undersøgelsen, fra Forschungszentrum Jülich.

"Kombinationen af exascale hardware og passende software bringer undersøgelser af grundlæggende aspekter af hjernens funktion, som plasticitet og læring, der udfolder sig over minutter af biologisk tid inden for vores rækkevidde, " tilføjer Markus Diesmann.

Med en af de næste udgivelser af simuleringssoftwaren NEST, forskerne vil gøre deres resultater frit tilgængelige for samfundet som open source.

"Vi har brugt NEST til at simulere den komplekse dynamik af basalgangliernes kredsløb i sundhed og Parkinsons sygdom på K-computeren. Vi er spændte på at høre nyheden om den nye generation af NEST, som vil give os mulighed for at køre helhjerneskala-simuleringer på post-K computeren for at afklare de neurale mekanismer for motorisk kontrol og mentale funktioner, " siger Kenji Doya fra Okinawa Institute of Science and Technology (OIST).

"Undersøgelsen er et vidunderligt eksempel på det internationale samarbejde i bestræbelserne på at konstruere exascale computere. Det er vigtigt, at vi har applikationer klar, der kan bruge disse dyrebare maskiner fra den første dag, de er tilgængelige, " konkluderer Mitsuhisa Sato fra RIKEN Advanced Institute for Computer Science i Kobe.

Varme artikler

Varme artikler

-

Maskinlæringsalgoritme klassificerer automatisk søvnstadier for laboratoriemusKredit:unoL/Shutterstock Forskere ved University of Tsukuba har skabt et nyt kunstig intelligens-program til automatisk klassificering af søvnstadier hos mus, der kombinerer to populære maskinlæri

Maskinlæringsalgoritme klassificerer automatisk søvnstadier for laboratoriemusKredit:unoL/Shutterstock Forskere ved University of Tsukuba har skabt et nyt kunstig intelligens-program til automatisk klassificering af søvnstadier hos mus, der kombinerer to populære maskinlæri -

Detektorer til online hadefulde ytringer kan let snydes af mennesker, undersøgelse viserHvordan Google Perspective vurderer en kommentar, der ellers anses for giftig efter nogle indsatte stavefejl og lidt kærlighed. Kredit:Aalto University Hadelig tekst og kommentarer er et stadigt s

Detektorer til online hadefulde ytringer kan let snydes af mennesker, undersøgelse viserHvordan Google Perspective vurderer en kommentar, der ellers anses for giftig efter nogle indsatte stavefejl og lidt kærlighed. Kredit:Aalto University Hadelig tekst og kommentarer er et stadigt s -

Facebook siger, at Vægten ikke starter uden amerikansk godkendelseI denne 11. april, 2018, fil foto, Facebooks administrerende direktør, Mark Zuckerberg, holder pause, mens han vidner før en høring i House Energy and Commerce på Capitol Hill i Washington om brugen a

Facebook siger, at Vægten ikke starter uden amerikansk godkendelseI denne 11. april, 2018, fil foto, Facebooks administrerende direktør, Mark Zuckerberg, holder pause, mens han vidner før en høring i House Energy and Commerce på Capitol Hill i Washington om brugen a -

Elektronisk pille kan videresende diagnostiske oplysninger eller frigive medicin som reaktion på sm…MIT -forskere har designet en indtagelig sensor, der kan lægge sig i maven i et par uger og kommunikere trådløst med en ekstern enhed. Kredit:Massachusetts Institute of Technology Forskere på MIT,

Elektronisk pille kan videresende diagnostiske oplysninger eller frigive medicin som reaktion på sm…MIT -forskere har designet en indtagelig sensor, der kan lægge sig i maven i et par uger og kommunikere trådløst med en ekstern enhed. Kredit:Massachusetts Institute of Technology Forskere på MIT,

- Nobelvindende ICAN fordømmer stigningen i atomvåbeninvesteringer

- Buffet-up avatarer afholder os fra at træne hårdt

- Forskere finder ud af, at byudvikling øger strømningen dramatisk

- Elektrodeform forbedrer neurostimulering for små mål

- Forskere har opdaget et ældgammelt søbund dybt under Grønlands is

- Uber-ryttere kan købe transitbilletter på app til Denver