Adversarial Robustness Toolbox – sikring af AI mod modstridende trusler

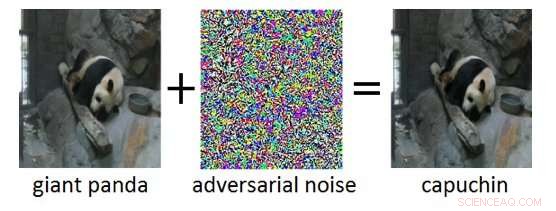

Figur 1:Adversarisk eksempel (højre) opnået ved at tilføje modstridende støj (midten) til et rent inputbillede (venstre). Mens den ekstra støj i det modstridende eksempel er umærkelig for et menneske, det får Deep Neural Network til at fejlklassificere billedet som "capuchin" i stedet for "gigantisk panda". Kredit:IBM Blog Research

I de seneste år er der set enorme fremskridt i udviklingen af kunstig intelligens (AI). Moderne AI-systemer opnår præstationer på menneskeligt niveau på kognitive opgaver såsom genkendelse af objekter i billeder, kommentere videoer, konvertere tale til tekst, eller oversættelse mellem forskellige sprog. Mange af disse gennembrudsresultater er baseret på Deep Neural Networks (DNN'er). DNN'er er komplekse maskinlæringsmodeller, der har en vis lighed med de indbyrdes forbundne neuroner i den menneskelige hjerne. DNN'er er i stand til at håndtere højdimensionelle input (f.eks. millioner af pixels i billeder med høj opløsning), repræsenterer mønstre i disse input på forskellige abstraktionsniveauer, og relatere disse repræsentationer til semantiske begreber på højt niveau.

En spændende egenskab ved DNN'er er, at mens de normalt er meget nøjagtige, de er sårbare over for såkaldte modstridende eksempler. Modstridende eksempler er input (f.eks. billeder), som bevidst er blevet ændret for at frembringe et ønsket svar af en DNN. Et eksempel er vist i figur 1:Her får tilføjelsen af en lille mængde modstandsstøj til billedet af en kæmpepanda, at DNN fejlklassificerer dette billede som en kapuciner. Tit, målet for modstridende eksempler er fejlklassificering eller en specifik forkert forudsigelse, som ville gavne en angriber.

Modstridende angreb udgør en reel trussel mod udrulningen af AI-systemer i sikkerhedskritiske applikationer. Næsten uopdagelige ændringer af billeder, video, tale, og andre data er blevet lavet til at forvirre AI-systemer. Sådanne ændringer kan laves, selvom angriberen ikke har nøjagtig viden om DNN's arkitektur eller adgang til dets parametre. Endnu mere bekymrende, modstridende angreb kan lanceres i den fysiske verden:i stedet for at manipulere pixels i et digitalt billede, modstandere kunne unddrage sig ansigtsgenkendelsessystemer ved at bære specialdesignede briller, eller besejre visuelle genkendelsessystemer i autonome køretøjer ved at klæbe plastre til trafikskilte.

IBM Research Ireland frigiver Adversarial Robustness Toolbox, et open source-softwarebibliotek, at støtte både forskere og udviklere i at forsvare DNN'er mod modstridende angreb og derved gøre AI-systemer mere sikre. Udgivelsen vil blive annonceret på RSA-konferencen af Dr. Sridhar Muppidi, IBM Fellow, VP og CTO IBM Security, og Koos Lodewijkx, Vicepræsident og CTO for Security Operations and Response (SOAR), IBM Sikkerhed.

Adversarial Robustness Toolbox er designet til at støtte forskere og udviklere i at skabe nye forsvarsteknikker, samt i implementering af praktiske forsvar af AI-systemer i den virkelige verden. Forskere kan bruge Adversarial Robustness Toolbox til at benchmarke nye forsvar mod det avancerede. For udviklere, biblioteket stiller grænseflader til rådighed, som understøtter sammensætningen af omfattende forsvarssystemer med individuelle metoder som byggesten.

Biblioteket er skrevet i Python, det mest almindeligt anvendte programmeringssprog til udvikling, test og implementering af DNN'er. Det omfatter state-of-the-art algoritmer til at skabe modstridende eksempler samt metoder til at forsvare DNN'er mod disse. Tilgangen til at forsvare DNN'er er tredelt:

- Måler modellens robusthed. For det første, robustheden af en given DNN kan vurderes. En ligetil måde at gøre dette på er at registrere tabet af nøjagtighed på modstridende ændrede input. Andre tilgange måler, hvor meget de interne repræsentationer og outputtet af en DNN varierer, når der anvendes små ændringer på dets input.

- Modelhærdning. For det andet en given DNN kan "hærdes" for at gøre den mere robust over for modstridende input. Almindelige tilgange er at forbehandle input fra en DNN, at udvide træningsdataene med modstridende eksempler, eller at ændre DNN-arkitekturen for at forhindre modstridende signaler i at forplante sig gennem de interne repræsentationslag.

- Kørselsdetektering. Endelig, runtime detektionsmetoder kan anvendes til at markere alle input, som en modstander kan have tempereret med. Disse metoder forsøger typisk at udnytte unormale aktiveringer i de interne repræsentationslag af en DNN forårsaget af de modstridende input.

For at komme i gang med Adversarial Robustness Toolbox, tjek open source-udgivelsen under github.com/IBM/adversarial-robustness-toolbox. Udgivelsen indeholder omfattende dokumentation og tutorials, der hjælper forskere og udviklere med at komme hurtigt i gang. En hvidbog, der beskriver de metoder, der er implementeret i biblioteket, er under udarbejdelse.

Denne første udgivelse af Adversarial Robustness Toolbox understøtter DNN'er implementeret i TensorFlow og Keras deep learning rammer. Fremtidige udgivelser vil udvide støtten til andre populære rammer såsom PyTorch eller MXNet. I øjeblikket, biblioteket er primært beregnet til at forbedre modstandsdygtigheden af visuelle genkendelsessystemer, imidlertid, vi arbejder på fremtidige udgivelser, der vil omfatte tilpasninger til andre datatilstande såsom tale, tekst eller tidsserier.

Som et open source-projekt, ambitionen med Adversarial Robustness Toolbox er at skabe et levende økosystem af bidragydere både fra industrien og den akademiske verden. Hovedforskellen til lignende igangværende indsats er fokus på forsvarsmetoder, og om sammensætningen af praktiske forsvarssystemer. Vi håber, at Adversarial Robustness Toolbox-projektet vil stimulere forskning og udvikling omkring modstridende robusthed af DNN'er, og fremme implementeringen af sikker AI i applikationer i den virkelige verden. Del venligst med os din erfaring med at arbejde med Adversarial Robustness Toolbox og eventuelle forslag til fremtidige forbedringer.

Sidste artikelNyt værktøj fungerer som digital logbog for dronebrugere

Næste artikelBitcoins vilde tur og hvad er forude for kryptovalutaen

Varme artikler

Varme artikler

-

Skærmlæser plus tastatur hjælper blinde, svagsynede brugere gennemser moderne websiderEn bruger trykker på tasterne for at vælge en menu på øverste niveau, undermenu, og klik derefter gennem mulighederne på en indlejret liste for at booke en sightseeingaktivitet gennem Airbnb. Kredit:U

Skærmlæser plus tastatur hjælper blinde, svagsynede brugere gennemser moderne websiderEn bruger trykker på tasterne for at vælge en menu på øverste niveau, undermenu, og klik derefter gennem mulighederne på en indlejret liste for at booke en sightseeingaktivitet gennem Airbnb. Kredit:U -

Omgå populære adgangskoderKredit:CC0 Public Domain Hvert år deler computersikkerhedsvirksomheder deres resultater vedrørende adgangskoder og databrud. Igen og igen, de advarer computerbrugere om at bruge komplekse adgangsk

Omgå populære adgangskoderKredit:CC0 Public Domain Hvert år deler computersikkerhedsvirksomheder deres resultater vedrørende adgangskoder og databrud. Igen og igen, de advarer computerbrugere om at bruge komplekse adgangsk -

Flyselskaber reducerer flyvninger, fastfryse ansættelser, da virus begrænser rejserI denne 24. maj, 2018, fil foto et Delta Air Lines passagerjetfly, en Boeing 737-900 model, nærmer sig Logan Lufthavn i Boston. Flyselskaber oplever et kraftigt fald i bookinger og en stigning i aflys

Flyselskaber reducerer flyvninger, fastfryse ansættelser, da virus begrænser rejserI denne 24. maj, 2018, fil foto et Delta Air Lines passagerjetfly, en Boeing 737-900 model, nærmer sig Logan Lufthavn i Boston. Flyselskaber oplever et kraftigt fald i bookinger og en stigning i aflys -

Hvad er trending inden for falske nyheder? Værktøjer viser, hvilke historier der bliver virale, og…En Hoaxy-søgning sporer spredningen af en nyhedshistorie, der hævder Syriens civile forsvar, en frivillig eftersøgnings- og redningsorganisation også kendt som White Helmets iscenesætter masseulykk

Hvad er trending inden for falske nyheder? Værktøjer viser, hvilke historier der bliver virale, og…En Hoaxy-søgning sporer spredningen af en nyhedshistorie, der hævder Syriens civile forsvar, en frivillig eftersøgnings- og redningsorganisation også kendt som White Helmets iscenesætter masseulykk

- Gennemgang af bionedbrydelige poser viser, at der ikke er kendt nok til at bedømme, om de er miljø…

- Op- og nedture i regenerativ medicin

- Hvordan at lære mere om neurovidenskab kan påvirke udviklingen af forbedrede AI-systemer

- Amerikanske medarbejdere, stater kunne gå sammen om Google -sonder:rapport

- Optomekaniske krystaller, der muliggør kaosbaseret sikker datakommunikation

- Hvad sker der med ioniske og kovalente forbindelser, når de opløses i vand?